داده کاوی (Data Mining) و مفاهیم کلیدی آن — راهنمای جامع و ساده

در این مطلب، مفاهیم کلیدی «داده کاوی» (Data Mining) مورد بررسی قرار خواهد گرفت. این مفاهیم در کلیه مسائل این حوزه مشترک محسوب میشوند و یادگیری آنها از الزامات یادگیری دادهکاوی است. هدف از این نوشته پرداختن به هر یک از این مفاهیم همراه با جزئیات نیست، بلکه یک دید کلی از آنها به منظور آمادهسازی ذهن مخاطب ارائه خواهد شد و برای مطالعه همراه با جزئیات هر مبحث، لینکهایی در متن و انتهای این نوشته قرار گرفته است.

مفاهیم مقدماتی

در ادامه برخی مفاهیم مقدماتی دادهکاوی و علم داده مورد بررسی قرار میگیرند.

نویز

«نویز» (Noise | نوفه) از یک سو، در تعریف به نمادها و سمبلها و یا دادههای ایجاد شده به صورت تصادفی که فاقد معنای خاصی هستند گفته میشود. بر همین اساس، گاهی دادههایی که دارای خطا هستند نویزی (دارای نویز) نامیده میشوند. از جمله این دادهها میتوان به «مقادیر ناموجود» (Missing Values) و مقادیر غلط (مانند عدد ۲۰۰۰ برای وزن یک انسان) اشاره کرد. از سوی دیگر، تفاوت بین یک مدل و پیشبینیهای آن را نویز گویند.

داده

«داده»ها (Data) نمادها و سمبلهای خامی هستند که به تنهایی فاقد معنای کامل هستند. از جمله دادهها میتوان به تراکنشها، اعداد، متن، تصاویر و ویدئوها اشاره کرد.

قالب داده

اقلام داده ممکن است در قالبهای گوناگون مانند متن، اعداد صحیح، اعداد اعشاری، تصاویر و ویدئوها باشند. نوع داده در «پایگاه داده» (Database) را «قالب داده» (Data Format) گویند.

دادههای خارجی

«دادههای خارجی» (External Data)، دادههایی هستند که در داخل یک سازمان گردآوری و ذخیره نشدهاند. از جمله این دادهها میتوان به دادههای موجود در کتابهای مرجع، منابع داده دولتی و دادههای وب اشاره کرد.

دادههای داخلی

دادههای گردآوری شده در یک سازمان مانند دادههای مشتریان و عملیات سازمانی را «دادههای داخلی» (Internal Data) گویند.

Overlay

دادههایی که توسط سازمان گردآوری نشدهاند، مانند دادههای پایگاه داده اختصاصی که با دادههای خود سازمان ترکیب میشوند را «Overlay» گویند.

داده کاوی

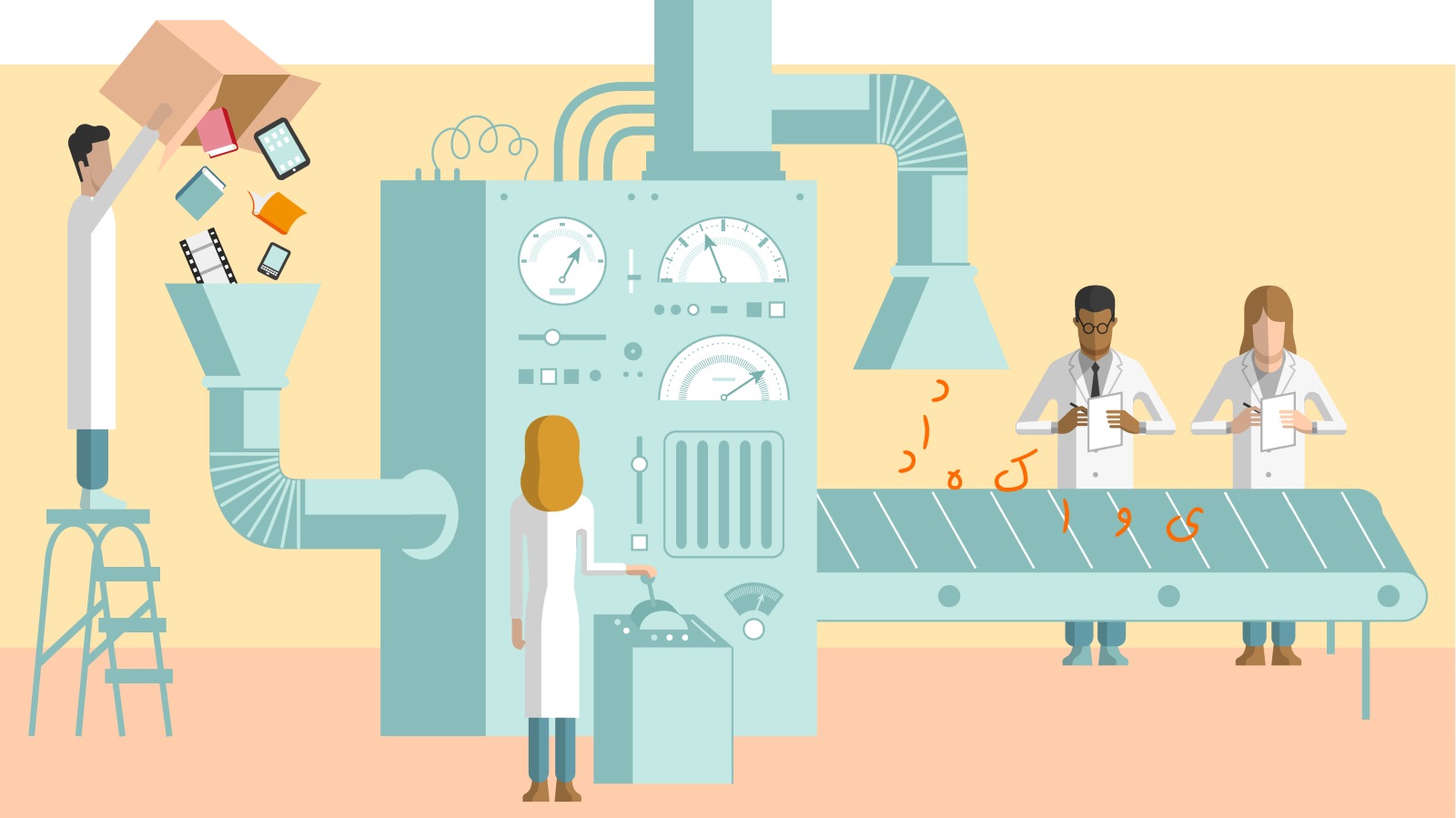

«دادهکاوی» (Data Mining)، علمی میانرشتهای شامل الگوریتمهای «یادگیری ماشین» (Machine Learning)، روشهای آماری و «سیستمهای مدیریت پایگاه داده» (Database Management Systems) به شمار میآید. هدف از انجام فرآیند دادهکاوی کشف الگوهای مهم و جالب توجه در میان حجم انبوه دادهها است.

در واقع، از دادهکاوی برای استخراج اطلاعات از حجم زیادی از دادهها استفاده میشود. این اطلاعات در زمینههای گوناگون از جمله «تحلیل بازار» (Market Analysis)، «تشخیص کلاهبرداری» (Fraud Detection)، «حفظ مشتری» (Customer Retention)، «کنترل تولید» (Production Control) و اکتشافات علمی قابل استفاده هستند.

فرآیند دادهکاوی دارای هفت گام «پاکسازی داده» (Data Cleaning)، «تبدیل داده» (Data Transformation)، «یکپارچهسازی داده» (Data Integration)، «انتخاب ویژگی» (Feature Selection)، «دادهکاوی» (Data Mining)، «ارزیابی الگو» (Pattern Evaluation) و «ارائه دانش» (Knowledge Representation) است. امکان دارد هر یک از این گامها طی فرآیند دادهکاوی بیش از یک بار انجام شوند. به چهار گام اول «پیشپردازش» (Pre-Processing) نیز گفته میشود. شایان توجه است که «کشف دانش از داده» (Knowledge Discovery From Data | KDD) عنوانی بهتر برای آنچه فرآیند دادهکاوی نامیده میشود به شمار میآید، ولیکن به دلایل گوناگون از جمله طولانی بودن، عبارت دادهکاوی پرکاربردتر و متداولتر است.

موتور دادهکاوی

«موتور دادهکاوی» (Data Mining Engine) قلب حقیقی معماری دادهکاوی محسوب میشود و شامل ابزارها و نرمافزارهایی است که برای کسب بینش و دانش از دادههای کسب شده از منبع داده و ذخیره شده در «انبار داده» (Data Warehouse) به کار گرفته میشوند. یک موتور دادهکاوی قدرتمند دارای سه مولفه اساسی است که در ادامه بیان شدهاند.

- موتور دادهکاوی نیازمند مفسر است. مفسر میتواند دستورات تعریف شده در موتور دادهکاوی را به کامپیوتر انتقال دهد.

- نیاز به چرخدندههای ارتباطی بین موتور دادهکاوی و انبار داده برای تولید و مدیریت ارتباطات این دو در هر دو جهت وجود دارد.

- نیاز به دستورالعملها و الگوریتمهایی برای هدایت فرآیند دادهکاوی است.

به طور کل باید گفت وجود موتور دادهکاوی برای سیستمهای دادهکاوی بسیار حائز اهمیت محسوب میشود. این موتور دربردارنده مجموعههای متعددی از ماژولهای تابعی است و کارکردهای گوناگونی مانند «مشخصهسازی» (Characterization)، «تحلیل انجمنی و همبستگی» (Association and Correlation Analysis)، «دستهبندی» (Classification)، پیشبینی، «تحلیل خوشه» (Cluster analysis)، «تحلیل دورافتادگی» (Outlier analysis) و «تحلیل تکاملی» (Evolution analysis) را شامل میشود.

پایگاه دانش

«پایگاه دانش» (Knowledge Base) دامنهای از دانش و در واقع فناوری مورد استفاده برای ذخیرهسازی دادههای پیچیده ساخت یافته و غیر ساخت یافته است. از این پایگاه برای هدایت کردن اکتشافات در فرآیند دادهکاوی شامل گامهای «پاکسازی دادهها» (Cleaning of data)، یکپارچهسازی دادهها، انتخاب داده، تبدیل دادهها، دادهکاوی، ارزیابی الگو و ارائه دانش استفاده میشود.

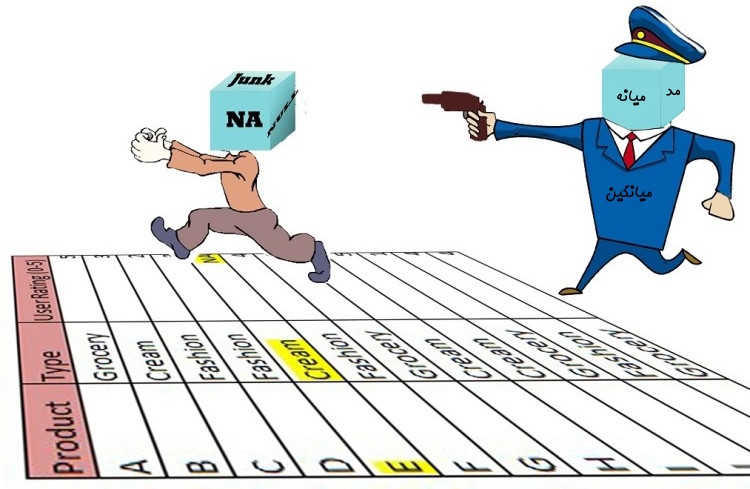

دادههای ناموجود

امکان دارد مقادیر داده به دلایل گوناگون شامل اندازهگیری نشدن (مثلا در پایگاه داده اطلاعات کودکان مبتلا به تالاسمی قد فرد اندازهگیری نشده و بدون مقدار است)، پاسخ داده نشدن به پرسش موجود در فرمها (مثلا فرد مشخص نکرده که گواهینامه رانندگی دارد یا خیر)، ناشناخته بودن مقادیر (مثلا عدد اشتباه برای سن فرد وارد شده) یا گم شدن دادهها وجود نداشته باشند.

این دادهها، «داده ناموجود» (Missing data) محسوب میشوند. روشهای دادهکاوی بسته به گونهای که با دادههای ناموجود برخورد میکنند متفاوت هستند.

دادههای غیر قابل اجرا

مقادیر ناموجودی که به لحاظ منطقی غیر ممکن هستند و یا طور مشخص مرتبط با دامنهای که برای آن وارد شدهاند نیستند را «دادههای غیر قابل اجرا» (Non-applicable Data) گویند.

پاکسازی

پاکسازی دادهها (Cleaning | Cleansing)، یک گام از فرآیند دادهکاوی و جزئی از پیشپردازش دادهها محسوب میشود که طی آن دادهها برای فعالیتهای دادهکاوی آمادهسازی میشوند. خطاهای آشکار دادهها در این مرحله شناسایی، اصلاح و «دادههای ناموجود» (Missing Data) با مقادیری (این مقادیر به روشهای گوناگون قابل محاسبه هستند) جایگزین میشوند.

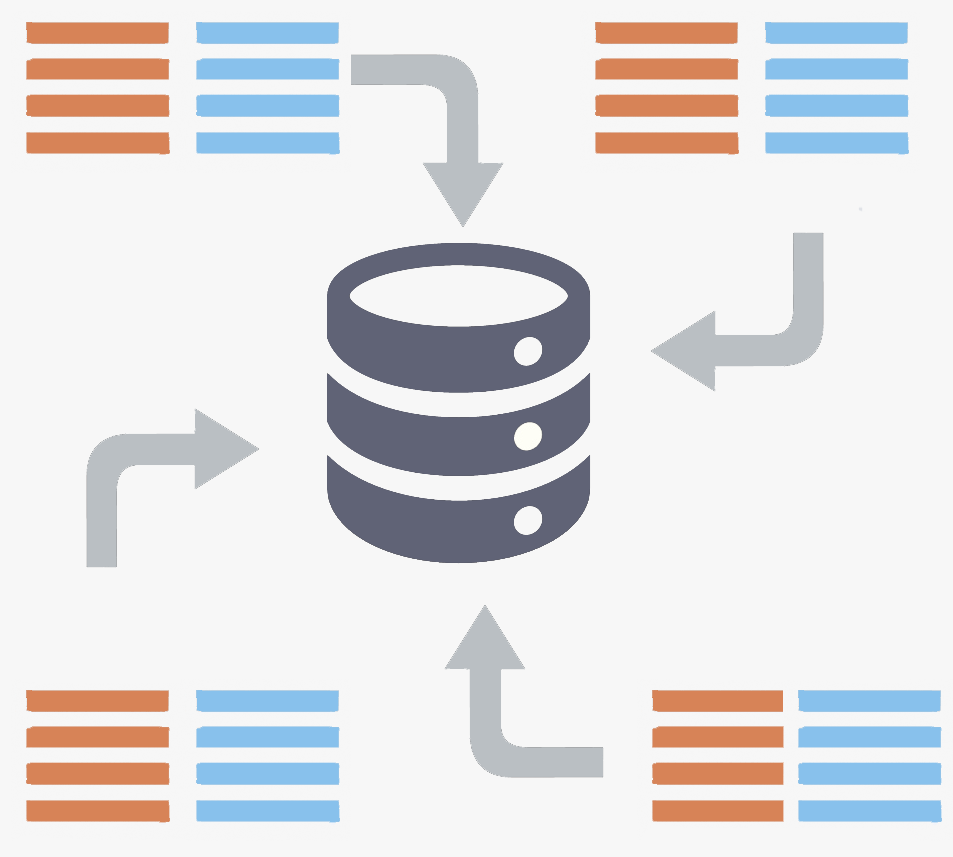

یکپارچهسازی دادهها

«یکپارچهسازی دادهها» (Data Integration)، یکی از گامهای فرآیند دادهکاوی و از مراحل پیشپردازش دادهها است. از این کار برای ادغام دادههای گردآوری شده از منابع داده ناهمگون در یک مخزن داده همبسته استفاده میشود. این مخزن در برگیرنده دادههای ناسازگار است، بنابراین نیاز به پاکسازی دادهها در آن وجود دارد.

تبدیل

«تبدیل» (Transformation) یک گام از فرآیند دادهکاوی و پیش پردازش دادهها است. در این گام یک بیان مجدد از دادهها با انجام تجمیع دوباره، نرمالسازی و تغییر واحدهای اندازهگیری آنها ارائه میشود.

بصریسازی

ابزارهای «بصریسازی» (Visualization)، دادهها را به صورت بصری نمایش میدهند تا درک بهتری از معنای آنها حاصل شود. ابزارهای بصریسازی گرافیکی طیفی از نمودارهای نقطهای ساده تا ارائههای پیچیده چند بُعدی را دارند.

استقرار

هنگامی که مدل ساخته و اعتبارسنجی شد، از آن برای تحلیل دادههای جدید و انجام پیشبینی استفاده میشود. بنابراین، به استفاده از مدل «استقرار» (Deployment) گفته میشود.

DBMS

«DBMS» سرنامی برای «Database Management System» (سیستم مدیریت پایگاه داده) است. «سیستم مدیریت پایگاه داده»، سیستم نرمافزاری مورد استفاده برای ساخت و مدیریت پایگاه داده به شمار میآید. DBMS یک راهکار سیستماتیک برای کاربران و برنامهنویسان جهت ساخت، بازیابی، به روز رسانی و مدیریت دادهها فراهم میکند.

RDBMS

«RDBMS» سرنامی برای «Relational Database Management System» (سیستم مدیریت پایگاه داده رابطهای) است. این سیستم در واقع پایگاه دادهای ساخته شده بر اساس مدل رابطهای است.

رابط کاربری

«رابط کاربری» (User Interface | UI) در معنای عام به فضایی گفته میشود که تعامل میان انسان و ماشین رخ میدهد. در واقع رابط کاربری بخش قابل مشاهده از یک ابزار است که کاربر آن را مشاهده میکند. در دادهکاوی نیز آن بخش از نرمافزارها و ابزارهای مورد استفاده که برای کاربر قابل مشاهده است (چه در ابزارهای پایگاه داده و چه زبانهای برنامهنویسی مانند پایتون و R که برای انجام تحلیل به کار میروند) رابط کاربری محسوب میشود. برخی از نقشهای رابط کاربری در ادامه بیان شدهاند.

- رابط انسان و ماشین جهت تعیین وظایف «پرسوجوی» (Query) دادهکاوی

- فراهم کردن اطلاعات برای کمک به متمرکزسازی جستوجوها

- کاوش بر اساس نتایج میانی دادهکاوی

- مرور شمای پایگاه داده و انبار داده یا ساختارهای داده

- ارزیابی الگوهای کاوش شده

- بصریسازی الگوها به اشکال گوناگون

انواع ویژگی

یک مجموعه داده از نمونهها و ویژگیها (خصیصهها) تشکیل میشود. یک ویژگی، فیلد دادهای است که مشخصههای یک شی داده را ارائه میکند. واژگان بُعد و متغیر معمولا در ادبیات این حوزه با معنای مشابه به کار میروند. اصطلاح بُعد به طور معمول توسط کارشناسان انبار داده مورد استفاده قرار میگیرد. نوع یک ویژگی توسط مجموعهای از مقادیر ممکن تعیین میشود. این انواع شامل «اسمی» (nominal) که به آن «دستهای» (categorical) نیز گفته میشود، «دودویی» (binary) و «عددی» (numeric) میشوند.

پیوسته

«دادههای پیوسته» (Continuous) میتوانند هر مقداری را در یک بازه از اعداد حقیقی بپذیرند. این مقدار الزاما نباید صحیح باشد. دادههای پیوسته متفاوت و به نوعی متضاد دادههای گسسته (Discrete) یا دستهای هستند.

گسسته

یک قلم داده که دارای مجموعه متناهی از مقادیر است را «گسسته» گویند. گسسته در اینجا متضاد «پیوسته» است.

دادههای دستهای

به طور کلی، «دادههای دستهای» (Categorical Data) قرار گیری دادهها در تعداد کمی از دستههای گسسته است. دادههای دستهای به شیوه مشخصی تعریف میشوند. برخی از این دادهها از جمله اسامی شهرها یا جنسیت افراد فاقد ترتیب و مواردی مانند دمای هوا (بالا، متوسط و پایین) دارای ترتیب هستند.

بستهبندی

«بستهبندی» (Binning) یکی از روشهای آمادهسازی دادهها طی فرآیند کاوش جهت تبدیل دادههای پیوسته به گسسته است. در این روش، نیاز به جایگزینی یک مقدار از طیف پیوسته با یک شناساگر «بسته» (bin) است.

ابعاد

هر «ویژگی» (Feature | Attribute) در مجموعه داده را که به صورت یک فیلد در فایل مسطح یا ستون در جداول پایگاه داده رابطهای ذخیره شده است یک «بُعد» (Dimension) گویند. تعداد کل ویژگیها، ابعاد مجموعه داده را مشخص میکند.

جبر خطی و آمار

روشهای آماری و مباحث جبر خطی کاربردهای بسیاری در علم داده و دادهکاوی دارند. از جمله مفاهیم آماری پر کاربرد در دادهکاوی میتوان به معیارهای تمرکز و شاخصهای پراکندگی اشاره کرد.

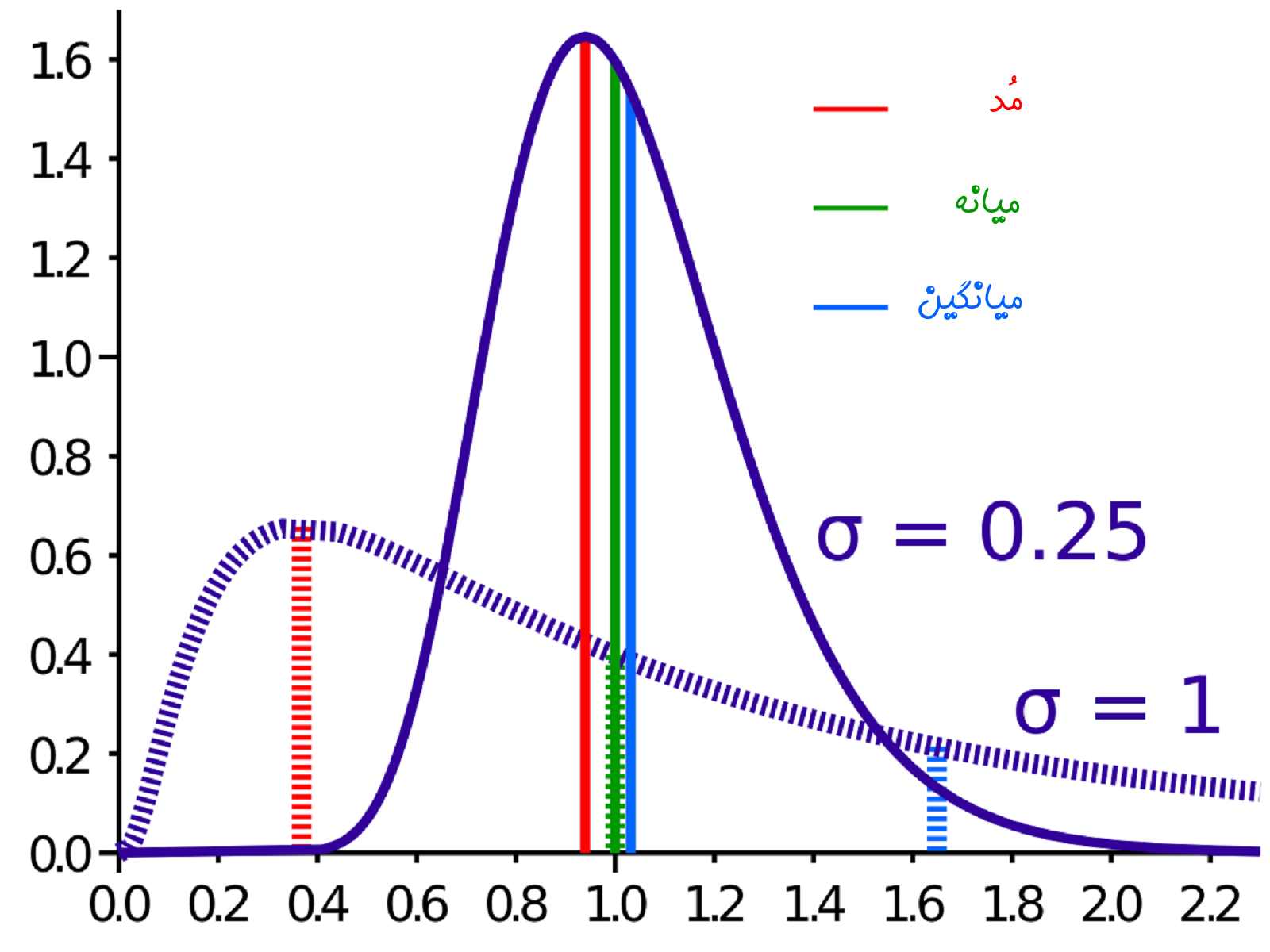

میانگین

مقادیر یک مجموعه از دادههای عددی را «میانگین حسابی» (Mean) گویند. میانگین انوع گوناگون و کاربردهای متنوعی در دادهکاوی دارد.

میانه

مقدار موجود در وسط مجموعهای از دادههای مرتب شده را میانه گویند. به بیان دیگر، مقداری با تعداد مقادیر پیشین و پسین مشابه را میانه گویند.

مُد

یک نقطه تصمیمگیری در دستهبندی مقدار مُد (Mode) است. اگر بیش از یک مقدار دارای تعداد تکرار مشابهی باشد، داده «چندمدلی» (multi-model) است.

نرمالسازی

«نرمالسازی» (Normalization)، تبدیل دادهها به مقادیر بدون واحد به منظور مقایسه بهتر آنها است. این امر موجب میشود دادهها دارای هیستوگرامی مشابه دادههای اصلی ولی در بازه جدیدی مثلا ۰ و ۱ باشند. انجام این کار برای همه ورودیهای شبکه عصبی و همچنین ورودیهای مدل رگرسیون مفید است.

کمترین مربعات

«کمترین مربعات» (Least Squares) متداولترین روش آموزش وزنهای مدل است. بدین منظور، نیاز به انتخاب وزنهایی است که انحراف مجموع مربعات از مقادیر پیشبینی شده مدل را کمینه کنند. این کار با استفاده از مقادیر مشاهده شده دادهها امکانپذیر است.

واریانس

«واریانس» (Variance) پر کاربردترین سنجه آماری مورد استفاده برای پراکندگی است. در محاسبه واریانس، گام اول آن است که مربع انحراف اقلام داده از مقدار میانگین آنها مشخص شود. سپس، میانگین مربع انحرافات باید محاسبه شود. بنابراین واریانس به عنوان معیاری برای برآورد کلی تغییرپذیری مورد نیاز است.

MARS

«MARS» سرنامی برای «Multivariate Adaptive Regression Splines» (رگرسیون چند متغیره اسپیلاین) و راهکاری برای عمومیساز ی درختهای تصمیم است.

بیشینه درستنمایی

«بیشینهسازی درستنمایی» (Maximum Likelihood) روشی برای تخمین یا آموزش مدل است. این تخمین از یک پارامتر، مقدار پارامتری است که نیاز به بیشینهسازی احتمال دادهها دارد. این دادهها از جامعه تعریف شده توسط پارامترها میآیند.

روشهای دادهکاوی

روشهای دادهکاوی در واقع روالها و الگوریتمهایی هستند که برای تحلیل دادهها در پایگاه داده مورد استفاده قرار میگیرند. این روشها در سه دسته «نظارت شده» (Supervised)، «نظارت نشده» (Unsupervised) و «نیمه نظارت شده» (Semi-Supervised) قرار میگیرند.

تحلیلهای اکتشافی

به جستوجو در دادهها به منظور کشف ارتباطاتی که پیش از این شناخته نشدهاند «تحلیل اکتشافی» (Exploratory Analysis) گفته میشود. ابزارهای تحلیل اکتشافی اغلب به کاربر در ساخت جداول و نمایش گرافیکی کمک میکنند.

استنتاج

با «استنتاج کردن» (Deduction)، اطلاعاتی که دارای توالی منطقی در دادهها هستند حاصل میشوند.

استقرا

«استقرا» (Induction) روشی است که طی آن با استفاده از اطلاعات موجود در دادهها کلیت استنباط میشود.

استاندارد شده

مجموعهای از روشها که در آن تحلیلها از یک متغیر خوشتعریف (شناخته شده) وابسته استفاده میکنند را «استاندارد شده» (Standardize) گویند.

OLAP

ابزارهای «پردازش تحلیلی برخط» (Online Analytical Processing | OLAP) به کاربر قابلیت انجام تحلیلهای چند بُعدی دادهها را میدهد.

متغیر مستقل

«متغیر مستقل» (Independent Variable)، متغیری است که در معادله برای پیشبینی متغیر خروجی استفاده میشود.

متغیر وابسته

«متغیر وابسته» (Dependent Variable)، از جمله متغیرهای مدل است که باید توسط معادله مدل و با استفاده از متغیرهای مستقل پیشبینی شود.

یادگیری

آموزش مدلها (تخمین پارامترهای آنها)، بر پایه دادههای موجود را «یادگیری» (Learning) گویند.

یادگیری نظارت نشده

گروهی از روشها که در آنها دادهها بدون استفاده از متغیرهای وابسته تعریف شدهاند را «یادگیری نظارت نشده» (Unsupervised Learning) گویند.

آموزش

«آموزش» (Training) اصطلاحی است که برای تخمین پارامترهای مدل بر پایه مجموعه داده موجود مورد استفاده قرار میگیرد.

دادههای آموزش

«داده آموزش» (Train Data)، یک مجموعه داده است که برای تخمین یا آموزش مدل مورد استفاده قرار میگیرد.

دادههای تست

یک مجموعه داده مستقل از دادههای آموزش که برای تنظیم تخمین پارامترهای مدل (مانند وزنها) مورد استفاد قرار میگیرد را «مجموعه داده تست» (Test Data Set) گویند. از مجموعه داده تست برای ارزیابی عملکرد مدلهای نظارت شده آموزش دیده نیز استفاده میشود.

درجه برازش

«درجه برازش» (Degree of fit) سنجهای است که نشان میدهد مدل چه میزان با دادههای آموزش برازش شده است.

بیش برازش

آموزش دیدن بیش از اندازه مدل با دادههای آموزش که قابلیت تعمیم مدل را از بین برده و موجب میشود مدل برای دادههای تست و دادههای جدید پاسخ غلط داشته باشد را «بیش برازش» (Over Fitting) گویند.

وابستگی

«وابستگی» (association)، نوعی از الگوریتمهای دادهکاوی است. از این الگوریتم برای ساخت قوانینی که مشخص میکنند رویدادها چگونه با هم به وقوع پیوستهاند استفاده میشود و به آن «قواعد وابستگی» (Association Rules) گفته میشود.

تالی

هنگامی که وابستگی بین دو متغیر تعریف شده باشد، آیتم دوم تالی نامیده میشود.

پشتیبان

«پشتیبان» (Support) سنجهای است که نشان میدهد چند وقت یکبار مجموعه اقلام در یک وابستگی همزمان به وقوع میپیوندند و به صورت درصدی برای همه تراکنشها نشان داده میشود. برای مثال، در ۲ درصد از خریدهای یک ابزار فروشی، بیل و کلنگ همزمان خریداری شدهاند.

شیوع

«شیوع» (Prevalence) سنجهای است از اینکه چند وقت یک بار مجموعهای از اقلام در یک وابستگی به طور همزمان به وقوع میپیوندند.

Right-hand side

هنگامی که نیاز به تعریف وابستگی در میان دو متغیر باشد، آیتم دوم در «سمت راست» (Right-hand side) قرار دارد.

کشف توالی

همچون الگوریتم وابستگی، در «کشف توالی» (Sequence Discovery) نیز توالی سریهای زمانی وجود دارد. برای مثال، ۲۰ درصد از افرادی که VCR خریدهاند، یک دوربین ویدئویی نیز طی ۴ ماه خریداری کردهاند.

لایه

اساسا، گرهها در یک «شبکه عصبی» (Neural Networks) در «لایهها» (layers) گروهبندی میشوند. همچنین، هر لایه به عنوان ورودی، خروجی یا پنهان تعریف میشود. تعداد گرههای خروجی با متغیرهای خروجی برابر است. معمولا یک یا دو لایه پنهان در یک شبکه عصبی وجود دارد.

بازگشت به عقب

«بازگشت به عقب» (Backpropagation) نوعی از روشهای آموزش مدل است. از این روش برای محاسبه وزنها در «شبکه عصبی» (Neural Network) با استفاده از دادهها استفاده میشود.

پیشخور

یک «شبکه عصبی پیشخور» (Feedforward Neural Network)، شبکهای است که سیگنالهای آن از ورودی گرفته تا خروجی تنها در یک جهت قرار میگیرند.

توپولوژی

در یک شبکه عصبی، «توپولوژی» (Topology) به تعداد لایهها و تعداد گرههای هر لایه باز میگردد.

دستهبندی

«دستهبندی» (Classification)، روشی برای حل مسائل دادهکاوی است که طی آن دسته دادههای موجود، با ساخت یک مدل پیشبینی میشود. مدل مذکور برپایه تعدادی متغیر پیشبین ساخته میشود.

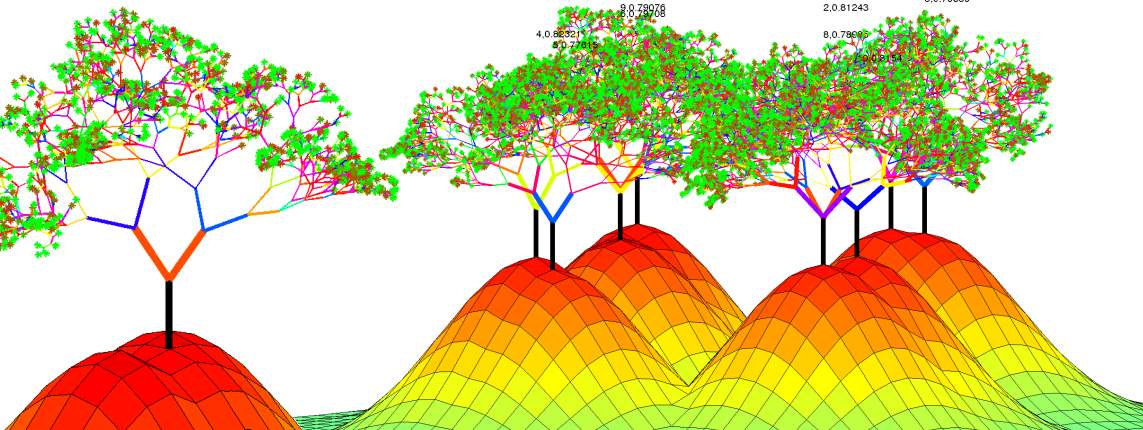

درخت تصمیم

از «درخت تصمیم» (Decision Tree) برای ارائه مجموعهای از قواعد سلسهمراتبی که منتج به یک کلاس یا مقدار میشوند استفاده میشود.

درخت دستهبندی

درخت دستهبندی نوعی درخت تصمیم است که «متغیرهای دستهای» (Categorical Variables) را در کلاسها قرار میدهد.

درخت رگرسیون

«درخت رگرسیون» (Regression Tree)، یک درخت تصمیم است که مقدار متغیرهای پیوسته را پیشبینی میکند.

CART

CART به درختهای دستهبندی و رگرسیون گفته میشود و در واقع سرنامی برای عبارت «Classification And Regression Tree» است. در این روش، متغیرهای مستقل در گروههای کوچکتری قرار گرفته و در واقع جداسازی میشوند و یک تابع ثابت برای مجموعه دادههای کوچکتر برازش داده میشود. در درخت رگرسیون مقدار میانگین پاسخ برای مجموعه دادههای کوچک متصل برازش داده میشود.

CHAID

«CHAID» سرنامی برای عبارت «Chi-squared Automatic Interaction Detector» (شناساگر تعامل خودکار خی دو) است. این الگوریتم برای برازش درختهای دستهای مورد استفاده قرار میگیرد و برای جداسازی دادهها در مجموعههای دادههای کوچک متصل بر آمارهای خی دو تکیه دارد.

برگ

گرهای در درخت رگرسیون یا دستهبندی که قابل تقسیم نیست را «برگ» (Leaf) گویند.

هرس کردن

حذف سطح پایینتر در درخت تصمیم را «هرس کردن» (Pruning) گویند. همچنین، از این اصطلاح برای تشریح الگوریتمها نیز استفاده میشود. زیرا میتوان از این اصطلاح برای تنظیم توپولوژی یک شبکه عصبی با حذف (هرس کردن) گرههای پنهان استفاده کرد.

گره

یک نقطه تصمیمگیری در یک درخت تصمیم را «گره» (Node) گویند. همچنین، یک نقطه در شبکه عصبی که نیاز به ترکیب ورودیها از دیگر گرهها دارد را گویند.

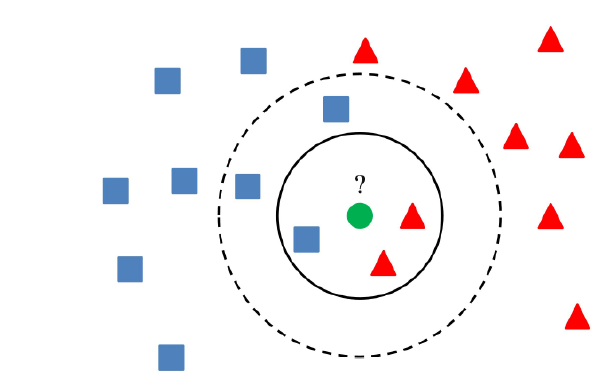

k-نزدیکترین همسایگی

«k-نزدیکترین همسایگی» (k-nearest neighbor)، یک روش دستهبندی است که نقاط داده را با محاسبه فاصله میان آنها دستهبندی میکند. سپس، نقطه را به دستهای که بیشترین همسایههای آن قرار دارند تخصیص میدهد (k در این الگوریتم مقدار صحیح است).

الگوریتم ژنتیک

«الگوریتم ژنتیک» (Genetic Algorithm) یک روش کامپیوتری برای تولید و ارزیابی ترکیبی از پارامترهای ورودی محتمل است. این الگوریتم باید خروجی بهینه را پیدا کند و از فرآیندی بر مبنای مفاهیم «تکامل طبیعی» (Natural Evolution) مانند «ترکیب ژنتیکی» (Genetic Combination)، «جهش» (Mutation) و «انتخاب طبیعی» (Natural Selection) در این راستا استفاده میکند.

ارزیابی مدل

یک مدل دادهکاوی پس از نهایی شدن، باید از ابعاد گوناگون از جمله ارائه پاسخهای صحیح برای دادههای جدید و قابلیت تعمیم مورد بررسی قرار بگیرد و «ارزیابی» (Evaluation) شود.

اعتبارسنجی

فرآیند ارزیابی مدل با مجموعه داده متفاوت از مجموعه داده آموزش را «اعتبارسنجی» (Validation) گویند.

ماتریس درهمریختگی

«ماتریس درهمریختگی» (Confusion Matrix) از جمله روشهای ارزیابی الگوریتمهای دادهکاوی به ویژه در یادگیری نظارت شده محسوب میشود که نشان میدهد دسته چه تعداد از دادهها به درستی پیشبینی شده است. همچنین جزئیات دیگری نیز در همین رابطه به دست میدهد.

اعتبارسنجی متقابل

«اعتبارسنجی متقابل» (Cross-Validation) روشی برای تخمین صحت یک مدل رگرسیون است. در این روش، مجموعه داده به چندین بخش شامل دادههای «آموزش» (Train)، «آزمون» (Test) و «اعتبارسنجی» (Validation) تقسیم میشود. دادههای آموزش برای برازش مدل و دادههای آزمون و اعتبارسنجی برای ارزیابی مدل برازش شده با دادههای آموزش مورد استفاده قرار میگیرند.

معیارهای بهینهسازی

«معیار بهینهسازی» (ٰOptimization Criterion)، یک تابع مثبت از تفاوت بین پیشبینیها و تخمینهای دادهای است که انتخاب شدهاند، تا تابع یا ساخت را بهینهسازی کنند. کمترین مربعات و بیشینهسازی درستنمایی از جمله معیارهای بهینهسازی محسوب میشوند.

تحلیل تمایز

«تحلیل تمایز» (Discriminant analysis) نوعی از روشهای آماری است که بر پایه «بیشینه درست نمایی» (maximum likelihood) برای تعیین مرزها بنا نها شده است. این مرزها باید دادهها را در دستههای جداگانهای قرار دهند.

آنتروپی

«آنتروپی» (Entropy | بینظمی) روشی برای محاسبه بینظمی در دادهها است که بر مدل احتمالی تکیه دارد. برخی از درختهای تصمیم، دادهها را به گروههایی بر مبنای حداقل آنتروپی تقسیم میکنند.

R-squared

R-squared عددی است بین ۰ و ۱ که اندازهگیری میکند یک مدل چقدر خوب روی مجموعه دادههای آموزش برازش شده است. صفر حاکی از آن است که مدل هیچ توانایی پیشبینی ندارد. این روش «کوواریانس» (Covariance) بین مقادیر پیشبینی و مشاهده شده که توسط «انحراف معیار» مقادیر پیشبینی و مشاهده شده تقسیم شدهاند را محاسبه میکند.

سایر مفاهیم

دیگر مفاهیم مورد استفاده در این حوزه در ادامه بیان شدهاند.

منطق فازی

«منطق فازی» (Fuzzy Logic)، بر مجموعههای فازی اعمال شده است. عضویت در یک مجموعه فازی دارای درجهای است که الزاما ۰ یا ۱ نیست. منطق غیر فازی خروجیهایی را دستکاری میکند که درست یا غلط هستند. منطق فازی نیاز به دستکاری درجه «امکان» علاوه بر درست و غلط دارد.

نقشه ویژگی Kohonen

«نقشه ویژگی Kohonen» نوعی از شبکههای عصبی است که از یادگیری نظارت نشده برای یافتن الگوها در دادهها استفاده میکند. در دادهکاوی، از این روش برای تحلیل خوشه استفاده میشود.

دورافتادگی

به طور کلی، «دورافتادهها» (outliers) اقلام دادهای هستند که از جامعه مورد نظر دادهها نیامدهاند.

دامنه

دامنه دادهها تفاوت بین مقدار بیشینه و مقدار کمینه است. به طور همزمان، یک دامنه میتواند شامل کمینه و بیشینه باشد.

تعامل

«تعامل» (Interaction) زمانی به وقوع میپیوندد که دو متغیر مستقل با یکدیگر تعامل داشته باشند. به عبارت دیگر هر گاه تغییر مقدار یک متغیر، اثر بر متغیر وابسته دیگری را تغییر دهد تعامل به وقوع پیوسته است.

خطای وضعیت مجدد

تخمین خطا بر پایه تفاوت بین مقادیر پیشبینی شده و مقادیر موجود در مجموعه داده آموزش را «خطای وضعیت مجدد» (Resubstitution Error) گویند.

نمونهبرداری

ساخت یک زیر مجموعه از کل دادهها را «نمونهبرداری» (Sampling) گویند. نمونهبرداری تصادفی در تلاش برای نشان دادن همه چیز با انتخاب دادههای نمونه از طریق یک مکانیزم تصادفی است.

تحلیل حساسیت

تنوع پارامترهای یک مدل به منظور ارزیابی تغییرات در ورودی را «تحلیل حساسیت» (Sensitivity Analysis) گویند.

پردازش موازی

پردازش انجام شده توسط چندین کامپیوتر یا واحد پردازش مرکزی (CPU | Central Processing Unit) که به یکدیگر متصل شدهاند و میتوانند به طور همزمان محاسبات انجام دهند را «پردازش موازی» (Parallel Processing) گویند.

SMP

«SMP» سرنامی برای عبارت «Symmetric Multi-processing» (چند پردازشی متقارن) محسوب میشود و پیکربندی کامپیوتری است که در آن پردازندههای زیادی یک سیستمعامل واحد، حافظه اصلی و دیسک را با یکدیگر به اشتراک میگذراند. این پردازندهها میتوانند روی بخشهای گوناگون مساله به طور همزمان کار کنند.

خطای تست

تخمین خطا بر پایه مجموعه تفاوت بین پیشبینیهای مدل روی دادههای تست و مقادیر مشاهده شده در مجموعه دادههای تست هنگامی که دادههای تست برای آموزش مدل مورد استفاده قرار نگرفتهاند را «خطای تست» (Test Error) گویند.

سریهای زمانی

یک سری از مقادیر که در نقاط متوالی در زمان به وقوع پیوستهاند را «سری زمانی» (Time Series) گویند. سریهای زمانی نوعی داده محسوب میشوند.

مدل سریهای زمانی

«مدل سریهای زمانی» (Time Series Model) نوعی مدل است که مقادیر آینده یک سری زمانی را بر اساس مقادیر پیشین محاسبه میکند.

پنجرهسازی

از «پنجرهسازی» (Windowing) هنگامی استفاده میشود که یک مدل با دادههای سری زمانی آموزش داده میشود. یک پنجره، یک دوره از زمان برای هر مورد آموزش است. برای مثال،فرض میشود دادههای قیمتهای هفتگی بازار بورس برای ۵۰ هفته موجود باشند. پس باید پنجره را روی ۵ هفته تنظیم کرد. علاوه بر این، اولین مورد آموزش از هفتههای یکی تا پنج استفاده کرده و پیشبینهای آن را با هفته ششم مقایسه میکند. علاوه بر این، مورد دوم از هفته دو تا شش را برای پیشبینی هفته هفتم مورد استفاده قرار میدهد و به همین صورت.

نتیجهگیری

واژگان بیان شده در بالا و تعاریف آنها از پر کاربردترین مفاهیم مورد استفاده در زمینه دادهکاوی هستند. این واژگان در این مطلب به صورت کلی شرح داده شدند تا چشماندازی کلی از آنها حاصل شود. برای درک جزئیات هر یک، میتوان از لینکهای ارائه شده در مطلب استفاده کرد. همچنین، برای علاقمندان به یادگیری دادهکاوی به طور کامل، مجموعه آموزشهای آمار، احتمالات و دادهکاوی توصیه میشود.

اگر مطلب بالا برای شما مفید بوده، آموزشهای زیر نیز به شما پیشنهاد میشوند:

- مجموعه آموزشهای آمار، احتمالات و دادهکاوی

- مجموعه آموزشهای یادگیری ماشین و بازشناسی الگو

- مجموعه آموزشهای هوش محاسباتی

- مجموعه آموزشهای شبکههای عصبی مصنوعی

- گنجینه آموزشهای برنامه نویسی پایتون (Python)

- آموزش برنامهنویسی R و نرمافزار R Studio

- مجموعه آموزشهای برنامه نویسی متلب (MATLAB)

- علم داده، تحلیل داده، دادهکاوی و یادگیری ماشین ــ تفاوتها و شباهتها

- دوره آموزش یادگیری ماشین وبلاگ فرادرس با مثالهای کاربردی

^^

سلام و خیلی ممنون از مطالب مفید ی که یه زبان ساده آموزش م ذهید من اطلاعاتی در باره مدل Dsmart میخواستم \یدا نکردم اگر راهنمایی بفرمایید ممنو می شومن