انتخاب ویژگی (Feature Selection) در داده های ابعاد بالا — خودآموز ساده

روشهای انتخاب ویژگی (Feature Selection Methods) به منظور مواجهه با دادههای ابعاد بالا، به مولفهای جدایی ناپذیر از فرآیند یادگیری مبدل شدهاند. یک انتخاب ویژگی صحیح میتواند منجر به بهبود یادگیرنده استقرایی از جهتهای گوناگون از جمله سرعت یادگیری، ظرفیت تعمیم و سادگی مدل استنتاج شده شود. در این مطلب بحث استخراج ویژگی و انتخاب ویژگی و انواع روشهای آن مورد بررس قرار میگیرد.

طی چند سال اخیر، مجموعه دادههای متعددی با ابعاد بالا در اینترنت در دسترس عموم قرار گرفتند. این امر چالش جالب توجهی را برای جوامع پژوهشی در پی داشت، زیرا برای الگوریتمهای یادگیری ماشین سر و کار داشتن با حجم زیادی از ویژگیهای ورودی کاری دشوار است. در حال حاضر، ابعاد مجموعه دادههای بنچمارک که از مخازن داده گوناگون در دسترس هستند به میلیونها عدد یا حتی بیشتر افزایش یافته است. در حقیقت، تحلیلهایی که توسط پژوهشگران انجام شده حاکی از آن است که ۷ تا از ۱۱ مجموعه دادهای که در سال ۲۰۰۷ منتشر شدهاند دارای ابعادی بالغ بر میلیونها ویژگی بودهاند. برای مواجهه با مساله تعداد بالای ویژگیها، روشهای کاهش ابعاد الزامی است و میتوانند به بهبود کارایی یادگیری کمک کنند.

اصطلاح «ابعاد کلان» (Big Dimensionality) برای اشاره به مشکل مذکور استفاده میشود و در قیاس با واژه «کلان داده» (مِه داده | Big Data) که با حجم نمونههای بالا سر و کار دارد، ساخته شده است. روشهای کاهش ابعاد اغلب در دو دسته انتخاب ویژگی و استخراج ویژگی قرار دارند و هر یک از آنها دارای خصوصیات ویژه خود هستند. از یک سو، روشهای استخراج ویژگی با ترکیب ویژگیهای اصلی به کاهش ابعاد دست مییابند. از این رو، قادر به ساخت مجموعهای از ویژگیهای جدید هستند که معمولا فشردهتر و دارای خاصیت متمایزکنندگی بیشتری است. این روشها در کاربردهایی مانند تحلیل تصویر، پردازش تصویر و بازیابی اطلاعات (information retrieval) ترجیح داده میشوند زیرا در این موارد صحت مدل از تفسیرپذیری آن بیشتر حائز اهمیت است.

از سوی دیگر، انتخاب ویژگی با حذف ویژگیهای غیر مرتبط و تکراری به کاهش ابعاد منجر میشود. انتخاب ویژگی به طور گسترده در کاربردهای گوناگون دادهکاوی مانند «متنکاوی» (Text Mining)، «تحلیل ژنتیک» (genetic analysis) و پردازش دادههای حسگرها مورد استفاده قرار میگیرد. انتخاب ویژگی برای کاربردهایی که در آنها ویژگیهای اصلی برای تفسیر مدل و استخراج دانش مهم هستند بسیار کاربردپذیر است زیرا طی این فرآیند ویژگیهای اصلی مجموعه داده حفظ میشوند. در ادامه مبانی انتخاب ویژگی شرح داده خواهد شد.

انتخاب ویژگی

انتخاب ویژگی را میتوان به عنوان فرآیند شناسایی ویژگیهای مرتبط و حذف ویژگیهای غیر مرتبط و تکراری با هدف مشاهده زیرمجموعهای از ویژگیها که مساله را به خوبی و با حداقل کاهش درجه کارایی تشریح میکنند تعریف کرد. این کار مزایای گوناگونی دارد که برخی از آنها در ادامه بیان شدهاند.

- بهبود کارایی الگوریتمهای یادگیری ماشین

- درک داده، کسب دانش درباره فرآیند و کمک به بصریسازی آن

- کاهش داده کلی، محدود کردن نیازمندیها ذخیرهسازی و احتمالا کمک به کاهش هزینهها

- کاهش مجموعه ویژگیها، ذخیرهسازی منابع در دور بعدی گردآوری داده یا در طول بهرهبرداری

- سادگی و قابلیت استفاده از مدلهای سادهتر و کسب سرعت

به همه دلایل گفته شده، در سناریوهای «تحلیل کلان داده»، انتخاب ویژگی نقشی اساسی ایفا میکند.

ویژگی مرتبط

برای تشخیص یک «ویژگی مرتبط» (Feature Relevance) با مساله، از این تعریف استفاده میشود: «یک ویژگی مرتبط است اگر شامل اطلاعاتی پیرامون هدف باشد». به بیان رسمیتر، «جان» (John) و کوهاوی (Kohavi) ویژگیها را به سه دسته جدا از هم تقسیم کردهاند که «به شدت مرتبط» (strongly relevant)، «به طور ضعیف مرتبط» (weakly relevant) و «ویژگی غیرمرتبط» (irrelevant features) نامیده میشوند.

در رویکرد این پژوهشگران، ارتباط ویژگی X به صورت یک دستهبندی بیزی ایدهآل تعریف میشود. ویژگی X، هنگامی که حذف آن منجر به آسیب دیدن صحت پیشبینی دستهبندی بیزیی ایدهآل شود، به شدت مرتبط محسوب میشود. این ویژگی به طور ضعیف مرتبط نامیده میشود اگر به شدت مرتبط نباشد و یک زیرمجموعه از ویژگیهای S وجود داشته باشد، به طوری که کارایی دستهبندی ایدهآل بیزی روی S بدتر از کارایی {S∪{X باشد. یک ویژگی نامرتبط تعریف میشود اگر به شدت و به طور ضعیف مرتبط نباشد.

افزونگی ویژگی

یک ویژگی معمولا در صورت وجود همبستگی بین ویژگیها دارای افزونگی (Feature Redundancy) محسوب میشود. این مفهوم که دو ویژگی نسبت به هم دارای افزونگی هستند اگر مقادیر آنها کاملا همبسته باشد توسط پژوهشگران زیادی پذیرفته شده، اما در عین حال امکان دارد تشخیص افزونگی ویژگیها هنگامی که یک ویژگی با یک مجموعه از ویژگیها مرتبط است کار سادهای نباشد.

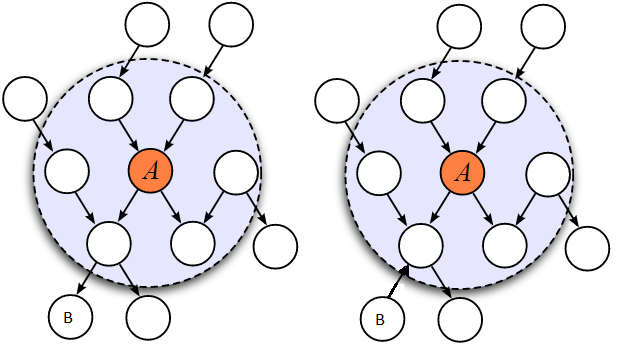

مطابق با تعریف ارائه شده توسط جان و کوهاوی، یک ویژگی در صورتی دارای افزونگی است و در نتیجه باید حذف شود که به طور ضعیف مرتبط و دارای پوشش مارکوف (Markov blanket) درون مجموعه ویژگیهای کنونی باشد. از آنجا که ویژگیهای غیرمرتبط باید به هر سو حذف شوند، پاکسازی آنها بر اساس این تعریف انجام میشود.

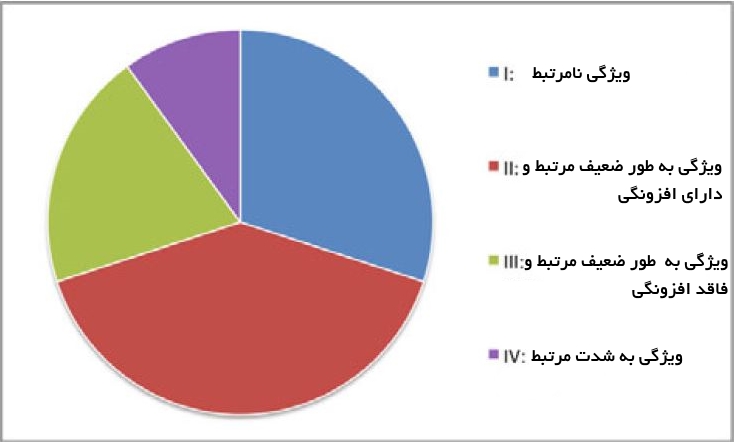

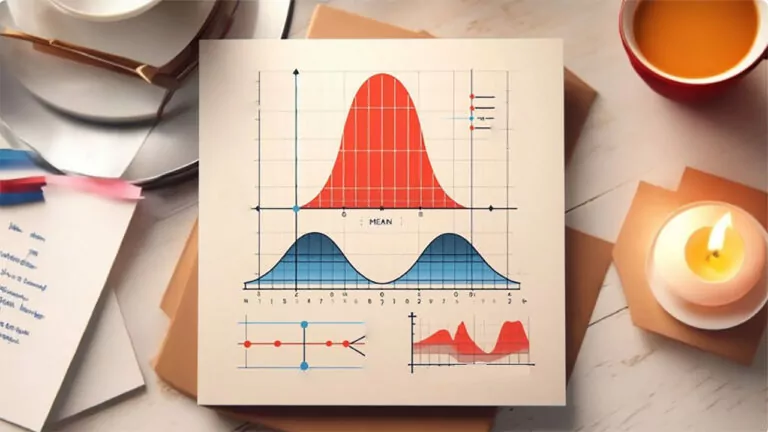

در شکل زیر چشماندازی از ارتباط بین ارتباط ویژگیها و افزونگی ارائه شده است. کل مجموعه ویژگی میتواند به طور مفهومی به چهار بخش مجزا تقسیم شود که عبارتند از ویژگیهای نامرتبط (I)، ویژگیهای به طور ضعیف مرتبط و ویژگیهای دارای افزونگی (II)، ویژگیهای به طور ضعیف مرتبط ولی فاقد افزونگی (III) و ویژگیهای به شدت قدرتمند (IV). لازم به ذکر است که مجموعه بهینه حاوی همه ویژگیهای موجود در بخشهای III و IV میشود.

روشهای انتخاب ویژگی

روشهای انتخاب ویژگی به دو دسته کلی «ارزیابی فردی» (individual evaluation) و «ارزیابی زیرمجموعهها» (subset evaluation) تقسیم میشوند. ارزیابی تکی همچنین با عنوان «رتبهبندی ویژگیها» (feature ranking) شناخته شده و ویژگیهای فردی را با تخصیص دادن وزن به آنها مطابق درجه ارتباطشان ارزیابی میکند. از سوی دیگر، ارزیابی زیرمجموعهها یک زیرمجموعه از ویژگیهای کاندید را براساس یک استراتژی جستوجوی خاص فراهم میکند.

هر زیرمجموعه کاندید با استفاده از یک سنجه ارزیابی مشخص ارزیابی و با بهترینهای پیشین با توجه به این سنجه مقایسه میشود. در حالیکه ارزیابی فردی از حذف ویژگیهای دارای افزونگی به دلیل آنکه احتمال دارد ویژگیهای دارای افزونگی رتبهبندی مشابهی داشته باشند ناتوان است، رویکرد ارزیابی زیرمجموعهها میتواند افزونگی ویژگیها را با ارتباط ویژگیها مدیریت کند.

اگرچه روشهای ارائه شده در این چارچوب دارای مشکلات اجتنابناپذیری هستند که به دلیل جستوجو در سراسر زیر مجموعههای ویژگی مورد نیاز در مرحله ساخت زیرمجموعه به وقوع میپیوندد و بنابراین هر دو روش انتخاب ویژگی بیان شده نیازمند مطالعات بیشتری هستند. در کنار این دستهبندی، سه رویکرد کلی انتخاب ویژگی با توجه به ارتباط بین الگوریتمهای انتخاب ویژگی و روش یادگیری استقرایی (inductive learning method) برای استنتاج یک مدل مورد استفاده قرار میگیرند. این موارد در ادامه بیان شدهاند.

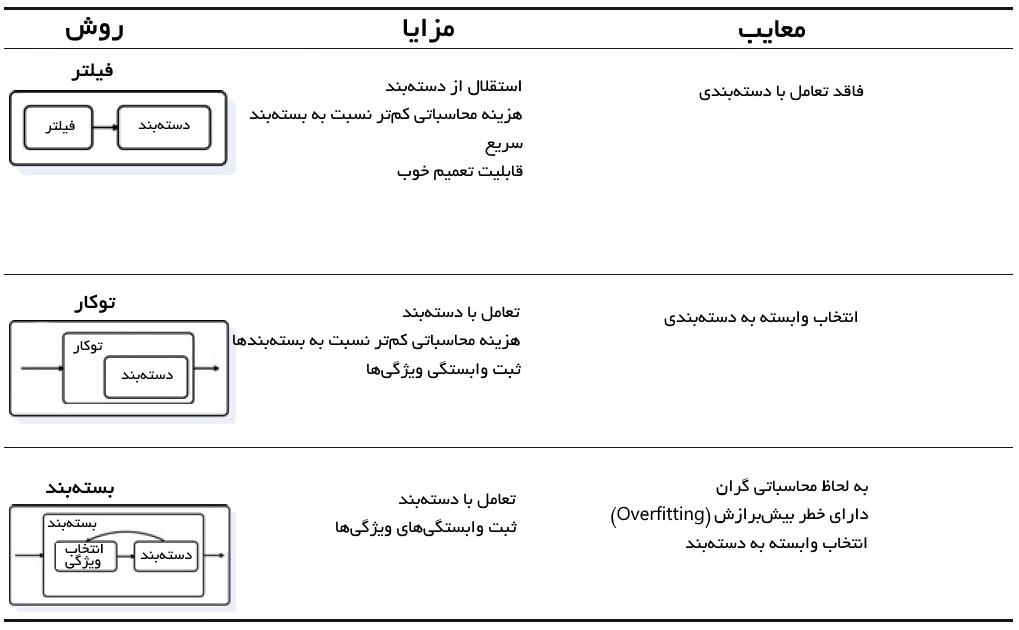

«فیلترها» (Filters) بر ویژگیهای کلی مجموعه داده آموزش تکیه دارند و فرآیند انتخاب ویژگی را به عنوان یک گام پیش پردازش با استقلال از الگوریتم استقرایی انجام میدهند. مزیت این مدلها هزینه محاسباتی پایین و توانایی تعمیم خوب آنها محسوب میشود.

«بستهبندها» (Wrappers) شامل یک الگوریتم یادگیری به عنوان جعبه سیاه هستند و از کارایی پیشبینی آن برای ارزیابی مفید بودن زیرمجموعهای از متغیرها استفاده میکنند. به عبارت دیگر، الگوریتم انتخاب ویژگی از روش یادگیری به عنوان یک زیرمجموعه با بار محاسباتی استفاده میکند که از فراخوانی الگوریتم برای ارزیابی هر زیرمجموعه از ویژگیها نشات میگیرد. با این حال، این تعامل با دستهبند منجر به نتایج کارایی بهتری نسبت به فیلترها میشود.

«روشهای توکار» (Embedded) انتخاب ویژگی را در فرآیند آموزش انجام میدهند و معمولا برای ماشینهای یادگیری خاصی مورد استفاده قرار میگیرند. در این روشها، جستوجو برای یک زیرمجموعه بهینه از ویژگیها در مرحله ساخت دستهبند انجام میشود و میتوان آن را به عنوان جستوجویی در فضای ترکیبی از زیر مجموعهها و فرضیهها دید. این روشها قادر به ثبت وابستگیها با هزینههای محاسباتی پایینتر نسبت به بستهبندها هستند.

در جدول زیر خلاصهای از سه روش انتخاب ویژگی معرفی شده در بالا آمده و برجستهترین مزایا و معایب آنها را بیان شده است. با در نظر گرفتن این که چندین الگوریتم برای هر یک از رویکردهای پیشتر بیان شده وجود دارد باید گفت تعداد زیادی روش انتخاب ویژگی وجود دارد.

روشهای انتخاب ویژگی

بسیاری از پژوهشگران توافق دارند که «بهترین روش» (به صورت مطلق) برای انتخاب ویژگی وجود ندارد و از این رو تلاشهای آنها بر انتخاب روشی متمرکز شده که برای یک مساله مشخص بهتر عمل میکند. روشهای گوناگونی برای مواجهه با مجموعه دادههای کلان مقیاس وجود دارد که اهمیت انتخاب ویژگی در آنها واقعیتی غیر قابل انکار است، زیرا منجر به کمینه کردن زمان آموزش و حافظه تخصیص داده شده با حفظ صحت نتایج میشود. با این حال، به یاد داشتن این امر حائز اهمیت است که بیشتر روشهای انتخاب ویژگی از کارایی مدل یاد گرفته شده به عنوان بخشی از فرآیند انتخاب استفاده میکنند.

در حقیقت، از سه دسته بیان شده در بالا (فیلترها، بستهبندها و روشهای توکار) تنها فیلترها مستقل از الگوریتم هستند. این خصوصیت موجب میشود که فیلترها به لحاظ محاسباتی ساده و سریع و همچنین قادر به مدیریت مجموعه دادههای کلان مقیاس باشند. اغلب فیلترها تک متغیره هستند (هر ویژگی را مستقل از سایر ویژگیها در نظر میگیرند)، و این امر میتواند منجر به غلبه بر روشهای چند متغیرهای شود که نیازمند منابع محاسباتی بیشتر هستند.

اگر نوشته بالا برای شما مفید بوده، آموزشهای زیر نیز به شما پیشنهاد میشوند:

- مجموعه آموزشهای آمار، احتمالات و دادهکاوی

- مجموعه آموزشهای مدلسازی، برازش و تخمین

- مجموعه آموزشهای شبکههای عصبی مصنوعی

- مجموعه آموزشهای هوش محاسباتی

- آموزش انتخاب ویژگی یا Feature Selection

- آموزش انتخاب ویژگی با استفاده از الگوریتم های فراابتکاری و تکاملی

- اصطلاحات کاربردی خوشهبندی — به زبان ساده

^^

مطلب شما مفید بود ممنونم.

سلام

مثل همیشه عالی.

عالی ممنونم