احتمال پسین (Posterior Probability) و احتمال پیشین (Prior Probability) — به زبان ساده

در مباحث مربوط به «آمار بیز» (Bayesian Statistics)، احتمال پسین برای یک متغیر تصادفی همان احتمال شرطی است که براساس شواهد قبلی در مورد رخداد آن پیشامد محاسبه میشود. این احتمال شرطی را، احتمال پسین (Posterior Probability) میگویند. از طرف دیگر احتمال کسب چنین شواهدی نیز به احتمال پیشین (Prior Probability) معروف است.

از آنجایی که در ادامه براساس قضیه و رابطه بیز (Bayesian Theorem) پیش خواهیم رفت، مطالعه مطلب قضیه بیز در احتمال شرطی و کاربردهای آن ضروری به نظر میرسد. همچنین به منظور اطلاع از خصوصیات تابع احتمال، بهتر است مطلب آزمایش تصادفی، پیشامد و تابع احتمال را قبلا مطالعه کرده باشید. همچنبن خواندن مطلب تابع درستنمایی (Likelihood Function) و کاربردهای آن — به زبان ساده نیز خالی از لطف نیست.

احتمال پسین

اگر فرض کنیم که پارامتر توزیع متغیر تصادفی X است، خود دارای توزیع احتمال باشد و به آن به چشم یک متغیر تصادفی نگاه کنیم، مسئله احتمال پسین پیش میآید. به این ترتیب میتوان این احتمال را به عنوان تابع احتمال متغیر به شرط متغیر تصادفی X در نظر گرفت. در این حالت احتمال پسین را به صورت نشان میدهند. به این ترتیب قضاوت در مورد پارامتر توزیع میتواند با توجه به شواهدی که در مورد آن مشاهده شده (مقدارهای مشاهده شده از متغیر تصادفی X) با دقت بیشتری صورت گیرد.

در مقابل تابع درستنمایی (Likelihood Function)، تابع احتمال متغیر تصادفی X به شرط پارامتر است، اگر آن را به عنوان تابعی از پارامتر نگاه کنیم. در اینجا تابع درستنمایی را به صورت مشخص میکنیم.

رابطه احتمال پسین و پیشین با تابع درستنمایی

این دو بخش توسط رابطه زیر با یکدیگر ارتباط دارند:

فرض کنید که براساس اطلاعات پیشین (Prior Information)، میدانیم که تابع احتمال به صورت است و مشاهدات x نیز با تابع درستنمایی در دسترس هستند. آنگاه تابع احتمال پسین که آن را با نشان میدهیم، بر طبق قضیه بیز برابر است با:

توجه کنید که در اینجا تابع «احتمال پیشین» (Prior Probability) برای پارامتر به صورت نوشته شده است.

نکته: مخرج کسر به این علت براساس نوشته شده است تا احتمال پسین دارای خصوصیات تابع احتمال باشد، مثلا مقدار آن بین ۰ تا ۱ قرار بگیرد. پس مخرج کسر وظیفه نرمالسازی و یا سازگاری محاسبات با مفهوم احتمال را دارد.

اگر بدون در نظر گرفتن مخرج کسر که البته مرتبط با نیز نمیباشد، رابطه را بررسی کنیم به فرم سادهتر زیر میتوان رسید:

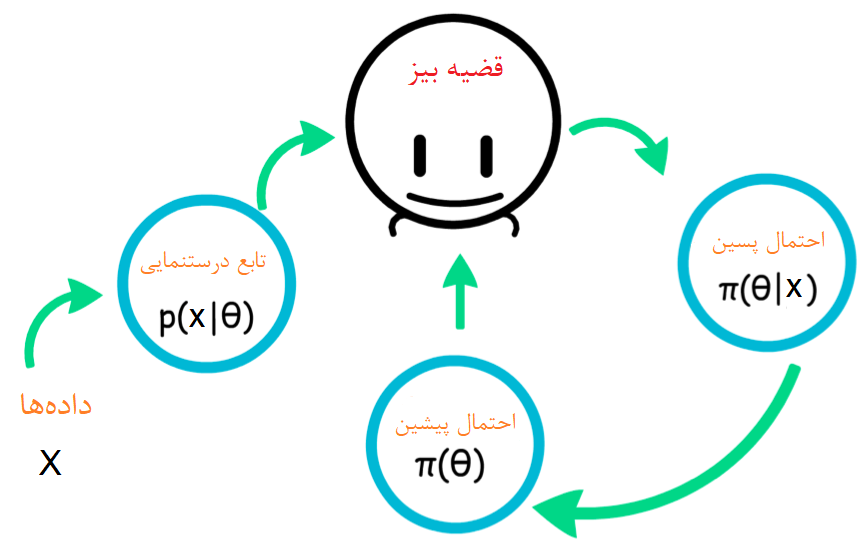

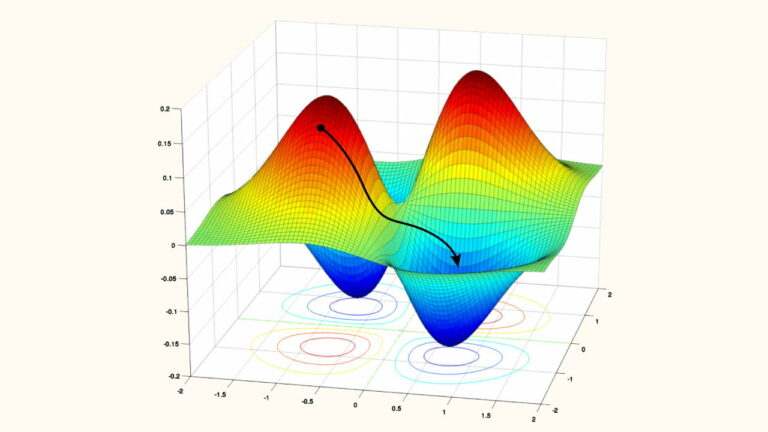

اغلب برای استنباط آماری برای پارامتر توزیع براساس احتمال پسین و پیشین، از رابطه بالا کمک میگیرند. همانطور که در تصویر بالا دیده میشود، براساس مشاهداتی از X تابع درستنمایی برای پارامتر ساخته میشود. با توجه به اصلاعات پیشین که در مورد تابع احتمال پارامتر داریم تفکر و بررسی کرده و به نتیجه جدیدی برای تابع احتمال پارامتر میرسیم که به آن تابع احتمال پسین میگویند. ممکن است این کار براساس یک نمونه جدید دیگر دوباره انجام شود و در این مرحله تابع پسین قبلی به عنوان تابع پیشین جدید در محاسبات به کار میرود.

برای روشن شدن شیوه محاسبه تابع احتمال پسین به کمک قضیه بیز به یک مثال میپردازیم.

مثال ۱

فرض کنید در یک مدرسه 60٪ دانشآموزان در تورهای فرهنگی و ۴۰٪ نیز در تورهای علمی ثبت نام کردهاند. برای تور فرهنگی افراد باید یا دوربین و یا دفترچه یادداشت به همراه داشت باشند. فرض کنید نیمی از دانشآموزان تور فرهنگی دارای دوربین و نیمی نیز دفترچه دارند. از طرف دیگر دانشآموزان تور علمی باید فقط دفترچه همراه داشته باشند. از بین همه دانشآموزان یکی را به تصادف انتخاب میکنیم. مشخص میشود که او دفترچه به همراه دارد. احتمال اینکه او مربوط به گروه تورهای فرهنگی باشد چقدر است؟

ابتدا تعریفهای اولیه را مشخص میکنیم.

- N پیشامد انتخاب فردی است که دارای دفترچه است.

- D پیشامد انتخاب فردی است که دارای دوربین است.

- C پیشامد انتخاب فردی از گروه تورهای فرهنگی است

- S پیشامد انتخاب فردی از گروه تورهای علمی است.

- احتمال انتخاب دانشآموز از گروه تور فرهنگی است (بدون آنکه به تجهیزاتش توجه داشته باشیم). براساس اطلاعات مسئله، مقدار این احتمال برابر با 0.6 است.

- احتمال انتخاب دانشآموز از گروه تور علمی است (بدون آنکه به تجهیزاتش توجه داشته باشیم). با توجه به توضیحات گفته شده این احتمال نیز برابر با 0.4 است.

- احتمال آن است که فردی که در تور فرهنگی ثبتنام کرده، دفترچه همراه داشته باشد. براساس توضیحات مسئله مشخص است که احتمال برابر با 0.5 است.

- احتمال داشتن دفترچه در بین افرادی است که در تور علمی ثبت نام کردهاند. باز هم میدانیم که این احتمال برابر با 1 است.

- احتمال این است که دانشآموز انتخابی دفترچه داشته باشد. این احتمال نیز براساس رابطه احتمال کل به صورت زیر قابل محاسبه است:

با آگاهی از این اطلاعات، احتمال پسین برای مشاهده فردی با دفترچه از گروه تورهای فرهنگی، به صورت زیر محاسبه میشود.

فرم کلی محاسبه احتمال پسین

اگر متغیر تصادفی X با چگالی احتمال (یا درستنمایی ) و نیز تابع احتمال پیشین برای پارامتر باشد، آنگاه برای محاسبه تابع احتمال پسین باید محاسبه زیر انجام شود:

پیوسته:

البته اگر فضای پارامتر گسسته باشد باید به جای انتگرال از جمع استفاده کرد:

: گسسته

نکته: اصطلاح تابع توزیع پسین و پیشین که در مورد پارامتر گفته میشود، مربوط به رابطه بین پارامتر و مشاهدات متغیر تصادفی X است. اگر در هر روز به یک تابع پسین جدید احتیاج باشد، ممکن است این رابطه را به این صورت در نظر گرفت که توزیع پسین امروز، توزیع پیشین فردا است. این مطلب در تصویر بالا به خوبی دیده میشود.

مثال ۲

فرض کنید که متغیر تصادفی X دارای تابع احتمالی طبق جدول زیر باشد. اگر دارای توزیع یکنواخت گسسته () باشد، تابع احتمال پسین به صورت زیر محاسبه میشود.

| 0.7 | 0.4 | 0.2 | |

| 0.3 | 0.6 | 0.8 |

باید توجه داشت که جدول بالا در حقیقت چگالی توام متغیرهای تصادفی X و را نشان میدهد. بنابراین باید تابع احتمال حاشیهای متغیر تصادفی X را نیز محاسبه کنیم. به این ترتیب خواهیم داشت:

در نتیجه با توجه به فرم گسسته تابع پسین خواهیم داشت:

و به همین ترتیب برای :

مثال ۳

فرض کنید و و توزیع پیشین برای نیز به صورت است که هر دو مقدار مثبت هستند. روش پیدا کردن احتمال پسین پیوسته طبق رابطه گفته شده، در ادامه خواهد آمد. میدانیم که در این مسئله تابع احتمال برای X و به صورت زیر است:

ابتدا تابع احتمال حاشیهای X را پیدا میکنیم.

در نتیجه خواهیم داشت:

نکته: به نظر میرسد که توزیع پسین پارامتر نیز به صورت در آمده است. میتوان نتیجه گرفت که اگر توزیع متغیر تصادفی X دو جملهای و توزیع پیشین نیز بتا باشد، آنگاه توزیع پسین باز هم بتا خواهد بود. در نتیجه میتوان در چنین مواقعی، توزیع پیشین بتا را میتوان مزدوج توزیع دوجملهای محسوب کرد.

اگر مطلب بالا برایتان مفید بوده است، آموزشهای زیر نیز به شما پیشنهاد میشوند:

- متغیر های تصادفی – میانگین، واریانس و انحراف معیار – به زبان ساده

- مجموعه آموزشهای آمار، احتمالات و دادهکاوی

- احتمال شرطی (Conditional Probability) — اصول و شیوه محاسبه

- مجموعه آموزشهای یادگیری ماشین و بازشناسی الگو

- آموزش آمار و احتمال مهندسی

- آزمایش تصادفی، پیشامد و تابع احتمال

- قضیه بیز در احتمال شرطی و کاربردهای آن

- تابع درستنمایی (Likelihood Function) و کاربردهای آن — به زبان ساده

^^

خیلی زیبا و دقیق مبحثی ک از دوره کارشناسی باهاش مشکل داشتم. و فهمیدم

خدا خیرت بده خدا بهت سلامتی و عزت بده دکتر

سلام امکان حل این مسئله هست؟

تاسی را میریزیم اگر فرد آمد دوباره میریزیم و اگر ۲ آمد سکه سالمی می اندازیم و اگر ۴و ۶ آمد سکه ناسالمی که احتمال شیر امدن ان دوبرابر خط است می اندازیم حال مطلوب است محاسبه تاس زوج و سکه شیر

سلام. وقت بخیر. ممنون از اموزشتون. ببخشید یک سوال داشتم، این مطالبی که در مجله فرادرس توسط دکتر ری بد نوشته شدن، آیا اموزش آنها هم در وبسایت فرادرس هست؟ در صورت موجود بودن لطفا نام دقیق دوره ها را بفرمایید تا تهیه کنیم؟

سلام دوست و همراه عزیز،

اگر در صفحه اصلی سایت فرادرس در قسمت جستجو موضوع مورد نظرتان را وارد کنید آموزش های متعددی را دریافت خواهید کرد. برای مثال آموزشهای مرتبط با آمار و احتمال در این لینک قرار دارند

از اینکه همراه مجله فرادرس هستید، سپاسگزاریم.

فكر ميكنم در جايگذاري اعداد مثال اول اشتباهي وجود داره Pn=0.5*0.6+0.4*1=0.7

با سلام و تشکر از شما بابت توجه به مقالات فرادرس

طبق راهنمایی شما جایگذاری ها اصلاح شده است. باز هم از اینکه همراه فرادرس هستید متشکریم