تحلیل کلان داده (Big Data)، چالش ها و فناوری های مرتبط — راهنما به زبان ساده

در قسمت اول از مجموعه مطالب «کلان داده» (Big Data)، در مطلبی با عنوان «مفاهیم کلان داده (Big Data) و انواع تحلیل داده — راهنمای جامع»، تعاریف و ۴۲ «V» کلان داده و همچنین انواع روشهای تحلیل داده مورد بررسی قرار گرفتند. در این بخش به چالشهای این حوزه و فناوریهای مرتبط با آن از جمله «رایانش ابری» (Cloud Computing)، «رایانش کوانتومی» ( Quantum Computing) و «رایانش الهام گرفته از زیست» (Bio Inspired Computing) پرداخته خواهد شد. لازم به ذکر است، همانطور که در بخش پیشین نیز تاکید شده کلانداده ترجمه متداول و پرکاربرد عبارت Big Data محسوب میشود، در حالیکه معادل فارسی برگزیده شده توسط فرهنگستان زبان و ادب پارسی «مِهداده» است. در این متن از هر دو معادل استفاده خواهد شد.

در سالهای اخیر حجم کلانی از دادهها در زمینههای گوناگون از جمله بهداشت و درمان، مدیریت عمومی، خردهفروشی، بیوشیمی و دیگر زمینههای علمی و پژوهشی میانرشتهای انباره شده است. نرمافزارهای کاربردی مبتنی بر وب مانند برنامههای «محاسبات اجتماعی» (Social Computing)، اسناد و متون اینترنتی و اندیسگذاری جستوجوهای وب دائما با کلان داده مواجه هستند.

محاسبات اجتماعی شامل «تحلیل شبکههای اجتماعی» (Social Network Analysis | SNA)، «اجتماعات آنلاین» (Online Communities)، «سیستمهای توصیهگر» (Recommender system)، «سیستمهای شهرت» (Reputation Systems)، «بازارهای پیشبینی» (Prediction Markets) و نمایهسازی جستوجوهای وب شامل ISI ،IEEE Xplorer ،Scopus ،Thomson و Reuters میشود. با در نظر گرفتن مزایای کلانداده (مِهداده)، باید گفت که این مبحث فرصتهای جدیدی را در وظایف پردازش دانش برای پژوهشگران فراهم کرده و میکند. اگرچه این فرصتها اغلب چالشهایی را نیز به همراه دارند.

برای مدیریت این چالشها نیاز به دانستن پیچیدگیهای محاسباتی، امنیت اطلاعات و روشهای محاسباتی برای تحلیل کلانداده است. برای مثال، بسیاری از روشهای آماری که عملکرد خوبی برای انواع مجموعه دادههای کوچک دارند برای حجم دادههای زیاد مقیاسپذیر نیستند. به طور مشابه، بسیاری از روشهای محاسباتی که عملکرد خوبی برای دادههای کم دارند با چالشهای قابل توجهی در تحلیل کلانداده (مِهداده) مواجه میشوند. در ادامه، چالشهای کلان داده در چهار گروه «ذخیرهسازی و تحلیل داده» (data storage and analysis)، کشف دانش و پیچدگی محاسباتی، «مقیاسپذیری و بصریسازی دادهها» (scalability and visualization of data) و «امنیت اطلاعات» (information security) دستهبندی شدهاند. کلیه این موارد در ادامه مورد بررسی قرار میگیرند.

ذخیرهسازی و تحلیل داده

در سالهای اخیر حجم دادهها به وسیله ابزارهای گوناگون -تولید داده - مانند دستگاههای موبایل، فناوریهای حسگرها، «سنجش از راه دور» (remote sensing) و «سامانههای بازشناسی با امواج رادیویی» (radio frequency identification readers) به صورت نمایی رشد کرده است.

این دادهها با صرف هزینه بسیار زیاد ذخیره میشوند در حالیکه در نهایت حذف شده یا نادیده گرفته میشوند زیرا فضای کافی برای ذخیرهسازی آنها وجود ندارد. بنابراین، اولین چالش برای تحلیلهای کلانداده (مِهداده) رسانههای ذخیرهسازی با سرعت ورودی/خروجی بالا هستند. در این شرایط، دسترسیپذیری داده باید در اولویت اصلی برای کشف و ارائه دانش باشد.

دلیل این امر آن است که این دادهها برای تحلیلهای آتی باید به سادگی و به صورت بلادرنگ قابل دسترسی باشند. در دهههای گذشته، تحلیلگران از درایوهای دیسک سخت برای ذخیرهسازی دادهها استفاده میکردند، اما این دستگاهها کارایی ورودی/خروجی تصادفی را نسبت به ورودی/خروجیهای متوالی کندتر میکنند. برای غلبه بر این محدودیت، مفاهیم «درایو حالت جامد» (Solid State Drive | SSD) و حافظه تغییر فاز (Phase-Change Memory | PCM) معرفی شدند. اگرچه فناوریهای ذخیرهسازی موجود دارای کارایی لازم برای پردازش کلانداده نیستند.

دیگر چالش تحلیلهای کلانداده (تحلیلهای مِهداده)، مربوط به تنوع دادهها است. با رشد سریع مجموعه دادهها، وظایف دادهکاوی به طور قابل توجهی رشد کردند. علاوه بر این، کاهش داده، انتخاب داده و انتخاب ویژگی از جمله وظایف اساسی به ویژه هنگام کار با مجموعه دادههای بزرگ هستند. این مساله از چالش بیسابقهای برای پژوهشگران پردهبرداری میکند. زیرا، الگوریتمهای موجود ممکن است در زمان مناسب (زمان واقعی) هنگام کار با این دادههای ابعاد بالا پاسخگو نباشد.

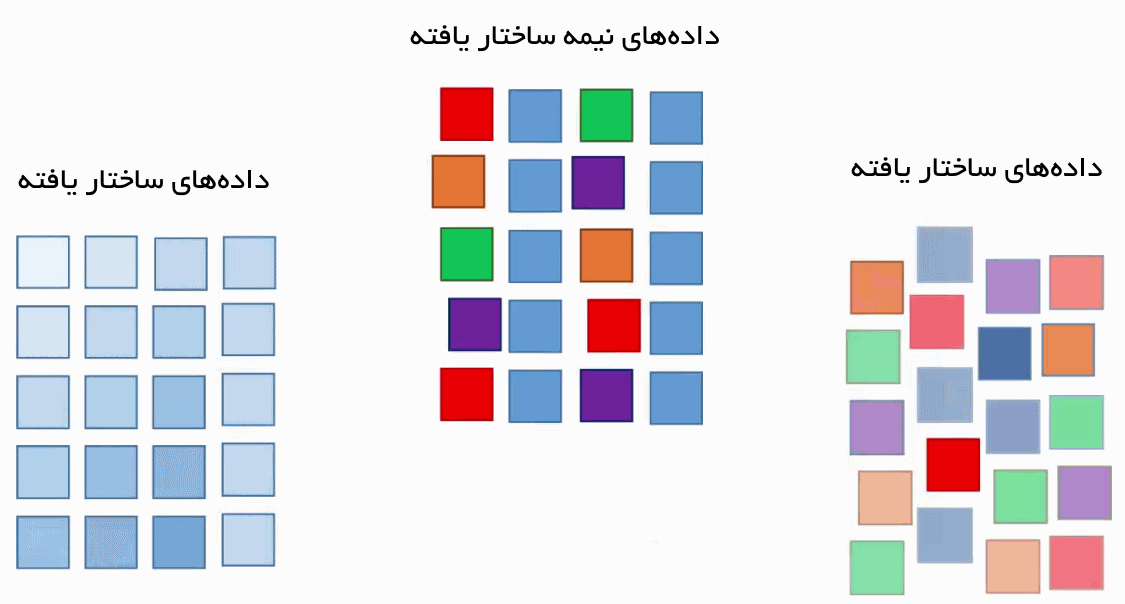

از همین رو، خودکارسازی فرآیند تحلیل و توسعه الگوریتمهای یادگیری ماشین جدید برای حصول اطمینان از استحکام آنها یک چالش اساسی محسوب میشود. علاوه بر همه اینها، خوشهبندی مجموعه دادههای بزرگ که به تحلیل کلانداده (مِهداده) کمک میکند یکی از نگرانیهای اصلی این حوزه است (منظور از خوشهبندی آنچه در دادهکاوی مورد استفاده قرار میگیرد و نوعی یادگیری نظارت نشده محسوب میشود نیست. بلکه، تقسیمبندی دادهها به بخشهایی به منظور انجام پردازشها به طور سریعتر و بهینهتر است). فناوریهای اخیر مانند «هادوپ» (hadoop) و «نگاشت کاهش» (mapReduce) امکان گردآوری حجم زیادی از دادههای «نیمه ساختاریافته» (semi structured) و «ساختار نیافته» (unstructured) را در مدت زمان معقولی فراهم میکنند.

چالش کلیدی در این زمینه، چگونگی تحلیل این دادهها برای کسب دانش است. یک فرآیند استاندارد برای این کار تبدیل دادههای نیمهساختار یافته و ساختارنیافته به دادههای ساختاریافته و سپس اعمال الگوریتمهای دادهکاوی برای استخراج دانش است. یک چارچوب برای تحلیل چنین دادههایی توسط «داس» (Das) و «کومار» (Kumar) در مقالهای با عنوان «تحلیلهای کلانداده: چارچوبی برای تحلیل دادههای ساختار نیافته» (Big data analytics: A framework for unstructured data analysis) ارائه شده است.

همچنین، جزئیات تحلیل داده برای توییتهای عمومی در مقالهای با عنوان «عقیدهکاوی درباره یک محصول با تحلیل توییتهای عمومی در توییتر» (Opinion mining about a product by analyzing public tweets in twitter) توسط «داس» و همکاران تشریح شده است. چالش اساسی در این شرایط توجه کردن به طراحی سیستمهای ذخیرهسازی و افزایش ابزارهای تحلیل داده موثر هنگام آمدن دادهها از منابع داده گوناگون جهت تضمین افزایش دقت خروجیها است. علاوه بر این، طراحی الگوریتمهای یادگیری ماشین برای تحلیل داده به منظور بهبود بهرهوری و مقیاسپذیری امری حیاتی است.

کشف دانش و پیچیدگی محاسباتی

کشف و ارائه دانش از جمله مسائل اساسی در بحث کلانداده (مِهداده) هستند. این مسائل تعدادی زیر مجموعه مانند احراز هویت، آرشیو کردن، مدیریت، حفاظت، بازیابی و ارائه اطلاعات دارد. ابزارهای گوناگونی برای کشف و ارائه دانش مانند «مجموعههای فازی» (fuzzy set)، «مجموعههای خام» (rough set)، «مجموعههای نرم» (soft set)، «مجموعه نزدیک» (near set)، «تحلیل مفهوم رسمی» (formal concept analysis)، «تحلیل مولفه اساسی» (principal component analysis) و دیگر موارد وجود دارد.

همچنین، روشهای ترکیبی برای پردازش مسائل جهان واقعی ساخته و توسعه داده شدهاند. همه این روشها مبتنی بر مساله هستند. برخی از آنها ممکن است برای مجموعه دادههای بزرگ در «کامپیوتر ترتیبی» (sequential computer) مناسب نباشد. ضمنا، برخی از نیز دارای مشخصههای خوبی از مقیاسپذیری در کامپیوترهای موازی هستند. از آنجا که اندازه کلانداده همچنان به صورت نمایی در حال رشد است، ابزارهای موجود ممکن است برای پردازش این دادهها به منظور کسب اطلاعات معنادار کارآمد نباشند. مشهورترین رویکرد جهت مدیریت مجموعه دادههای بزرگ «انبارهای داده» (data warehouses) و «دادهگاهها» (data marts) هستند. انبار داده عمدتا مسئول ذخیرهسازی دادههایی است که از سیستمهای عملیاتی نشات گرفتهاند، در حالیکه دادهگاهها بر مبنای انبارهای داده و تسهیل تحلیلها هستند.

تحلیل مجموعه دادههای بزرگ نیازمند پیچیدگی محاسباتی بیشتری است. مساله اساسی مدیریت دادههای ناسازگار و عدم قطعیت ظاهر شده در مجموعه دادهها است. به طور کلی، در مدلسازی اصولی مساله پیچیدگی محاسباتی مورد بررسی قرار میگیرد. ایجاد یک سیستم ریاضیاتی که به طور جامع برای کلانداده (مِهداده) قابل اجرا باشد کاری دشوار است. اما تحلیلهای مبتنی بر دامنه به سادگی با درک پیچیدگیهای خاص قابل انجام هستند. مجموعهای از چنین توسعههایی میتواند تحلیلهای کلانداده (مِهداده) را برای حوزههای گوناگون امکانپذیر کند.

پژوهشها و بررسیهای زیادی در این راستا با استفاده از روشهای «یادگیری ماشین» (Machine Learning) و با بهرهگیری از حداقل حافظه مورد نیاز انجام شده است. هدف اصلی در این پژوهشها حداقل کردن هزینه و پیچیدگی محاسباتی است. ابزارهای تحلیل کلانداده (تحلیل مِهداده) کنونی دارای کارایی ضعیف در مدیریت پیچیدگیهای محاسباتی، عدم قطعیت و ناسازگاریها هستند. این امر منجر به ایجاد چالشهای بزرگتری برای توسعه روشها و فناوریهایی میشود که بتوانند با پیچیدگی محاسباتی، عدم قطعیت و ناسازگاری به شیوه موثر مواجه شوند.

مقیاسپذیری و بصریسازی دادهها

یکی از مهمترین چالشهای مرتبط با روشهای تحلیل کلانداده، مقیاسپذیری و امنیت آنها است. در دهههای گذشته پژوهشگران توجه زیادی را به شتابدهی تحلیلهای داده معطوف کردند و این امر منجر به افزایش سرعت پردازندهها مطابق با «قانون مور» (Moore’s Law) شده است.

همچنین، توسعه روشهای نمونهبرداری، تحلیل آنلاین و روشهای تحلیل چندراهکاری به منظور سرعت بخشیدن به تحلیل دادهها لازم است. روشهای افزایشی دارای خصوصیت مقیاسپذیری خوبی در تحلیلهای کلانداده هستند.

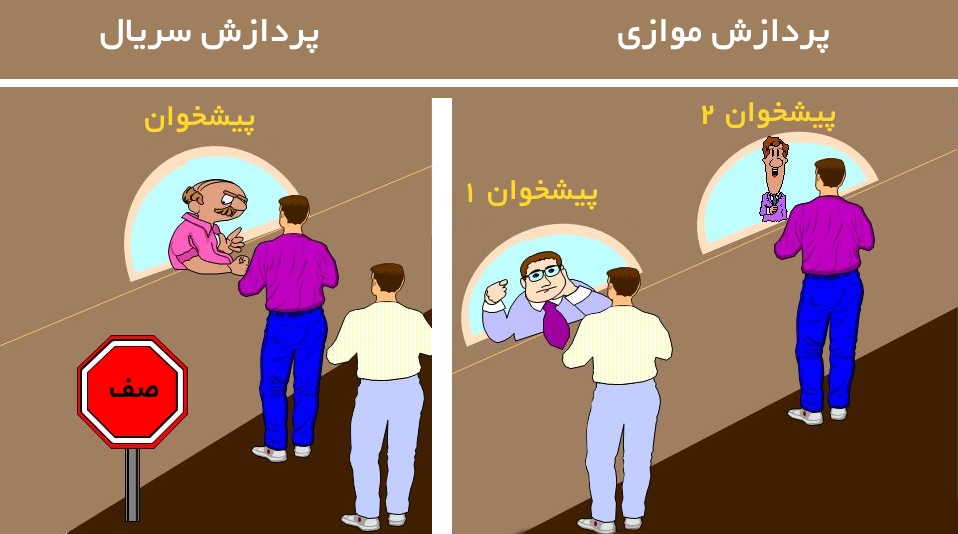

از آنجا که اندازه داده بسیار سریعتر از سرعت پردازندهها (CPU) توسعه میپذیرد، تغییر چشمگیری در فناوری پردازندههایی که دارای تعداد زیادی هسته توکار هستند وجود دارد. این تغییر در پردازندها منجر به توسعه «پردازش موازی» (parallel computing) شده است. تحلیلهای کاربردی زمان واقعی مانند شبکههای اجتماعی، امور مالی و جستوجوهای اینترنتی از جمله موارد نیازمند پردازش موازی هستند.

هدف از «بصریسازی دادهها» (Data Visualization)، ارائه آنها به طور مناسب با استفاده از نمودارهای آماری، «نظریه گراف» (graph theory) و گرافیک است. بصریسازی گرافیکی پیوندی میان داده و تفسیر مناسب آن برقرار میکند. برای مثال فروشگاههای آنلاینی مانند flipkart، آمازون و e-bay دارای میلیونها کاربر و میلیاردها محصول برای فروش در هر ماه هستند. این مساله منجر به تولید حجم زیادی از دادهها توسط این شرکتها میشود.

نحوه ارائه این دادهها و نتایج حاصل از آنها از جمله چالشهایی است که این مراکز با آن مواجه هستند. از این رو، برخی از شرکتها از ابزارهای بصریسازی داده شرکت نرمافزاری «تابلو» (Tableau) استفاده میکنند. این نرمافزارها توانایی تبدیل دادههای بزرگ و پیچیده به تصاویر بصری را دارند و به کارکنان سازمان (به ویژه تصمیمسازان و مدیران) در راستای بصریسازی جستوجوهای مرتبط، نظارت بر آخرین بازخوردهای مشتریان و تحلیل عواطف آنها کمک میکنند. اگرچه، ابزارهای تحلیل داده کنونی معمولا ضعفهای قابل توجهی در بحث مقیاسپذیری، زمان پاسخ و ویژگیها دارند.

براساس آنچه بیان شد مشهود است که کلانداده (مِهداده) چالشهای زیادی را برای توسعه سختافزارها و نرمافزارها ایجاد کرده و این امر منجر به ایجاد «پردازش موازی» (parallel computing)، «رایانش ابری» (cloud computing)، «رایانش توزیع شده» (distributed computing)، فرآیندهای بصریسازی و مقیاسپذیری شده است.

امنیت اطلاعات

در تحلیلهای کلانداده (تحلیل مِهداده)، حجم عظیمی از دادهها دارای همبستگی هستند و برای کشف الگوهای معنادار تحلیل و کاوش میشوند. اغلب سازمانها دارای سیاستهای گوناگونی برای حفاظت از امنیت اطلاعات حساس خود هستند.

حفاظت از اطلاعات حساس مساله مهمی در تحلیلهای کلانداده است زیرا ریسکهای امنیتی بسیار زیادی برای کلانداده وجود دارد. بنابراین، امنیت اطلاعات یک مشکل برای تحلیلهای کلانداده محسوب میشود. امنیت کلانداده با استفاده از روشهای «احراز هویت» (Authentication)، «کسب اجازه» (authorization) و «رمزنگاری» (encryption) قابل ارتقا است.

سنجههای امنیتی گوناگونی که نرمافزارهای کلانداده با آنها مواجه هستند مقیاسپذیری شبکه، تنوع دستگاهها، نظارت بر امنیت زمان واقعی و فقدان «سیستمهای تشخیص نفوذ» (Intrusion Detection System | IDS) مناسب و کارآمد است. چالشهای امنیتی موجب شدهاند تا «کلانداده» توجه پژوهشگران امنیت اطلاعات بسیاری را به خود جلب کند. این توجهات معطوف به ساخت مدلهای سیاست امنیتی و سیستمهای حفاظتی چند سطحی شده است. با وجود اینکه پژوهشهای زیادی در حوزه امنیت کلانداده (مِهداده) انجام شده، اما این حوزه همچنان نیازمند بهبودهای بیشتری است. چالش اساسی در این راستا توسعه یک مدل امنیت داده و حفظ حریم خصوصی چند سطحی برای کلان داده است.

فناوریهای مرتبط با کلانداده

تحلیلهای کلانداده و علم داده به کانون پژوهشهای صنعت و دانشگاه مبدل شدهاند. هدف علم داده پژوهش در کلانداده و استخراج دانش از آن است. کاربردهای کلانداده و علم داده شامل علم اطلاعات، مدلسازی عدم قطعیت، تحلیل دادههای غیر قطعی، یادگیری ماشین، یادگیری آماری، تشخیص الگو، انبارسازی داده و پردازش سیگنال میشود.

یکپارچهسازی موثر فناوریها و تحلیلها امکان پیشبینی حوادث در حال وقوع آتی را فراهم میکند. تمرکز اصلی مطالبی که در ادامه میآید فناوریهای مرتبط و موضوعات نیازمند پژوهش در حوزه کلانداده است.

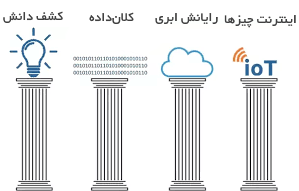

در این مطلب، مباحث مورد بررسی در چهار دسته گسترده «اینترنت چیزها» (Internet of Things | IoT)، رایانش ابری، «محاسبات الهام گرفته از زیست» (bio inspired computing) و «رایانش کوانتومی» (quantum computing) قرار داده شدهاند. اگرچه در حقیقت این موضوعات محدود به این چهار دسته نیستند و بسیار گستردهتر محسوب میشوند. از دیگر زمینههای پژوهشی مرتبط میتوان به کلاندادههای حوزه سلامت اشاره کرد که «کو» (Kuo) و همکاران در مقالهای با عنوان «تحلیلهای کلانداده سلامت: چشمانداز کنونی، چالشها و راهکارهای بالقوه» (Health big data analytics: current perspectives, challenges and potential solutions) به آن پرداختهاند.

اینترنت چیزها (IoT) برای تحلیلهای کلانداده

اینترنت، ارتباطات جهانی، کسبوکار، انقلابهای فرهنگی و تعداد قابل توجهی از خصوصیات فردی انسانها را شکل و ساختاری مجدد بخشیده است. در حال حاضر، فعالات حوزه «فناوری اطلاعات» (Information Technology) در تلاش برای کنترل تعداد بیشماری گجت خودکار در اینترنت و ساخت اینترنت چیزها (IoT) هستند.

به وسیله اینترنت چیزها (برخی به آن اینترنت اشیا نیز میگویند، ولی اینترنت اشیا معادل کلیتری است که بهتر به گستردگی این مبحث اشاره میکند)، دستگاهها درست مانند انسانها به کاربران اینترنت مبدل میشوند. اینترنت چیزها به دلیل داشتن فرصتها و چالشهای بیشمار توجه پژوهشگران و شرکتهای حوزه IT را در سالهای اخیر به خود جلب کرده است. میتوان به جرات گفت که اینترنت چیزها دارای ضرورت اقتصادی و اجتماعی به منظور انجام ساخت و سازهای آینده در حوزه فناوری اطلاعات، شبکه و ارتباطات است.

در آینده پیش رو در نهایت همه چیزها به هم متصل و به صورت هوشمندی کنترل خواهند شد. مفهوم اینترنت چیزها با تولید دستگاههای موبایل، فناوریهای ارتباطتی توکار و در همه جا حاضر، رایانش ابری و تحلیلهای داده، بیش از پیش به واقعیت نزدیک شده. اگرچه، این حوزه نیز دارای چالشهایی در زمینه حجم، سرعت و تنوع دادهها است. در یک معنای وسیعتر، اینترنت چیزها نیز درست مانند اینترنت، دستگاهها را قادر به حضور در محلهای بیشماری کرده و کاربردهای گوناگون را از موارد بدیهی گرفته تا حیاتی تسهیل میکند.

با این وجود هنوز هم درک عمیقی از اینترنت چیزها وجود ندارد و این امر موجب شده تا تمایز آن با دیگر مفاهیم مشابه به صورت رمز و رازی باقی بماند. برخی فناوریها مانند هوش محاسباتی و کلانداده میتوانند به منظور بهبود مدیریت داده و کشف دانش در مقیاس وسیعی از نرمافزارهای خودکارسازی مورد استفاده قرار بگیرند. پژوهشهای بیشتر در این حوزه توسط «میشرا» (Mishra) و همکاران در مقالهای با عنوان «یک چارچوب شناختی برای چشمانداز مدیریت کلانداده و کشف دانش اینترنت چیزها» (A cognitive adopted framework for IoT big data management and knowledge discovery prospective) انجام شده است.

کسب دانش از دادههای اینترنت اشیا بزرگترین چالشی است که متخصصان کلانداده با آن مواجه هستند. بنابراین، توسعه زیرساختها جهت تحلیل دادههای IoT امری حیاتی است. یک دستگاه IoT جریانهای مداومی از داده را تولید میکند و پژوهشگران میتوانند ابزارهایی به منظور استخراج اطلاعات معنادار از این دادهها با استفاده از روشهای یادگیری ماشین را ساخته و توسعه دهند. درک این جریانهای داده تولید شده از دستگاههای IoT و تحلیل آنها برای دریافت اطلاعات معنادار مسالهای چالش برانگیز است و منجر به تحلیلهای کلانداده میشود.

الگوریتمهای یادگیری ماشین و روشهای هوش محاسباتی تنها راهکارهای موجود برای مدیریت کلانداده از چشمانداز اینترنت چیزها هستند. فناوریهای مرتبط با اینترنت اشیا نیز در مقالات پژوهشی گوناگونی مورد بررسی قرار گرفتهاند که از این جمله میتوان به مقاله نوشته شده توسط «چن» (Chen) و «جین» (Jin) با عنوان «پژوهشی در فناوری کلیدی و کاربردهای اینترنت چیزها» (Research on key technology and applications for internet of things) اشاره کرد. شکل 10 چشماندازی از کلانداده، اینترنت اشیا و فرآیند کشف دانش ارائه میکند.

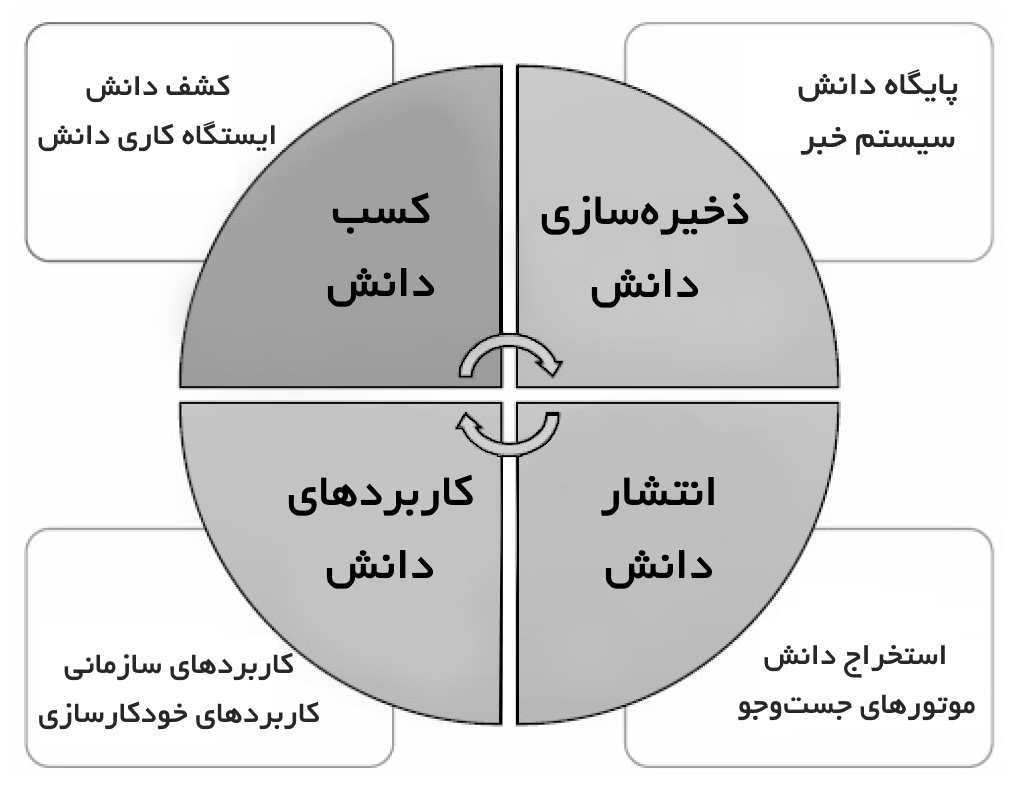

سیستمهای کشف دانش از نظریه پردازش اطلاعات انسانی مانند چارچوبها، قوانین، تگگذاری و شبکههای معنایی نشات گرفتهاند و به طور کلی، دارای چهار بخش از جمله «کسب دانش» (knowledge acquisition)، «پایگاه دانش» (knowledge base)، «نشر دانش» (knowledge dissemination) و «کاربرد دانش» (knowledge application) هستند. در فاز کسب دانش، دانش با بهرهگیری از روشهای سنتی و هوشمند محاسباتی اکتشاف میشود.

دانش کشف شده در پایگاههای دانش ذخیره میشود و بر اساس آن «سیستمهای خبره» (expert systems) طراحی و ساخته میشوند. نشر دانش به منظور حصول اطلاعات معنادار از پایگاه دانش مساله حائز اهمیتی است. استخراج دانش فرآیندی است که به جستوجوی دانش موجود در اسناد میپردازد. فاز آخر، اعمال دانش کشف شده در کاربردهای گوناگون است که در واقع هدف نهایی کشف دانش محسوب میشود. مسائل، بحثها و پژوهشهای زیادی در حوزه اکتشاف دانش وجود دارد که فراتر از بحث این مقاله هستند. به منظور درک بهتر مساله، طرحی از سیستم اکتشاف دانش در شکل زیر نمایش داده شده است.

توسعه «فناوریهای مجازیسازی» (virtualization technologies)، انجام «ابَررایانش» (supercomputing) را دسترسیپذیرتر و مقرون به صرفهتر کرده است. زیرساختهای رایانشی که در نرمافزارهای مجازیسازی پنهان هستند موجب میشوند این سیستمها همچون یک کامپیوتر واقعی اما همراه با انعطاف در مشخصهسازی جزئیاتی مانند تعداد پردازندهها، فضای دیسک، حافظه و سیستمعامل عمل کنند. استفاده از این کامپیوترهای مجازی که با عنوان رایانش ابری شناخته میشود یکی از مستحکمترین راهکارهای کلانداده است. فناوریهای کلانداده و رایانش ابری با توجه به اهمیت ساخت منابع داده مقیاسپذیر و دسترسیپذیر بر مبنای نیاز توسعه پیدا میکنند. رایانش ابری حجم عظیمی از دادهها را با دسترسی مبتنی بر تقاضا به منظور پیکربندی منابع کامپیوتری از طریق روشهای مجازیسازی هماهنگ میکند.

مزایای به کارگیری رایانش ابری شامل ارائه منابع هنگامی که تقاضا وجود دارد و پرداختن به منابعی که برای ساخت و توسعه محصول مورد نیاز هستند میشود. در عین حال، این امر دسترسیپذیری را بهبود بخشیده و هزینهها را کاهش میدهد. چالشهای باقی و موضوعات نیازمند پژوهش این حوزه توسط پژوهشگران زیادی به تفصیل مورد بررسی قرار گرفتهاند که از آن جمله میتوان به موضوعات مرتبط با مدیریت داده، تنوع و سرعت داده، ذخیرهسازی داده، پردازش داده و مدیریت منابع اشاره کرد. بنابراین، رایانش ابری به توسعه یک مدل کسبوکار برای انواع کاربردها با زیرساخت و ابزار کمک میکند.

نرمافزارهای ویژه کلانداده با استفاده از رایانش ابری از تحلیل و توسعه داده پشتیبانی میکنند. محیط ابر با ابزارهایی را فراهم کند که به دانشمندان داده و تحلیلگران کسبوکار امکان اکتشاف دادهها را به طور تعاملی و به منظور استخراج نتایج ثمربخش و کسب دانش فراهم کند. این امر میتواند به حل برنامههای عظیمی که در دامنههای گوناگون ظهور پیدا میکنند کمک کند. علاوه بر این، رایانش ابری باید امکان مقیاسپذیری ابزارها از فناوریهای مجازی را به فناوریهای جدیدی مانند «اسپارک» (spark)، زبان برنامهنویسی R و دیگر انواع روشهای پردازش کلانداده فراهم کند.

رایانش ابری مزایای گوناگونی را برای تحلیل کلانداده در بر دارد. کاربر میتواند متناسب با نیاز خود چارچوب رایانش ابری لازم را تعیین و بر اساس آن سرویسهای زیرساخت را از تامینکنندگان زیرساختهای ابری مانند گوگل و IBM و همچنین «نرمافزار به عنوان سرویس» (Software as a Service | SaaS) از گستره وسیعی از شرکتها مانند «NetSuite» ،«Cloud9» ،«Jobscience» و دیگر موارد تهیه کند. دیگر مزیت رایانش ابری، «ذخیرهسازی ابری» (Cloud Storage) است که راهکاری برای ذخیرهسازی کلانداده فراهم میکند. در غیاب قابلیت ذخیرهسازی ابری، کنترل توزیع محاسبات و سختافزار پایه دشوار خواهد بود. اما در بحث میزبانی و ذخیرهسازی دادهها روی سرورهای عمومی نگرانی اصلی افراد «حریم خصوصی» است که نیاز به انجام پژوهشهایی جهت حل آن وجود دارد .

رایانش الهام گرفته از زیست برای تحلیلهای کلان داده

رایانش الهام گرفته از زیست روشی است که در آن از طبیعت برای پرداختن به مسائل پیچیده جهان واقعی الهام گرفته شده است. سیستمهای زیستی بدون یک کنترل مرکزی، خود سازماندهی شده هستند. یک مکانیزم کاهش هزینه الهام گرفته از طبیعت، با انجام جستوجو راهکار سرویس داده بهینه را با در نظر گرفتن هزینههای مدیریت داده و نگهداری سرویس پیدا میکند.

این روشها به وسیله ملکولهای زیستی مانند DNA و پروتئینها به منظور هدایت و انجام محاسبات رایانشی شامل ذخیرهسازی، بازیابی و پردازش داده توسعه داده میشوند.

یک ویژگی قابل توجه از چنین رایانشی آن است که موارد مشتق شده از زیست را برای اجرای توابع محاسباتی و دریافت کارایی هوشمند یکپارچه میکنند. این سیستمها برای کاربردهای کلانداده مناسبتر هستند. زیرا، حجم عظیمی از دادهها از منابع متنوع در سرتاسر وب از هنگام ظهور دیجیتالسازی تاکنون تولید شدهاند. تحلیل این دادهها و دستهبندی آنها به متن، عکس، ویدئو و سایر موارد نیازمند تحلیلهای هوشمند زیادی از دانشمندان داده و کارشناسان کلانداده است.

روشهای محاسباتی الهام گرفته از زیست نقش کلیدی را در تحلیلهای داده هوشمند و کاربردهای آن برای کلانداده (مِهداده) دارند. این الگوریتمها به انجام دادهکاوی در مجموعه دادههای بزرگ به منظور بهینهسازی فرآیند کاوش کمک میکنند. مهمترین مزیت این روشها، سادگی و همگرایی سریع آنها به راهکار بهینه است.

برخی از کاربردهای رایانش الهام گرفته از زیست به طور مشروح در مقالهای از «شی» (Shi) و همکاران با عنوان «هوش ازدحامی در تحلیلهای کلان داده» (Swarm intelligence in big data analytics) بیان شده است. براساس آنچه پیشتر بیان شد میتوان مشاهده کرد که مدلهای رایانشی الهام گرفته از زیست، به تعاملات هوشمندانهتر ، ممانعت از مشکل از دست رفتن دادهها و مدیریت ابهامات کمک میکند. از این رو، باوری وجود دارد مبنی بر اینکه رایانش الهام گرفته از زیست در آینده کمکهای قابل توجهی به مدیریت کلانداده خواهد کرد.

رایانش کوانتومی برای تحلیلهای کلانداده

یک کامپیوتر کوانتومی دارای حافظهای است که به صورت نمایی بزرگتر از سایز فیزیکی آن محسوب میشود و میتواند یک مجموعه نمایی از ورودیها را به طور همزمان دستکاری کند. این بهبود نمایی در سیستمهای کامپیوتری امکانپذیر است.

اگر یک کامپیوتر کوانتومی واقعی وجود داشت، میتوانست مسائلی را حل کند که برای کامپیوترهای کنونی دشوار محسوب میشوند و البته مسائل مربوط به کلانداده (مِهداده) نیز از این دست هستند. انتظار میرود چالشهای فنی اصلی در مسیر راه ساخت کامپیوترهای کوانتومی به زودی حل شوند و بشر شاهد انقلابی در بحث محاسبات باشد. رایانش کوانتومی راهکاری برای ادغام مکانیک کوانتومی و پردازش اطلاعات فراهم میکند.

در کامپیوترهای سنتی، اطلاعات با رشته طولانی از بیتها نمایش داده میشوند، بنابراین در نهایت یا صفر یا یک هستند. از سوی دیگر، یک کامپیوتر کوانتومی از بیتها یا «کوبیتها» (qubit) استفاده میکند. تفاوت اصلی بین کوبیت و بیت آن است که سیستم کوانتومی صفر و یک را به دو حالت کوانتومی قابل تمایز رمزنگاری و از پدیدهها و قوانین مکانیک برای برهمنهی و گرفتگی بهره میبرد. این امر به آن دلیل است که کوبیتها رفتار کوانتومی دارند.

برای مثال، ۱۰۰ کوبیت در یک سیستم کوانتومی نیازمند ۲۱۰۰ مقدار برای ذخیرهسازی در سیستمهای کامپیوتری کلاسیک است. این یعنی بسیاری از مسائل کلانداده با بهرهگیری از کامپیوترهای کوانتومی بزرگ سریعتر از کامپیوترهای کلاسیک حل میشوند. از این رو، ساخت یک کامپیوتر کوانتومی و تسهیل پردازش کامپیوتری برای حل مسائل محاسباتی به چالشی جهت حل مسائل کلانداده (مِهداده) مبدل شده و نیازمند پژوهشهای بیشتر است.

اگر نوشته بالا برای شما مفید بوده، آموزشهای زیر نیز به شما پیشنهاد میشوند: