ضریب همبستگی (Correlation Coefficients) و شیوه محاسبه — به زبان ساده

در تحلیلهای چند متغیره آماری، شیوههای مختلف محاسباتی برای اندازهگیری وابستگی یا ارتباط بین دو متغیر تصادفی وجود دارد. منظور از ضریب همبستگی بین دو متغیر، قابلیت پیشبینی مقدار یکی برحسب دیگری است. برای مثال، عرضه و تقاضا دو پدیده وابسته به یکدیگر هستند. یکی از روشهای نمایش ارتباط بین دو متغیر، محاسبه «کوواریانس» (Covariance) و یا «ضرایب همبستگی» (Correlation Coefficient) بین آنها است.

هر چه مقدار این دو شاخص بزرگتر باشد، نشاندهنده ارتباط یا وابستگی بیشتر بین دو متغیر است. برای مثال میتوان وابستگی زیادی بین دو متغیر میزان مصرف برق و دمای هوا در نظر گرفت. زیرا هر چه دما افزایش یابد، استفاده از وسایل سرمایشی نیز افزایش داشته و مصرف برق را بالا میبرد. در نتیجه وابستگی زیادی بین این دو متغیر وجود دارد.

البته باید توجه داشت که کوواریانس یا همبستگی بیانگر ارتباط علت و معلولی نیستند، بلکه فقط معیاری برای نشان دادن میزان وابستگی بین دو متغیر محسوب میشوند.

به عنوان پیشزمینه این بحث احتیاج به میانگینگیری و محاسبه واریانس دارید. برای آشنایی بیشتر با این مباحث میتوانید مطالب رابطه بین میانگین حسابی، هندسی و همساز و اندازههای پراکندگی — به زبان ساده از مجله فرادرس را مطالعه کنید.

ضریب همبستگی و کوواریانس

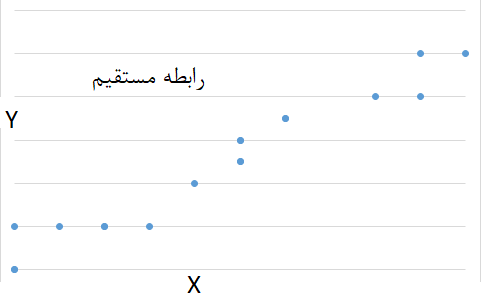

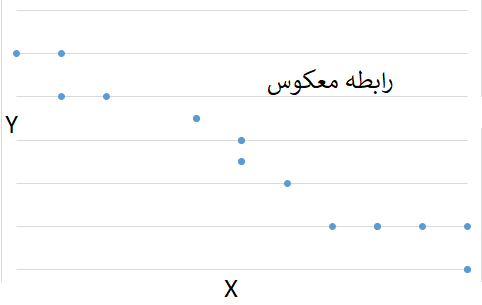

یک روش برای نشان دادن ارتباط بین دو متغیر، استفاده از «کوواریانس» (Covariance) است. این میزان جهت ارتباط بین دو متغیر را نیز نشان میدهد. به این معنی که اگر مقدار کوواریانس مثبت شود، بیانگر ارتباط مستقیم بین دو متغیر است. این گفته بدان معناست که با افزایش یکی دیگری نیز افزایش مییابد.

همچنین منفی بودن کوواریانس نشان میدهد که جهت تغییرات دو متغیر عکس یکدیگر هستند. به بیان دیگر ارتباط معکوس بین دو متغیر نشان میدهد که با افزایش یکی، دیگری کاهش مییابد.

فرض کنید X و Y دو متغیر تصادفی با امید-ریاضی و هستند. رابطه زیر نحوه محاسبه کوواریانس X و Y را که به صورت نشان میدهیم، مشخص کرده است:

خواص کوواریانس

با توجه به رابطه تعریف شده برای کوواریانس میتوان خصوصیات زیر را برایش مشخص کرد:

- تقارن: کوواریانس یک شاخص متقارن است. یعنی .

- واحد ترکیبی: واحد اندازهگیری کوواریانس، ترکیبی است. به این معنی که اگر X با واحد متر و Y با واحد کیلوگرم اندازهگیری شده باشد، واحد اندازهگیری کوواریانس به صورت متر در کیلوگرم است.

- کوواریانس بین X و X برابر با واریانس خواهد بود.

- اگر بین X و Y رابطه خطی وجود داشته باشد، یعنی داشته باشیم a+bX=Y آنگاه به این معنی که تغییر مکان دادهها در مقدار کوواریانس تاثیری نداشته و فقط تغییر مقیاس باعث میشود که کوواریانس نیز به همان مقیاس تبدیل شود.

- با توجه به مقیاس اندازهگیری دادهها، بزرگی یا کوچکی کوواریانس برای مقایسه مناسب نیست.

مثال 1

براساس مطالعه قد و وزن ۹ نوزاد و نوپا، دادههای زوجی () در جدول زیر ثبت شدهاند. کوواریانس بین قد و وزن این افراد برابر است با 10.80 کیلوگرم در سانتیمتر.

| وزن (کیلوگرم) | 3.7 | 4.4 | 5.6 | 6.4 | 7.0 | 7.5 | 8.0 | 8.3 | 8.7 |

| قد (سانتیمتر) | 49.8 | 54.9 | 58.4 | 61.5 | 64.0 | 66.0 | 67.6 | 69.0 | 70.8 |

میانگین وزنها برابر 6.6 کیلوگرم و میانگین قدها نیز برابر با 62.4 سانتیمتر است. محاسبات مورد نیاز برای بدست آوردن کوواریانس نیز در جدول زیر قرار دارد.

| تفاوت وزنها از میانگین | -2.9 | -2.2 | -1.0 | -0.2 | 0.4 | 0.9 | 1.4 | 1.7 | 2.1 |

| تفاوت قدها از میانگین | -12.6 | -7.5 | -4.0 | -0.9 | 1.6 | 3.6 | 5.2 | 6.6 | 8.4 |

| حاصلضرب وزن در قد | 36.54 | 16.5 | 4 | 0.18 | 0.64 | 3.24 | 7.28 | 11.22 | 17.64 |

| کوواریانس = میانگین حاصلضربها= | 10.8 | ||||||||

این مقدار نشان میدهد که رابطه مستقیم بین قد و وزن کودکان وجود دارد.

ماتریس کوواریانس

اگر لازم باشد ارتباط بین چندین متغیر، محاسبه و نمایش داده شود، از ماتریس کوواریانس استفاده میشود. در سطرها و ستونهای این ماتریس متغیرها قرار گرفته و مقدارهای درون ماتریس نیز، کوواریانس مربوط به متغیر سطر با ستون متناظرش را نشان میدهد. اگر X,Y,Z سه متغیر تصادفی باشند، ماتریس کوواریانس آنها به صورت زیر نمایش داده میشود.

از آنجایی کوواریانس هر متغیر با خودش برابر با واریانس آن متغیر است، گاهی به V ماتریس واریانس-کوواریانس نیز میگویند. توجه داشته باشید که ماتریس V یک ماتریس متقارن است و عناصر روی قطر اصلی همان واریانسها هستند.

محاسبه ضرایب همبستگی

همانطور که اشاره شد، کوواریانس به واحد اندازهگیری دادهها بستگی دارد. در نتیجه نمیتوان بزرگی کوواریانس دو متغیر را با بزرگی کوواریانس دو متغیر دیگر بدون در نظر گرفتن واحد اندازهگیریشان، مقایسه کرد. ضریب همبستگی که شاخصی بدون واحد است، این مشکل را حل کرده.

در قسمتهای قبل متوجه شدیم که ضریب همبستگی نیز برای اندازهگیری میزان وابستگی بین دو متغیر استفاده میشود. با توجه به نوع دادهها، شیوههای مختلفی برای اندازهگیری ضریب همبستگی وجود دارد. اغلب ضریب همبستگی، رابطه بین مقدارهای میانگین دو متغیر را نشان میدهد. ضریب همبستگی را با و یا r نشان میدهند. در این متن به بررسی و شیوه محاسبه «ضریب همبستگی پیرسون» (Pearson Correlation Coefficient) ، «ضریب همبستگی اسپیرمن» (Spearman Correlation Coefficient) و «ضریب همبستگی کندال» (Kendall Correlation Coefficient) میپردازیم.

ضریب همبستگی پیرسون

یکی از مشهورترین شیوههای اندازهگیری وابستگی بین دو متغیر کمی، محاسبه ضریب همبستگی پیرسون است. این شاخص توسط «کارل پیرسون» (Karl Pearson) آماردان انگلیسی در سال 1900 طی مقالهای معرفی شد. او از این شاخص برای بررسی علمی روی علوم زیستی و حتی جمعیتی استفاده کرد و به نتایج جالب توجهی رسید. شیوه محاسبه برای ضریب همبستگی پیرسون در ادامه دیده میشود.

فرض کنید X و Y دو متغیر تصادفی هستند که دارای امید-ریاضی و و واریانس و هستند. ضریب همبستگی بین X و Y را با یا نشان داده و به صورت زیر محاسبه میکنیم.

صورت این کسر همان کوواریانس بین دو متغیر X و Y محسوب میشود. منظور از E نیز، امید-ریاضی دو متغیر تصادفی X و Y است.

البته باید توجه داشت که ضریب همبستگی پیرسون فقط زمانی که واریانس و امید-ریاضی وجود داشته باشند، قابل محاسبه است. برای مثال دادههایی «توزیع کوشی» (Cauchy Distribution) دارای میانگین و واریانس نیستند در نتیجه ضریب همبستگی به این شکل برای آنها قابل محاسبه نیست. همچنین اگر یکی از واریانسها نیز صفر باشد (یعنی دادهها پراکندگی نداشته باشند) مقدار ضریب همبستگی نامفهوم خواهد بود.

با استفاده از نامساوی کوشی-شوارتز نیز میتوان نشان داد که قدر مطلق ضریب همبستگی هرگز بزرگتر از ۱ نخواهد بود. پس میتوان نوشت:

خصوصیات ضریب همبستگی پیرسون

با توجه به تعریفی که ضریب همبستگی پیرسون دارد میتوان خصوصیات زیر را برای آن اثبات کرد.

- بدون واحد بودن: ضریب همبستگی پیرسون به واحد اندازهگیری دادهها بستگی ندارد. یعنی شاخصی بدون واحد است. حتی گاهی آن را به صورت درصدی نیز بیان میکنند.

- تقارن ضریب همبستگی پیرسون: واضح است که ضریب همبستگی پیرسون دارای تقارن است. زیرا

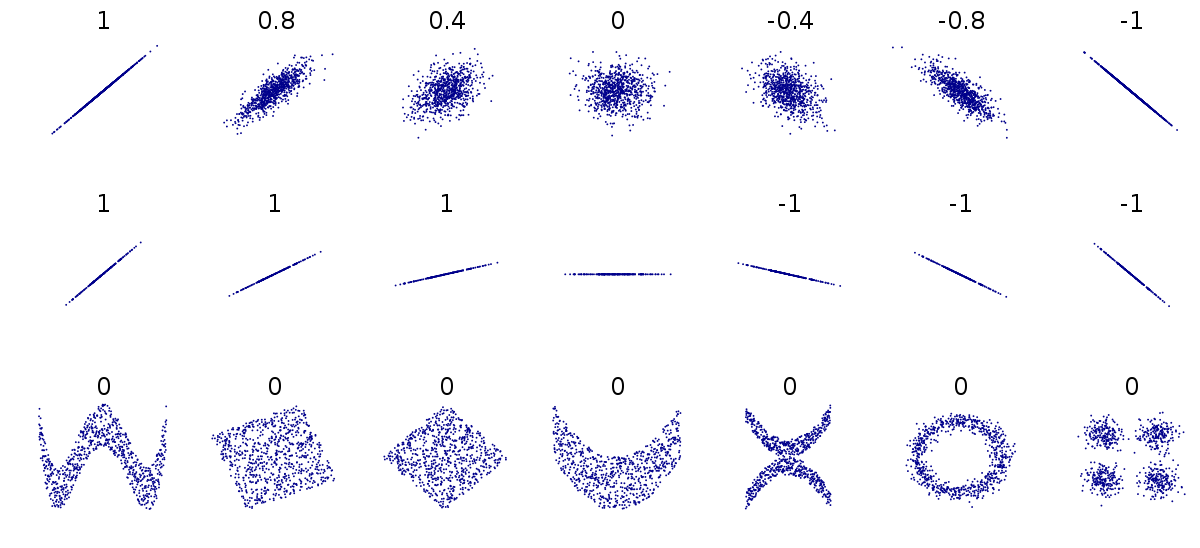

- اندازهگیری ارتباط خطی بین دو متغیر: هر چه مقدار ضریب همبستگی به ۱ یا ۱- نزدیک شود، وجود رابطه خطی بین دو متغیر بیشتر میشود. فرض کنید a+bX=Y باشد. ضریب همبستگی بین X , Y به صورت زیر قابل محاسبه است:

حال سعی میکنیم صورت کسر ضریب همبستگیرا ساده کنیم.

از طرفی نیز برای واریانس داریم:

در نتیجه برای ضریب همبستگی بین X و Y خواهیم داشت:

البته همین محاسبات را برای a-bX=Y نیز میتوان انجام داد و نتیجه گرفت که ضریب همبستگی پیرسون برای چنین رابطه خطی برابر با ۱- است.

- تعیین جهت همبستگی: چنانچه ضریب همبستگی مثبت باشد، رابطه بین دو متغیر را مستقیم و اگر منفی باشد، رابطه بین دو متغیر معکوس خواهد بود.

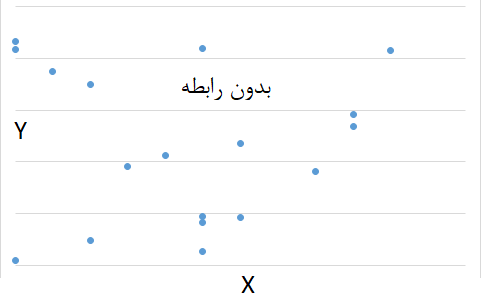

- استقلال دو متغیر: اگر دو متغیر مستقل باشند، ضریب همبستگی پیرسون برابر با صفر خواهد بود. البته عکس این موضوع صحیح نیست. یعنی ممکن است ضریب همبستگی پیرسون برای دو متغیر برابر با صفر باشد در حالیکه آن دو متغیر مستقل نیستند. در چنین حالتی اگر X یک متغیر تصادفی متقارن حول صفر باشد (یعنی ) و متغیر تصادفی y به صورت باشد، آنگاه ضریب همبستگی بین این دو برابر صفر است ولی مشخص است که Y کاملا به X وابستگی دارد. در چنین حالتی صورت مربوط به محاسبه ضریب همبستگی پیرسون به شکل زیر خواهد بود:

در نتیجه برای دو متغیر X و Y که به شدت به هم مرتبط هستند ضریب همبستگی برابر با صفر خواهد بود.

- استقلال برای دو متغیر نرمال: اگر دو متغیر X و Y دارای توزیع نرمال باشند، آنگاه صفر بودن ضریب همبستگی میتواند دلیلی برای استقلال دو متغیر تصادفی نرمال باشد.

- ضریب همبستگی نمونهای: اگر یک نمونه تصادفی به حجم n از متغیرهای تصادفی X و Y به صورت داشته باشیم، «ضریب همبستگی نمونهای پیرسون» (Pearson Sample Correlation Coefficient) به شکل زیر محاسبه میشود:

مثال ۲

براساس دادههای موجود در جدول مربوط به مثال ۱ ضریب همبستگی پیرسون به صورت زیر قابل محاسبه است. این اطلاعات در جدول محاسبه شدهاند.

| 59.1 | 14.8 | 875.08 | 3818.9 | 562.0 | 56.6 | 3818.9 |

| محاسبه ضریب همبستگی | ||||||

ضریب همبستگی رتبهای اسپیرمن

با توجه به اینکه ضریب همبستگی پیرسون براساس میانگین و واریانس محاسبه میشود، ممکن است در مقابل دادههای دورافتاده، منحرف شده و میزان همبستگی را به درستی نشان ندهد. در چنین مواقعی از ضریب همبستگی رتبهای اسپیرمن استفاده میشود. همبستگی رتبهای اسپیرمن به مانند ضریب پیرسون، نشان میدهد تمایل یک متغیر به پیروی کردن از مقدارهای متغیر دیگر چقدر است.

این شاخص همبستگی توسط «چارلز اسپیرمن» (Charles Spearman) دانشمند روانشناس انگلیسی در سال 1904 معرفی شد. او با استفاده از این ضریب همبستگی توانست تئوریهایش در زمینه شناخت و هوش را توسعه دهد.

در این ضریب همبستگی به جای محاسبه روی مقدارها، از رتبهها استفاده میشود. به همین دلیل به آن ضریب همبستگی رتبهای میگویند. بنابراین اگر رتبههای مربوط به مقدارهای و رتبههای مربوط به مقدارهای باشد ضریب همبستگی رتبهای اسپیرمن که به صورت نشان داده میشود طبق رابطه زیر قابل محاسبه است:

مشخص است که در ضریب همبستگی رتبهای اسپیرمن، اساس رتبهها هستند، نه خود مقدارها. همچنین ضریب همبستگی اسپیرمن شدت رابطه خطی را اندازهگیری نمیکند. به این معنی که ممکن است ضریب همبستگی رتبهای اسپیرمن برابر ۱ باشد در حالی که رابطه خطی بین دو متغیر وجود نداشته باشد.

مثال ۳

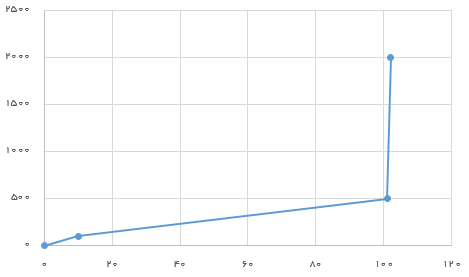

برای دادههای زوجی مقدار ضریب همبستگی اسپیرمن برابر است با ۱ در حالیکه نمودار ترسیمی، رابطه خطی را نشان نمیدهد و ضریب همبستگی پیرسن برابر است با 0.754.

ضریب هماهنگی کندال

ضریب هماهنگی کندال نیز مانند ضریب همبستگی اسپیرمن، به جای مقدار از ترتیب مقدارها برای اندازهگیری میزان وابستگی استفاده میکند. این شاخص توسط «موریس کندال» (Maurice Kendall) دانشمند انگلیسی علم آمار در سال 1938 معرفی شد. او بوسیله این شاخص، میزان همخوانی رتبهها را اندازهگیری کرد.

فرض کنید زوجهای مشاهدات متغیرهای X و Y را تشکیل میدهند. زوج و را «هماهنگ» (Concordant) میگویند اگر داشته باشیم . به بیان دیگر اگر دادههای این زوجها را براساس مولفه اول یا دوم مرتب کنیم، دارای رتبههای یکسانی خواهند بود. در حالت عکس این زوجها را «ناهماهنگ» (Discordant) مینامند.

حال براساس تعریف هماهنگ و ناهماهنگ برای زوجها، اگر تعداد زوجهای هماهنگ را با و تعداد زوجهای ناهماهنگ را نیز با نشان دهیم، ضریب هماهنگی کندال به صورت زیر محاسبه میشود:

خصوصیات ضریب هماهنگی کندال

- از آنجایی که مخرج این کسر تعداد انتخابهای زوجها از بین n مشاهده است، همیشه از صورت بزرگتر است. پس ضریب همبستگی کندال از ۱ کوچکتر و از ۱- بزرگتر است.

- اگر همه زوجها با هم هماهنگ باشند مقدار ضریب هماهنگی کندال برابر است با ۱.

- اگر همه زوجها ناهماهنگ باشند ضریب هماهنگی کندال برابر است با ۱-.

- اگر X و Y مستقل باشند، انتظار داریم که ضریب هماهنگی کندال نیز برابر با ۰ باشد.

شکل دیگری نیز برای محاسبه ضریب هماهنگی کندال وجود دارد که از تابع علامت یا sgn استفاده میکند. منظور از علامت x است. اگر علامت x مثبت باشد، مقدار sgn برابر با ۱ و اگر منفی باشد sgn برابر با ۱- است. در حالتی که x صفر باشد، مقدار sgn صفر در نظر گرفته میشود. به این ترتیب رابطه محاسباتی برای ضریب هماهنگی کندال به صورت زیر است:

$$\large \tau =\dfrac {2}{n(n-1)}\sum _{i<j}sgn(x_{i}-x_{j})sgn(y_{i}-y_{j})$$

مثال ۴

برای دادههای مثال ۱ محاسبات مربوط به ضریب همبستگی اسپیرمن و کندال در جدول زیر آورده شده است.

| ردیف مشاهده | ۱ | ۲ | ۳ | ۴ | ۵ | ۶ | ۷ | ۸ | ۹ |

| رتبه (مولفه اول) | ۱ | ۲ | ۳ | ۴ | ۵ | ۶ | ۷ | ۸ | ۹ |

| رتبه (مولفه دوم) | ۱ | ۲ | ۳ | ۴ | ۵ | ۶ | ۷ | ۸ | ۹ |

| ضریب همبستگی اسپیرمن | 1 | هماهنگی | 36 | ناهماهنگی | 0 | ضریب همبستگی کندال | ۱ | ||

برای مثال، زوج اول یعنی نسبت به همه زوجهای دیگر هماهنگ است پس میزان هماهنگی این زوج برابر با ۸ و برای زوج دوم درجه هماهنگی ۷ و ... است. در نتیجه مجموع تعداد هماهنگیها برابر ۳۶ میشود.

وقت شما بخیر.

برای بررسی داده های آماری کلا از چه مواردی استفاده میشه؟ یعنی همبستگی پیرسون و اسپیر من، لیکرت و دیگه؟ ممکنه راهنمایی بفرمایید

بسیار عالی بود ممنون از فرادرس و مدرس محترم

سلام برای تعیین حجم نمونه ما ضریب همبستگی رو چه جوری میتونیم تعیین کنیم مطالعات قبلی دقیقا رو همین موضوع کار نکردن

سلام، من دو تا متغیر رو می خوام بررسی کنم ، انگیزش تحصیلی و هوشمند سازی ، انگیزش تحصیلی که پرسشنامه داره و داده بدست میارم اما هوشمند سازی بر اساس نظر آموزش و پرورش منطقه است که مثلا میگه این مدرسه براساس شاخص هایی که خودشون دارن هوشمند هست و اون مدرسه عادی، الان من نمی دونم چطوری باید همبستگی این دو رو در spss بررسی کنم ممنون میشم راهنمایی م کنید

سلام

من مسئله ای را متوجه نشد. اگر لطف کنید توضیح بیشتر بدین. اینکه اگر ضریب همبستگی صفر باشد؛ تنها در صورتی که دو متغیر توزیع نرمال داشته باشند مستقل از هم هستند. چه لزومی داره متغیرها توزیع نرمال داشته باشند؟ آیا منظور اینه که در صورت توزیع نرمال دیگر فرض رابطه ی غیر خطی بودن این دو دسته داده از بین میره؟

سلام و درود بر شما همیار مجله فرادرس،

بله همانطور که گفتید، در صورتی که توزیع جامعه آماری نرمال دو متغیره باشد، با شرط صفر شدن ضریب همبستگی، میتوان استقلال را نتیجه گرفت. در غیر اینصورت، صفر شدن ضریب همبستگی، دلیلی بر استقلال دو متغیر تصادفی نخواهد بود. این موضوع به علت ساختار تابع چگالی نرمال و همچنین فرم محاسبه ضریب همسبتگی پیرسون است.

توجه دارید که ضریب همبستگی پیرسون، بیانگر همبستگی یا رابطه خطی بین دو متغیر است.

برای مثال یک توزیع متقارن را در نظر بگیرید. منظور از تقارن آن است که f(x)=f(−x). از طرفی X و Y=X2 را دو متغیر در نظر بگیرید. کوواریانس برای توانهای فرد، با توجه به تقارن صفر بوده و توانهای زوج مخالف صفر هستند. E(X3)=0 و E(X)=0 پس ضریب همبستگی صفر است ولی به خوبی دیده میشود که بین این دو متغیر تصادفی، رابطه شدیدی وجود دارد. بنابراین صفر شدن ضریب همبستگی دلیلی بر استقلال نخواهد بود.

Cov(X,X2)=E(X2×X)–E(X)E(X2)=E(X3)–E(X)E(X2)=0–0=0

از اینکه مطالب مجله فرادرس را مطالعه میکنید و به آن توجه دارید، بر خود میبالیم.

تندرست و پیروز باشید.

خیلی ممنون از توضیحات خوبتون