پردازش متن فارسی در پایتون با کتابخانه هضم

فرض کنید هزاران پیام فارسی را از شبکههای اجتماعی جمعآوری کردهاید و حالا میخواهید پردازش سادهای روی این متنها انجام دهید؛ مثلاً میخواهید بدانید چند درصدِ این پیامها، درباره «کتاب» است. احتمالاً آسانترین راه این است که کلمه «کتاب» را بین این پیامها جستجو کنید و بر اساس آن، فراوانی کلمه را محاسبه کنید. اما اینجا مشکلی وجود دارد!

کلمه «کتاب» لزوماً به یک شکل نوشته نمیشود. کتاب، کتــــاب، ڪتاب، کتابـــ و ... . از دید ماشین هر یک از این کلمات، جداست؛ در حالی که اینطور نیست.

اینجاست که پیشپردازش و نرمالسازی متن اهمیت پیدا میکند. نرمالسازی یعنی متن ورودی را که ممکن است به هر شکلی نوشته شده باشد به یک متن استاندارد و متحدالشکل تبدیل کنیم.

این یعنی حذف فاصلههای اضافه، اصلاح فاصلهها در پسوندها و پیشوندها، اصلاح فاصله در علائم نگارشی، تبدیل اعداد غیر فارسی به فارسی، استفاده از گیومه به جای کوتیشن، تبدیل حروف عربی و غیراستاندارد به حروف فارسی، حذف تکرارهای بیهوده حروف، حذف علائم و کاراکترهای بیفایده، اصلاح فاصله در ترکیب اعداد و کلمات و ... .

اگر بخواهید همه این کارها را خودتان انجام دهید باید زمان زیادی را برای تشخیص حالات مختلف و کدنویسی برای هر یک از این حالتها صرف کنید.

اما راه آسانتری وجود دارد: کتابخانه هضم

هضم یک کتابخانه متنباز بر مبنای زبان پایتون برای پردازش متون فارسی است. تمام کارهای بالا را میتوانید با چند خط کد با کتابخانه هضم انجام دهید.

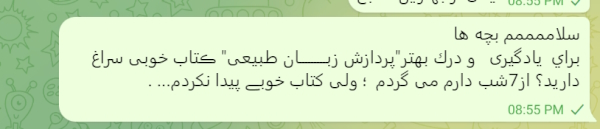

این متن را با کمک کتابخانه هضم تمیز میکنیم:

1input = “””سلاممممم بچه ها

2براي یادگیری و درك بهتر"پردازش زبـــــــــان طبیعی" ڪتاب خوبی سراغ دارید؟

3از7شب دارم می گردم ؛ ولی کتاب خوبے پیدا نکردم... .

4”””

5

6normalizer = Normalizer()

7output = normalizer.normalize(input)

8print(output)خروجی به صورت زیر خواهد بود:

«سلام بچهها برای یادگیری و درک بهتر «پردازش زبان طبیعی» کتاب خوبی سراغ دارید؟ از ۷ شب دارم میگردم؛ ولی کتاب خوبی پیدا نکردم … .»

در ادامه با قابلیتهای هضم، بیشتر آشنا میشویم:

تمیزکردن متن

هدف از تمیزکردن متن یا اصطلاحاً نرمالسازی، رفع نایکدستیها و متحدالشکل کردن متن، جهت آمادهسازی آن برای پردازشهای بعدی است. کتابخانه هضم توانایی بسیار خوبی در این بخش دارد.

1>>> normalizer = Normalizer()

2>>> normalizer.normalize('اِعلاممممم کَرد : « زمین لرزه ای به بُزرگیِ 6دهم ریشتر ...»')

3'اعلام کرد: «زمینلرزهای به بزرگی ۶ دهم ریشتر …»'استخراج جملات و کلمات

گاهی لازم است جملات یا کلمات متن را استخراج کنید. هضم میتواند این کار را به سادگی برای شما انجام دهد. حتی میتواند در هنگام استخراج جملات، مفاهیمی مثل هشتگ، ایمیل، عدد و لینک را هم علامت بگذارد.

1>>> tokenizer = WordTokenizer()

2>>> tokenizer.tokenize('این جمله (خیلی) پیچیده نیست!!!')

3['این', 'جمله', '(', 'خیلی', ')', 'پیچیده', 'نیست', '!!!']

4>>> tokenizer = WordTokenizer(join_verb_parts=False)

5>>> print(' '.join(tokenizer.tokenize('سلام.')))

6سلام .

7>>> tokenizer = WordTokenizer(join_verb_parts=False, replace_links=True)

8>>> print(' '.join(tokenizer.tokenize('در قطر هک شد https://t.co/tZOurPSXzi https://t.co/vtJtwsRebP')))

9در قطر هک شد LINK LINK

10>>> tokenizer = WordTokenizer(join_verb_parts=False, replace_ids=True, replace_numbers=True)

11>>> print(' '.join(tokenizer.tokenize('زلزله ۴.۸ ریشتری در هجدک کرمان @bourse24ir')))

12زلزله NUMF ریشتری در هجدک کرمان ID

13>>> tokenizer = WordTokenizer(join_verb_parts=False, separate_emoji=True)

14>>> print(' '.join(tokenizer.tokenize('دیگه میخوام ترک تحصیل کنم 😂😂😂')))

15دیگه میخوام ترک تحصیل کنم 😂 😂 😂ریشهیابی کلمات

با کتابخانه هضم میتوانید ریشه یا بن کلمات را پیدا کنید. مثلاً ریشه کلمه «کتابها»، «کتاب» است، یا در کلمه «میروم»، بن ماضی و مضارع به ترتیب «رفت» و «رو» است.

1>>> lemmatizer = Lemmatizer()

2>>> lemmatizer.lemmatize('کتابها')

3'کتاب'

4>>> lemmatizer.lemmatize('آتشفشان')

5'آتشفشان'

6>>> lemmatizer.lemmatize('میروم')

7'رفت#رو'

8>>> lemmatizer.lemmatize('گفته_شده_است')

9'گفت#گو'

10>>> lemmatizer.lemmatize('نچشیده_است')

11'چشید#چش'

12>>> lemmatizer.lemmatize('مردم', pos='N')

13'مردم'

14>>> lemmatizer.lemmatize('اجتماعی', pos='AJ')

15'اجتماعی'برچسبگذاری کلمات

شاید لازم باشد فعلها، اسمها، صفتها و دیگر ساختهای زبانی را استخراج کنید. این کار نیز با کمک هضم امکانپذیر است.

1>>> posTagger = POSTagger(model = 'pos_tagger.model')

2>>> posTagger.tag(tokens = ['من', 'به', 'مدرسه', 'ایران', 'رفته_بودم', '.'])

3[('من', 'PRON'), ('به', 'ADP'), ('مدرسه', 'NOUN,EZ'), ('ایران', 'NOUN'), ('رفته_بودم', 'VERB'), ('.', 'PUNCT')]قطعهبندی

گاهی در برخی از جملات مثل «رئیس جمهور ایران به نیویورک سفر کرد.»، عبارت «رئیس جمهور ایران»، در ظاهر سه کلمه است ولی در حقیقت یک واحد معنایی است. کتابخانه هضم امکان استخراج این گروههای معنایی را نیز دارد.

1 >>> chunker = Chunker(model = 'chunker.model')

2>>> tree = chunker.parse(sentence = [('نامه', 'NOUN,EZ'), ('ایشان', 'PRON'), ('را', 'ADP'), ('دریافت', 'NOUN'), ('داشتم', 'VERB'), ('.', 'PUNCT')])

3>>> print(tree)

4(S

5 (NP نامه/NOUN,EZ ایشان/PRON)

6 (POSTP را/ADP)

7 (VP دریافت/NOUN داشتم/VERB)

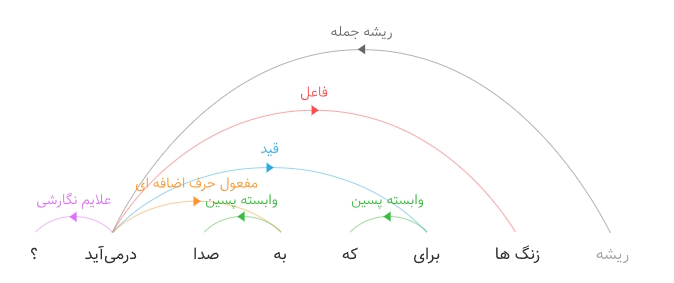

8 ./PUNCT)تجزیه نحو وابستگی

در نهایت، تجزیهگر نحو وابستگی، با تحلیل ساختار نحوی یک جمله و یافتن کلمات مرتبط، روابط بین کلمات و گروههای معنایی را نشان میدهد.

1>>> from hazm import POSTagger, Lemmatizer, DependencyParser

2>>> parser = DependencyParser(tagger=POSTagger(model='pos_tagger.model'), lemmatizer=Lemmatizer())

3>>> parser.parse(['من', 'به', 'مدرسه', 'رفته بودم', '.']).tree().pprint()

4(من (به (مدرسه (رفته_بودم .))))نمونهای از خروجی تجزیهگر عمقی که برای درک بهتر به شکل نمودار ترسیم شده است:

بازنمایی واژهها و جملات

با استفاده از بازنمایی واژهای هضم میتوانید شبکههای عمیق را با سهولت بیشتری برای کاربردهای زبانی دلخواه خود آموزش دهید. همچنین با استفاده از بازنمایی جملهای میتوانید شباهت میان متون را بسنجید.

1>>> wordEmbedding = WordEmbedding(model_type = 'fasttext')

2>>> wordEmbedding.load_model('word2vec.bin')

3>>> wordEmbedding.doesnt_match(['سلام' ,'درود' ,'خداحافظ' ,'پنجره'])

4'پنجره'

5>>> wordEmbedding.doesnt_match(['ساعت' ,'پلنگ' ,'شیر'])

6'ساعت'خواندن آسان پیکرههای متنی

پیکرههای متنی، دادههایی هستند که در شکلها و قالبهای مختلفی عرضه میشوند مانند پیکره ویکیپدیا، همشهری، پرسیکا، میراث و … . هر یک از این پیکرهها در ساختار و قالب متفاوتی عرضه میشوند که در نبود کتابخانه هضم باید برای خواندن هر یک از آنها اسکریپت جدایی بنویسید. با کتابخانه هضم بهراحتی میتوانید بیشتر پیکرههای مهم فارسی را با چند خط کد بخوانید.

1>>> mirastext = MirasTextReader(filename='mirastext.txt')

2>>> next(mirastext.texts())[:42] # first 42 characters of fitst text

3'ایرانیها چقدر از اینترنت استفاده میکنند؟'برای استفاده از این کتابخانه، کسب اطلاعات بیشتر یا مشارکت در توسعه پروژه به صفحه گیتهاب هضم مراجعه کنید.