خوشهبندی و تفسیر نتایج آن

با افزایش آگاهی مدیران سازمانها، کسبوکارها، نهادهای بهداشتی و درمانی و دانشگاهها از مزایایی که دادهکاوی برای آنها به ارمغان میآورد، در سالهای اخیر پروژههای کاوش داده متعددی در سازمانها اجرایی شده است. تحلیل سبد خرید، تشخیص کلاهبرداری، تشخیص وامگیرندگان قابل اعتماد، تحلیل شبکههای اجتماعی، تشخیص انواع سرطان و تحلیل بازار تنها بخشی از موضوعاتی است که این روزها پروژهها و پژوهشهای دادهکاوی حول محور آن انجام میشود.

برای انجام پروژههای دادهکاوی، راهکارهای نظارت شده، نظارت نشده و نیمهنظارت شدهای وجود دارد که بسته به نوع مساله قابل استفاده هستند. دکتر مارتین اشمیتز (Martin Schmitz)، دانشمند داده و از نویسندگان «Toward Data Science» در رابطه با استفاده از الگوریتمهای خوشهبندی (روشهای نظارت نشده) میگوید: «من با کارفرماهای زیادی برای انجام پروژههای دادهکاوی همکاری کردهام. گاهی مشتریان تمایل به استفاده از روشهای خوشهبندی دارند و من همه سعیم را برای اجتناب از این کار میکنم. دلیل این اجتناب، یک قانون سرانگشتی ساده است؛ اگر میتوانید از روشهای نظارت شده استفاده کنید، پس این کار را انجام دهید!». اما گاهی نیز تبدیل مساله خوشهبندی به دستهبندی امکانپذیر نیست و لذا نیاز به راهکارهایی مطرح میشود که برای تفسیر نتایج خوشهبندی بتوان از آنها استفاده کرد. آنچه در ادامه میخوانید، نظرات مارتین اشمیتز در همین رابطه است.

هر تحلیلی دارای یک مجموعه از پارامترها است. این پارامترها باید در هر پروژهای تعیین شوند. در مسائلی که نظارت شده هستند، آنچه باید بهینه شود کاملا مشخص است و چیزی به جز ارزش کسبوکار نیست. در مسائل نظارت نشده، همواره بحثهای متعددی در رابطه با انتخاب سنجههای مناسب شکل میگیرد. راهکارهای متعددی برای اندازهگیری کیفیت خوشهبندی وجود دارد که از آن جمله میتوان به شاخص «Davies-Bouldin» و ضریب «silhouette» اشاره کرد.

نکته قابل توجه آن است که بسیاری از مسائل تقسیمبندی قابل تبدیل به دستهبندی هستند. این کار همیشه توصیه میشود! تنها در برخی موقعیتهای خاص است که به دادهکاوها گفته میشود از خوشهبندی بهجای طبقهبندی استفاده کنند. دلیل این توصیه تولید نتایجی است که برای انسان قابل تفسیر باشد و مدیران را در تراز کردن اهداف کسبوکارشان یاری کند. در ادامه راهکارهایی بیان میشود که تشریح نتایج خوشهبندی را ساده کند.

ترفند اول: تبدیل آن به مساله انتخاب ویژگی

در تحلیلهای داده نیاز به نگاشت پرسشهای کسبوکار به یک روش است. در چنین شرایطی، این پرسشها مطرح میشوند که: چه چیزی خوشهها را به بهترین شکل توصیف میکند؟ (در این مثال cluster_0) یا به عبارت دیگر، چه چیزی یک خوشه (cluster_0) را از سایر خوشهها متمایز میکند؟ این پرسشها را میتوان به صورت یک مساله انتخاب ویژگی تفسیر کرد.

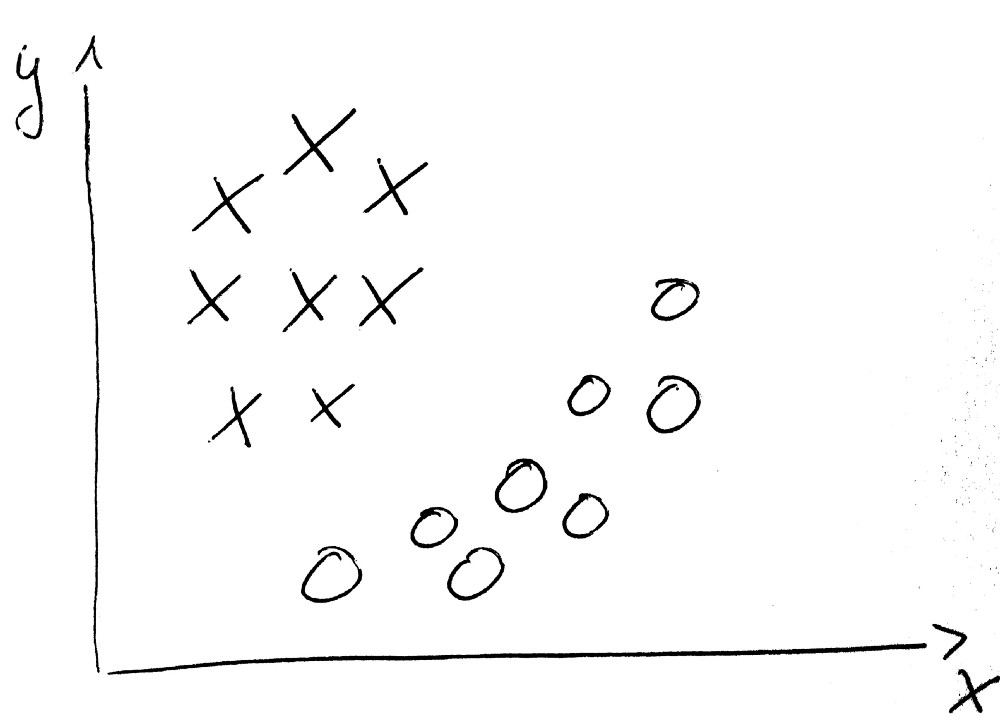

تنها کافیست که مشخص شود کدام ویژگی قدرت ایجاد تمایز بین دادهها (در این مثال بین خوشه O و X) را دارد. توصیه میشود از این ترفند در همه مسائل استفاده شود، زیرا بهطور مستقیم پاسخ پرسشهای طرح شده را فراهم میکند.

دادهها در دو بخش تقسیمبندی شدهاند. یک روش انتخاب ویژگی، قادر به تشخیص ابعادی است که برای تمییز کلاسها از یکدیگر لازم هستند.

روشهای متداول انتخاب ویژگی مانند wrapper یا فیلترگذاری، یک لیست از ویژگیها و میزان اهمیت آنها فراهم میکنند.

در مجموعه داده معروف تایتانیک، ویژگیهای سن، جنسیت و مسافر مهمترین خصیصهها هستند. این امر امکان نامگذاری خوشه را با عنوان «Age-Gender-Passenger Class» فراهم میکند. مسالهای که در اینجا مطرح میشود آن است که به هنگام شناسایی فاکتورهای مهم، جهت آنها نامگذاری نمیشود. آیا این خوشه متعلق به مردهای کهنسال است، یا زنان جوان؟ با استفاده از مختصات مرکزوار (centroid) میتوان به نتایج عمیقتری در این رابطه دست یافت. اما یک راهکار سادهتر نیز وجود دارد: درخت تصمیم!

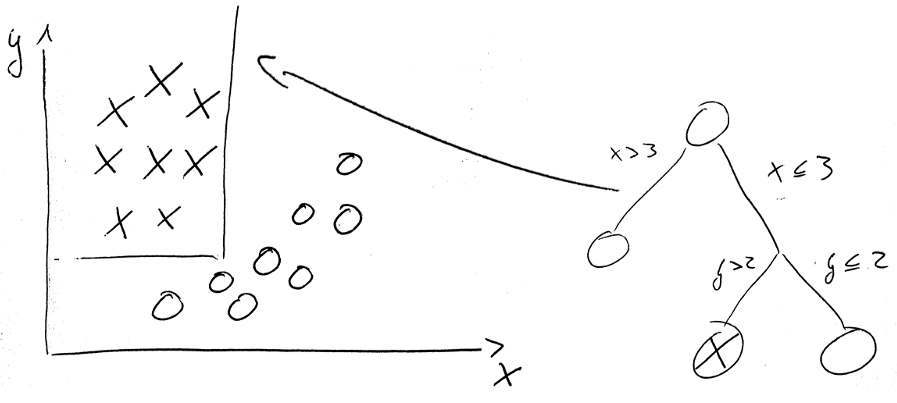

ترفند دوم: درخت تصمیم

درختهای تصمیم همواره از قابل درکترین مدلهای یادگیری ماشین هستند. معمولا، از این مدلها برای حل مسائل دستهبندی استفاده میشود.

در اینجا از آنها برای تمییز دادن خوشه cluster_0 و دیگر خوشهها استفاده میشود.

درخت تصمیم توانایی ایجاد تمایز بین کلاسهای گوناگون را دارد و به دادهکاو میگوید که کدام ویژگیها مهمتر هستند.

گام بعدی، تحلیل انشعابهای درخت تصمیم است. همه انشعابهایی که cluster_0 را پیشبینی میکنند میتوانند بهعنوان توصیف استفاده شوند. شاخهها را میتوان به صورت زیر دریافت کرد:

Age < 20 AND Passenger Class= First AND Gender= female

که cluster_0 را به خوبی توصیف میکند.

با نگاهی به صحت آموزش درخت، میتوان دید که توصیف ارائه شده چقدر دقیق محسوب میشود. لازم به ذکر است که همواره باید بین تفسیرپذیری و کیفیت نتایج، تعادل برقرار باشد. این کار را میتوان با هرس کردن انجام داد. توصیه میشود که برشهای عمیقی در درخت زده شود.

تجربیات پیشین نشان میدهد که هرس در عمق ۴ یا ۵ میتواند به نتایج خوبی منجر شود. انسانها اغلب توانایی خود برای تفسیر مدلها را بیش از آنچه هست تخمین میزنند و در درختهای تصمیم، برای همه برشها اهمیت یکسانی قائل هستند. این در حالیست که هر ناحیه باید متناسب با زمینه و سلسله مراتب آن تفسیر شود.

اگر نوشته بالا برای شما مفید بوده است، آموزشهای زیر نیز به شما پیشنهاد میشود:

- همه چیز در مورد درخت تصمیم (Decision Tree)

- آموزش مقدمهای بر دادهکاوی

- فیلمهای آموزشی دادهکاوی یا Data Mining در متلب

- آموزش خوشهبندی با استفاده از الگوریتمهای تکاملی و فراابتکاری

^^