کامپیوتر کوانتومی — به زبان ساده

در این مقاله قصد داریم تا شما را با یکی از شگفتانگیزترین ساختههای قرن 21، یعنی کامپیوتر کوانتومی آشنا کنیم. امروزه پردازندههای مورد استفاده در تلفنهای همراه به ساختاری ۷ نانومتری رسیده و انتظار میرود تا سال 2021 پردازندههایی با لیتوگرافی 5 نانومتری نیز روانه بازار شوند. بدون اغراق این پردازندههای کوچک، بیش از چندین برابر پردازندههای سطح بالا دسکتاپ که در دهه 2000 میلادی روانه بازار شدند، قویتر هستند. این امر نه تنها برای پردازندههای موبایل بلکه برای پردازندههای دسکتاپ و سرور که با لیتوگرافی 10 و ۷ نانومتری روانه بازار شدند نیز صادق است.

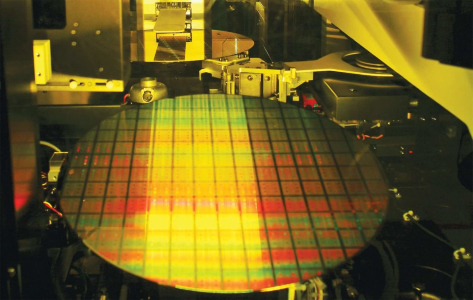

با وجود این پیشرفت شگفتانگیز در کارایی و سرعت پردازندههای محاسباتی، هنوز مسائل پیچیدهای وجود دارند که حل آنها از عهده هیچ یک از سوپر کامپیوترهای موجود بر نمیآید. شاید. جدا از وجود مسائل پیچیده، یک مشکل اساسیتر در روند توسعه و ساخت تراشهها، کوچک شدن ابعاد ترانزیستورها است. امروزه شرکتهایی بزرگی چون AMD و اپل پس از تقلای بسیار به تکنولوژی ساخت تراشههای ۷ نانومتری دست پیدا کردهاند.

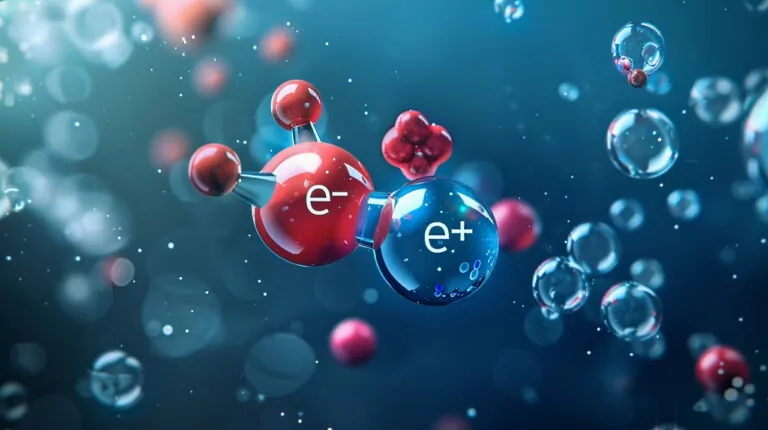

در ساختارهای زیر 10 نانومتر، ابعاد ترانزیستورها به ابعاد اتمی نزدیک شده که در این صورت قوانین فیزیک کوانتومی نمود بیشتری پیدا کرده و قواعد بازی را عوض میکنند. به طور مثال یک الکترون میتواند از یک ترانزیستور به ترانزیستور دیگر تونلزنی انجام دهد، که این پدیده برای یک تراشه محاسباتی، امر مطلوبی نیست.

در طول تاریخ، عموماً شاهد تبدیل چالشها به فرصتها، توسط فیزیکدانان بودهایم. شما چه راه حلی را برای مشکل فوق پیشنهاد میکنید؟ آیا به نظرتان دنیای پردازندهها به انتهای خود نزدیک شده و دیگر پیشرفت قابل ملاحظهای را به خود نمیبینند؟ بعید است! علم و تکنولوژی هیچگاه متوقف و یا به عقب برنمیگردند. حال که به دنیای فیزیک کوانتومی وارد شدهایم، نظرتان چیست که محاسبات را از دنیای کلاسیک به دنیای کوانتوم بیاوریم؟ در ادامه این مطلب همراه ما باشید تا با زبانی ساده و به دور از روابط پیچیده، به بحث محاسبات و کامپیوتر کوانتومی بپردازیم.

محاسبات رایج (Conventional Computing)

آیا تا به حال فکر کردهاید اموری سادهای که در طول روز توسط کامپیوتر یا موبایل خود انجام میدهید، چگونه توسط پردازنده (CPU) دستگاه شما انجام میگیرد؟

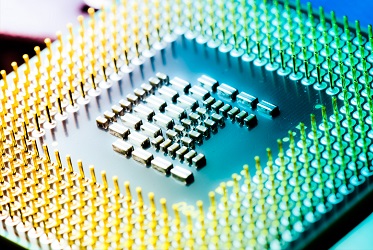

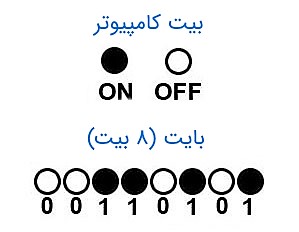

کامپیوترهای متعارف میتوانند اعداد (۰ و ۱) را در حافظه خود ذخیره و روی آنها عملیات ساده ریاضی (پردازش) را انجام دهند. عمل ذخیرهسازی و پردازش توسط سوییچهایی به نام ترانزیستور انجام میگیرد. ترانزیستورها را میتوانید نسخهای میکروسکوپی از سوییچهایی که روی دیوار جهت خاموش و روشن شدن چراغها استفاده میشود، در نظر بگیرید. در واقع یک ترانزیستور میتواند روشن و یا خاموش باشد. درست همانطور که نور میتواند روشن و یا خاموش شود. از ترانزیستور روشن میتوانیم برای ذخیره یک (۱) و از خاموش بودن آن برای ذخیره صفر (۰) استفاده کنیم.

رشتههایی طولانی از این صفر و یکها میتوانند برای برای ذخیره هر عدد، نماد و حروفی استفاده شوند. به طور مثال در قواعد کد «اسکی» (ASCII) رشته 1000001 برای نمایش A و رشته 01100001 برای نمایش a به کار میرود. (برای تبدیل کد اسکی از این لینک استفاده کنید). هر کدام از این ۰ و ۱ها یک رقم باینری یا بیت نامیده میشوند که با رشتهای ۸ بیتی میتوانید ۲۵۵ کاراکتر مختلف مثل A-Z، a-z و 0-9 را ذخیره کنید. یادآور میشویم که هر 8 بیت معادل ۱ بایت در نظر گرفته میشود.

کامپیوترها با استفاده از مدارهای (دروازه - گیت) منطقی (Logic Gates) که از تعدادی ترانزیستور ساخته شدهاند، محاسبات و پردازش را بر روی بیتها انجام میدهند. یک گیت منطقی حالت یک بیت را سنجیده و در حافظهای موقت موسوم به رجیستری ذخیره میکند. سپس آنها را به حالت جدیدی تبدیل میکند. در واقع معادل عمل جمع، تفریق یا ضرب که ما در ذهن خود انجام میدهیم. یک الگوریتم در سطح پایین و به صورت فیزیکی، در واقع متشکل از چندین گیت منطقی است که کنار یکدیگر تشکیل یک مدار الکترونیکی را دادهاند. این مدار محاسبه یا عمل خاصی را انجام میدهد.

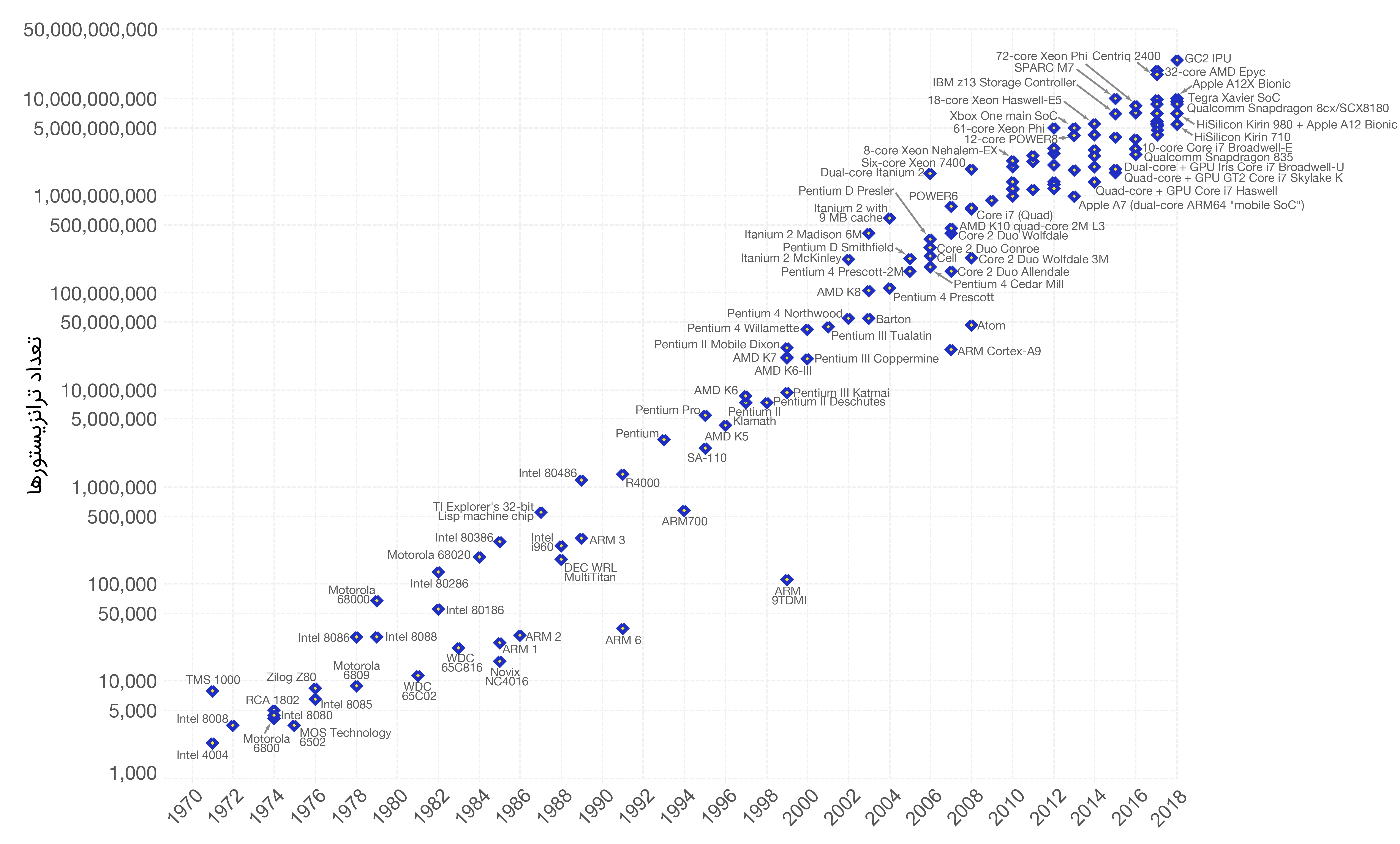

همانطور که در مقدمه مقاله اشاره کردیم، روند کوچکسازی ابعاد ترانزیستورها با مشکل مواجه بوده و در لیتوگرافیهای زیر 10 نانومتر به کندی پیش میرود. تا قبل از اختراع ترانزیستور در سال 1947، سوییچهایی که عمل ترانزیستور را انجام میدادند، لامپهایی خلأ بودند که اندازه بزرگی داشتند. امروزه روی یک تراشه پیشرفته به اندازه ناخن دست، میلیاردها ترانزیستور وجود دارد. در دهه 1960، گوردن مور یکی از بنیانگذران شرکت بزرگ «اینتل» (Intel) قانونی تجربی را که به «قانون مور» (Moore's law) معروف است بیان کرد. این قانون پیشبینی میکند که به طور متوسط هر ۱۸ ماه تعداد ترانزیستورها بر روی یک تراشه با مساحت ثابت، دو برابر میشود.

مطابق با پیشبینی قانون مور، از دهه 1960 تا کنون با افزایش تعداد ترازیستورها و در نتیجه افزایش حافظه و سرعت کامپیوترها، برخی از مسائل پیچیده حل شده و از تعداد آنها کم شده است. اما همچنان مسائلی وجود دارند که حتی سوپرکامپیوترهایی که در چند سال اخیر به جهان عرضه شدند، قدرت و توانایی حل آنها را ندارند.

جدا از مطلب فوق، در چند سال اخیر فرآیند ساخت ترانزیستورها و لیتوگرافیهای کمتر از 10 نانومتر با مشکلاتی مواجه بوده و به کندی پیش میرود. در واقع به نظر میرسد که قانون مور به پایان عمر خود نزدیک است. جدا از راهکارهای کلاسیکی برای رفع مشکلات، میتوانیم رویکردهای فیزیک کوانتومی را بررسی و علم محاسبات را به دنیای کوانتومی وارد کنیم.

پیدایش محاسبات کوانتومی

نظریه و فیزیک کوانتوم قوانین حاکم بر دنیای میکروسکوپی، اتمها و ذرات زیر اتمی را تشریح میکند. همانطور که احتمالاً میدانید، در مقیاسهای اتمی، قوانین فیزیک کلاسیک دیگر کارایی نداشته و نیاز است تا قوانین جدیدی را به کار بریم.

در کتابهای اپتیک، نور را موجودی دوگانه (موج و ذره) تعریف میکنند. در واقع نور بخشی از طیف امواج الکترومغناطیسی است که در عین حال یک ذره (فوتون) هم میتواند باشد! شاید بپرسید چگونه یک چیز واحد میتواند دو موجودیت داشته باشد؟! بله، در دنیای کوانتوم نظیر چنین مطالبی امری عادی است. به جز بحث دوگانگی موج - ذره نور، یکی دیگر از مثالهای معروف دنیای فیزیک کوانتوم، گربه شرودینگر است. این گربه که در جعبهای قرار دارد، در هر لحظه هم میتواند زنده باشد و هم مرده! پیشنهاد میکنیم برای آشنایی بیشتر با فیزیک کوانتوم نگاهی بر مقالات «معادله شرودینگر -- به زبان ساده»، «درهمتنیدگی -- به زبان ساده» و «کوانتوم -- به زبان ساده» داشته باشید.

حال فرض کنید که ما همچنان بتوانیم ابعاد ترانزیستورها را کوچک و کوچکتر کنیم تا قانون مور پابرجا بماند. این ترانزیستورهای کوچک دیگر همانند ترانزیستورهای قدیمی مطابق قوانین فیزیک کلاسیک کار نکرده و از قوانین پیچیدهتر فیزیک کوانتومی پیروی میکند. سوال مهمی که در اینجا پیش میآید، این است که آیا تراشههای ساخته شده با این ترانزیستورهای به اصطلاح کوانتومی میتوانند کارهای رایج مارا انجام دهند؟! محاسبات ریاضی روی کاغذ به این سوال پاسخ مثبت میدهد.

اجازه دهید نگاهی گذار به روند پیشرفت علوم کامپیوتر و محاسبات که باعث شدند امروزه کامپیوترهای کوانتومی به گزینهای جدی برای انجام محاسبات تبدیل شوند، داشته باشیم. آغاز این روند از دو فیزیکدان و محقق شرکت «آی بی اِم» (IBM) به نامهای «رالف لاندائور» (Rolf Landauer) و «کارلس بِنِت» (Charles H. Bennett.) بود. لاندائور در دهه 1960 مطرح کرد که اطلاعات ماهیتی فیزیکی دارند که با توجه به قوانین فیزیکی میتوانند تغییر کنند.

یکی از نتایج بسیار مهم از طرح لاندائور این است که کامپیوترها، به واسطه دستکاری و تغییر اطلاعات (بیتها) باعث به هدر رفتن انرژی میشوند. به همین دلیل است که قسمتهای پردازشی در یک کامپیوتر نظیر تراشه مرکزی (CPU) و تراشه گرافیکی (GPU) حتی اگر عملیات سنگینی انجام ندهند، انرژی بسیار زیادی مصرف کرده و گرم میشوند.

بِنِت در دهه 1970 در راستای طرح لاندائور، نشان داد که اگر کامپیوترها بتوانند عملیات پردازش را به طور برگشتپذیر انجام دهند، میتوان از اتلاف انرژی به حد زیادی جلوگیری کرد. منظور از پردازش یا محاسبات برگشتپذیر به طور خیلی ساده این است که با داشتن خروجی اطلاعات (بیتهای خروجی) بتوانیم به اطلاعات ورودی (بیتهای ورودی) پی ببریم. برای تحقق این امر باید دروازههای (گیت) منطقی ساخت که به طور برگشت پذیر کار میکنند. در فیزیک و محاسبات کلاسیک تنها گیت NOT برگشتپذیر است. برای آشنایی با یکی از مهمترین گیتهای برگشتپذیر پیشنهاد میکنیم به مقاله «گیت برگشت پذیر توفولی (CCNOT) -- به زبان ساده» رجوع کنید. پس انتظار میرود که کامپیوترهای کوانتومی با انجام محاسباتی برگشتپذیر، عملیات گسترده و سنگینی را بدون صرف انرژیهای بسیار زیاد انجام دهند. در مقام مقایسه خوب است بدانید که کامپیوتر کوانتومی D-Wave 2000Q ساخت شرکت کانادایی «دی وِیو» (D-Wave) تنها 25کیلووات انرژی مصرف میکند. در حالی که سوپرکامپیوتر Summit که از تراشههای شرکت «انویدیا» استفاده میکند توان مصرفی 13مگاوات را دارد!

در سال 1981 «پائول بِنیوف» (Paul Benioff) از آزمایشگاه ملی (Argonne) سعی کرد ماشینی بسازد که مشابه یک کامپیوتر معمولی اما طبق قوانین فیزیک کوانتومی کار میکرد. سال بعد «ریچارد فاینمن» (Richard Feynman) فیزیکدان پرآوازه، با استفاده از اصول مکانیک کوانتومی، چگونگی استفاده از یک ماشین پایه برای انجام محاسبات را نشان داد. چند سال بعد در دانشگاه آکسفورد «دِیوید دویچ» (David Deutsch) یکی از تاثیرگذارترین افراد در توسعه محاسبات کوانتومی، مبانی نظری و تئوری یک کامپیوتر کوانتومی را تشریح کرد.

کامپیوتر کوانتومی

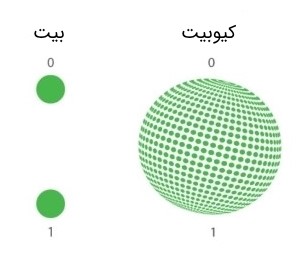

ویژگیهای اصلی کامپیوترهای معمولی نظیر بیت، الگوریتم، گیتهای منطقی و ... به طور مشابه در کامپیوترهای کوانتومی نیز وجود دارند. اصلیترین جزء یک کامپیوتر کوانتومی، در واقع واحد پردازش اطلاعات، بیت کوانتومی یا کیوبیت است. عملکرد یک کیوبیت شاید کمی مبهم به نظر آید.

همانطور که میدانید یک بیت کلاسیک در هر لحظه تنها میتواند یکی از دو مقدار ۰ و ۱ را داشته باشد؛ اما یک کیوبیت در هر لحظه هم میتواند ۰ باشد و هم ۱ یا حتی هر چیزی دیگری بین ۰ و ۱ ! در واقع یک کیوبیت در حالت «برهمنهی» (Superposition) از حالتهای پایه ۰ و ۱ است. برای مشخص شدن حالت کیوبیت باید آن را اندازهگیری کرد، در این صورت حالت برهمنهی فرو ریخته و کیوبیت با یک احتمالی در 0 و یا ۱ ظاهر میشود. پرداختن بیشتر به بیت کوانتومی از حوصله این مقاله خارج بوده و در صورت علاقهمندی جهت آشنایی بیشتر به مقاله «کیوبیت -- به زبان ساده» مراجعه کنید.

از آنجایی که یک کیوبیت در هر لحظه میتواند مقادیر مختلفی را به طور همزمان در خود ذخیره کند (برهمنهی از حالتهای 0 و ۱)، میتوان نتیجه گرفت که یک کامپیوتر کوانتومی به هنگام پردازش کیوبیتها، میتواند اطلاعات را به صورت همزمان پردازش کند. در واقع بر خلاف کامپیوترهای معمولی که عمل پردازش و محاسبات را به طور «سری» (Serial) انجام میدهند، کامپویترهای کوانتومی میتواند محاسبات را به صورت «موازی» (Parallel) انجام دهند. این امر سرعت بسیار زیادی را در انجام محاسبات نسبت به یک کامپیوتر معمولی به ارمغان میآورد.

میدانیم که بیتهای معمولی به وسیله گیتهای منطقی پردازش میشوند. در کامپیوترهای کوانتومی نیز، کیوبیتها توسط گیتهای کوانتومی پردازش میشوند. گیتهای کوانتومی در واقع عملگر یا اپراتورهای (Quantum Operators) تحول زمانی یکانی هستند که در مدت زمان مشخصی، یک نگاشت یک به یک را انجام داده و در یک حالت کوانتومی را به حالت دیگری تبدیل میکنند. از آنجایی که گیتهای کوانتومی، نگاشتی یک به یک را انجام میدهند، عملیات انجام شده توسط آنها برگشتپذیر است.

کامپیوتر کوانتومی چگونه کار میکند؟

مصداق فیزیکی یک بیت کلاسیکی میتواند دو سطح مختلف ولتاژ (مثلاً دو 0 و 5 ولت) یا روشن و خاموش شدن یک پالس لیزری باشد. در مورد کیوبیت نیز، هر سیستم دو حالته فیزیکی (ریزمقیاس) مانند اسپین بالا و پایین یک الکترون یا قطبش عمودی و افقی یک فوتون یا تغییر حالت یک اتم یا یون در سیستمی خاص میتواند برای تعریف کیوبیت به کار رود.

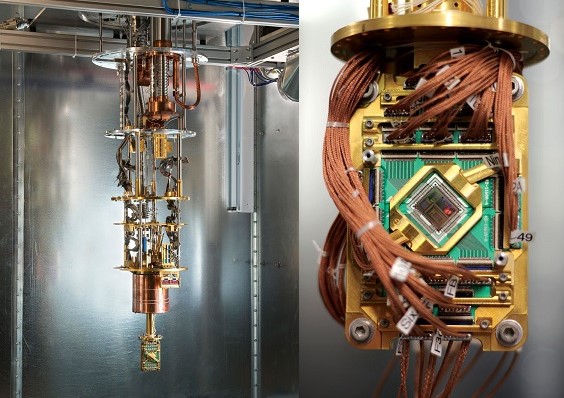

احتمالاً میدانید که سیستمهای ریزمقیاس و کوانتومی به شدت نویزپذیر بوده و حالتشان تغییر میکند. پس برای تعریف کیوبیتها و یا پردازش و کنترل آنها به مکانیزمهایی خاص و پیچیده نیاز داریم تا بتوانیم اتم، یون و ... را در حالتی خاص قرار داده و یا به حالتهای دیگر ببریم. قرار دادن کیوبیت (اتم، یون، فوتون و ...) در یک حالت خاص، مصداق ذخیره اطلاعات و تغییر حالت آنها مصداق عمل پردازش بر روی کیوبیتها است. برای حذف نویز و ایزوله کردن سیستمهای کوانتومی از محیط بیرون معمولاً به تجهیزات گرانقیمتی جهت مهیا ساختن خلأ بسیار بالا و یا سرد کردن تا نزدیکی صفر مطلق نیاز است.

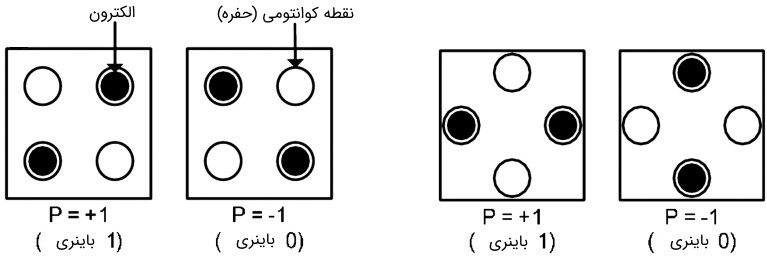

تا کنون روشهای متفاوتی جهت کنترل کیوبیتها، پیادهسازی گیتهای کوانتومی و الگوریتمهای کوانتومی ارائه شدهاند که هر یک مزایا و معایب خاص خود را دارا هستند. یکی از این روشها تعریف کیوبیت توسط نقاط کوانتومی است. نقاط کوانتومی که ذراتی نانومقیاس از نیمهرسانا بوده که درون آن شامل الکترون و حفره است.

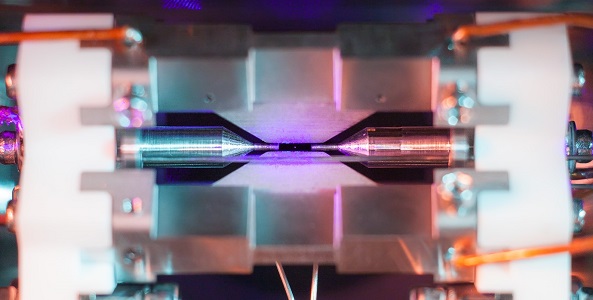

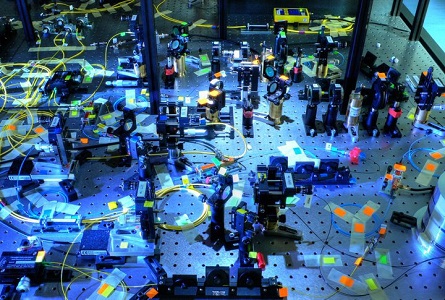

یکی دیگر از این روشها تله اندازی یونی است. شما میتوانید با اضافه کردن یا کندن الکترون از اتم، آن را به یون تبدیل کنید. این اتم میتواند در داخل یک کاواک به وسیله پالسهای لیزری دام (تله) افتاده و در حالت خاصی قرار گیرد. همچنین به وسیله پالسهایی متفاوت در حالتهای مختلف دیگری قرار گیرد.

یکی دیگر از روشهایی که نسبت به سایر روشها پیچیدگی کمتری دارد، تعریف کیوبیت و پیادهسازی گیتهای کوانتومی با استفاده از سیستمهای اپتیک خطی و غیرخطی است. از آنجایی که فوتونها نسبت به محیط بیرون و دیگر فوتونها ایزوله هستند، گزینهای مناسب و ارزان قیمت جهت تعریف کیوبیتها هستند. چرا که برای کار با آنها نیازی به دماهای خیلی سرد یا خلأ بالا نیست. البته این سیستم نیز مشکلات خاص خود را دارد. به طور مثال برای پیادهسازی گیتهای چند کیوبیتی (۲ ورودی با بالا) نیاز به برهمکنش فوتونها بوده که این برهمکنش تحت شرایطی خاص و به صورت احتمالی صورت میگیرد.

آیا کامپیوترهای کوانتومی جایگزین کامپیوترهای عادی میشوند؟

شاید بتوان با قطعیت پاسخ خیر را به این سوال داد. از آنجایی که تعریف کیوبیتها شرایط خاصی (مثل خلأ بالا و یا دمای خیلی پایین) را طلب میکند، دور از انتظار است که در آینده، تلفن همراه و یا کامپیوتر خانگی شما حاوی تراشهای کوانتومی باشد.

کامپیوتر کوانتومی تنها حالت خاصی از کامپیوتر است که برای انجام و اجرای الگوریتمهایی خاص توسعه پیدا کرده است. برای روشن شدن این مطلب نور معمولی و نور لیزر را در نظر بگیرید. آیا با اختراع لیزر که فرمی جدیدتر از نور معمولی بود، استفاده از نور معمولی به تاریخ پیوست؟! خیر، لیزر کاربردهای خاص خود را داشته و نمیتوان آن را جایگزین نور معمولی کرد.

تا به امروز به جز چند الگوریتم محدود نظیر «شور» (Shor Algorithm) و «گراور» (Graver Algorithm)، مورد دیگری کشف نشده است که در کامپیوتر های کوانتومی بهتر اجرا شود.

شایان ذکر است الگوریتم شور که در سال 1994 توسط «پیتر شور» (Peter Shor) در آزمایشگاه «بل» (Bell) واقع در شرکت مخابراتی AT&T کشف شد، خطری بزرگ برای امنیت جهانی اینترنت و سیستمهای رمزنگاری معمولی است. این الگوریتم که عمل شکستن یک عدد بسیار بزرگ به عاملهای اول را در زمانی کوتاه انجام میدهد، خطری بزرگ برای سیستمهای رمزنگاری است. البته در حال حاضر بعید است که هکرها و سارقان به کامپیوتر کوانتومی دسترسی داشته باشند. همچنین از نگاه مثبت، این امر به توسعه بخشهای جدید از محاسبات کوانتومی منجر شد و دانشمندان را وادار به توسعه رمزنگاری کوانتومی و مخابرات کوانتومی کرد.

لازم به ذکر است که الگوریتم گراور برای جستوجو در پایگاههای داده خیلی بزرگ کاربرد دارد. انجام اموری که توسط الگوریتمهای شور و گراور در زمانی کوتاه صورت میگیرد، توسط قویترین سوپرکامپیوترهای موجود ممکن است که تا ماهها و یا سالها طول بکشد.

مشکلات ساخت کامپیوتر کوانتومی

خارج شدن یک ایده یا دستگاه از حالت آزمایشگاهی و نمود صنعتی پیدا کردن، ممکن است که چندین سال طول بکشد. در پس ساخت کامپیوترهای معمولی با ترانزیستورهای عادی که هر ساله نمونههای جدیدی از آنها با سرعت و ظرفیتهای بیشتری روانه بازار میشوند، چندین سال تجربه است. برای ساخت یک کامپیوتر کوانتومی به نوآوریهایی جدید که با قوانین فیزیک کوانتومی در تعامل هستند، نیاز داریم.

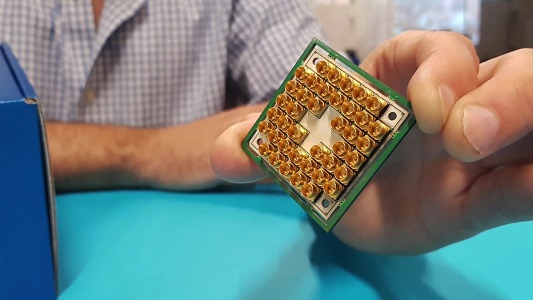

همانطور که پیشتر اشاره کردیم، یکی از مشکلات اصلی ساخت کامپیوترهای کوانتومی، ایجاد و کنترل دقیق کیوبیتها و ساخت گیتهای کوانتومی پایدار است. مشکل دوم مربوط به خطاپذیری زیاد سیستمهای کوانتومی است که از لحاظ فنی «نویز» (Noise) نامیده میشود. از آنجایی که کوچکترین تغییرات (جزئی) که ما از آنها در فیزیک کلاسیک و علوم مهندسی صرفنظر میکنیم، حالت یک سیستم میکروسکوپی در واقع کوانتومی را تغییر میدهند، باعث ایجاد خطا در محاسبات کوانتومی میشوند. از این جهت کیوبیتها کوچکترین تعاملی با محیط بیرون نباید داشته باشند، لذا به خلأ بسیار بالا و یا دماهای خیلی پایین (برای نمونههای ابررسانا) نیاز است. همچنین راهکارهایی نظیر «اصلاح خطای کوانتومی» (Quantum Error Correction) برای رفع این مشکل ارائه شدهاند.

یکی دیگر از مشکلات اساسی کامپیوتر کوانتومی، چگونگی ارسال و دریافت اطلاعات از آن است. برخی از منتقدین این مشکل را غیرقابل حل میداند. البته به نظر میرسد، کامپیوترهای کوانتومی اپتیکی که کیوبیتها بر اساس فوتون در آنها تعریف میشوند، کمتر این مشکل را داشته باشند. در واقع کدگذاری و ایجاد یک استاندارد برای کیوبیتهای فوتونی امری سادهتر از دیگر کیوبیتها است.

چقدر از کامپیوترهای کوانتومی دور هستیم؟

در سالهای اولیه، بحث کیوبیتها و کامپیوترهای کوانتومی تنها روی کاغذ مطرح بود. پس از گذشت مدتی طولانی، در سال 2000 دو پیشرفت قابل توجه در این حوزه از علم فیزیک رخ داد. «ایزاک چوانگ» (Isaac Chuang) استاد دانشگاه MIT و محقق شرکت IBM توانست یک کامپیوتر کوانتومی (البته غیر قابل استفاده) با ۵ کیوبیت توسط اتمهای فلوئور (Fluorine) بسازد. در همان سال، پژوهشگران آزمایشگاه ملی «لوس آلاموس» (Los Alamos) توانستند توسط قطره مایعی اسیدی شامل ۴ اتم کربن و ۶ اتم هیدروژن یک ماشین ۷ کیوبیتی بسازند. ۵ سال بعد محققان دانشگاه «اینسبراک» (Innsbruck) توانستند یک کیوبیت به همان سیستم اضافه و ماشینی ۱ کیوبایتی (Qubyte) در واقع شامل ۸ کیوبیت را بسازند.

تا سال 2011 پژوهشهای زیادی در این حوزه انجام شد. اما در این سال شرکت پیشگام کانادایی D-Wave با رونمایی از یک کاپیوتر 128 کیوبیتی گام موثری در پیشرفت دنیای محاسبات کوانتومی برداشت. البته بحثهای زیادی در خصوص این که آیا این ماشین واقعاً رفتاری کوانتومی دارد یا خیر، مطرح است. در سال 2015 شرکت «گوگل» کامپیوتر کوانتومی خود را بر اساس طرح شرکت D-Wave توسعه داد و اعلام کرد که روشی جدید برای کنترل و تشخیص خطاهای کوانتومی پیدا کرده است.

در سال 2016 «ایزاک چوانگ» و پژوهشگران دانشگاه «اینسبراک» کامپیوتری 5 کیوبیتی توسعه دادند که میتواست مطابق با الگوریتم شور فاکتورهای عدد 15 را محاسبه کند.

در سال 2017 شرکت «مایکروسافت» (Microsoft) با معرفی و ارائه زبان برنامهنویسی جدید به اسم Q#، کیت کاملی برای توسعه برنامههای کاربردی کوانتومی توسعه داد. در همین سال شرکت D-Wave با معرفی کامپیوتر کوانتومی D-Wave 2000Q که شامل 2048 کیوبیت و بر اساس فیزیک ابررساناها کار میکرد، معرفی کرد.

در میان سالهای 2000 تا به امروز تحقیقات گستردهای در این زمینه در حال انجام است که تنها به بخش کوچکی از آنها در فوق اشاره کردیم. با وجود این پیشرفتها، همچنان مشکلات زیادی بر سر راه کامپیوترهای کوانتومی وجود دارد. به نظر شما ممکن است روزی فرا رسد که در کامپیوتر خانگی خود با اندازه و شرایط محیطی معمولی یک تراشهای کوانتومی داشته باشید و یا در حال اجزای یک بازی ویدئویی در کامپیوتر کوانتومی باشید!؟

اگر این مطلب برای شما مفید بوده است، آموزشهای زیر نیز به شما پیشنهاد میشوند:

- مجموعه آموزشهای فیزیک

- آموزش مروری مکانیک کوانتومی ۲

- مجموعه آموزشهای دروس علوم و مهندسی کامپیوتر

- آموزش معماری کامپیوتر با رویکرد حل مساله – پیشرفته

- سیستمهای باینری به زبان ساده – بخش اول: اعداد باینری

- منطق دیجیتال — از صفر تا صد

- گرافن چیست؟ -- به زبان ساده

^^

از طریق چه رشته هایی میتوان وارد این حوزه شد ؟

زمانی که سیستم عامل داس ساخته شده حداکثر حافظه ای که توان مدیریت اون رو داشته فکر میکنم ۱۶ مگابایت بوده یعنی سازنده اون با خودش فکر میکرده امکان نداره برنامه ای ساخته بشه که از ۱۶ مگ بیشتر نیاز داشته باشه.من خودم زمان دبیرستان با سیستم عامل داس کار میکردم.بعدش کم کم شاهد کامپیوترها و سی پی یو ها و سیستم عامل های قوی تر شدیم.یادمه یک زمانی یک استادی داشتیم میگفت دیگه قدرت سی پی یو ها به آخرش رسیده و از این بیشتر نمیشه.اما حالا باید شاهد پردازنده های کوانتومی باشیم.بسیار هم عالی.نمیشه از الان گفت در اینده این پردازنده ها جایگزین پردازنده های معمولی رو نگیره و یا حتی تکنولوژی بالاتر از این نیاد.انسان ذاتا کنجکاو آفریده شده و روز به روز حقایق این زمین خاکی رو بیشتر کشف میکنه.تا قرن ۲۱ درک و فهم انسان به این حد رسیده.واقعا آدمهای قرون آینده به چه درک و فهمی نسبت به این زمین خاکی خواهند رسید.خیلی جالبه.ما اون زمان کجا هستیم.

نظر من در مورد کوانتوم یا کامپیوترهای کوانتومی نیست ولی سالهاست در مورد این موضوعی که عنوان میکنم فکر کردم ، هر انسانی امواج صوتی صدایش با انسانی دیگر تفاوت دارد در آینده میتوان بدون تلفن همراه و از طریق فرستنده و گیرنده امواج صوتی را رد وبدل کرد به نظر شما امکان دارد

دوستان این نکته رو در نظر داشته باشید که لازم نیست این کامپیوتر ها در خانه افراد باشند . فقط کافیه شما یه گیرنده و نمایشگر داشته باشید و از نرم افزار ها و بازی ها بصورت ابری و برخط استفاده کنید و یعنی کیس داخل شرکت هست و بازی یا نرم افزار روش اجرا میشه و شما خروجی رو دریافت میکنید .واقعا منتظر اون روز هستم .چقدر رندر سه یعدی راحت میشه خدا میدونه .عالیه

وقتی میگن علم یعنی قدرت یعنی همین. دیگه هیچ رمزی روی سیستمی معنی نمیده. مسلما نسل جدید نرم افزارهای طراحی شده توسط کوانتوم خیلی متفاوت تر از نرم افزارهای امروزیست. کوانتوم فلسفه ی زندگی و حتی کل زندگی بشر رو تغییر میده.

کامپیوتر ساخته شده توسط Dwave کوانتومیه؟

پس چرا اغلب شرکت ها می گن تا ساخت کامپیوتر کوانتومی هنوز فاصله داریم؟

من فکر نکنم اینا رو به مردم عادی بفرشن. چرا؟ چون اگه دست یه ادم دیوونه بیفته میتون در عرض چند دقیقه کل سیستم موشک های اتمی دنیا رو هک کنه و همرو به کشتن بده حتی خودش رو

چرا این مقاله تاریخ نداره؟!

باسلام. اول اینکه اقای دکتر هم دانشگاهی و هم رشته ای بنده هستند. خوشبختم جناب دکتر.

مطلب بسیار جامع و خوب نوشته شده. میخواستم 1 موضوعی رو اضافه کنم. میشه اینجوری هم عنوان کرد که یکی از دلایل اصلی این موج اشتیاق به سمت پردازنده های کوانتومی دغدغه هوش مصنوعی و پیاده سازی شبکه های عصبی به صورت سخت افزاری هست.نرون های عصبی، سیناپس ها و دندریت ها در حال حاضر به شکل شدیدی معلول به عملکرد و سرعت ترانزیستورهای cmosهستند و برای همین که بحث یادگیری عمیق به شکل محسوسی ناکارآمد هست. تولد مدارهای کوانتومی در اینده ای نزدیک با مدل های Neuromorphic ادغام خواهند شد و احتمالا ما به مغزافزار عصبگون با حالت فازی الکترودینامیک طبیعی نزدیک خواهیم شد که احتمالا جهشی بزرگ در دنیای هوش مصنوعی خواهد بود.

به همین دلیل هست که کمپانی های که در زمینه AI پیشگام هستند به صورت موازی روی بحث رایانش کوانتمی هم تمرکز کردند مثل IBM, Google, ماکروسافت و اینتل.

سلام، وقت شما بخیر؛

تاریخ آخرین به روز رسانی کلیه مقالات مجله فرادرس در زیر عنوان آنها ذکر شده است.

از همراهی شما سپاسگزاریم.

چطوری میشه ساخت اینو

ابزار و وسایلش زیر مقاله ذکر شده یه نگاه بندازی دستت میاد

جدای از شوخی ساخت این سیستم ها به قدری پیچیده هست که وقتی یه شرکتی فقط چند کیوبیت به کامپیوترش اضافه میکنه برتری کوانتمی محسوب میشه

در کل علوم خیلی زیادی دست به دست هم دادن

بسیار عالی و کاربردی بود

خیلی جذاب بود

نوشته هم بسیار ساده و شیوا بود

خدا خیرتون بده

ممنون خيلي خوب بود. يک سوال داشتم. تکنولوژي ساخت کامپيوترهاي کوانتومي چيست؟ ترانزيستور؟

بنده خدا دوساعت داشت میگفت اینا فرق دارن با گیت های معمولی بعد میگی ترانزیستور ?

ممنون خیلی خوب بود

بهترین مقاله ای بود که تا الان خوندم عالی بود عالی

سپاس