پردازش کلان داده در پایتون – راهنمای جامع

اگر کاربران با دنیای علم و فناوری آشنایی داشته باشند، بدون شک با واژگان و اصطلاحاتی نظیر «علم داده» (Data Science)، «علم تجزیه و تحلیل» (Analytics Science)، «یادگیری ماشین» (Machine Learning)، «کلان داده» (Big Data) مواردی مشابه برخورد داشتهاند. در دنیای فناوری امروز، از این اصطلاحات برای تعریف مجموعهای از فناوریهای مهم و پیشرفته حوزه در «علوم کامپیوتر» (Computer Science) استفاده میشود که پایه و اساس پیشرفتهای فناوری در آینده نیز به شمار میآیند. در این مطلب، با مهمترین ابزارهای علم داده جهت پردازش کلان داده آشنا خواهید. همچنین، مثالهای ساده و عملی جهت پردازش کلان داده نمایش داده خواهند شد. علاوه بر این، استفاده از «زبان برنامهنویسی پایتون» (Python Programming language) برای تحلیل داده آموزش داده خواهد شد (از این دسته از تکنیکها در مقیاس وسیعتر، جهت پردازش کلان داده نیز استفاده میشود).

علم داده یکی از حوزههای گسترده علوم کامپیوتر محسوب میشود و زیر شاخههای گستردهای نظیر «جمعآوری داده» (Data Collection)، «پاکسازی داده» (Data Cleaning)، «استاندارد سازی داده» (Data Standardization)، «تحلیل داده» (Data Analysis) و «گزارش» (Reporting) را شامل میشود. بزرگترین شرکتهای حوزه فناوری، از تکنیکهای علم داده و پردازش کلان داده برای استخراج دانش از «دادههای غیر ساخت یافته» (Unstructured Data) و «دادههای ساخت یافته» (Structured Data) سازمانی استفاده میکنند.

پردازش کلان داده

تحلیل و پردازش کلان داده هم اکنون به یکی از ترندهای تحقیقاتی در دنیا تبدیل شده است. به همین خاطر است که فرصتهای شغلی بسیار خوبی، برای برنامهنویسان و توسعهدهندگانی که با تکنیکهای پردازش کلان داده آشنایی دارند، فراهم شده است. یک دانشمند علم داده و یا یک برنامهنویس مسلط به پردازش کلان داده و تحلیل آن میتواند از مجموعه ابزارهای تولید شده برای پردازش کلان داده، جهت «تحلیل زبان» (Language Analysis)، «پیشنهاد فایلهای ویدئویی» (Recommending Videos) و یا مشخص کردن محصولات جدید با توجه به دادههای بازاریابی یا دادههای جمعآوری شده از مشتریان استفاده کند.

به طور کلی، زمانی که تکنیکهای موجود در حوزه پردازش کلان داده در علم داده مورد بررسی قرار میگیرند، منظور تکنیکهایی هستند که در حوزه خاصی به نام «علم داده در مقیاس وسیع» (large Scale Data Science) استفاده میشوند. تعریف کلمه کلان در اصطلاح پردازش کلان داده، به نوع پروژههای برنامهنویسی پردازش داده یا حجم دادههایی که قرار است پردازش و تحلیل شوند، بستگی دارد.

بسیاری از مسائل تحلیل داده، که برای حل آنها پروژههای برنامهنویسی تعریف میشود، توسط راهکارهای «مرسوم» (Conventional) و متدهای یادگیری ماشین به راحتی قابل حل هستند. به عبارت دیگر، زمانی که دادههای استفاده شده برای مدلسازی یا آموزش مدل یادگیری، به اندازهای باشند که بتوان از سیستمهای محاسباتی معمول نظیر کامپیوترهای شخصی برای پردازش آنها استفاده کرد، معمولا نیازی به استفاده از روشهای پردازش کلان داده وجود نخواهد داشت. با این حال، این امکان وجود دارد که بتوان از روشهای تحلیل و پردازش کلان داده برای حل مسائل تحلیل داده استفاده کرد. به طور کلی، زمانی از تکنیکهای پردازش کلان داده برای حل مسئله استفاده میشود که نیاز به پردازش حجم عظیمی از دادهها وجود دارد و سیستمهای محاسباتی مرسوم، توان پردازشی لازم برای تحلیل و پردازش کلان داده را نداشته باشند.

مهمترین ابزارهای پردازش کلان داده

یکی از مهمترین مدلهای ذخیرهسازی توزیع شده دادهها و پردازش کلان داده، که به وفور توسط دانشمندان علم داده مورد استفاده قرار میگیرد، مدل برنامهنویسی به نام «نگاشت-کاهش» (MapReduce) است. مدل MapReduce، روشی بهینه برای مدیریت و پردازش کلان داده محسوب میشود که به دانشمندان علم داده و توسعهدهنده برنامه کاربردی اجازه میدهد تا ابتدا داده را با استفاده از یک «صفت» (Attribute)، فیلتر یا دستهبندی خاص نگاشت کنند و سپس، با استفاده از یک مکانیزم «تبدیل» (Transformation) یا «تجمیع» (Aggregation)، دادههای نگاشت شده را کاهش دهند.

به عنوان نمونه، در صورتی که دادههای جمعاوری شده مرتبط با مجموعهای از گربهها باشند، ابتدا گربهها با استفاده از صفتی نظیر رنگ آنها نگاشت میشوند. در مرحله بعد، دادهها، از طریق جمع کردن گروهبندیهای انجام شده، کاهش پیدا میکنند. در پایان فرایند MapReduce، یک لیست یا مجموعهای مرتبط با رنگ گربهها و تعداد گربههای موجود در هر کدام از گروهبندیهای رنگی در اختیار برنامهنویس یا دانشمند داده قرار میدهد.

تقریبا تمامی کتابخانههای برنامهنویسی توسعه داده شده برای مقاصد پردازش کلان داده و علم داده، از مدل برنامهنویسی MapReduce پشتیبانی میکنند. همچنین، تعداد زیادی کتابخانه برنامهنویسی وجود دارند که امکان مدیریت، پردازش و انجام عملیات «نگاشت-کاهش» (MapReduce) دادهها را به شکل توزیع شده (خوشه یا مجموعهای از کامپیوترهای ) در اختیار برنامهنویسان و فعالان حوزه علم داده قرار میدهند. افرادی که به دنبال استفاده از مدلهای MapReduce، جهت مدیریت و پردازش کلان داده هستند، به راحتی میتوانند از ابزارها، بستهها و کتابخانههای توسعه داده شده در زبان پایتون، جهت پیادهسازی کاربردهای مرتبط با پردازش کلان داده استفاده کنند.

کتابخانه Hadoop

یکی از محبوبترین کتابخانهها برای انجام عملیات «نگاشت-کاهش» (MapReduce) روی دادههای حجیم، کتابخانه هدوپ است که توسط بنیاد نرمافزاری Apache طراحی شده است. کتابخانه هدوپ با استفاده از «محاسبات خوشهای» (Cluster Computing)، به فعالان حوزه علم داده اجازه میدهد تا بتوانند تا با سرعت و اثرگذاری به مراتب بیشتری، وظایف مرتبط با مدیریت و پردازش کلان داده را انجام دهند. کتابخانهها و بستههای زیادی در زبان پایتون توسعه داده شدهاند که از طریق آنها میتوان دادهها (که به آنها Jobs نیز گفته میشود) را به هدوپ ارسال کرد. انتخاب یکی از این کتابخانهها و بستههای برنامهنویسی جهت مقاصد پردازش کلان داده و علم داده، به عواملی نظیر سادگی استفاده، زیرساختهای لازم برای پیادهسازی و کاربرد خاصی که قرار است در آن مورد استفاده قرار بگیرند، بستگی دارد.

کتابخانه Spark

در صورتی که در کاربرد پردازش کلان داده مورد نظر برنامهنویس و یا دانشمند علم داده، استفاده از دادههایی که در قالب «دادههای جریانی» (Streaming Data) هستند (نظیر دادههای «بلادرنگ» (Real-Time)، دادههای Log و دادههای جمعآوری شده از «واسطهای برنامهنویسی کاربردی» (Application Programming Interface))، عملکرد به مراتب بهتری را برای سیستم به ارمغان میآورند، استفاده از کتابخانه Spark بهترین گزینه خواهد بود. کتابخانه Spark، نظیر کتابخانه هدوپ، توسط بنیاد نرمافزاری Apache توسعه داده شده است.

پایتون و پردازش کلان داده

سؤالی که ممکن در اینجا ذهن خوانندگان و مخاطبان این مطلب را به خود مشغول کند این است که زبان پایتون، جهت پردازش کلان داده و تحلیل آن، چه امکاناتی را در اختیار برنامهنویس یا «دانشمند علم داده» (Data Scientist) قرار میدهد. در چند سال اخیر، پایتون به عنوان یکی از مهمترین ابزارهای دانشمندان علم داده برای برنامهنویسی پروژههای علم داده مطرح شده است؛ تحلیل و پردازش کلان داده هم از این قاعده مستثنی نیست.

اگرچه، بسیاری از دانشمندان علم داده و برنامهنویسان فعال در این حوزه، از زبانهای برنامهنویسی نظیر جاوا، R و Julia و ابزارهایی مانند SPSS و SAS برای تحلیل داده و استخراج «بینش» (Insight) از آنها استفاده میکنند، با این حال، محبوبیت روزافزون زبان پایتون، «کتابخانههای برنامهنویسی» (Libraries) متنوع و پرکاربرد و جامعه برنامهنویسی پویا و فعال آن، سبب شده است تا بسیاری از دانشمندان علم داده، از زبان پایتون برای تحلیل دادهها و پردازش کلان داده استفاده کنند. افزایش روزافزون محبوبیت پایتون برای مقاصد علم داده را میتوان در رشد چشمگیر کتابخانهها، ابزارها و بستههای برنامهنویسی در حوزه علم داده مشاهده کرد.

زبان پایتون، در چند سال اخیر، همواره به عنوان یکی از محبوبترین زبانهای برنامهنویسی شناخته شده است. بسیاری از فرصتهای شغلی لیست شده برای زبان پایتون نیز مرتبط با حوزه علم داده، تحلیل داده، پردازش کلان داده و «هوش مصنوعی» (Artificial Intelligence) هستند. به همین دلیل است که بسیاری از «مهندسان داده» (Data Engineers) به استفاده از پایتون و تسلط بر این زبان برنامهنویسی روی میآورند.

یکی از مهمترین ابزارهای پردازش کلان داده برای دانشمندان داده، کتابخانهای به نام «هدوپ» (Hadoop) است. ابزارهای نرمافزاری منبع باز هدوپ، در ابتدا توسط «بنیاد نرمافزاری آپاچی» (Apache Software Foundation) و با هدف ارائه بستر نرمافزاری لازم برای محاسبات توزیع شده و پردازش کلان داده، در زبان برنامهنویسی جاوا تهیه شدهاند. این دسته از ابزارهای نرمافزاری به برنامهنویسان و توسعهدهندگان اجازه میدهند تا با استفاده از شبکهای متشکل از چندین کامپیوتر (به شکل «توزیع شده» (Distributed)) اقدام به حل مسائلی کنند که حجم عظیمی از داده و محاسبات را شامل میشوند. جهت پردازش کلان داده و تحلیل آنها، هدوپ، چارچوبی نرمافزاری برای ذخیرهسازی توزیع شده و پردازش کلان داده معرفی میکند؛ این چارچوب نرمافزاری بر پایه مدل برنامهنویسی «نگاشت-کاهش» (MapReduce) پیادهسازی شده است.

دو دلیل عمده برای محبوبیت بیش از پیش زبان پایتون، جهت برنامهنویسی علم داده و پردازش کلان داده، وجود دارد:

- کتابخانهها، ابزارها و بستههای برنامهنویسی بسیار قدرتمند و پرکاربردی برای پردازش، ذخیرهسازی، نمایش، شکل دادن و مصورسازی دادهها در زبان برنامهنویسی پایتون ارائه شده است (در ادامه، این ابزارها شرح داده خواهند شد).

- پس از افزایش روزافزون محبوبیت پایتون و روی آوردن تعداد زیادی از برنامهنویسان و توسعهدهندگان حوزه علم داده به این زبان برنامهنویسی، بنیاد نرمافزاری آپاچی به سرعت امکان استفاده از «اکوسیستم» (Ecosystem) هدوپ را برای دانشمندان علم داده و برنامهنویسان این حوزه فراهم آورد. هماکنون برنامهنویسان زبان پایتون و دانشمندان علم داده مسلط به این زبان میتوانند از ابزارهایی نظیر « استریمینگ هدوپ» (Hadoop Streaming)، افزونه Hadoopy، کتابخانه Pydoop و بسته Pydoop اشاره کرد.

استفاده از هدوپ (Hadoop) در پایتون به جای جاوا

یکی از سؤالاتی که ممکن است هنگام استفاده از هدوپ در پایتون (جهت پردازش کلان داده و تحلیل آنها) برای فعالان حوزه علم داده پدید بیاید این است که چرا لازم است از پایتون به جای جاوا، برای پردازش کلان داده و تحلیل آن استفاده شود. در پاسخ به این سؤال باید گفت که اگرچه زبان جاوا هنوز هم یکی از محبوبترین و پرکاربردترین زبانهای برنامهنویسی در جهان و زبان اصلی توسعه چارچوب هدوپ (و Spark) محسوب میشود، با این حال، میان برخی از ویژگیهای ساختاری این دو زبان تفاوتهایی وجود دارد که ممکن است سبب روی آوردن فعالان این حوزه به استفاده از پایتون شود. از جمله این تفاوتها میتوان به موارد زیر اشاره کرد:

- نصب، پیادهسازی و اجرای محیط برنامهنویسی جاوا (Java Development Environment) نسبت به زبان پایتون سختتر است (تنظیم کردن تنظیمات مرتبط با «متغیرهای محیطی» (Environment Variables)، تنظیمات فایلهای XML مرتبط با وابستگیهای نرمافزاری و سایر موارد). در نقطه مقابل، برای نصب، پیادهسازی و اجرای محیط برنامهنویسی پایتون، تنها کافی است پایتون را روی سیستم نصب و از واسط خط دستوری آن جهت کد نویسی استفاده کرد.

- در محیط برنامهنویسی جاوا، ابتدا باید کدهای نوشته شده «کامپایل» (Compile) و سپس اجرا شوند. در حالی که در زبان پایتون، تنها کافی است کدها توسط برنامهنویس نوشته و سپس خط به خط در واسط خط دستوری اجرا شوند.

- تعداد خط کدهای لازم برای نوشتن یک برنامه خاص در زبان جاوا، به مراتب بیشتر از تعداد خط کدهای لازم برای توسعه همان برنامه در زبان پایتون خواهد بود. به عنوان نمونه، به مثال زیر دقت کنید. در ادامه، تعداد خط کدهای لازم برای شمارش تعداد دفعات تکرار کلمات با استفاده از زبان جاوا و پایتون نمایش داده شده است. اولین قدم جهت پردازش کلان داده در فرم دادههای متنی غیر ساخت یافته، شمارش تعداد دفعات تکرار کلمات ظاهر شده در این دادهها است:

شمارش تعداد دفعات تکرار کلمات با استفاده از زبان جاوا:

شمارش تعداد دفعات تکرار کلمات با استفاده از زبان پایتون:

همانطور که مشاهده میشود، برنامهای که نوشتن آن در زبان جاوا به 57 خط کد احتیاج است، در زبان پایتون، تنها با 15 خط کد قابل نوشتن است. این ویژگی سبب میشود تا «نگهداری» (Maintain) کدها در زبان پایتون به مراتب راحتتر از زبان جاوا باشد.

کتابخانههای مدیریت و پردازش داده در پایتون

همانطور که پیش از این نیز اشاره شد، کتابخانهها، ابزارها و بستههای برنامهنویسی بسیار قدرتمند و پرکاربردی برای پردازش، ذخیرهسازی، نمایش، شکل دادن و مصورسازی دادهها در زبان برنامهنویسی پایتون ارائه شده است. از جمله مهمترین کتابخانههای مدیریت و پردازش داده در پایتون میتوان به موارد زیر اشاره کرد:

کتابخانه Pandas

یکی از محبوبترین کتابخانههای ارائه شده برای مقاصد علم داده، کتابخانه Pandas است. کتابخانه Pandas توسط دانشمندان علم دادهای که به زبانهای برنامهنویسی R و پایتون مسلط هستند، توسعه داده شده است. هم اکنون جامعه بسیار بزرگی از برنامهنویسان و توسعهدهندگان (متشکل از دانشمندان علم داده و تحلیلگران داده) از کتابخانه Pandas و فرایند توسعه آن (برطرف کردن مشکلات احتمالی و اضافه کردن قابلیتهای برنامهنویسی جدید) پشتیبانی میکنند.

کتابخانه Pandas ویژگیهای تعبیه شده بسیار مهم و پرکاربردی نظیر قابلیت خواندن دادهها از منابع مختلف، ساختن «دیتا فریم» (Dataframe) یا ماتریس/جدول متناظر با دادههای خوانده شده و محاسبه «تجزیه و تحلیل تجمیعی» (Aggregate Analytics) بر اساس نوع برنامه کاربردی در حال توسعه را برای برنامهنویسان و توسعهدهندگان فراهم میآورد.

علاوه بر امکانات تعبیه شده برای مدیریت و پردازش داده، کتابخانه Pandas از امکانات «مصورسازی داده» (Data Visualization) بسیار مناسبی نیز بهره میبرد. با استفاده از قابلیتهای مصورسازی تعبیه شده در این کتابخانه، امکان تولید گراف و نمودار از نتایج تولید شده برای برنامهنویسان و دانشمندان علم داده فراهم شده است. همچنین، مجموعهای از توابع داخلی در کتابخانه Pandas تعریف شدهاند که امکان «صادر کردن» (Export) تجزیه و تحلیلهای انجام شده روی دادهها را در قالب فایل «صفحات گسترده اکسل» (Excel Spreadsheet) فراهم میآورند.

کتابخانه Agate

یکی از کتابخانههای برنامهنویسی نوظهور برای مقاصد علم داده، کتابخانه Agate نام دارد. کتابخانه Agate با هدف استفاده در کاربردهای «روزنامهنگاری» (Journalism) پیادهسازی شده است و ویژگیهای بسیار مناسبی جهت تحلیل دادهها در اختیار برنامهنویسان و توسعهدهندگان قرار میدهد. از این کتابخانه میتوان جهت تحلیل و مقایسه فایلهای صفحه گسترده (Spreadsheet)، انجام محاسبات آماری رو دادهها و سایر موارد استفاده کرد.

یادگیری کار کردن با کتابخانه Agate بسیار ساده است و وابستگیهای به مراتب کمتری نسبت به Pandas دارد. همچنین، ویژگیهای جالبی نظیر مصورسازی دادهها و تولید نمودار، این کتابخانه را به ابزاری محبوب برای مقاصد تحلیل داده تبدیل کرده است.

کتابخانه Bokeh

در صورتی که تمایل به مصورسازی دادههای موجود در یک مجموعه داده ساخت یافته دارید، Bokeh ابزار بسیار مناسبی محسوب میشود. این ابزار را میتوان با کتابخانههای تحلیل داده نظیر Pandas ،Agate و سایر موارد مورد استفاده قرار داد. این ابزار، به برنامهنویسان و توسعهدهندگان اجازه میدهد تا با کمترین کد نویسی، نمودارهای گرافیکی و مصورسازیهای خیره کنندهای از دادهها تولید کنند.

کاوش، پردازش و تحلیل دادهها در پایتون با استفاده از کتابخانه Pandas

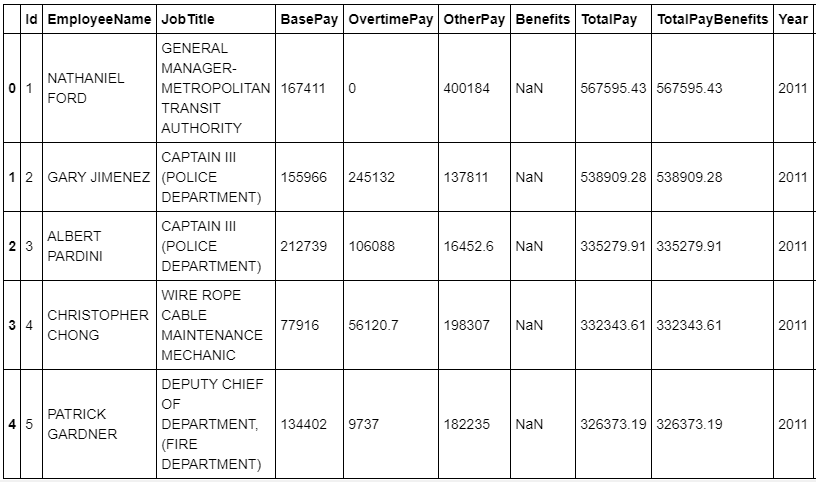

پیش از این که با ابزارهای پردازش کلان داده در پایتون آشنا شویم، با یک مثال ساده، نحوه تحلیل دادهها در پایتون مورد بررسی قرار میگیرد. پس از جستجو در سایت Kaggle، مجموعه داده حقوق کارکنان دولتی شهر سانفرانسیسکو برای این کار انتخاب شد. این مجموعه داده از طریق لینک [+] قابل دسترسی است.

ابتدا با استفاده از قطعه کد زیر دادهها وارد (Import) و در یک دیتا فریم Pandas خوانده میشوند.

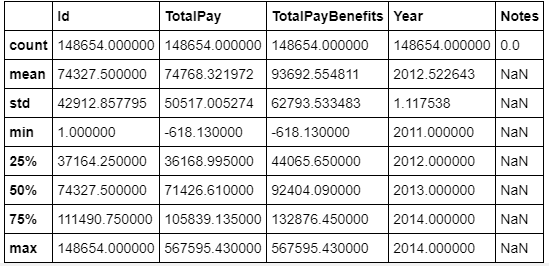

سپس، با استفاده از تابع describe، توزیع دادههای موجود در مجموعه داده نمایش داده میشود.

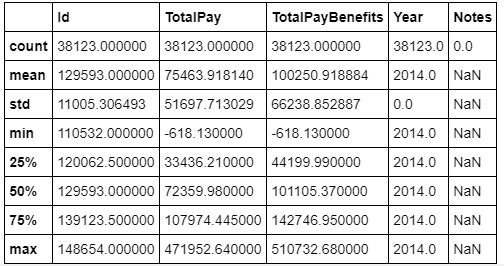

دادههای جمعآوری شده، مربوط به سالهای متعددی است. برای محدودتر کردن حوزه تحلیلی انجام شده از دادهها، تنها دادههای مربوط به سال 2014 مورد بررسی قرار گرفته میشوند.

سپس، در این مرحله از فرایند تحلیل داده، مقدار درصد متوسطی از حقوق سالیانه که کارمندان دولتی برای پرداخت اجاره خانه استفاده میکنند، بررسی میشود.

0.61698360153365217

بنابراین، همانطور که در خروجی نمایش داده شده مشخص است، کارمندان دولتی در سانفرانسیسکو، به طور متوسط چیزی حدود 60 درصد از حقوق خود را صرف پرداخت اجاره بها میکنند. در مرحله بعد، تعداد کارمندانی که حقوق آنها از متوسط اجاره بهای منزل در این شهر کمتر است مشخص میشود.

11360

همانطور که در خروجی نمایش داده شده مشخص است، بیش از 11 هزار کارمند دولتی در سانفرانسیسکو، درآمد کمتر از متوسط اجاره بهای منزل دارند. در مرحله بعدی، تعداد کارمندانی که باید اضافه کار داشته باشند تا بتوانند از حقوق لازم برای پرداخت اجاره بها برخوردار شوند، نمایش داده میشود. برای اینکار، تمامی کسانی که بیش از 70 درصد حقوق خود را برای اجاره بها پرداخت میکنند، به عنوان افرادی در نظر گرفته میشوند که بدون اضافه کاری قادر به پرداخت اجاره بها نیستند.

count 38119.000000 mean 66564.421924 std 44053.783972 min 0.000000 25% NaN 50% NaN 75% NaN max 318835.490000 Name: BasePay, dtype: float64

20074

بنابراین، بیش از 20 هزار کارمند دولتی بدون اضافه کاری قادر به پرداخت اجاره بها و هزینه زندگی در شهر سانفرانسیکو نخواهند بود. در مرحله بعد، با استفاده از تحلیل دادههای موجود، تعداد کارمندانی مشخص میشود که باید بیش از 1000 دلار در سال اضافه کاری داشته باشند تا بتوانند به زندگی خود در این شهر ادامه دهند.

count 38119.000000 mean 5401.993737 std 11769.656257 min 0.000000 25% NaN 50% NaN 75% NaN max 173547.730000 Name: OvertimePay, dtype: float64

15361

بنابراین، همانطور که در خروجی نمایش داده شده مشخص است، بیش از 15 هزار کارمند دولتی، با اضافه کاری بیش از 1000 دلار در سال، قادر به زندگی در این شهر پرخرج هستند. این دسته از تحلیلهای انجام شده روی مجموعه داده انتخابی، تنها بخشی از کارهای قابل انجام توسط کتابخانههای پردازش و تحلیل داده در پایتون هستند. بنابراین، همانطور که مشاهده میشود، پایتون یکی از بهترین و سادهترین زبانها برای تحلیل داده به شمار میآید و امکانات کاملی برای کاوش، پردازش و تحلیل داده در اختیار برنامهنویسان و دانشمندان علم داده قرار میدهد.

کتابخانههای پردازش کلان داده در پایتون

زبان برنامهنویسی پایتون و جامعه برنامهنویسی فعال آن، ابزارها و کتابخانههای متنوعی برای پردازش کلان داده در اختیار برنامهنویسان و دانشمندان علم داده قرار داده است. این ابزارها، مبتنی بر کتابخانه هدوپ و Spark هستند. از جمله، مهمترین ابزارهای پردازش کلان داده در پایتون میتواند به موارد زیر اشاره کرد:

کتابخانه PySpark

کتابخانه PySpark که واسط برنامهنویسی کاربردی Spark در زبان پایتون محسوب میشود، به دانشمندان علم داده و برنامهنویسان فعال در این حوزه اجازه میدهد تا به سرعت، زیرساختهای لازم برای نگاشت و کاهش مجموعههای داده را پیادهسازی کنند. همچنین، از آنجایی که در کتابخانه Spark مجموعهای از الگوریتمهای یادگیری ماشین تعبیه شده است، علاوه بر پردازش کلان داده و مدیریت آنها، جهت حل مسائل یادگیری ماشین نیز مورد استفاده قرار میگیرد.

ابزار جریانسازی یا Streaming

ابزار جریانسازی هدوپ یا Hadoop Streaming، یکی از مجبوبترین روشهای استفاده از Hadoop در پایتون محسوب میشود. جریانسازی یا Streaming، یکی از ویژگیهای تعبیه شده در کتابخانه Hadoop است. این ویژگی به برنامهنویس اجازه میدهد تا کدهای نوشته به زبان پایتون (و یا دیگر زبانهای برنامهنویسی) را جهت انجام عملیات نگاشت (Mapping) به تابع stdin پاس بدهند (به عنوان آرگومان، به این تابع ارسال کنند). به عبارت دیگر، توسعهدهندگان از جاوا به عنوان Wrapper استفاده میکنند تا بتوانند کدهای پایتون را به تابع stdin پاس بدهند. سپس، در زمان اجرا، عملیات نگاشت (Mapping) در زبان جاوا و توسط کتابخانه Hadoop انجام میشود.

افزونه Hadoopy

این ابزار، افزونهای برای جریانسازی هدوپ یا Hadoop Streaming محسوب میشود و از کتابخانه Cython برای انجام عملیات نگاشت-کاهش (MapReduce) در پایتون استفاده میکند. مستندسازی خوبی برای این ابزار انجام شده است و کار کردن با آن برای توسعهدهندگان راحت است. با این حال، این پروژه از پایان سال 2012 تا به امروز غیر فعال باقی مانده و بهروزرسانی جدیدی دریافت نکرده است.

بسته Pydoop

این بسته برنامهنویسی به توسعهدهندگان اجازه میدهد تا بتوانند برنامه مرتبط با پردازش کلان داده را در پایتون کد نویسی کنند. سپس، با استفاده از کدهای پیادهسازی شده، به طور مستقیم با دادههای ذخیره شده در خوشه هدوپ (Hadoop Cluster) ارتباط برقرار کرده و عملیات نگاشت-کاهش (MapReduce) انجام دهند. چنین کاری از طریق واسط برنامهنویسی کاربردی HDFS (یا HDFS API) تعبیه شده در بسته Pydoop امکانپذیر شده است. واسط برنامهنویسی کاربردی HDFS به برنامهنویسان اجازه میدهد تا در محیط پایتون، عملیات خواندن و نوشتن دادهها، از معماری فایل سیستم HDFS را انجام دهند.

کتابخانه MRJob

یک کتابخانه برنامهنویسی در زبان پایتون است که امکان انجام عملیات نگاشت-کاهش (MapReduce) و پردازش کلان داده را در اختیار برنامهنویسان و دانشمندان علم داده قرار میدهد. این کتابخانه نرمافزاری، یکی از پراستفادهترین بستههای برنامهنویسی جهت پردازش کلان داده در زبان پایتون محسوب میشود و توسط شرکت Yelp در اختیار برنامهنویسان زبان پایتون قرار گرفته است.

کتابخانه MRJob، از هدوپ، سرویس Cloud Dataproc گوگل و سرویس Elastic MapReduce یا EMR شرکت آمازون نیز پشتیبانی میکند. سرویس EMR، یک وب سرویس ارائه شده توسط شرکت آمازون است که امکان تحلیل و پردازش کلان داده با استفاده از هدوپ و Spark را در اختیار فعالان حوزه علم داده قرار میدهد. مستندسازی خوبی برای این کتابخانه انجام شده است و کار کردن با آن برای توسعهدهندگان و برنامهنویسان راحت است. همچنین، این پروژه کاملا فعال است و از پیادهسازیهای مختلف آن پشتیبانی میشود.

اجرای کدهای پایتون در هدوپ (Hadoop) با استفاده از کتابخانه MRJob

در این مثال، یک برنامه ساده برای محاسبه دفعات ظاهر شدن تمامی کلمات در متن، در زبان پایتون کد نویسی خواهد شد. سپس، با استفاده از هدوپ (Hadoop)، این قابلیت پدید میآید تا هر نوع داده متنی (با هر اندازه ممکن و در هر قالبی)، مورد تجزیه و تحلیل قرار بگیرد و تعداد دفعات ظاهر شدن تمامی کلمات موجود در آن محاسبه شود. برای چنین کاری، باید یک خوشه هدوپ در سیستم اجرایی باشد. برای اجرای کدهای پایتون در هدوپ (Hadoop) با استفاده از کتابخانه MRJob، لازم است مراحل زیر دنبال شود:

- ابتدا با استفاده از Pip، کتابخانه MRJob در پایتون نصب میشود.

- برنامه شمارش کلمات در متن: برای چنین کاری، در یک برنامه دلخواه ویرایشگر کد، از کدهای زیر استفاده کنید (یک فایل خالی و کدهای زی را در آن کپی کنید). سپس، فایل مورد نظر را با نام word-count.py ذخیره کنید.

کدهای لازم محاسبه دفعات ظاهر شدن تمامی کلمات در متن با استفاده از MRJob (ابزار Hadoop):

- اجرای کدهای پایتون در هدوپ (Hadoop) با استفاده از کتابخانه MRJob: پس از اینکه کد نویسی برنامه شمارش تعداد دفعات ظاهر شدن کلمات در متن به پایان رسید، در مرحله بعد لازم است تا کدهای پایتون برای هدوپ (hadoop) ارسال و اجرا شوند. برای این کار از کد دستوری زیر استفاده میشود:

کدهای کامل پیادهسازی سیستم پردازش دادههای متنی با استفاده از کتابخانه MRJob، در لینک [+] موجود است (در این پروژه، از تکنیکهای پردازش کلان داده، مدل برنامهنویسی MapReduce و کتابخانههای Spark و Hadoop استفاده شده است). در ادامه، تعدادی مثال مرتبط با پردازش دادههای متنی با استفاده از کتابخانه MRJob نمایش داده شده است. ذکر این نکته ضروری است که برای اطمینان از صحت عملکرد کدهای ارائه شده، تمامی ماژولهای تعریف شده در در لینک [+]، باید توسط برنامه کاربردی قابل دسترس باشند.

محاسبه دفعات ظاهر شدن تمامی کلماتی که حاوی حرف u هستند، با استفاده از MRJob (ابزار Hadoop):

محاسبه تعداد کلمات موجود در یک متن با استفاده از Pyspark:

مشخص کردن کلمات پر استفاده در یک داده متنی ورودی با استفاده از MRJob (ابزار Hadoop):

مشخص کردن کلمات پر استفاده در یک داده متنی ورودی با استفاده از MRJob (ابزار spark):

دستهبندی دادههای متنی با استفاده از MRJob (ابزار Hadoop):

برنامه نگاشت شمارههای تلفن به آدرسهای URL با استفاده از از MRJob (ابزار Hadoop):

مثالهای ارائه شده تنها بخش کوچکی از قابلیتهای ابزارهایی نظیر هدوپ (Hadoop) و Spark هستند. این دسته از مدلهای برنامهنویسی، علاوه بر اینکه امکان ذخیرهسازی و پردازش توزیع شده دادههای مختلف را به برنامهنویسان و دانشمندان داده میدهند، قابلیت مدیریت و پردازش کلان داده را برای سیستم فراهم میکنند.

اگر نوشته بالا برای شما مفید بوده است، آموزشهای زیر نیز به شما پیشنهاد میشوند:

- مجموعه آموزشهای داده کاوی و یادگیری ماشین

- آموزش اصول و روشهای داده کاوی (Data Mining)

- مجموعه آموزشهای هوش مصنوعی

- آموزش مقدماتی Hadoop (هدوپ) برای تجزیه و تحلیل کلان داده

- مفاهیم کلان داده (Big Data) و انواع تحلیل داده — راهنمای جامع

- کلان داده یا مِه داده (Big Data) — از صفر تا صد

^^