آنالیز تشخیصی خطی (LDA) در پایتون – راهنمای کاربردی

تحلیل یا «آنالیز تشخیصی خطی» (Linear Discriminant Analysis - LDA) یک روش آماری برای کاهش ابعاد یک مسئله و تشخیص دستهها بوسیله بیشینهسازی نسبت «پراکندگی بین گروهها» (Scatters between groups) به «درون گروهها» (Scatters within groups) است. رویکرد آنالیز تشخیصی خطی در واقع مشابه و وام گرفته از روشی است که «رونالد فیشر» (Ronald Fisher) برای تعیین میزان افتراق بین گروهها به کار برد و مبنایی برای تحلیل واریانس گردید. به همین دلیل گاهی به این تحلیل، «آنالیز افتراقی خطی» نیز میگویند.

در دیگر نوشته فرادرس با عنوان تحلیل تشخیص خطی فیشر (Fisher’s Linear Discriminant) — پیاده سازی در پایتون با نحوه عملکرد این تکنیک آماری آشنا شدهاید. در این نوشتار به بررسی گونه دیگری از تحلیل تشخیصی میپردازیم. البته به منظور پیادهسازی محاسبات و اجرای الگوریتمها از زبان برنامهنویسی پایتون استفاده خواهیم کرد. در نتیجه در طول این نوشتار با کدهایی از این زبان برخورد خواهیم داشت که برای روشن شدن نقش دستورات و شیوه اجرای الگوریتم توضیحاتی نیز ارائه خواهد شد.

از آنجایی که آنالیز یا تحلیل تشخیصی خطی، الهام گرفته از یکی دیگر از تکنیکهای آماری یعنی «تحلیل واریانس» (Analysis of Variance) است، خواندن مطلب تحلیل واریانس (Anova) — مفاهیم و کاربردها و تحلیل مولفه اساسی (PCA) — راهنمای عملی به همراه کد نویسی در پایتون و R به عنوان پیشنیاز این مطلب ضروری به نظر میرسد. همچنین خواندن مطلب احتمال پسین (Posterior Probability) و احتمال پیشین (Prior Probability) — به زبان ساده و تابع درستنمایی (Likelihood Function) و کاربردهای آن — به زبان ساده و بردار ویژه و مقدار ویژه — از صفر تا صد نیز خالی از لطف نیست.

آنالیز تشخیصی خطی (LDA)

هدف از انجام آنالیز تشخیص خطی، پیدا کردن یک «تصویر» (Projection) یا «تبدیل» (Transformation) است، که از این به بعد به آن میگوییم، روی مجموعه داده بطوری که بتواند نسبت «پراکندگی بین گروهها» (Between Class) را به «پراکندگی درون گروهها» (Within Class) دادههای تبدیل شده، حداکثر کند.

در این صورت اگر ماتریس را مجموعه دادههای اولیه بُعدی در نظر بگیریم، هدف از اجرای تحلیل یا آنالیز تشخیص خطی، پیدا کردن بردار یا ماتریس است که بتواند نسبت یاد شده را برای دادههای تبدیل یافته یعنی بیشینه کند. این تبدیل یا تصویر در رابطه زیر دیده میشود.

از آنجایی که این تبدیل به صورت ترکیب خطی از سطرهای ماتریس نوشته میشود، این روش را «آنالیز تشخیصی خطی» (Linear Discriminant Analysis) مینامند. به این ترتیب به نظر میرسد که در هر بُعد از ماتریس ، که با نشان داده خواهد شد، به دنبال تبدیلی یا در واقع مضربی مانند بردار هستیم. به این ترتیب تبدیل حاصل که بوسیله عبارت نشان داده میشود، یک ترکیب خطی از است، به شکلی که دارای بیشینه مقدار واریانس بین گروهها نسبت به واریانس درون گروه را دارا است. از جهتی میتوان تکنیک LDA را به مانند روش «تحلیل مولفههای اصلی» (Principal Component Analysis - PCA) در نظر گرفت با این تفاوت که هدف از انجام تحلیل LDA پیدا کردن تبدیلی است که بیشترین تمایز را بین گروهها ایجاد کند در حالیکه هدف از PCA فقط کاهش بعد مسئله و ایجاد استقلال بین مولفهها است.

در ادامه به منظور آشنایی با نحوه انجام LDA، مفاهیم آماری و ریاضی مربوط به LDA را مرور میکنیم. هر چند این مفاهیم بیشتر جنبه ریاضی دارند ولی کاربردهای زیادی در ایجاد مدلهای آماری و بخصوص در یادگیری ماشین برای آنها بوجود آمده است، بطوری که امروزه بیشتر «تحلیلگرهای داده» (Data Scientist) باید از نحوه اجرا و پیادهسازی آن در نرمافزارها و زبانهای برنامهنویسی آگاهی داشته باشند تا قادر به حل مسئلههای شوند که دارای پارامتر یا متغیرهای زیادی هستند.

مفاهیم آماری مرتبط با تحلیل تشخیصی خطی

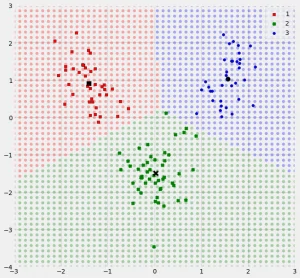

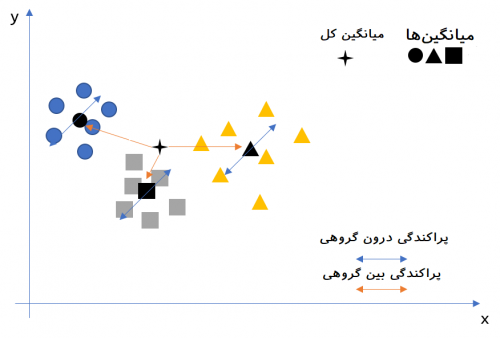

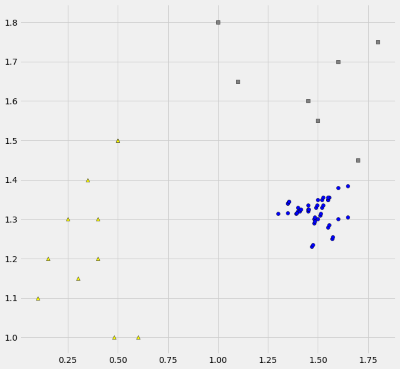

برای اینکه بیشتر و بهتر با مفاهیم و موضوع پراکندگی درون گروهی و بین گروهی آشنا شویم از تصویر زیر استفاده میکنیم و براساس آن، فرمولها و شیوه محاسبات مربوط به اندازهگیری پراکندگی درون گروهی با نماد و بین گروهی با نماد را معرفی خواهیم کرد.

1- پراکندگی درون گروهی ()

فرض کنید که مقدار مربوط به مشاهدات با و مرکز گروه نیز با نشان داده شده باشد. آنگاه نحوه محاسبه مطابق با رابطه زیر است.

مشخص است که در اینجا منظور از در تصویر بالا، دستههای دایرههای آبی، مربعهای خاکستری و مثلثهای زرد هستند. همچنین نیز بردار مشاهدات را در هر کلاس یا گروه نشان میدهند. همانطور که در تصویر مشخص است مشاهدات دارای دو بُعد هستند به همین علت برای نمایش نقاط مربوط به مشاهدات از مختصات دو بُعدی دکارتی استفاده کردهایم که مولفه اول روی محور افقی و مولفه دوم نیز در محور عمودی قابل مشاهده و اندازهگیری است به این ترتیب نقاط دارای دو بُعد هستند.

این موضوع را هم در نظر بگیرید که میانگین این نقاط دو بُعدی برای گروه با مشخص شده است که آن هم یک مقدار دو بُعدی است. به این ترتیب اگر ۱۵ مشاهده از گروه یک موجود باشد، یک ماتریس است که دارای ۲ ردیف و ۱۵ ستون است و به صورت نقطه تشکیل میشود که میانگین بروی مولفه اول و میانگین روی مولفه دوم است. در نتیجه آن را یک بردار میتوان در نظر گرفت که دارای دو سطر و یک ستون است. به این ترتیب تفاضل آنها یعنی یک ماتریس خواهد بود که ۱۵ ستون و ۲ سطر دارد. واضح است که در رابطه بالا منظور از نیز ترانهاده بردار تفضلهای است. در نتیجه قرار است حاصل ضریب یک ماتریس در یک ماتریس بدست آید که حاصل یک ماتریس خواهد بود.

از آنجایی هدف بیشینهسازی نسبت پراکندگی بین گروهی به درون گروهی است، به نظر میرسد که مقدار پراکندگی درون گروهی باید تا حد ممکن کاهش یابد تا نسبت مذکور به حداکثر مقدار خود برسد. به این ترتیب گروههای متجانس و همشکل ایجاد خواهد شد که دارای پراکندگی کوچکی خواهند بود در نتیجه مجموع پراکندگیهای درون گروهی برای همه دستهها کوچکترین مقدار را خواهد داشت. بنابراین گروههای آبی، زرد و خاکستری به نظر بهترین تفکیک برای دادهها خواهند بود.

همانطور که گفته شد ماتریس مقدارها یا از نقاط مربوط به مشاهدات و ابعادشان ساخته میشود. در این صورت یک ماتریس را برای دادههای دو بُعدی مثال ما ایجاد خواهد کرد. بنابراین با جمع مقدارهای این ماتریسها برای همه دسته یا گروهها خواهیم داشت:

نکته: توجه داشته باشید که در این محاسبات ماتریس کوواریانس بدست نیامده است، بلکه فقط مجموع پراکندگیهای درون گروهی حاصل شده و در قسمتهای بعدی برای تجزیه پراکندگی کل استفاده خواهد شد. این کار درست به شکلی است که جدول تحلیل واریانس ساخته میشود.

پیادهسازی محاسبات در پایتون

به منظور محاسبه این ماتریسها و بدست آوردن و از کدهای پایتون استفاده خواهیم کرد. ابتدا به محاسبه خواهیم پرداخت. البته مطابق با تصویر قبلی، سه گروه از دستههای دایره، مربع و مثلث با رنگهای یاد شده ایجاد کردهایم و با توجه به مختصات دو بُعدی آنها، ماتریس پراکندگی درون گروهی را بدست آوردهایم. دادههای به کار رفته در درون کد قرار دارند و محاسبات براساس آنها صورت گرفته است.

توجه داشته باشید که در این کد، مقدارها به صورت زیر طبق سه ماتریس برای «مستطیلها» (Rectangles)، «مثلثها» (Triangles) و «دایرهها» (Circles) مشخص شدهاند. مقدارهای این ماتریسها در ادامه دیده میشود.

همانطور که در قبل گفته شد، حاصل اجرای کد فوق یک ماتریس دو بعدی خواهد بود که پراکندگی بین گروهی را نشان داده و نمودار نقطهها را هم رسم خواهد کرد. همانطور که انتظار داشتیم، نقاط از یکدیگر به خوبی تفکیکپذیر هستند. حال باید ببینیم که تکنیک LDA چگونه آنها را تشخیص میدهد.

۲- پراکندگی بین گروهی ()

همانطور که قبلا مشاهده کردیم، صورت کسری که باید بیشینه شود، برحسب نوشته شده است. به منظور محاسبه پراکندگی بین گروهی از رابطه زیر استفاده خواهیم کرد. به یاد دارید که در این حالت، در هر بار بررسی بیشینه بودن نسبت، مخرج ثابت در نظر گرفته میشود.

در نتیجه میانگین گروهها تغییر نخواهد کرد. ولی هر گاه گروهبندی تغییری داشته باشد، مراکز نیز تغییر کرده و مخرج کسر متفاوت خواهد بود.

مشخص است که در این رابطه فاصله بین مراکز گروهها یا دستهها نسبت به مرکز یا میانگین کلی () اندازهگیری شده است بطوری که در مثال ما و ماتریسهای هستند یعنی دو سطر و یک ستون دارند. در نتیجه حاصل ضریب عبارتهای یک ماتریس خواهد بود. همچنین باید توجه داشت که تعداد اعضای هر گروه یا دسته را نشان میدهد.

فرض کنید که پراکندگی کلی برای مشاهدات به صورت نامگذاری شده باشد. با توجه به مفهوم پراکندگی برحسب مربعات فاصله، خواهیم داشت:

در این حالت رابطه زیر بین پراکندگی درون گروهی و بین گروهی با پراکندگی کل وجود دارد.

زیرا با توجه به فرمول زیر به راحتی میتوان رابطه بالا را اثبات کرد.

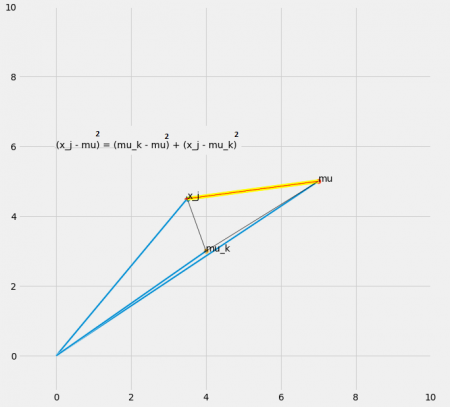

بوسیله کدی که در ادامه قابل مشاهده است، رابطه بالا به خوبی نمایش داده شده است. این کد نموداری را برای یک نقطه مشخص کرده است که خط قرمز ترسیم شده، رابطه سمت چپ یعنی فاصله نقطه از میانگین کل را نشان میدهد. خط زرد رنگ نیز سمت راست معادله بالا را بیان میکند. از آنجایی که این مقدارها همگی به صورت مربع هستند، همانطور که دیده میشود براساس قاعده فیثاغورس، این دو خط با یکدیگر مساوی هستند. البته اثبات این مطلب نیز در ادامه و بعد از تصویر قابل مشاهده است.

به منظور اثبات رابطه قبل، هنگام محاسبه مقداری را اضافه و کم میکنیم تا در مقدار پراکندگی کلی تغییری بوجود نیاید.

در رابطه آخر به علت اینکه جمع، روی مقدارهای بسته شده ولی داخل عبارت به آن بستگی ندارد، به صورت نوشته شده است. به این ترتیب کافی است پراکندگی کلی و پراکندگی درون گروهی را محاسبه کنیم و پراکندگی بین گروهها را براساس رابطهای که بینشان برقرار است بدست آوریم.

بیشینهسازی نسبت

همانطور که قبلا اشاره شد، به دنبال ترکیبی خطی از مشاهدات هستیم که براساس آن بتوانیم نسبت را برای دادههای جدید و تبدیل یافته، بیشینه کنیم. البته مشخص است که دادههای تبدیل یافته، دارای بُعد کمتری نسبت به دادههای اصلی هستند. به این ترتیب به نوع کاهش بُعد در حل مسئله نیز رسیدهایم و با توجه به دادههایی با بُعد کمتر که در رابطه زیر تشکیل میشوند، میتوانیم تشخیص بهتری برای دسته یا گروهها ایجاد کنیم.

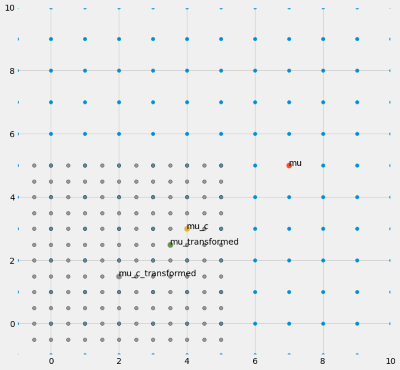

از آنجایی که این تبدیل (ضرب) توسط بردار یا ماتریس روی همه نقطهها اثر میکند، میانگین گروه و میانگین کل نیز که به صورت و هستند نیز تحت تاثیر قرار میگیرند. این تغییرات و تبدیلات توسط تصویری که براساس کد زیر ایجاد شده است، به خوبی دیده میشوند.

اسامی mu ،mu_c به ترتیب میانگین و میانگین گروه c بوده و mu_transformed و mu_c_transformed نیز بیانگر میانگین و میانگین همان گروه با توجه به تبدیل فرضی هستند. همانطور که در کد میبینید ماتریس تبدیل به صورت دلخواه انتخاب شده و به شکل زیر نوشته شده است. یعنی این تبدیل، طول و عرض هر نقطه را نصف میکند.

مطابق کد بالا دادههای مربوط به data به صورت زیر خواهد بود که مشخص است که ماتریس با ۲ سطر و 12 ستون است.

عناصر یا ستونهای سطر اول در ابتدا و عناصر یا ستونهای سطر دوم نیز در انتهای کادر بالا دیده میشوند. حال به بررسی نتیجه تبدیل میپردازیم. ماتریس تبدیل یافته به شکل زیر خواهد بود.

نمودار دادهها اصلی و تبدیل شده به همراه میانگینها در تصویر زیر قابل مشاهده است. البته تعداد ابعاد در اینجا کاهش نیافته است ولی مشخص است دادهها جابجا شدهاند.

با اعمال ماتریس تبدیل میزان پراکندگی درون گروهی مطابق رابطه زیر محاسبه خواهد شد.

از طرفی شیوه محاسبه پراکندگی بین گروهی نیز تغییر کرده و به شکل زیر درخواهد آمد.

به این ترتیب نسبت پراکندگی بین گروهی به درون گروهی به شکل زیر نوشته و محاسبه میشود.

به منظور بیشینهکردن این کسر میتوان صورت کسر را حداکثر کرده و مخرج را ثابت در نظر گرفت. این قید را در محاسبات مدل لحاظ کرده و آن را به صورت زیر در میآوریم.

به این ترتیب رابطه زیر را میتوان نوشت.

این حالت معادله را فرم لاگرانژی با پارامتر مینامند، که قید در مدل نیز ظاهر شده است. برای حل این مسئله از روال معمول یعنی مشتقگیری و پیدا کردن نقاط اکسترمم استفاده میشود. در نتیجه رابطه زیر را برحسب مشتق خواهیم نوشت.

توجه داشته باشید که این معادله به صورت ماتریسی یا برداری است. در نتیجه این مشتق با بردار صفر برابر خواهد بود. به این ترتیب مقدار برحسب بدست خواهد آمد.

جوابهای این معادله دقیقا همان فرم مقدارهای ویژه و بردارهای ویژه است. با شرط وجود داشتن معکوس ماتریس در این حالت خواهیم داشت:

جوابهای این معادله، مقدارهای ویژه () و بردارهای ویژه () برای ماتریس هستند که بوسیله تابع (numpy.linalg.eig(a در زبان برنامهنویسی پایتون قابل محاسبهاند.

نکته: البته برای محاسبه به روش دستی کافی است که را محاسبه کرده و را بدست آوریم. با جایگذاری این مقدار در رابطه دستگاه معادلات خطی و بردارهای ویژه حاصل میشود. به این ترتیب بردار ویژه برای هر بعد ایجاد میشود. به این ترتیب امکان محاسبه دادههای تبدیل یافته بوجود آمده و ماتریس حاصل و تحلیل LDA صورت خواهد گرفت. از آنجایی که انجام این محاسبات توسط Numpy قابل انجام است، کد زیر را آورده و کل فرآیند انجام محاسبات برای LDA را بازنویسی کردهایم. گامهایی که در این کد دنبال شده است به قرار زیر هستند.

- استاندارد کردن دادهها به صورتی که میانگین آنها صفر و واریانس برابر با ۱ باشد. این عمل توسط محاسبه مقدارهای z برای آنها مقدور است. دستور standardScaler در کتابخانه sklearn.preprocessing برای انجام این کار مناسب است.

- محاسبه میانگین کل و میانگین برای هر گروه. این کار درون یک حلقه تکرار صورت گرفته است.

- محاسبه و . برای انجام این محاسبات، از ضرب داخلی np.dot استفاده شده است.

- محاسبه بردار و مقدارهای ویژه به منظور پیدا کردن که نسبت را حداکثر کند. مقدار و بردارهای ویژه توسط دستور np.linalg.eig حاصل میشود.

- انتخاب k مقدار ویژهای که از بقیه مقدارهای ویژه بزرگتر هستند. با این کار میتوانیم ماتریس دادهها را از به تقلیل دهیم. مشخص است که ماتریس در این حالت دارای ابعاد خواهد بود. ستونهای این ماتریس همان بردار ویژه هستند. معمولا با توجه به حساسیت مسئله مقدار k را از ۲ تا ۵ انتخاب میکنند. البته انتخاب مناسب برای این پارامتر میتواند توسط اعتبار سنجی متقابل نیز انجام شود.

- استفاده از ماتریس به منظور تبدیل دادهها و کاهش بعد و محاسبه .

استفاده از آنالیز LDA روی دادههای واقعی

مجموعه دادههای با نام vingar.txt دارای ۱۳ متغیر کمی و البته یک متغیر کیفی یا طبقهای است که مشاهدات را به سه گروه تقسیم میکند. میتوانید این فایل را از اینجا دریافت کنید.

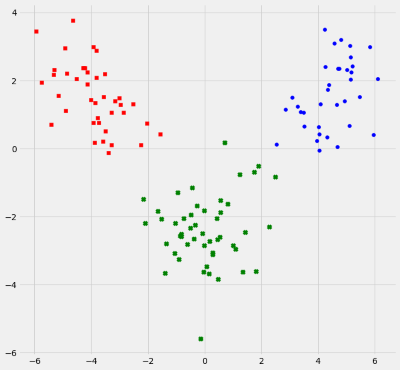

میخواهیم به کمک آنالیز LDA این دادهها را به بهترین وجه به سه گروه تقسیم کرده و به جای استفاده از ۱۳ متغیر، به کمک تبدیل ، فقط از دادههایی با دو بُعد برای انجام این کار، بهره ببریم. کد زیر به این علت تهیه شده است.

توجه داشته باشید که در اینجا ۳۰٪ دادهها برای آزمایش استفاده شده است و ۷۰٪ آنها برای آموزش مدل به کار رفته است. خروجی مطابق با تصویر زیر خواهد بود. البته ابتدا توضیحاتی نیز توسط مفسر کد پایتون ظاهر میشود.

همانطور که در نمودار دیده میشود، سه گروه مجزا از یکدیگر توسط دو بعد تشکیل شده است. هر کدام از اعضای واقعی گروهها با علامت مربع، دایره و ضربدر مشخص شدهاند و نواحی مربوط به هر گروه که توسط LDA مشخص شده نیز با رنگهای قرمز و آبی و سبز دیده میشود.

آنالیز تشخیصی خطی با sklearn

برای اجرای آنالیز تشخیصی خطی در پایتون میتوانید از کتابخانه sklearn نیز استفاده کنید. روش ارائه دادهها در اینجا درست به مانند قبل است ولی میتوان با کدهای کمتری مدل آنالیز تشخیصی خطی را اجرا کرد.

باز هم در این قسمت دادهها به دو گروه آموزشی (Train) و آزمایشی (Test) تقسیم شدهاند. توجه داشته باشید که قبلا از اجرای این برنامه، فایل اطلاعاتی را بارگذاری کرده و آدرس محل آن را در قسمت pd.read_csv برنامه مشخص کنید.

همانطور که میبینید نتیجه با این روش نیز درست به مانند قبل است. برای اجرای برنامه و یا کدهای پایتون میتوانید از نرمافزارهای مختلف در محیط وب یا روی رایانه شخصی خود استفاده کنید. اگر میخواهید بدون نصب هیچ برنامهای، در محیط وب کدهای پایتون را اجرا کنید از سایت بنیاد پایتون وارد پوسته اجرای پایتون شوید و کدهایتان را اجرا کنید. همچنین برای نصب مفسر پایتون در رایانه شخصی شاید استفاده از Canopy گزینه مناسبی باشد.

اگر مطلب بالا برای شما مفید بوده است، آموزشهای زیر نیز به شما پیشنهاد میشوند:

- مجموعه آموزشهای بهینه سازی چند هدفه

- مجموعه آموزشهای آمار، احتمالات و دادهکاوی

- گنجینه آموزش های محاسبات هوشمند

- احتمال شرطی (Conditional Probability) — اصول و شیوه محاسبه

- تحلیل تشخیص خطی فیشر (Fisher’s Linear Discriminant) — پیاده سازی در پایتون

- تحلیل واریانس (Anova) — مفاهیم و کاربردها

^^