فرآیند گاوسی برای نمونه کوچک – پیاده سازی در پایتون

امروزه بحث «مِهداده» یا «کلان داده» (Big Data) و تجزیه و تحلیل آنها در همه حوزهها، شنیده میشود. ولی گاهی لازم است که با دادههای محدود و حتی معدود (Little Data) دست به تجزیه و تحلیل آماری بزنیم. در این نوشتار به بررسی مدلهای ناپارامتری در مقابل روشهای پارامتری خواهیم پرداخت و «فرآیند گاوسی پیشگو» (Gaussian Process Regressor) را برای استنباط آماری و تجزیه و تحلیل به کار میبریم. این مقاله برای کسانی که به عنوان تحلیلگر دادهها مشغول به کار هستند مفید خواهد بود. همچنین به منظور انجام محاسبات و رسم نمودارها از زبان برنامهنویسی پایتون استفاده کردهایم که امروزه به عنوان ابزار سودمند برنامهنویسی در همه جا کاربرد دارد.

برای آشنایی با توزیع گاوسی (نرمال) بهتر است مطلب توزیع نرمال یک و چند متغیره — مفاهیم و کاربردها را مطالعه کنید. همچنین به منظور آگاهی بیشتر در مورد رگرسیون و شیوههای اجرای آن به مطلب رگرسیون خطی — مفهوم و محاسبات به زبان ساده و برای درک بهتر احتمال پسین و پیشین که در این مقاله به آنها اشاره خواهیم کرد، به احتمال پسین (Posterior Probability) و احتمال پیشین (Prior Probability) — به زبان ساده مراجعه کنید. در ضمن خواندن نوشتار رسم نمودار داده ها در پایتون --- راهنمای تخصصی نیز خالی از لطف نیست.

فرآیند گاوسی برای دادههای چند بُعدی

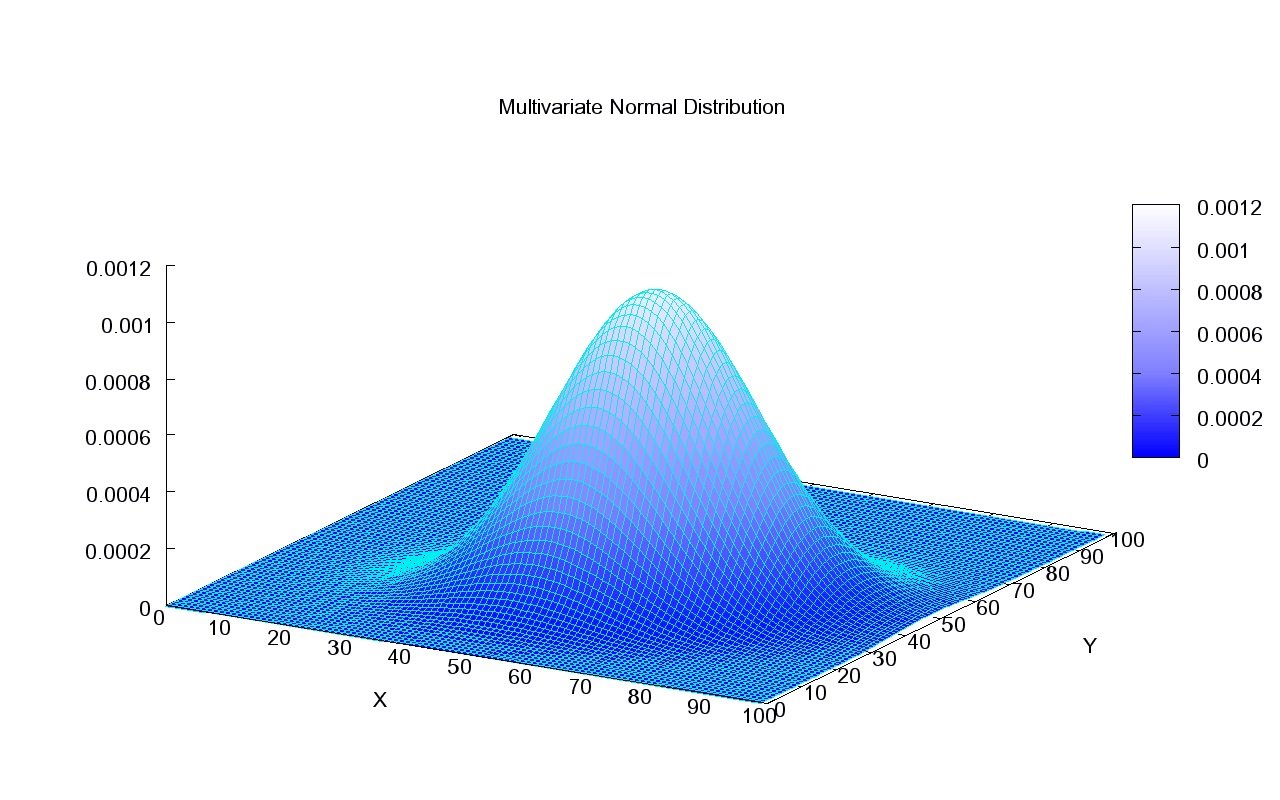

فرآیند گاوسی (Gaussian Process) در تئوری احتمالات، یک فرآیند تصادفی است که به صورت دنبالهای از متغیرهای تصادفی شناخته میشود. در این فرآیند، متغیرهای تصادفی معمولا برحسب مثلا زمان مرتب شدهاند و هر زیر مجموعه متناهی از این متغیرها دارای توزیع گاوسی (نرمال) چند متغیره هستند.

بنابراین اگر یک دنباله تصادفی باشد آنگاه دارای توزیع نرمال (گاوسی) چند متغیره هستند. به بیان دیگر در یک فرآیند گاوسی، هر ترکیبی خطی از مجموعه متناهی از فرآیند دارای توزیع نرمال یک متغیره است. مشخص است که ، مجموعهای نامتناهی از اندیسهای زمان یا مکان است. این فرآیند به علت فعالیت و تلاشهای دانشمند آلمانی «کارل گاوس» (Carl Fridrich Gauss) در این زمینه، به نام او ثبت شده است. برای توصیف بهتر مدل و فرآیند گاوسی به یک مثال خواهیم پرداخت.

فرض کنید به عنوان مربی یک تیم بسکتبال (Basketball Coach) استخدام شدهاید. البته از طرفی متخصص تحلیل دادهها (Data Scientist) نیز هستید. شعار مربیهای بسکتبال در سه دستور کلی خلاصه میشود: کمتر توپ از دست بدهید، بیشتر به حلقه حمله کنید و همکاری تیم در کسب امتیاز را فراموش نکنید.

این گفته را میتوان براساس تحلیل آماری و بهینهسازی به صورت زیر نیز نوشت:

- بُعد اول: باید تعداد پرتابهای آزاد بیشینه (Maximize) شود.

- بُعد دوم: تعداد اشتباهات منجر به از دست دادن توپ کمینه (Minimize) شود.

- خروجی یا تابع هدف: امتیاز در هر بازی بیشینه شود.

مشخص است که بُعد اول و دوم، شامل محدودیتهایی است که بواسطه آنها خروجی یا تابع هدف حاصل میشود. حال به بررسی و مدلسازی امتیازات یک بازیکن خاص (مثلا با نام «استفان کوری» - Steph Curry) برحسب تعداد «اقدام به پرتابهای آزاد» (Free Throws Attempt) و «میزان از دست دادن توپ» (Turnovers) در هر بازی میپردازیم. به این ترتیب به نظر میرسد که با یک فرآیند گاوسی دو بُعدی مواجه هستیم و امتیازات نیز به عنوان متغیر وابسته این فرآیند در نظر گرفته شده است.

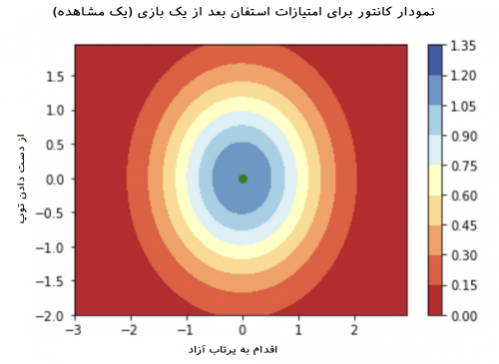

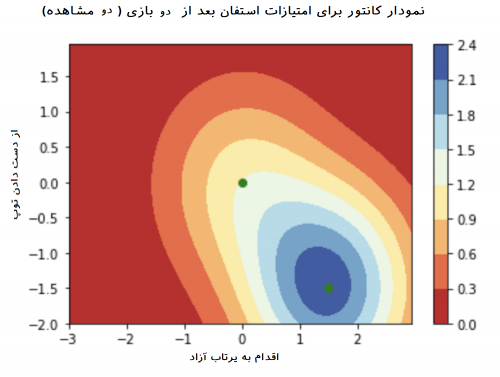

میتوان فرآیند دو بعدی را بر حسب متغیرهای آن توصیف کرد. در بعد اول تعداد پرتابها و در بعد دوم نیز از دست دادن توپ قرار دارد. این متغیرها به عنوان متغیرهای «توصیفگر» (Regressor) در مدل ایجاد شده، نقش خواهند داشت. البته متغیر خروجی نیز که همان امتیاز کسب شده در هر بازی است به عنوان متغیر وابسته در ساختار مدل به کار خواهد رفت. ابتدا اطلاعات حاصل از این متغیرها را به صورت استاندارد در میآوریم بطوری که با محاسبه zscoreها، دادهها دارای میانگین صفر و واریانس ۱ خواهند شد. به همین علت روی محور افقی و عمودی در نمودارهای زیر، مقیاسها در بین ۳- تا ۳+ تغییر میکند (به علت تغییرات کم روی محور عمودی فقط ناحیه بین ۲- تا ۲+ نمایش داده شده است.) این ویژگی را در مقدارهای متغیر هدف یا وابسته نیز میتوان مشاهده کرد.

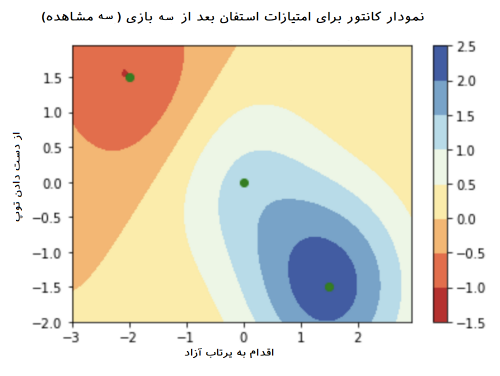

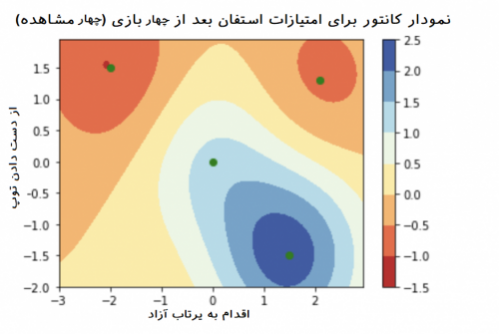

به این ترتیب، تصاویر زیر، توصیفی برای ارتباط بین متغیرهای مستقل و وابسته را براساس «نمودار کانتور» (Contour plot) نمایش میدهند. برای مثال مقدار ۱ در این نمودارها نشانگر اختلاف به میزان یک انحراف معیار از میانگین مسابقات NBA است. نقطه سبز درون نمودارها نیز بیانگر مقدار واقعی مشاهده شده است. به این ترتیب ناحیه آبی رنگ، نشانگر پیشبینی بهتر برای امتیاز توسط متغیرهای پیشگو است. هرچه به ناحیه قرمز رنگ برویم، پیشگویی با انحراف بیشتری همراه است. از طرفی راهنمای نمودار که طیف رنگ از قرمز تا آبی پر رنگ را نشان میدهد، کسب امتیاز او در بازی را به براساس مقدارهای استاندارد شده، نشان میدهد. به منظور تحلیل امتیازات و عملکرد این بازیکن، ابتدا براساس یک بازی، سپس به کمک دو بازی آخر او و سپس براساس سه و چهار بازی اخیر، دست به استنباط و تحلیل میزنیم. انتظار داریم هر چه تعداد بازیها بیشتر میشود، اطلاعات و دادهها نسبت به عملکرد این بازیکن بیشتر و موثرتر شوند.

تحلیل بازی اول: همانطور که دیده می شود این بازیکن در اولین بازی خود به میانگین تعداد پرتابها و از دست دادن توپ بسیار نزدیک است. از طرفی امتیاز کسب شده توسط او کمی بیشتر از استاندارد است. مشخص است که همه برآوردها براساس فقط یک نقطه است در نتیجه به نظر میرسد انحرافی نیز وجود ندارد.

تحلیل بازی دوم: در این قسمت، تعداد پرتابهای آزاد او بیشتر شده و از طرفی هم خطاهای او در از دست دادن توپ کاهش یافته است و امتیازات بیشتری نیز کسب کرده است. تغییرات امتیازات نسبت به بازی اول نیز در نمودار به خوبی دیده میشود. نتایج بازی دوم در قسمت پایین-راست نمودار زیر دیده میشود. نقش نتایج بازی اول در تغییر شکل نمودار کانتور به خوبی دیده میشود. هر چند امتیازات در بازی دوم موثر است ولی مانند نمودار مربوط به بازی اول، پیشبینیها کاملا دقیق نیستند.

تحلیل بازی سوم: در این نمودار، تعداد پرتابهای آزاد بازیکن بستکتبال، کمتر شده و از طرفی هم خطاهای او در از دست دادن توپ نیز افزایش داشته است. بنابراین دیده میشود که امتیازات کسب شده در این مسابقه کاهش داشته است زیرا ناحیه مربوط به این مسابقات با رنگ نارنجی نشان داده شده است. در نتیجه به نظر میرسد که او نسبت به مسابقههای قبلی، افت کرده است. به نظر میرسد که مدلبندی در این حالت برای پیشبینی امتیازات در بازی دوم مناسب است ولی خطای پیشبینی برای امتیاز بازی سوم زیاد است.

تحلیل بازی چهارم: نمودار آخر مربوط به چهار مسابقه آخر است. با توجه به افزایش تعداد پرتابهای آزاد بازیکن، امتیاز کسب شده در مسابقه چهارم افزایش نداشته است زیرا تعداد خطاهای از دست دادن توپ نیز افزایش نشان میدهد. به این ترتیب پیشگویی برای امتیاز حاصل از بازی چهار نیز با خطای زیادی همراه است. همچنین بازی دوم و به شکلی هم بازی اول به خوبی برآورد شده است.

اگر برای بازیهای بعدی نیز نمودارهای کانتور را رسم کنیم خواهیم دید که بین متغیرهای وابسته و مستقل یا توصیفی رابطهای وجود دارد. برای مثال زمانی که بازیکن تعداد خطاهای زیادی دارد حتی اگر پرتابهای آزاد خوبی هم داشته باشد، امتیاز کسب شده برای او از میانگین NBA کمتر خواهد بود. ولی با توجه به نمودارهای ترسیم شده به نظر میرسد که بازیکن ما نسبت به میانگین (مقدار صفر برای امتیازات) از کارایی بیشتری برخوردار است زیرا میانگین امتیازات او از در این چهار مسابقه بیشتر از صفر است.

همانطور که دیده شد، با فرض نرمال (گوسی) بودن دادهها، امتیازات براساس نمودار کانتور در دو بُعد ترسیم شد. برای راحتی کار، کدهای رسم چنین نمودارهایی در ادامه قابل مشاهده است.

مدلسازی فرآیند گاوسی

سوالی که در رابطه با این مثال مطرح میشود، این است که چگونه براساس دادههای مربوط به این چهار بازی، استنباط یا مدلسازی آماری انجام دهیم. در ادامه به شیوهای مدلسازی با روشهای پارامتری مانند تکنیک کمترین مربعات عادی و ناپارامتری مانند فرآین دگاوسی اشاره خواهیم داشت.

مدلها و روشهای پارامتری

یکی از روشهای مدلسازی مرسوم در آمار، استفاده از تکنیک OLS یا کمترین مربعات عادی (Ordinary Least Squares) است. سادگی در انجام محاسبات و تفسیر پذیری این مدل، آن را به عنوان ابزار اصلی تحلیلگرهای داده (Data Scientist) در آورده است. ولی زمانی که تعداد نقاط و مقادیر مشاهده شده از متغیرها، کم باشد، استفاده از این روش، با محدودیتهایی مواجه میشود. انتخاب توزیع نرمال برای خطای مدل از ویژگیهای اصلی روش OLS محسوب میشود. بنابراین اگر حجم دادهها کم باشد، نمیتوانیم از قضیه حد مرکزی یا قانون ضعیف اعداد بزرگ استفاده کنیم و توزیع خطا را نرمال فرض کنیم.

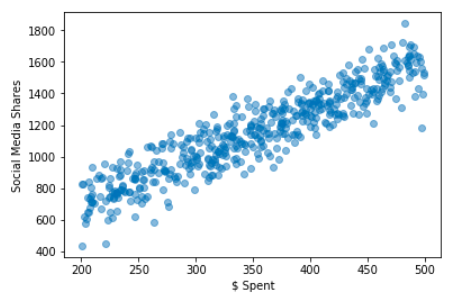

برای مثال فرض کنید که میخواهیم ارتباط بین میزان هزینه تبلیغات (Spent $) و سهم بازدیدهای مطالب در یک شبکههای اجتماعی (Social Media Shares) را مورد بررسی قرار دهیم. اگر نمودار مربوط به این دو متغیر یه مانند تصویر زیر باشند به خوبی میتوان برای پیشبینی سهم در شبکههای اجتماعی، بودجه و هزینه را مشخص کرد. به خوبی دیده میشود که با افزایش هزینه تبلیغات، سهم بازدید سایت در میان شبکههای اجتماعی نیز افزایش مییابد.

البته توجه دارید که این نمودار براساس تعداد نقاط زیادی ترسیم شده است. بنابراین پیشبینی توسط این نمودار با دقت و صحت مناسب صورت خواهد گرفت. چنین نموداری را در پایتون میتوان به راحتی ترسیم کرد. کد زیر به این منظور تهیه شده است.

به این ترتیب دیده میشود که با شبیهسازی 500 نقطه از توزیع یکنواخت در فاصله ۲۰۰ تا ۵۰۰ به عنوان هزینه (برحسب دلار) به عنوان متغیر تصادفی به همراه خطای نرمال (متغیر تصادفی ) با میانگین صفر و واریانس ۱، مدل مطابق با رابطه زیر شبیهسازی شده است.

البته این مدل را اغلب به شکل دیگری نیز نشان میدهند. در حالتی که رگرسیون ساده یک متغیره برای مدلسازی مورد نظر باشد، براساس پارامترهای ، میتوان ساختار رابطه بین متغیر وابسته و مستقل را به صورت زیر نوشت.

واضح است که در این مدل همان Bias در کد پایتون است. همچنین نیز همان پارامتر در برنامه نوشته شده محسوب میشود. البته برای به کارگیری چنین مدلهای در تکنیک OLS شرایطی وجود دارد که بخصوص برای حجم دادههای کوچک محقق شدن این شرایط بسیار بعید است. زمانی که مدل به صورت دو جملهای مرتبه ۲ نوشته شود، مدل رگرسیونی به صورت زیر نوشته میشود.

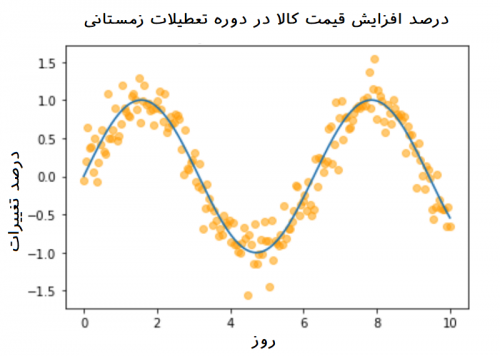

ولی اگر مدل برای دادهها، به صورت غیرخطی (مثلا تابع سینوسی) باشد. نمیتوان از روش OLS استفاده کرد. به عنوان مثال فرض کنید قیمت کالاها در دوره تعطیلات زمستانی (کریسمس) ممکن است از مدل سینوسی پیروی کند. نمودار زیر این حالت را نشان میدهد. در ادامه سعی داریم برای چنین حالتی از فرآیند گاوسی استفاده کرده و مدل مناسب را ارائه دهیم.

مدلها و روشهای ناپارامتری

همانطور که در قسمت قبل اشاره شد، استفاده از تکنیک OLS نیازمند شرایطی که است در همه مواقع قابل بررسی و محقق شدن نیست. به همین دلیل روشهای ناپارامتری ارزشمند و کارا هستند. البته باید توجه داشت که در صورت وجود توزیع نرمال برای خطا، روشهای پارامتری و OLS بسیار بهتر و با خطای بسیار کمتری نسبت به روشهای ناپارامتری عمل میکنند. ویژگیهای روشها و مدلهای ناپارامتری در زیر فهرست شدهاند.

- مدلهای ناپارامتری هیچ فرضی برای توزیع احتمالی جامعه آماری ندارند. برای مثال در تکنیک «نزدیکترین همسایه» - KNN یا (K-Nearest Neighbor) احتیاجی نیست که توزیع جامعه آماری مشخص باشد در حالیکه در شیوه «خوشهبندی k-میانگین» (K-means Clustering) فرض بر این است که دادهها مستقل از یکدیگر و از یک جامعه آماری با توزیع نرمال با واریانس ثابت و یکسان آمدهاند. همچنین در مدل بیز ساده (Naive Bayes) توزیع مزدوج برای مشاهدات، تزویع نرمال در نظر گرفته شده و شرط استقلال نقاط نیز باید وجود داشته باشد.

- پیچیدگی مدلهای ناپارامتری با افزایش تعداد دادهها افزایش مییابد. اگر به جای ۱۰ مشاهده، ۱۰۰۰ مشاهده وجود داشته باشد، استفاده از مدلهای ناپارامتری موردی نخواهد داشت و میتوان از مدلهای پارامتری استفاده کرد. برای مثال فرض کنید که برای «رگرسیون کرنل گاوسی» (Gaussian Kernel Regression)، میانگین مقدار پیشبینی شده برای متغیر وابسته برحسب متغیر مستقل به کمک مشاهدات مطابق با رابطه زیر نوشته شده باشد. واضح است که با افزایش نقاط، محاسبات بیشتری برای کرنل احتیاج است.

حال سوالی که در اینجا مطرح میشود این است که چه زمانی تحلیلگر داده باید از روشهای ناپارامتری استفاده کند؟ شرایط استفاده از تکنیکهای آماری ناپارامتی در زیر فهرست شده است.

- نامعلوم یا نامشخص بودن فضای مقداری برای ویژگیها یا متغیرها.

- محقق نشدن بعضی از شرایط حساس در روشهای پارامتری مانند یکسان بودن واریانس، استقلال و همچنین توزیع نرمال برای باقیمانده در مدل رگرسیون OLS.

- وجود دادههای پرت در مشاهدات بطوری که روشهای ارزیابی مانند «میانگین مربعات خطا» (Mean Square Error - MSE) دچار مشکل در تفسیر نتایج شوند. به این ترتیب تکنیکهایی که از این معیارها استفاده میکنند، مانند گرادیان کاهشی، ناکارآمد خواهند بود.

پیادهسازی فرآیند گاوسی

اگر از توزیع دادهها اطلاع ندارید و میخواهید به مدلسازی بپردازید، شاید یک روش ساده و مستقیم، استفاده از فرآیند گاوسی باشد. در اینجا فرض شده است که هیچ اطلاعاتی در مورد تغییرات و توزیع دادهها نسبت به زمان و پارامترهای توزیعشان نداریم. در چنین حالتی برای شروع، استفاده از «فرآیند گاوسی» (GP) به عنوان یک راه حل اولیه مناسب به نظر میرسد.

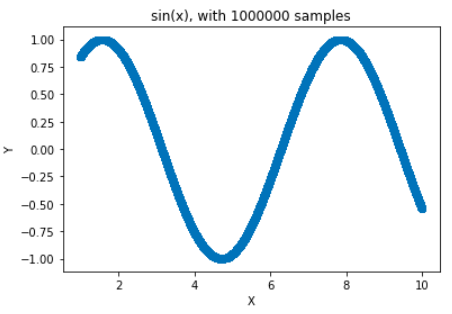

همانطور که در قسمتهای قبلی اشاره شد، فرایند گاوسی دنبالهای از متغیرهای تصادفی است که هر زیر مجموعهای از آنها دارای توزیع گاوسی باشند که توسط میانگین و ماتریس واریانس-کوواریانس قابل تشخیصاند. در دیگر نوشتارهای فرادرس با شیوه ترسیم نمودارهای ریاضی آشنا شدهاید و میدانید که برای نمایش توابع ریاضی با مقادیر حقیقی، باید از بینهایت نقطه استفاده شود. در تصویرهای زیر نمودار تابع به کمک ۱۰ و ۱۰۰۰۰۰۰۰ نقطه ترسیم شده است.

کدی که در ادامه میبینید برای کشیدن این نمودارها در پایتون نوشته شده. مشخص است که ۱ میلیون نقطه در فاصله بین ۱ تا ۱۰ تولید شده و محاسبه تابع سینوس برای این نقطهها صورت گرفته است. در انتهای کد نیز به کمک مختصات دکارتی، نمودار تابع سینوس (Sine) ترسیم شده است.

اساس فرآیند گاوسی در «توزیع حاشیهای» (Marginal Distribution) و «توزیع شرطی» (Conditional Distribution) نهفته است که به کمک دادههای مشاهده نشده از بینهایت متغیر تصادفی (دنباله تصادفی یا فرآیند تصادفی) حاصل میشود. به این ترتیب به کمک مشاهداتی که از زیرمجموعه فرآیند گاوسی حاصل شده است برای پیشبینی و محاسبه توزیع احتمال استفاده میشود. خوشبختانه توزیع حاشیهای و شرطی زیرمجموعه از متغیرهای تصادفی گاوسی، باز هم دارای توزیع نرمال هستند. به این ترتیب روابط زیر را میتوان در نظر گرفت.

رابطه ۱

برطبق قوانین شرطی و توزیع حاشیهای به کمک قضیه بیز نیز میتوان رابطه زیر را استنباط کرد.

رابطه ۲

در رابطه اول، ماتریسهای کوواریانس زیادی وجود دارد. برای مثال واریانس متغیرهای را نشان میدهد. همچنین نیز بیانگر ماتریس کوواریانس بین و است. اگر بین و رابطه خطی برقرار باشد میتوان فرمول زیر را بین متغیر مستقل با متغیر وابسته نوشت.

از طرفی توزیع توام متغیرهای تصادفی و به شکل زیر خواهد بود.

قدم بعدی تبدیل «توزیع توام» (Joint Distribution) به فرآیند گاوسی (GP) است. طبق فرآیند گاوسی باید توزیع توام زیرمجموعهای از این دنباله متغیرهای تصادفی از توزیع گاوسی با میانگین و ماتریس واریانس مشخصی آمده باشد. برای راحتی کار (یا براساس باورهای پیشین) میانگین دادهها را صفر در نظر میگیریم. توجه داشته باشید که ما براساس مشاهداتی که از قبل در مورد متغیر تصادفی داریم سعی در پیشبینی متغیر تصادفی داریم. بنابراین نیازمند ایجاد رابطه یا تابعی مثل هستیم که بتواند این پیشبینی را به صورت یک رابطه ریاضی نشان دهد. این تابع باید به مانند متغیر تصادفی یک توزیع توام نرمال چند متغیره را ایجاد کند.

در این رابطه و به ترتیب متغیرهای توصیفی و خروجی (وابسته) برمبنای «دادههای آموزشی» (Training Set) هستند. همچنین و نیز ویژگیها یا متغیرهای ورود و خروجی هستند که باید پیشبینی شوند. همچنین نیز واریانس خطاها را نشان میدهد. همچنین به توابع که به عنوان کرنل معرفی شدهاند نیز توجه داشته باشید.

فرض کنید که تعداد دادههای آموزشی و نیز «دادههای آزمایشی» (Test Set) باشند. در این صورت یک ماتریس است که کوواریانس بین نقاط آموزشی و آزمایش را بیان میکند. به همین ترتیب ماتریس نیز واریانس مقادیر آزمایشی را در قالب یک ماتریس نمایش میدهد. به منظور سادهتر کردن محاسبات در اینجا از «کرنل پایه شعاعی» (Radial Basis Function Kernel) استفاده میکنیم. این کرنل به صورت زیر نوشته میشود.

البته توجه داشته باشید که در اینجا منظور از مربع فاصله اقلیدسی بین دو بردار و است. کدی که در ادامه مشاهده میکنید این کرنل را به وسیله کتابخانه NumPy در پایتون، پیادهسازی کرده و برای بردار بدست آورده است. این محاسبات به صورت یک کلاس در آمده تا قادر به فراخوانی آن در برنامههای مربوط به قسمتهای دیگر نیز باشیم.

نکته: از آنجایی که احتیاج به یک ماتریس داریم به جای استفاده از تابع np.subtract از np.subtract.outer استفاده کردهایم.

نتیجه اجرای این کرنل روی دادههای برداری به صورت زیر است.

از این به بعد از توزیع نرمال استاندارد (با میانگین صفر و واریانس ۱) به عنوان توزیع پیشین استفاده خواهیم کرد. فرض کنید قرار است یک مقدار تصادفی از متغیر انتخاب شده، مقدار متغیر وابسته () برای آن تعیین شود. در محاسبه زیر تعیین شده است.

نکته: توجه داشته باشید که در اینجا مقدار مشاهده شده برای یک نقطه انتخابی است ولی و مربوط به کل دادههای آموزشی ورودی و خروجی هستند.

تابعی که برای پیشبینی متغیر وابسته به کار میرود، براساس رابطههای قبلی، به صورت زیر نوشته میشود. البته توجه داشته باشید که در این میان، امید ریاضی و ماتریس کوواریانس نیز برآورد شده است.

رابطه ۳

رابطه ۴

به منظور پیادهسازی این محاسبات از کد پایتون زیر استفاده کردهایم تا مقدار پیشبینی شده برای x_new را محاسبه کنیم. واضح است که این مقدار همان میانگین یا امید ریاضی تعریف شده در رابطه بالا است که با نمایش داده شد. به این ترتیب براساس دادههای مشاهده شده (آموزشی) برای مقدار x_new، متغیر وابسته در y_pred محاسبه میشود.

نقطه تمرکز این محاسبات، پیدا کردن y_pred و updated_sigma است. همانطور که در شیوه پیدا کردن مقدار y_pred مشخص است، ماتریس کرنل دارای یک عبارت اضافه به صورت است. این جمله به این علت به کرنل اضافه شده است که گاهی ممکن است این ماتریس معکوسپذیر نباشد، اضافه کردن مقدار ثابت برحسب واریانس به عناصر قطر اصلی آن باعث میشود که ماتریس از حالت «تکین» (Singular) خارج شود. مشخص است که این عمل با ضرب واریانس ثابت (مقداری کمتر از 0.002) در ماتریس یکه () و جمع با ماتریس کرنل صورت گرفته است.

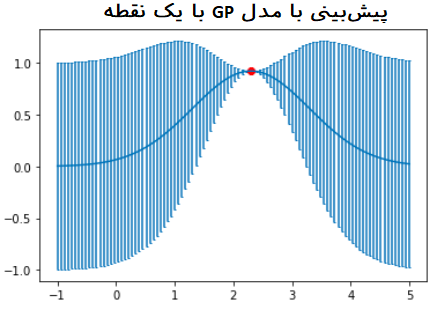

حال فرض کنید به کمک دادههای آموزشی قبلی، میخواهیم برای ۱۰۰ مقدار مختلف پیشیبینی در فاصله ۱- تا ۵ پیدا کنیم در حالیکه فقط یک نقطه () به عنوان نقطه آموزشی داریم.

نموداری که در ادامه قابل مشاهده است، پیشبینیها را با خطوط آبی نشان داده است که همان فرآیند گاوسی است. از طرفی برای هر مقدار پیشبینی شده، نمودار میله خطا (Error bar) نیز براساس انحراف استاندارد رسم شده است. این خطوط نشان میدهند که با دور شدن از نقطه آموزشی، میزان خطای برآورد برای نقاط آزمایشی بیشتر خواهد شد. مشخص است که میانگین توزیع گاوسی همان نقطه آموزشی است که در نمودار با رنگ قرمز نشان داده شده.

حال بهتر است که کدهای تولید شده را به صورت یک class در پایتون درآوریم. این کلاس را به نام GaussianProcess نامگذاری کردهایم. همچنین با استفاده از یک روش ()update امکان به روزآوری محاسبات ماتریس کوواریانس برای مشاهدات جدید بوجود آمده است. درست بعد از محاسبه بهروزآوری (update)، محاسبه ماتریس کوواریانس کرنل K و معکوس آن صورت گرفته است. در قسمتهای بعدی از این کلاس استفاده کرده و محاسبات را پیمیگیریم.

همانطور که در کد مشاهده میکنید، به منظور محاسبه مربع فاصله اقلیدسی از حلقه تکرار استفاده نشده است. در عوض با استفاده از اتحادها میدانیم رابطه زیر برقرار است.

به این ترتیب محاسبه مربع فاصله اقلیدسی در حالت چندگانه به سادگی صورت میگیرد. برای اینکه تفاوت سرعت در انجام محاسبات در حالت عادی و با استفاده از اتحاد ریاضی و شکل برداری را متوجه شوید، کد زیرا را اجرا کنید. در اینجا از کتابخانه scikit-learn برای انجام محاسبات برداری کمک گرفتهایم.

همانطور که در انتها به عنوان خروجی، مشاهده میکنید، زمان انجام محاسبات در حالت حلقه برداری و با استفاده از کتابخانه scikit-learn حدود ۱۰ برابر بیشتر از زمانی است که به صورت حلقه تکرار محاسبات صورت بگیرد. مشخص است که محاسبه ماتریس کوواریانس با ابعاد ۱۰۰ در ۱۰۰ با استفاه از حلقه تکرار حدود 0.120 ثانیه بطول انجامیده در حالیکه همین کار به کمک محاسبات برداری فقط 0.009 ثانیه زمان لازم دارد.

مدلسازی برای تابع سینوس به کمک فرایند گاوسی

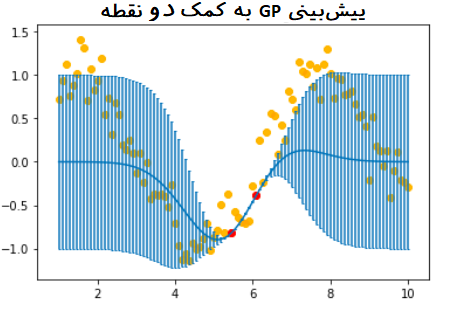

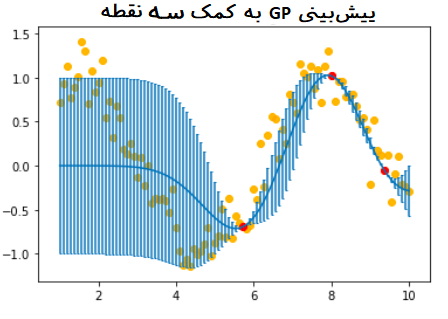

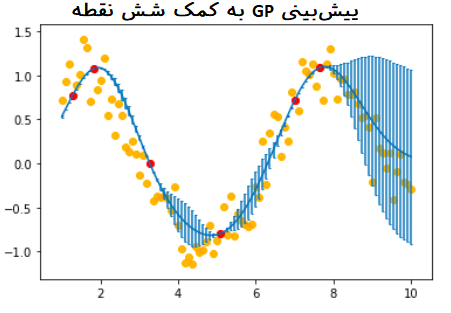

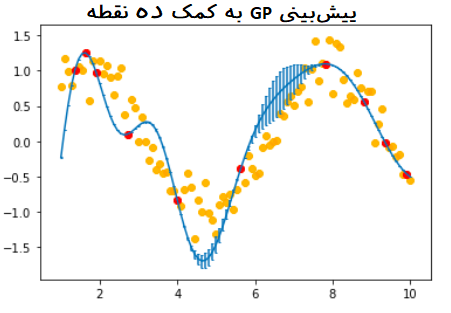

دوباره به مثال مربوط به تابع سینوس باز میگردیم. در این قسمت سعی داریم به کمک توابع و کلاسهایی که تولید کردیم، پیشبینی برای تابع سینوس را به کمک یک فرآیند گاوسی ایجاد کنیم. فرض کنید که فقط ۱۰ مشاهده برای پیشبینی چنین تابعی در اختیار داریم. از میان این نقاط به طور تصادفی، نقطههایی را برای عمل برآورد به کار خواهیم گرفت.

این نقطهها در نمودارهای ترسیم شده به رنگ قرمز هستند. در ضمن عمل برآورد و پیشبینی را طبق مدل گاوسی برای ۱۰۰ نقطه در فاصله ۱ تا ۱۰ به پیش میبریم. در نمودارهای ترسیم شده این نقطهها با رنگ نارنجی نشان داده شدهاند.

واضح است که منحنی آبی رنگ نیز همان برآورد و پیشبینی برای تابع سینوس را نشان میدهد. میلههای خطا نیز در نمودارها دیده میشود.

در آخرین نمودار، زمانی که از همه ۱۰ نقطه آموزشی استفاده شده است، مدل قادر است که پیش بینی مناسبی برای نقاط مربوط به تابع سینوس ارائه دهد. با توجه به کمبود نقاط آموزشی یا فاصله بیشتر بین آنها در بازه ۵ تا ۸، میزان خطا در این ناحیه بیشتر از بقیه نواحی است.

محدودیتهای استفاده از فرآیند گاوسی

هر چند استفاده از فرآیند گاوسی، در بسیاری از موارد امکان پیشبینی مناسب را میدهد ولی باید با محدودیتها و معایب آن نیز آشنا باشیم.

بار محاسباتی در مدلهای فرآیند گاوسی، زیاد است. از طرفی برای بدست آوردن ماتریس کوواریانس حجم زیادی از حافظه اشغال میشود. همانطور که در رابطههای ۳ و ۴ دیده شد، باید معکوس یک ماتریس محاسبه شود که تعداد مشاهدات آموزشی هستند. از آنجایی که پیچیدگی انجام این محاسبه حتی طبق روش تفکیک چولسکی (Cholesky Decomposition) از مرتبه است، مشخص میشود که زمان اجرای این محاسبات زیاد است. به همین ترتیب میزان حافظه اشغالی توسط این الگوریتم از مرتبه است. البته روشهایی برای کاهش بعد ماتریس کرنل نیز وجود دارد که با استفاده از تجزیه آن سعی دارد که بعد آن را از به کاهش دهد بطوری که بسیار کوچکتر از باشد.

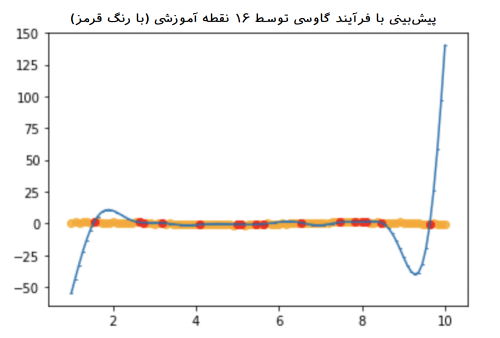

متاسفانه پایداری پیشبینیها با افزایش نقاط آموزشی یا انتخاب آنها تغییر میکند. اگر نقاطی که در مجموعه آموزشی به شکل مناسبی انتخاب نشده باشند، محاسبات GP باعث ایجاد خطا و اشتباهات زیادی در برآورد میشود. در تصویر زیر مدلسازی توسط GP را با ۱۶ نقطه آموزشی می بینید که در عمل واقعا قادر به پیشبینی منحنی آبی رنگ نیست.

از طرفی با توجه به اینکه روش GP را به عنوان یک روش ناپارمتری در نظر گرفتیم ولی خطای برآورد برای مقدارهای و ها از توزیع نرمال پیروی میکند. از طرفی با توجه به اطلاعات پیشینی که از توزیع خطاها ممکن است داشته باشیم، این امر میتواند باعث بهبود برآوردها شود ولی اگر این اطلاع با واقعیت مطابقت نداشته باشد، خطای برآوردها زیاد خواهد بود. برای مثال اگر دادهها فقط مقدارهای مثبت داشته باشند یا در یک بازه خاصی تغییر کنند، انتخاب توزیع نرمال به عنوان توزیع پیشین مناسب به نظر نمیرسد.

اگر علاقهمند به یادگیری مباحث مشابه مطلب بالا هستید، آموزشهای زیر نیز به شما پیشنهاد میشوند:

- مجموعه آموزش های SPSS

- مجموعه آموزشهای نرمافزارهای آماری

- مجموعه آموزش های داده کاوی یا Data Mining در متلب

- مهمترین الگوریتمهای یادگیری ماشین (به همراه کدهای پایتون و R) — بخش دوم: رگرسیون خطی

- رگرسیون لاسو (Lasso Regression) — به زبان ساده

- رگرسیون خطی با متغیرهای طبقه ای در SPSS — راهنمای گام به گام

^^

سلام.

در مقاله ای پاراگراف زیر را مطالعه نمودم:

برای مجموعه ای از داده ها نرمالسازی به روش “حداقل حداکثر” و “امتیاز زد” صورت گرفت و سپس همه این 48 مجموعه داده معیار با استفاده از تکنیک نرمال سازی حداقل حداکثر و z-score نرمال سازی شده اند. حداقل حداکثر و مجموعه داده های نرمال شده با امتیاز z که در قالب اعتبارسنجی متقاطع 5 برابری موجود هستند به عنوان ورودی طبقه بندی کننده ELM هسته گاوسی داده می شوند. مقدار G-mean محاسبه شده با استفاده از هسته گاوسی ELM برای پیشبینی برچسب کلاس (تکنیک نرمالسازی مناسب) برای همه 48 مجموعه داده معیار استفاده میشود. اگر میانگین G-max مجموعه داده نرمال سازی شده بیشتر از میانگین G-میانگین مجموعه داده نرمال شده با z-score با استفاده از ELM هسته گاوسی باشد، حداقل حداکثر (با برچسب 0) روش عادی سازی انتخاب شده است. در غیر این صورت، روش عادی سازی انتخاب شده z-score است (با برچسب 1).

سوال: با چه نرم افزاری می توان محاسبات مربوطعه را انجام داد و به چه صورت. اگز توضیح دهید ممنون میشم.