روش های تولید دیپ فیک (جعل عمیق) و ساختار آنها – راهنمای جامع

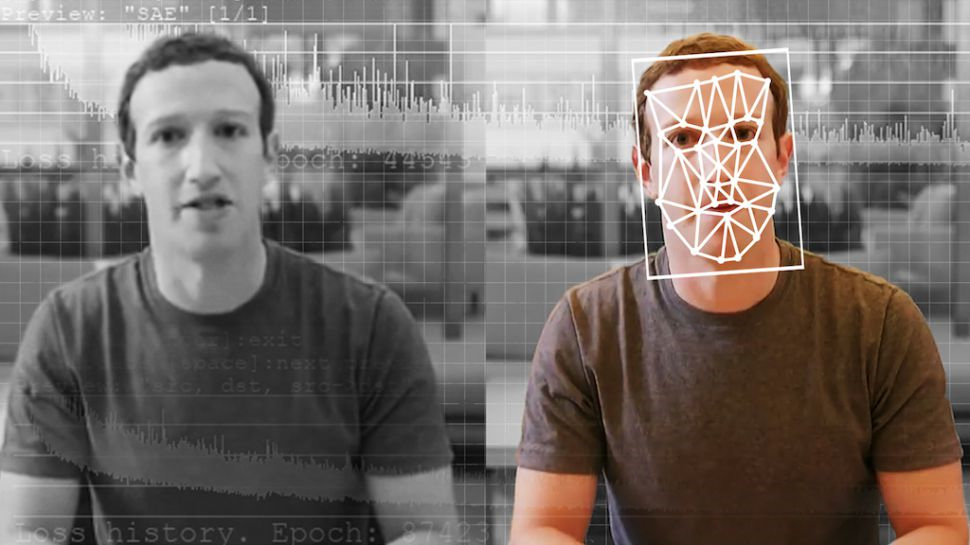

اگر اخبار دنیای فناوری را در یک سال اخیر دنبال کرده باشید، به احتمال زیاد با اصطلاح «دیپ فیک» (DeepFake | جعل عمیق) آشنا شدهاید. سیستمهای دیپ فیک (جعل عمیق) که سیستمهای مبتنی بر «یادگیری عمیق» (Deep Learning) و «یادگیری ماشین» (Machine Learning) محسوب میشوند، در نگاه اول شاید فناوری سرگرم کنندهای به نظر برسند، با این حال، با بررسی دقیق کاربرد آنها میتوان دریافت از این دسته از فناوریها برای جابجایی چهره افراد مختلف و «تحریف کردن» (Doctoring) فایلهای ویدیوئی مورد استفاده قرار میگیرند.

در چند سال اخیر، شاهد ظهور فناوریهای هوشمند و در عین خطرناکی در سطح اینترنت هستیم؛ به جرأت میتوان گفت که از میان فناوریهای ترسناک و خطرناک موجود در سطح اینترنت، قابلیت گول زدن افراد با محتویات جعلی و غیر واقعی توسط دیپ فیک (جعل عمیق)، یکی از رعبآورترین سناریوهای استفاده از فناوریهای مبتنی بر هوش مصنوعی محسوب میشود. تمامی فناوریها این قابلیت را دارند که برای مقاصد خصمانه یا مفید مورد استفاده قرار بگیرند، فناوریهای دیپ فیک (جعل عمیق) نیز از این قاعده مستثنی نیستند و علاوه بر کاربردهای خصمانه، پتانسیل استفاده در کاربردهای مفید (نظیر تجاری) را دارند.

اصطلاح دیپ فیک به ویدئوها و صداهای جعلی و تولید شده به وسیله کامپیوتر اطلاق میشود که متمایز ساختن آنها از محتویات واقعی (Genuine) و بدون تغییر (Unaltered) بسیار سخت است. فناوریهای دیپ فیک جهت تغییر فایلهای ویدئویی، معادل نرمافزار فتوشاپ برای تصاویر دیجیتالی محسوب میشوند.

دیپ فیک (جعل عمیق)، که از ترکیب دو واژه دیپ (معادل انگلیسی Deep و به معنای عمیق) و فیک (معادل انگلیسی Fake به معنای جعل) تشکیل شده است، سیستمهای مبتنی بر «هوش مصنوعی» (Artificial Intelligence) محسوب میشوند که برای «سنتز یا تولید تصاویر انسان» (Human Image Synthesis) مورد استفاده قرار میگیرند.

در سیستمهای دیپ فیک یا جعل عمیق، معمولا از دسته خاصی از الگوریتمهای یادگیری ماشین به نام «شبکههای مولد تخاصمی» (Generative Adversarial Networks) جهت «ترکیب کردن» (Combine) و «برهمنهی» (Superimpose) تصاویر و ویدئوهای موجود، روی مجموعهای از تصاویر یا ویدئوهای «منبع» (Source) استفاده میشود.

به دلیل وجود چنین ویژگی مشخصهای در سیستمهای دیپ فیک یا جعل عمیق، از این دسته از سیستمها برای تولید محتویات «چند رسانهای» (Multimedia) با نیت خصمانه استفاده میشود. از جمله مهمترین کاربردهای خصمانه سیستمهای دیپ فیک میتوان به مواردی نظیر «اخبار جعلی» (Fake News)، «فریبکاریهای خصمانه» (Malicious Hoaxes) و سایر موارد اشاره کرد.

از جمله کاربردهای خطرناک سیستمهای دیپ فیک (جعل عمیق)، تولید محتوای غیر اخلاقی جعلی با استفاده از تصاویر چهرههای مشهور دنیا و ترکیب و برهمنهی آنها با ویدئوهای غیر اخلاقی است. در این دسته از کاربردهای خصمانه دیپ فیک (جعل عمیق)، امکان تشخیص محتوای جعلی از محتوای واقعی بسیار سخت است. در نتیجه، بسیاری از افراد هنگام مشاهده ویدئوهای دیپ فیک (جعل عمیق)، به جعلی بودن محتوای آنها شک نمیکنند.

دیپ فیک (جعل عمیق | DeepFake)

دیپ فیک (جعل عمیق)، یکی از فناوریهای نوظهور مبتنی بر هوش مصنوعی است که جهت تولید یا تغییر محتویات فایلهای ویدئویی مورد استفاده قرار میگیرد؛ به گونهای که محتویات نمایش داده شده در فایلهای ویدئویی، در اصل رخ نداده است یا وجود خارجی ندارد.

نامگذاری چنین فناوریهایی به عنوان دیپ فیک (جعل عمیق)، بر اساس نام کاربری یکی از اعضای سایت Reddit (یک محیط میکروبلاگ و یکی از شبکههای اجتماعی معروف) است. این شخص که با نام کاربری deepfakes در سایت Reddit شناخته میشود، در دسامبر سال 2017 میلادی، از فناوری یادگیری عمیق برای ویرایش چهره افراد مشهور (Celebrities) و قرار دادن چهره آنها روی بازیگران فیلمهای غیر اخلاقی (و تولید ویدئوهای جعلی) استفاده کرده است.

غالب سیستمهای دیپ فیک مبتنی بر روشهای یادگیری عمیق هستند. یک بخش بزرگ از ابزارهایی که از طریق آنها ویدئوهای دیپ فیک تولید میشوند، مبتنی بر تکنیکهای خاصی به نام شبکههای مولد تخاصمی هستند. شبکههای مولد تخاصمی که به اختصار به آنها شبکههای GAN نیز گفته میشود، توسط محققی به نام Ian Goodfellow در سال 2014 ابداع شدند.

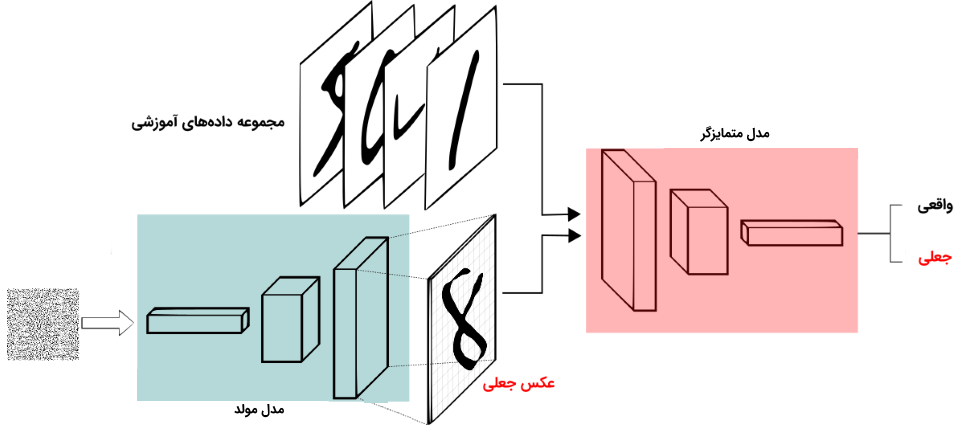

الگوریتمهای GAN از دو مدل هوش مصنوعی تشکیل میشوند؛ وظیفه یکی از این مدلها تولید محتوا (به عنوان نمونه، تولید تصاویر افراد) است. وظیفه مدل رقیب نیز این است که تشخیص دهد آیا عکس تولید شده واقعی است یا جعلی. مدل هوش مصنوعی که وظیفه تولید عکس را برعهده دارد، کار خود را از صفر آغاز میکند؛ به عبارت دیگر، تشخیص جعلی بودن تصاویر ابتدایی تولید شده توسط این مدل راحت است.

بنابراین، در ابتدای کار مدل هوش مصنوعی رقیب به راحتی قادر است میان تصاویر واقعی و جعلی تمایز ایجاد کند. با این حال، هر چقدر که زمان بیشتری میگذرد، دقت و عملکرد هر دو مدل ارتقاء پیدا میکند. در نهایت، عملکرد و دقت مدل هوش مصنوعی تولید کننده محتوا به قدری افزایش پیدا میکند که تشخیص جعلی بودن محتوای تولید شده توسط این مدل بسیار سخت میشود.

شبکههای مولد تخاصمی

شبکههای مولد تخاصمی (GAN)، کلاسی از الگوریتمهای یادگیری ماشین محسوب میشوند که در سال 2014 توسط Ian Goodfellow و همکارانش ابداع شد. در شبکههای مولد تخاصمی، دو «شبکه عصبی مصنوعی» (Artificial Neural Network) رقیب در یک بازی (این بازی معمولا از قواعد «نظریه بازی» (Game Theory) و فرم «بازی مجموع-صفر» (Zero-Sum Game) تبعیت میکند) با یکدیگر به رقابت میپردازند.

با در اختیار داشتن یک «مجموعه آموزشی» (Training Set)، مدل شبکههای مولد تخاصمی یاد میگیرد تا دادههای جدیدی تولید کند که آماره برابری با آماره دادههای آموزشی داشته باشند. به عنوان نمونه، یک مدل GAN آموزش داده شده روی تصاویر دیجیتالی، قادر است تصاویر جدیدی تولید کند که به صورت سطحی، برای ناظران انسانی واقعی به نظر میرسند و بسیاری از ویژگیهای مشخصه یک تصویر دیجیتالی واقعی را از خود نشان میدهند.

شبکههای مولد تخاصمی از دو بخش تشکیل شدهاند: «شبکههای مولد» (Generative Network) و «شبکههای متمایزگر یا تمایزی» (Discriminator). شبکههای مولد وظیفه تولید دادههای کاندید را بر عهده دارند، در حالی که شبکههای متمایزگر، وظیفه ارزیابی دادههای کاندید تولید شده را بر عهده دارند.

رقابت میان این دو شبکه، بر اساس «توزیع دادهها» (Data Distribution) صورت میگیرد. معمولا شبکههای مولد، نگاشت دادهها از «فضای نهان» (Latent Space) به یک توزیع دلخواه را یاد میگیرند؛ در حالی که شبکههای متمایزگر، دادههای کاندید تولید شده توسط شبکههای مولد را از توزیع واقعی دادهها متمایز میکنند.

هدف اصلی فاز آموزش شبکههای مولد، افزایش نرخ خطای شبکههای متمایزگر است. به عبارت دیگر، از طریق تولید دادههای کاندیدی که مدل متمایزگر قادر به تشخیص مصنوعی بودن آنها نیست، شبکههای مولد سعی میکنند تا شبکههای متمایزگر را فریب دهند.

از یک مجموعه داده شناخته شده (جعلی یا واقعی بودن دادههای این مجموعه مشخص شده است)، به عنوان مجموعه داده ابتدایی برای آموزش مدل متمایزگر استفاده میشود. در مرحله آموزش مدل متمایزگر، نمونههای موجود در مجموعه آموزشی وارد شبکه متمایزگر میشوند؛ تا زمانی که شبکه به عملکرد و دقت مطلوب دست پیدا کند. شبکه مولد بر اساس این معیار که آیا موفق به فریب دادن شبکه متمایزگر میشود یا نه، آموزش داده میشود.

همچنین، شبکه مولد معمولا یه وسیله نمونههای تصادفی که از یک فضای نهان (نظیر توزیع نرمال چند متغیره (Multivariate Normal Distribution)) نمونهگیری شدهاند، آموزش میبیند. در مرحله بعد، دادههای کاندید تولید یا سنتز شده به وسیله مدل متمایزگر ارزیابی میشوند. از الگوریتم یادگیری «پسانتشار» (BackPropagation) در هر دو مدل استفاده میشود تا شبکه مولد بتواند تصاویر بهتری تولید کند و شبکه متمایزگر نیز بتواند در متمایز کردن تصاویر واقعی از تصاویر جعلی مهارت بیشتری کسب کند.

شایان توجه است که مدل متمایزگر معمولا یک «شبکه عصبی پیچشی» (Convolutional Neural Network) است، در حالی که برای پیادهسازی مدل مولد از «شبکههای عصبی دیکانولوشن» (Deconvolutional Neural Network) استفاده میشود.

شبکههای مولد تخاصمی برای تولید ویدئوهای دیپ فیک

ویدئوهای دیپ فیک (جعل عمیق)، با استفاده از دو سیستم یا مدل هوش مصنوعی «رقابت کننده» (Competing) پدید میآیند؛ دسته اول از چنین مدلها یا سیستمهای هوش مصنوعی رقابت کننده، سیستمهای «مولد» (Generator) نام دارد و دسته دوم، سیستمهای «متمایزگر یا تمایزی» (Discriminator).

روش کار سیستمهای هوشمند تولید کننده محتوای دیپ فیک بدین صورت است که ابتدا مدلهای مولد (Generator)، یک ویدئوی جعلی تولید میکند. سپس، ویدئوی تولید شده به عنوان ورودی مدلهای متمایزگر وارد سیستم میشود. وظیفه مدل متمایزگر این است که تشخیص دهد آیا ویدئوی تولید شده واقعی است یا جعلی.

هر بار که مدل متمایزگر بتواند به درستی، جعلی بودن ویدئوها را تشخیص دهد، باز خورد یا سیگنالی در اختیار مدل مولد قرار میدهد؛ این سیگنال یا بازخورد، خطاهای مدل مولد در تولید ویدئوهای تقلبی را مشخص میکند. مدل مولد بر اساس «بازخوردهای» (Feedbacks) ایجاد شده، اقدام به تصحیح خطا و تولید ویدئوهای تقلبی جدید میکند.

همانطور که پیش از این نیز اشاره شد، از در کنار هم قرار گرفتن مدلهای مولد و متمایزگر، شبکههای مولد تخاصمی شکل خواهد گرفت. اولین قدم در پیادهسازی یک مدل شبکههای مولد تخاصمی یا GAN، شناسایی خروجی مطلوب و تولید یک مجموعه داده آموزشی برای مدل مولد است. به محض اینکه عملکرد و دقت مدل مولد در تولید ویدئوهای جعلی به سطح مطلوبی برسد، ویدئوهای تولید شده به عنوان ورودی مدل متمایزگر عمل خواهند کرد.

همانطور که به مرور زمان عملکرد مدل مولد در تولید ویدئوهای جعلی افزایش پیدا میکند، مدل متمایزگر نیز دقت بیشتری در تشخیص ویدئوهای جعلی از خود نشان میدهد. همچنین، با افزایش دقت و عملکرد مدل متمایزگر در تشخیص ویدئوهای جعلی، دقت مدل مولد در تولید ویدئوهای جعلی با کیفیت و نزدیک به واقعیت افزایش پیدا میکند.

تاریخچه دیپ فیک (جعل عمیق)

بیشتر سیستمهای تولید دیپ فیک معمولا در دو حوزه «مطالعات دانشگاهی» (Academic Research) و یا به وسیله افراد «آماتور» (Amateur) در جوامع آنلاین توسعه یافتهاند.

دیپ فیک در مطالعات دانشگاهی

بیشتر مطالعات دانشگاهی مرتبط با دیپ فیک در حوزه «علوم کامپیوتر» (Computer Science)، هوش مصنوعی و به طور خاص «بینایی کامپیوتر» (Computer Vision) در حال انجام است. بینایی کامپیوتر حوزهای است که بر پردازش کامپیوتری ویدئو و تصاویر دیجیتالی تمرکز دارد. اولین مطالعات تحقیقاتی معتبر در این زمینه، برنامهای کامپیوتری به نام Video Rewrite بود. این برنامه کامپیوتری که در سال 1997 منتشر شد، میتوانست تصاویر ویدیوئی صحبت کردن یک فرد خاص را به گونهای تغییر دهد که به نظر برسد این فرد، کلمات موجود در یک فایل صوتی دیگر را به زبان میآورد.

این برنامه اولین سیستم کامپیوتری محسوب میشود که فرایند «تجسم دوباره چهره» (Facial Reanimation) را به طور خودکار و از طریق روشهای یادگیری ماشین انجام میدهد. برنامهای کامپیوتری Video Rewrite، از روشهای یادگیری ماشین برای ایجاد ارتباط میان صداهای ادا شده توسط شخص موجود در تصویر و شکل چهره آنها استفاده میکند.

پروژههای تحقیقاتی معاصر در زمینه دیپ فیک (جعل عمیق)، بیشتر روی ساختن ویدئوهای «واقعنمایانهتر» (More Realistic) و همچنین، افزایش سرعت، سادگی و سطح دسترسی آنها برای عموم تمرکز دارند. برنامه Face2Face، که در سال 2016 منتشر شد، تصاویر ویدئویی چهره یک شخص را به گونهای تغییر میدهد که گویا در حال تقلید حالات چهره شخص دیگری است.

در ادامه، سه نمونه از سیستمهای تولید ویدئوهای دیپ فیک که از مطالعات دانشگاهی نشأت گرفتهاند، مورد بررسی قرار گرفته میشود.

یادگیری همگامسازی دقیق لب در ویدئو با استفاده از فایلهای صوتی

در این مثال، کاربردی از مطالعات دانشگاهی مرتبط با دیپ فیک ارائه خواهد شد. در سال 2017، نتایج یک پروژه دانشگاهی مرتبط با جعل عمیق، تحت عنوان Synthesizing Obama منتشر شد. در این برنامه، با در اختیار داشتن صدای باراک اوباما (رئیس جمهور پیشین آمریکا)، یک ویدئوی دیپ فیکِ با کیفیت از صحبت کردن این شخصیت، به همراه «همگامسازی دقیق لب» (Accurate Lip Sync) و به زبان آوردن کلمات موجود در یک فایل صوتی دیگر (از باراک اوباما) ارائه شده است.

با آموزش این سیستم روی ساعتها سخنرانی هفتگی اوباما، مدل «شبکه عصبی بازگشتی» (Recurrent Neural Network)، نگاشت از ویژگیهای خام صوتی به حالات دهان را یاد میگیرد. نتایج ارائه شده، ویدئوهای به مراتب واقعنمایانهتری را نسبت به پروژههای مشابه نشان میدهد. بخشی از کدهای لازم برای پیادهسازی این روش در زبان پایتون در ادامه نمایش داده شده است. شایان توجه است که برای اجرای صحیح کدهای نمایش داده شده، ابتدا لازم است فایلهای صوتی ورودی به سیستم «نرمالسازی» (Normalize) شوند. جهت دریافت توضیحات لازم برای اجرای کدها، به لینک [+] مراجعه شود.

فایل util.py [+]:

فایل اجرایی run.py [+]:

کدهای کامل و قابل استفاده برای پیادهسازی این روش در زبان پایتون و دادههای لازم جهت آموزش مدل شبکه عصبی بازگشتی، از طریق لینک [+] قابل دسترس است. شایان توجه است که برای اجرای صحیح کدها، خواندن توضیحات مرتبط با نحوه اجرای برنامه در لینک [+] ضروری است.

در ادامه، نحوه عملکرد سیستم بینایی کامپیوتر ارائه شده جهت تولید ویدئوهای دیپ فیک نمایش داده شده است:

بازسازی مدل کنترل شده یک شخص از مجموعه عظیمی از دادههای تصویری

در سال 2015، گروهی از محققین روشی را برای بازسازی یک مدل کنترل شده از اشخاص، بر اساس مجموعه عظیمی از تصاویر نمایش دهنده ویژگیهای شخصیتی آنها نظیر رفتار و ظاهر فیزیکی ارائه دادند. سیستم ارائه شده توسط این محققان، بر اساس ترکیب بدیع از روشهای بازسازی سهبُعدی چهره (3D Face Reconstruction)، ردیابی (Tracking)، همترازی (Alignment) و مدلسازی چندبافتی (Multi-Texture) پدید آمده است.

قابلیت انجام عملیات روی مجموعهای از تصاویر غیر ساخت یافته، به سیستم امکان میدهد بدون اینکه تصاویر افراد را اسکن کند، تنها با داشتن تصاویر افراد از زوایای مختلف، چهره آنها را مدلسازی کند. در ادامه، نحوه عملکرد سیستم در تولید مدلهای بازسازی چهره (نمونهای از قابلیتهای یک سیستم دیپ فیک) نمایش داده شده است:

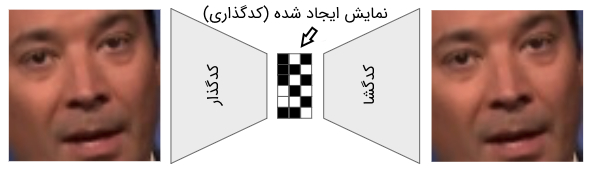

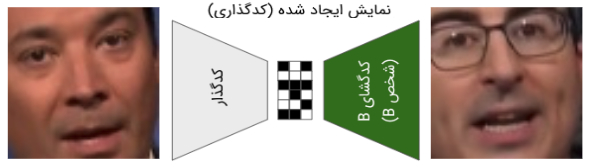

مدلهای شبکههای عصبی خود کدگذار (AutoEncoder) برای تولید دیپ فیک

یکی از روشهای دیگر برای تولید دیپ فیک (جعل عمیق)، مدل شبکه عصبی «خود کدگذار» (AutoEncoder) نام دارد. مدل خود کدگذار، یک شبکه عصبی عمیق (Deep Neural Network) است که ورودیها را در قالب تصاویر دیجیتالی دریافت و آنها را به تعدادی مدل نمایشی کوچکتر به نام «کدگذاری» (Encoding) تبدیل میکند.

در نهایت، این مدل قادر است تا تصاویر اصلی را از روی نمایشهای تولید شده (کدگذاریها) بازسازی کند.

قرار دادن مدل تولید کننده نمایش کدگذاری (Encoding) در وسط شبکه عصبی خودکدگذار، شبکه عصبی را مجبور میکند تا به جای تولید یک پیشبینی کلاسی متناسب با داده ورودی، تصاویر بازسازی شده را خروجی دهد. چنین ساختاری، شبکه عصبی را قادر میسازد تا الگوهای موجود در تصویر نظیر شکل ابروها، فرم چهره و سایر موارد و از همه مهمتر مکان آنها در تصویر را یاد بگیرد.

سیستمهای دیپ فیک (جعل عمیق)، از سه مدل خودکدگذار برای تبدیل چهره شخص A به چهره شخص B استفاده میکند. مدل خودکدگذار اول، تصویر ورودی شخص A را کدگذاری و بازسازی میکند. مدل خودکدگذار دوم، تصویر ورودی شخص B را کدگذاری و بازسازی میکند. مدل سوم نیز، تصویر شخص A را به عنوان ورودی دریافت میکند، با این حال، تصویر بازسازی شده شخص B را به عنوان خروجی تولید میکند.

روش آموزش یک مدل شبکه عصبی خودکدگذار برای تولید دیپ فیک به صورت زیر خواهد بود:

- در مرحله اول، تصویر نویزی (تاب برداشته) شخص A وارد ماژول کدگذار (Encoder) در مدل خودکدگذار (AutoEncoder) اول میشوند. در این مرحله، مدل شبکه عصبی تلاش میکند تا بر اساس کدگذاریهای تولید شده (Encoding)، چهره شخص A را بازسازی کند. به عبارت دیگر، مدل خودکدگذار اول مجبور میشود تا چهره شخص اول را از ورودیهای نویزی بازسازی کند.

- در مرحله دوم، از ماژول کدگذار (Encoder) در مدل خودکدگذار (AutoEncoder) اول استفاده و تصویر نویزی (تاب برداشته) شخص B وارد این ماژول میشود. با این تفاوت که این دفعه مدل شبکه عصبی تلاش میکند تا بر اساس کدگذاریهای تولید شده (Encoding) توسط ماژول کدگذار (Encoder)، چهره شخص B را بازسازی کند. به عبارت دیگر، مدل خودکدگذار اول مجبور میشود تا چهره شخص دوم را از ورودیهای نویزی بازسازی کند.

- این کار چندین بار تکرار میشود تا ماژولهای کدگذار (Encoder) مربوط به شخص A و B قادر به بازسازی چهرههای مربوطه شوند. به عبارت دیگر، ماژولهای کدگذار، ویژگیهای چهره شخص A و B و بازسازی آنها را یاد میگیرند.

پس از پایان مرحله آموزش مدل شبکه عصبی خودکدگذار، تصویر شخص A وارد ماژول کدگذار (Encoder) میشود؛ با این تفاوت که، به جای استفاده از کدگذاریهای تولید شده، جهت بازسازی تصویر A، کدگذاریهای تولید شده وارد کدگشای B میشوند و از این طریق، چهره شخص B بازسازی میشود.

محدودیتهای سیستمهای تولید دیپ فیک

اگرچه نتایج حاصل از تولید ویدئوهای دیپ فیک (برای مقاصد علمی و تحقیقاتی) ممکن است برای کاربران جذاب و مهیج باشد، با این حال، استفاده از فناوریهای هوش مصنوعی و یادگیری عمیق جهت تولید ویدئوهای دیپ فیک (جعل عمیق) محدودیتهایی نیز دارند که در ادامه به آنها پرداخته خواهد شد:

- سیستم تنها در صورتی قادر به تولید ویدئوهای دیپ فیک مطلوب خواهد بود که مجموعه بزرگی از تصاویر را برای آموزش در اختیار داشته باشد. برای اینکه سیستم قادر باشد تصویر یک شخص خاص را روی یک ویدئوی خاص قرار دهد، لازم است چیزی حدود 300 الی 2000 تصویر از صورت شخص در اختیار سیستم قرار داده شود تا شبکه عصبی قادر به یادگیری و بازسازی چهره آن شخص و قرار دادن آن روی ویدئوی مورد نظر باشد.

- دادههای آموزشی استفاده شده برای پیادهسازی سیستمهای دیپ فیک، باید به خوبی نمایانگر ویژگیهای ویدئوی هدف باشد. فرض کنید که قرار باشد چهره شخص A روی چهره شخص B در یک ویدئوی خاص قرار بگیرد. در چنین حالتی، تصاویر آموزشی شخص A باید در زوایا و حالات مختلف در اختیار سیستم قرار بگیرد تا سیستم بتواند به درستی ویژگیهای چهره این شخص را یاد بگیرد. به عبارت دیگر، تصاویر لازم (از شخص A) برای آموزش سیستم باید تقریب مناسبی از زوایا و حالات چهره شخص B باشد تا سیستم بتواند همترازی تصاویر شخص A روی ویدئوی شخص B را یاد بگیرد.

- ساختن مدلهای تولید دیپ فیک (جعل عمیق)، هزینه زمانی و محاسباتی زیادی میطلبد. سیستمهای تولید دیپ فیک از ماژولهای مختلفی نظیر «تشخیص چهره» (Face Detection) و همترازی تصاویر تشکیل شدهاند. هر کدام از این ماژولها، قدرت محاسباتی قابل توجهی را به خود اختصاص خواهند داد. به عنوان نمونه، آموزش یک مدل یادگیری عمیق برای تولید دیپ فیک با کیفیت معمولی، چیزی حدود 72 ساعت زمان خواهد برد. برای آموزش چنین سیستمی، به قدرت محاسباتی بسیار زیادی نیاز است. از سوی دیگر، هر مدل دیپ فیک تولید شده، تنها قادر به قرار دادن تصویر یک شخص خاص روی ویدئو خواهد بود و برای قرار دادن تصویر یک شخص دیگر روی ویدئو، احتیاج به آموزش یک مدل دیگر خواهد بود؛ به عبارت دیگر، سیستمهای تولید دیپ فیک، مقیاسپذیری خوبی از خود نشان نمیدهند.

کاربرد سیستمهای تولید دیپ فیک در جهان واقعی

در ادامه، به برخی از مهمترین کاربردهای سیستمهای تولید دیپ فیک اشاره خواهد شد:

تولید محتوای ویدئویی

شاید یکی از فناوریهای مشابهی که پیش از این در صنعت فیلم مورد استفاده شده است، فناوری تولید محتوای ویدئویی با استفاده از «جلوههای ویژه» باشد. اگرچه این فناوری (تولید چهرههای کامپیوتری و جا به جا کردن آنها با چهره بازیگران) سالهای زیادی است که در صنعت فیلم استفاده میشود، با این حال، سادگی دسترسی دیپ فیک و هزینه به مراتب کمتر آنها نسبت به جلوههای ویژه پرهزینه، دیپ فیک را به یک انتخاب وسوسهبرانگیز و هیجانآور برای افراد مختلف، به ویژه آماتورهای علاقهمند به این حوزه تبدیل کرده است.

البته، نمیتوان منکر استفادههای متعدد این فناوری در صنعت فیلم شد. به عنوان نمونه، این قابلیت برای شرکتهای سازنده فیلمهای سینمایی وجود دارد که فیلمها را با بازیگران ناشناخته ضبط کنند و سپس، در مرحله ویرایش، تصاویر بازیگران معروف روی تصاویر ضبط شده قرار داده شود. سناریوی واقعگرایانه دیگر جهت استفاده از فناوری دیپ فیک، تغییر بازیگر فیلم بر اساس بازار فروش و یا امکان انتخاب بازیگر توسط کاربر است، بدین صورت که با استفاده از این فناوری، این امکان برای کاربران فراهم میشود تا پیش از پخش یک فیلم، بازیگر مورد علاقه خود را برای ایفای نقش انتخاب کنند.

استفاده از چهره افراد مشهور برای تبلیغات پوشاک

در این سناریو، افراد مشهور چهرههای مدل شده و کامپیوتری خود را به شرکتهای تولید پوشاک قرض میدهند تا این شرکتها بدون نیاز به فیلمبرداری کلیپهای تبلیغاتی، از چهره آنها برای تبلیغ پوشاک و وسایل جانبی استفاده کنند (قرار دادن چهره افراد معروف روی مانکنهای لباس).

تبلیغات شخصیسازی شده

در این سناریو، هنگام جستجوی اینترنت، کاربران با تبلیغات هدفداری مواجه خواهند شد که از چهره خود آنها یا افراد خانواده و نزدیکان آنها استفاده شده است. به عنوان نمونه، یک مدل کامپیوتری تولید شده با توجه به مشخصات چهره و فیزیک کاربر، در حال تبلیغ پوشاک، ساعت، عینک آفتابی و سایر وسایل جانبی نمایش داده خواهد شد.

جمعبندی

فناوریهای دیپ فیک (جعل عمیق)، یکی از جنجالبرانگیزترین فناوریهایی است که در چند سال اخیر معرفی شده است و طی این مدت کوتاه توانسته است بخشهای مختلفی از جامعه انسانی و حتی مسائل سیاسی را نیز تحت تأثیر خود قرار دهد. چنین کاربردی از فناوری ممکن است یک هاله ابهام در مورد صحت و اعتبار ویدئوهای منتشر شده در سطح وب ایجاد کند.

با این حال، ظهور دیپ فیک، جذاب بودن این فناوری و کاربردهای گسترده (و مفید) آن در حوزههای مختلف علم و فناوری را نشان داد. مدلهای یادگیری عمیق نظیر GAN و مدلهای مولد یادگیری عمیق نظیر شبکههای عصبی خودکدگذار (AutoEncoder)، به کاربران (با سطح دانش کافی از مفاهیم یادگیری ماشین) اجازه میدهند تا دادههای مصنوعی ولی واقعگرایانه تولید کنند (دادههای نظیر تصاویر دیجیتالی و ویدئو). به عبارت دیگر، این در صورتی که یکی از این الگوریتمهای هوش مصنوعی به محصول تجاری تبدیل شود، ابزاری بسیار قدرتمند در اختیار کاربران عادی قرار میدهد تا بتوانند محتوای خلاقانهای (برای استفاده در مقاصد مثبت) ایجاد کنند.

اگر نوشته بالا برای شما مفید بوده است، آموزشهای زیر نیز به شما پیشنهاد میشوند:

- مجموعه آموزشهای دادهکاوی و یادگیری ماشین

- آموزش اصول و روشهای دادهکاوی (Data Mining)

- مجموعه آموزشهای هوش مصنوعی

- تفسیر مدل های یادگیری عمیق در بینایی کامپیوتر — راهنمای جامع

- نقشه دانش فناوریهای هوش مصنوعی و دسته بندی آنها — راهنمای جامع

- کدنویسی شبکه های عصبی مصنوعی چند لایه در پایتون — راهنمای کامل

- یادگیری عمیق (Deep Learning) با پایتون — به زبان ساده