آماره کامل و آماره کمکی — به زبان ساده

در تئوری آماری «برآوردیابی نقطهای» (Point Estimation) و انتخاب بهترین برآوردگر مسئله مهمی است. با توجه به خصوصیاتی که برآوردگرها برای پارامتر جامعه ($$\theta$$) دارند، نمیتوان بهترین برآوردگر را انتخاب کرد. بنابراین بهتر است که براساس این خصوصیات، آنها را دستهبندی کرده و از بین هر دسته، بهترین برآوردگر را انتخاب کرد. برای مثال میتوان گروه برآوردگرهای نااریب را مورد بررسی قرار داد و برآوردگری که بیشترین دقت (کمترین واریانس) را دارد از بین آنها انتخاب کرد. در این میان توزیعها یا آمارههای کامل (Complete Statistic) و آمارههای کمکی (Ancillary Statistic) نقش مهمی در انتخاب برآوردگرهای مناسب دارند.

در نوشتارهای دیگر فرادرس در مورد آمارههای بسنده (Sufficient Statistics) خواندهاید. در این نوشتار نیز به بررسی برخی از خصوصیات جالب توجه برای آمارههای بسنده و آماره بسنده مینیمال خواهیم پرداخت. البته خواندن مطلب آزمون های فرض و استنباط آماری — مفاهیم و اصطلاحات که به مباحث برآوردیابی میپردازد، توصیه میشود. همچنین مطالعه نوشتار فاصله اطمینان (Confidence Interval) — به زبان ساده که موضوع برآوردگرهای فاصلهای را مورد بررسی قرار میدهد، نیز خالی از لطف نیست.

آماره کامل (Complete Statistic) و آماره کمکی (Ancillary Statistic)

همانطور که در نوشتار آزمونهای آماری خواندهاید، میدانید منظور از آماره، تابعی از یک نمونه تصادفی است که مقدار آن به پارامتر مجهول جامعه بستگی ندارد. فرض کنید $$X_1,X_2,\cdots.X_n$$ یک نمونه تصادفی باشند. آنگاه $$\overline{X}$$ به عنوان میانگین نمونهای میتواند یک آماره برای پارامتر میانگین جامعه محسوب شود.

در مطلب آماره بسنده به آمارهای توجه کردیم که بیشترین میزان اطلاعات را در مورد پارامتر مجهول داشته باشد. همچنین مشخص کردیم که آماره بسندهای که تابعی از همه آمارههای بسنده باشد، آماره بسنده مینیمال نامیده شده و بهتر است برای انجام عمل برآوردیابی از آن استفاده شود.

ولی هدف از ایحاد آماره کامل، تولید یا انتخاب آمارهای است که بتواند با کمترین میزان بُعد بیشترین اطلاعات را در مورد پارامتر در اختیارمان قرار دهد. به این معنی که ممکن است در یک آماره بسنده مینیمال، اطلاعات اضافهای نیز که مربوط به استنباط پارامتر جامعه نباشد، وجود داشته باشد. با انتخاب «آماره بسنده مینیمال کامل» (Complete Minimal Sufficient Statistic) به آمارهای خواهیم رسید که فقط و فقط در مورد پارامتر جامعه اطلاعات در خود ذخیره کرده است و هیچ اطلاعات زائدی ندارد.

آماره کامل یا خانواده توزیع کامل

مفهوم اماره کامل، درست به مانند مفهوم «فضای کامل» (Complete Space) است. بنابراین بهتر است ابتدا به مفهوم فضای کامل بپردازیم. مجموعه بردارهای $$v_1,v_2,\cdots v_p$$ را «کامل» (Complete) میگویند اگر این بردارها بتوانند همه فضا را بپوشانند، یا (Span) کنند. به این ترتیب میتوانیم هر برداری مثلا $$u$$ را به صورت ترکیب خطی از بردارهای $$v_1,v_2,\cdots v_p$$ بنویسیم.

$$\large u=\sum_{i=1}^p a_iv_i$$

از آنجایی که این مجموعه بردارها، کل فضا را پوشش دادهاند، هر برداری مثل $$w$$ که بر همه آنها عمود باشد، طولی برابر با صفر دارد. در جبر خطی، فضای حاصل از بردارهای $$v_1,v_2,\cdots v_p$$ را فضای کامل pبُعدی مینامند. حال به بررسی آماره کامل میپردازیم.

تعریف آماره کامل

آماره $$T$$ را برای خانواده توزیع آن، کامل میگویند اگر برای هر تابع اندازه پذیر $$g$$ و هر مقدار پارامتر $$\theta \in \Theta$$ رابطه زیر برقرار باشد.

$$\large {\displaystyle \operatorname {E} _{\theta }(g(T))=0 \rightarrow \mathbf {P} _{\theta }(g(T)=0)=1}$$

این تعریف را میتوان دقیقا مشابه تعریفی که در مورد فضای کامل داشتیم در نظر بگیریم. فرض کنید که متغیر تصادفی $$X$$ گسسته باشد. در نتیجه امید ریاضی برای $$g(T)$$ و مفهوم کامل بودن، به صورت زیر نوشته خواهد شد.

$$\large {\displaystyle \operatorname {E} _{\theta }(g(T))=\sum_{t} g(t)P_{\theta}(T=t)=0 \rightarrow \mathbf {P} _{\theta }(g(T)=0)=1}$$

واضح است که طرف راست علامت $$\rightarrow$$ بیان میکند که به طور قطع به یقین (تقریبا مطمئن - Almost Surely) تابع $$g(T)$$ برابر با صفر است (به جز در نقاطی که احتمال آن صفر باشد). از آنجایی که امید ریاضی را میتوان به صورت ضرب داخلی بردارهای $$(g(t_1), g(t_2),\cdots,g(t_p))$$ و $$(p(t_1), p(t_2),\cdots,p(t_p))$$ در نظر گرفت مفهوم فضای کامل نیز در اینجا قابل استفاده است. به این ترتیب اگر قرار باشد فضای حاصل از برآوردگر $$T$$ کامل باشد، هیچ تابعی مثل $$g$$ نمیتواند شامل اطلاعات اضافهای در مورد پارامتر در این فضا باشد.

در این تعریف، از آن جهت خانواده توزیع را کامل خواندیم که همه مقدارهای پارامتر $$\theta$$ که خانواده توزیع را مشخص میکنند یک مجموعه غنی از بردارهایی را میسازند که منجر به ایجاد یک فضای کامل میشود.

نکته: اگر تابع $$g$$ که در شرایط کامل بودن به کار گرفته شد، کراندار نیز باشد، آماره $$T$$ یا خانواده حاصل از $$T$$ را «کامل کراندار» (Boundedly Complete) میگویند.

در ادامه نیز با توجه به مفهوم آماره کمکی، متوجه میشویم که آماره بسنده کامل، بیشترین اطلاعات را در مورد پارامتر جامعه بدون هیچ اضافاتی دارد. بهتر است برای روشنتر شدن موضوع به بررسی یک مثال بپردازیم.

نکته: اگر توزیعی، کامل باشد میتوان آن را «قابل تشخیص» (Identifiable) دانست به این معنی که براساس دادههای در دسترس توسط نمونه تصادفی، قادر به تشخیص توزیع و پارامتر آن خواهیم بود.

مثال ۱

یک آزمایش برنولی را در نظر بگیرید. اگر $$X_1, X_2,\cdots, X_n$$ یک نمونه تصادفی از این توزیع باشند، نشان میدهیم که مجموع آنها (که دارای توزیع دوجملهای است) یک آماره کامل است. به این ترتیب مشخص میشود که خانواده توزیع دوجملهای، یک خانواده کامل است. فرض کنید آماره $$T$$ به صورت جمع این نمونه تصادفی در نظر گرفته شده باشد. مشخص است که توزیع $$T$$ دوجملهای با پارامترهای $$p$$ و $$n$$ است یعنی داریم، $$T\sim B(n,p)$$.

$$\large T=X_1+X_2+\cdots +X_n$$

در این صورت مطابق با قسمت اول تعریف کامل بودن، رابطه زیر را فرض میکنیم.

$$\large \operatorname {E} _{p}(g(T))=\sum _{t=0}^{n}{g(t){n \choose t}p^{t}(1-p)^{n-t}}=(1-p)^{n}\sum _{t=0}^{n}{g(t){n \choose t}\left({\frac {p}{1-p}}\right)^{t}}=0$$

توجه داشته باشید که در اینجا فضای پارامتری ($$\Theta$$) شامل دو نقطه ۰ و ۱ نیست. از آنجایی که جملات این بسط (به غیر از $$g(T)$$) همگی مثبت هستند، فقط زمانی حاصل جمع صفر خواهد بود که تابع $$g(T)$$ صفر باشد. در نتیجه $$T$$ برای خانواده توزیعهای دوجملهای کامل است. یعنی رابطه زیر برقرار است.

$$\large {\displaystyle \operatorname {E} _{\theta }(g(T))=0 \rightarrow \mathbf {P} _{\theta }(g(T)=0)=1}$$

نکته: توزیع حاصل از آماره $$T$$، یک توزیع دوجملهای است به همین دلیل $$T$$ را برای این خانواده کامل نامیدیم.

مثال ۲

در مثال قبلی اگر فضای پارامتر محدود به $$p=0,0.5,1$$ و $$n\geq 3$$ باشد، دیگر $$T=\sum_{t=0}^n X_t$$ تشکیل یک خانواده کامل را نمیدهد. با توجه به تفسیر برداری که ارائه شد این فضا کامل نیست. زیرا فضای پارامتری سه بُعدی است ولی مقدار $$t$$ شامل نقاط $$0,1 \cdots , n$$ است که در نتیجه این سه پارامتر نمیتوانند همه فضا را پوشش دهند. مثلا فرض کنید که $$\theta = 0.5$$ و $$n=1$$ باشد. در این حالت خانواده توزیع دوجملهای کامل نیست در صورتی که این خانواده کامل باشد باید برای هر تابعی مثلا $$g(T)=2(t-0.5)$$ رابطه زیر برقرار باشد.

$$ \large E(g(T))=0 \rightarrow g(T)=2(t-0.5) = 0 ,\;\;\; t=0,1$$

به این معنی که اگر امیدریاضی تابع $$g(T)$$ صفر باشد، رابطه زیر برقرار است.

$$\large E(g(T))=\sum_{t=0,1} g(T)p^t(1-p)^{1-t}\\ \large =g(0)(0.5)^0(0.5)^1+g(1)(0.5)^1(0.5)^0=0.5[g(0)+g(1)]=0$$

به این ترتیب باید $$g(0)=-g(1)$$ باشد، که طبق تعریف این تابع داریم:

$$\large g(0)=2(0-0.5)=-1, \;\;\;g(1)= 2(1-0.5)=1$$

پس امید ریاضی تابع $$g(T)$$ صفر شده، ولی با این وجود نمیتوان نتیجه گرفت که تابع $$g(T)=g(X)$$ در همه نقاط تکیهگاه (مثلا ۰ و 1) برابر با صفر است. پس این خانواده، کامل نیست. زیرا مقدار تابع $$g$$ در دو نقطه 0 , 1 مخالف صفر است.

آماره کمکی (Ancillary Statistic)

آماره $$U$$ را در نظر بگیرید. با توجه به مفهوم آماره، مشخص است که $$U$$ شامل پارامتر جامعه نیست. از طرفی توزیع آماره کمکی نیز به پارامتر جامعه بستگی ندارد. بنابراین میتوان آماره کمکی را مبنایی برای محاسبه فاصله اطمینان (Confidence Interval) و کمیت محوری (Pivotal Quantity) در نظر گرفت. تعریف آماره کمکی توسط دانشمند بزرگ آمار «رونالد فیشر» (Sir Ronald Fisher) صورت گرفته است.

مثال ۳

فرض کنید نمونه تصادفی $$X_1.X_2,\cdots,X_n$$ دارای توزیع نرمال با میانگین نامعلوم $$\mu$$ و واریانس معلوم $$\sigma^2=1$$ باشند. در این صورت با توجه به $$\overline{X}$$ به عنوان میانگین نمونهای، $$\widehat{\sigma}^2$$ یک آماره کمکی است زیرا توزیع آن به پارامتر $$\mu$$ بستگی ندارد.

$$\large \widehat{\sigma}^2 =\dfrac{\sum_{i=1}^n(X_i-\overline{X})^2}{n}$$

نکته: اگر واریانس نمونهای $$S^2=\sum_{i=1}^n\dfrac{(X_i-\overline{X})^2}{n-1}$$ را برآوردگر نااریب واریانس بدانیم، مشخص است که $$\dfrac{(n-1)S^2}{\sigma^2}\sim \chi^2_{n-1}$$ است بنابراین توزیع $$S^2$$ به پارامتر $$\mu$$ بستگی ندارد و به نوعی از توزیع کای ۲ پیروری میکند، بنابراین $$S^2$$ یک آماره کمکی است.

آماره نااریب (Unbiased Estimator)

قبل از اینکه به قضیههای بعدی در زمینه آماره بسده کامل و مینیمال بپردازیم، بهتر است مفهوم «آماره نااریب» (Unbiased Estimator) را مرور میکنیم. $$U$$ را آماره نااریب مینامیم اگر مقدار مورد انتظار (امید ریاضی) آن برابر با پارامتر جامعه باشد.

برای مثال میتوان نشان داد که میانگین نمونهای ($$\overline{X}$$) یک برآوردگر نااریب برای پارامتر میانگین جامعه ($$\mu$$) است.

$$\large E(\overline{X})=\mu$$

این مفهوم نشان میدهد که انتظار داریم با تکرار نمونهگیری، برآیند حاصل از میانگین نمونهها، با میانگین جامعه آماری برابر باشد.

قضیه باسو (Basu's Theorem)

در تئوری آمار استنباطی، «آماره کامل کراندار» و «آماره کمکی»، نقش مهمی در قضیه باسو دارند. این قضیه کمک میکند که در بسیاری از موارد بتوانیم استقلال متغیرهای تصادفی یا توابعی از آنها را مشخص کنیم. صورت این قضیه به صورت زیر است.

قضیه باسو: اگر $$T$$ یک آماره بسنده کامل کراندار و $$U$$ نیز یک آماره کمکی برای پارامتر $$\theta$$ باشند، آنگاه $$T$$ از $$U$$ مستقل است.

در اینجا از اثبات این قضیه صرف نظر میکنیم ولی میتوانید این اثبات را در کتابهای «آمار-ریاضی» (Mathematical Statistics) مشاهده کنید. با توجه به این قضیه میتوان استقلال میانگین نمونهای و واریانس نمونهای را اثبات کرد. به این ترتیب $$\overline{X}$$ و $$\widehat{\sigma}^2$$ مستقل هستند. جالب آن است که برای محاسبه $$S^2$$ احتیاج به $$\overline{X}$$ هست ولی این دو متغیر تصادفی، مستقل از یکدیگرند.

قضیه بهادر (Bahadur's Theorem)

یکی دیگر از کاربردهای آماره کامل، در قضیه بهادر نهفته است. به این ترتیب میتوان روشی ساده برای پیدا کردن آماره بسنده مینمال پیدا کرد. در ادامه صورت این قضیه قابل مشاهده است.

قضیه بهادر: اگر $$T$$ یک آماره بسنده کامل کراندار باشد، در صورتی که آماره بسنده مینیمال برای پارامتر $$\theta$$ وجود داشته باشد، $$T$$ آماره بسنده مینیمال است.

این قضیه روشی برای پیدا کردن آماره بسنده مینیمال ارائه میدهد. بنابراین کافی است که به دنبال آماره بسنده کامل کراندار باشیم.

قضیه رائو-بلکول (Rao–Blackwell Theorem)

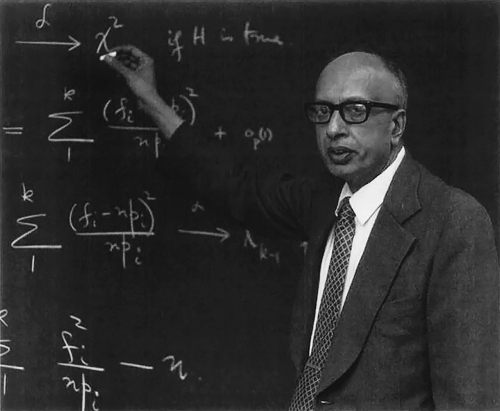

قضیه رائو-بلکول به منظور انتخاب برآوردگر مناسب برای پارامتر $$\theta$$ به کار میآید. این قضیه توسط دو دانشمند بزرگ آمار به نامهای «رائو» (Calyampudi Radhakrishna Rao) و «بلکول» (David Blackwell) اثبات و مورد استفاده قرار گرفته است. صورت این قضیه به شکل زیر است.

قضیه رائو-بلکول: فرض کنید $$T$$ یک آماره بسنده برای پارامتر $$\theta$$ باشد. همچنین $$S$$ را هر برآوردگر دیگری برای این پارامتر در نظر بگیرید. آماره یا برآوردگر جدیدی که به صورت $$E(S|T)$$ (برآوردگری به صورت امیدریاضی $$S$$ به شرط $$T$$) تعریف شود، دارای واریانس کمتری نسبت به $$S$$ است. به این ترتیب برآوردگر $$S$$ به کمک آماره بسنده، بهبود یافته است. مشخص است که آماره جدید تابعی از آماره بسنده خواهد بود.

بنابراین اگر $$\delta(X)=E(S(X)|T(X))$$ را یک برآوردگر نااریب برای پارامتر $$\theta$$ در نظر بگیریم، براساس واریانس برآوردگرها خواهیم داشت:

$$\large E(\delta(X)-\theta)^2\leq E(S(X)-\theta)^2$$

از این قضیه میتوان برای پیدا کردن برآوردگر نااریب با کمترین واریانس (Minimum Variance Unbiased Estimator- MVUE) استفاده کرد. برای انجام این کار کافی است که برآوردگر نااریبی را پیدا کرده و امید شرطی آن را برحسب آماره بسنده پارامتر بدست آوریم. برآوردگر حاصل دارای واریانس کوچکتری نسبت به واریانس برآوردگر اولیه خواهد بود. به منظور تعیین بهترین برآوردگر در کلاس یا مجموعه برآوردگرهای نااریب، باید از قضیه لهمن-شفه استفاده کرد. این قضیه تضمین میکند که برآوردگر نااریبی که توسط قضیه رائو-بلکول ایجاد میشود بطور یکنواخت، دارای واریانس کوچکتری نسبت به هر برآوردگر نااریب دیگر است.

قضیه لهمن-شفه (Lehmann–Scheffé Theorem)

در انتهای این بحث به بررسی قضیه لهمن-شفه میپردازیم. این قضیه کمک میکند که در کلاس برآوردگرها نااریب بهترین برآوردگر شناسایی شود. همچنین با استفاده از این قضیه شرایط بدست آوردن چنین برآوردگری نیز تعیین میشود. این قضیه را میتوان مکملی برای قضیه رائو-بلکول دانست.

با استفاده از این قضیه میتوان نشان داد که برآوردگر نااریب با کمترین واریانس تحت چه شرایطی یکتا است. به این ترتیب میتوان یک «برآوردگر با کمترین واریانس یکنواخت» (Uniformly Minimum Variance Unbiased Estiamtor- UMVUE) بدست آورد. منظور از یکنواخت این است که این برآوردگر در کلاس برآوردگرهای نااریب برای همه نقاط فضای پارامتری ($$\theta \in \Theta$$) دارای کمترین واریانس است.

قضیه لهمن-شفه: اگر $$T$$ یک برآوردگر بسنده کامل کراندار و $$U$$ یک برآوردگر نااریب برای پارامتر $$\theta$$ باشند، آنگاه $$E(U|T)$$ برآوردگر UMVUE برای $$\theta$$ است.

براساس این قضیه، مشخص است که در بین برآوردگرهای نااریب میانگین جامعه ($$\mu$$)، میانگین نمونهای ($$\overline{X}$$) دارای کمترین واریانس بوده، بنابراین UMVUE محسوب میشود.

اگر مطلب بالا برای شما مفید بوده است، احتمالاً آموزشهایی که در ادامه آمدهاند نیز برایتان کاربردی خواهند بود.

- مجموعه آموزشهای آمار، احتمالات و دادهکاوی

- آموزش آمار و احتمال مهندسی

- مجموعه آموزشهای نرمافزارهای آماری

- آموزش آزمون های فرض مربوط به میانگین جامعه نرمال در SPSS

- آزمون های فرض و استنباط آماری — مفاهیم و اصطلاحات

- آماره بسنده (Sufficient Statistic) و بسنده مینیمال — به زبان ساده

- احتمال شرطی (Conditional Probability) — اصول و شیوه محاسبه

^^