کنترل بهینه در متلب – از صفر تا صد

در آموزشهای قبلی مجله فرادرس، با جایابی قطب برای طراحی کنترلکننده آشنا شدیم. دیدیم که جایابی قطب روشی است که در آن، یک ماتریس بهره محاسبه میشود و با استفاده از فیدبک حالت، قطبهای سیستم حلقهبسته در جای مطلوب قرار میگیرند. البته، انتخاب قطبهای مطلوب سیستم را به صورت تقریبی و تجربی انجام دادیم. اما، با استفاده از کنترل بهینه میتوانیم قطبها را به صورت بهینه انتخاب کنیم. در این آموزش درباره کنترل بهینه و پیادهسازی آن در متلب بحث خواهیم کرد.

مقدمه

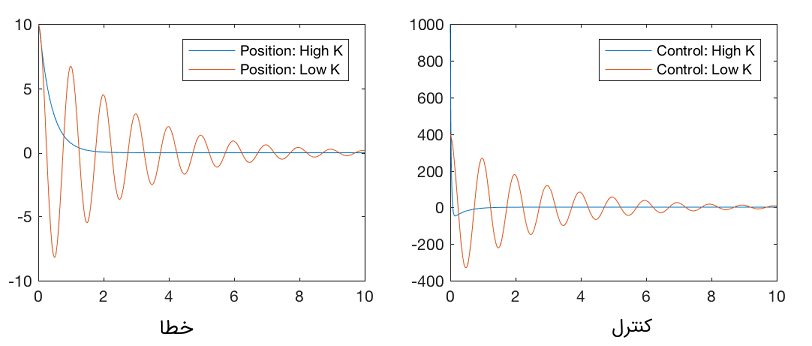

برای مثال، سیستم انتگرالگیر دوگانه را در نظر بگیرید. فرض کنید دو کنترلکننده با ماتریسهای بهره بزرگ و کوچک طراحی کردهایم. شکلهای زیر پاسخ سیستم را برای این دو کنترلکننده نشان میدهند. همانطور که در این شکلها مشخص است، هرچه بهره بزرگتر باشد، خطا زودتر به صفر میل میکند و البته سیگنال کنترل نیز بزرگتر خواهد بود. بنابراین، با انتخاب یک ماتریس بهره مناسب، طراح کنترل میتواند بین مقادیر بالا و پایین، نقطه بهینهای را انتخاب کند که در آن، خطا با سرعت مناسب و سیگنال کنترلی معقولی به صفر میل کند. برنامه متلب زیر، مربوط به رسم دو نمودار است. میتوانید مقادیر بهره را تغییر دهید و نتایج را با هم مقایسه کنید.

در ادامه، با فرمولبندی کنترل بهینه و رگولاتور خطی درجه دوم آشنا میشویم.

فرمولبندی کنترل بهینه

کنترل بهینه را میتوان با در نظر گرفتن موارد مختلف فرمولبندی کرد. در ادامه برخی موارد را بیان میکنیم.

حالت کلی: بدون قید زمان، مسیر و کنترل

در این بخش، کلیترین حالت کنترل بهینه را در نظر میگیریم که در آن، هیچ محدودیت یا قیدی برای مسیر، سیگنال کنترل یا زمان رسیدن به هدف وجود ندارد. سیستم زیر را در نظر بگیرید:

که در آن، شرایط اولیه است. میخواهیم قانون کنترل را به گونهای بیابیم که تابع هزینه (Cost Function) زیر کمینه شود:

بنابراین، مسئله کنترل بهینه را میتوان به صورت زیر فرمولبندی کرد:

مشروط به:

و

استخراج شرایط لازم بهینهسازی

اولین گام در به دست آوردن قانون کنترل، استخراج شرایط لازمی است که کنترلکننده در آنها صدق کند. برای انجام این کار، ابتدا معادله دینامیکی سیستم را به صورت یک تابع خطا به انتگرالده اضافه میکنیم:

هامیلتونی (Hamiltonian) یا همیلتونین را به صورت زیر تعریف میکنیم:

اکنون مسئله کنترل بهینه را میتوان به صورت زیر نوشت:

با استفاده از انتگرالگیری جزء به جزء، برای عبارت دوم داریم:

در نتیجه، تابع هزینه به صورت زیر در خواهد آمد:

در ادامه، تغییرات را با توجه به تغییرات ورودی کنترل محاسبه میکنیم. از آنجایی که متغیرهای حالت به ورودی کنترل وابستهاند، تغییرات تلاش کنترلی منجر به تغییرات حالت میشود که آن را با نشان میدهیم. تغییرات تابع هزینه نسبت به برابر است با:

از آنجایی که اختیاری هستند، میتوانیم آنها را به گونهای انتخاب کنیم که برقرار باشد و برای این انتخاب ، یک جواب بهینه خواهیم داشت. شرایط بهینگی به صورت زیر است:

که شرایط مقدار نهایی آن برابر است با:

معادلات به عنوان معادلات کمکحالت (Costate Equations) نیز شناخته میشوند.

قانون کنترل با شرایط مانا داده میشود:

تغییرات زمانی حالتها نیز از رابطه زیر به دست میآید:

و

معادلات حالت و کمکحالت شرایط لازم را مشخص میکنند که قانون کنترل باید در آن صدق کند. شرایط مرزی متغیرهای حالت نیز در شرایط اولیه و شرایط مرزی متغیرهای کمکحالت در زمان نهایی تعریف میشوند. حل این مسئله با مقدار مرزی دو نقطهای بسیار دشوار است و برای حل آن روشهای عددی متعددی وجود دارد. در حالت خاصی که سیستم خطی است، میتوانیم متغیرهای کمکحالت را به عنوان تابعی از متغیرهای حالت و تابع هزینه را به صورت یک تابع درجه دوم از حالتها و کنترل بنویسیم. در این صورت میتوان یک جواب عمومی وابسته به حالت را به دست آورد.

رگولاتور خطی و پیوسته زمان درجه دوم با زمان محدود

در سیستمهای خطی، میتوانیم با بیان کمکحالت به عنوان تابعی خطی از حالتها، یک نمایش مستقل از حالت برای آن بنویسیم. همچنین، در سیستمهای خطی، تابع هزینه یک تابع درجه دوم از حالت و کنترل است. این فرم به عنوان کنترل یا رگولاتور مرتبه دوم خطی (Linear Quadratic Regulator) یا LQR نامیده میشود. در LQR، قانون کنترل را به گونهای محاسبه میکنیم که تابع هزینه درجه دوم زیر کمینه شود:

که در آن، یک ماتریس معین نیمهمثبت است و هزینه یا ارزش انحراف متغیرها از صفر را نشان میدهد، یک ماتریس معین مثبت است و هزینه کنترل را نشان میدهد، و یک ماتریس معین مثبت است که خطا از مقدار مطلوب نهایی (در اینجا، صفر) را جریمه میکند. ماتریسهای و به صورت یک ماتریس قطری انتخاب میشوند. مقادیر بزرگ خطای مسیر و مقادیر بزرگ کنترل را جریمه میکنند. بنابراین، استفاده از این فرمولبندی، کار طراح کنترل را برای تشخیص قطبهای سیستم آسان کرده و تمرکز او را به تنظیم وزنهای مربوط به هزینه کنترل و خطای ردیابی محدود میکند. یک فرایند طراحی کنترل معمولی با تغییر وزنهای خطای ردیابی و هزینه یا تلاش کنترلی سر و کار دارد تا پاسخ مناسب به دست آید. موارد زیر، توصیههایی برای انتخاب مقادیر مناسب و هستند. نُرم (Norm) یک سنجش برای مقادیر ماتریسها است و نرم (جذر مجموع مربع درایهها) برای هدف ما گزینه مناسبی است. برای انتخاب ماتریسهای و موارد زیر کارساز خواهند بود:

- برای ، تلاش کنترلی با جریمه سنگینی روبهرو خواهد بود، و کنترلکننده حاصل از این انتخاب دیرتر خطا را صفر خواهد کرد.

- برای ، هزینه خطای ردیابی بالا بوده و خطا سریعاً به صفر خواهد رسید.

- میتوان را به گونهای انتخاب کرد که درایههای قطری آن مقادیر متفاوتی داشته باشند. در این حالت، کنترل متناظر با مقدار قطری بزرگتر، کمتر استفاده خواهد شد.

- میتوان را به گونهای انتخاب کرد که درایههای قطری آن مقادیر متفاوتی داشته باشند. در این حالت، حالتهای متناظر با مقادیر قطری بزرگتر، سریعتر به صفر میل میکنند.

اکنون میتوان مسئله کنترل بهینه را به صورت زیر نوشت:

مشروط به

و

با تعریف همیلتونین به صورت زیر:

شرایط بهینگی به صورت زیر خواهد بود:

با شرایط مرزی زیر:

و

انتظار داریم قانون کنترل تابعی از حالتها باشد. بنابراین، را در نظر میگیریم. با مشتقگیری از این رابطه، داریم:

حال این رابطه را در معادله زیر جایگذاری میکنیم:

با توجه به روابط و ، داریم:

با انتخاب ، داریم:

با کمی عملیات جابهجایی در عبارات معادله بالا، میتوان نوشت:

معادله بالا برای همه مقادیر برقرار است، بنابراین:

شرایط مرزی نیز است. معادله بالا، معادله ریکاتی (Riccati Equation) نامیده میشود و جواب آن همان جواب بهینه است.

توجه کنید که در مشتقگیری فرض کردیم زمان نهایی ثابت است. اگر زمان نهایی یک پارامتر قابل تغییر باشد، آنگاه شرط نیز اضافه میشود.

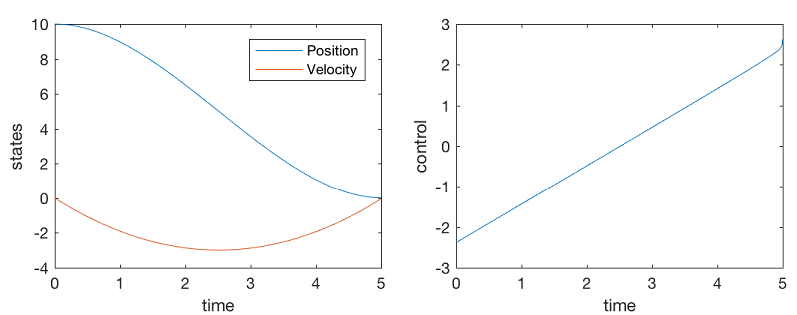

برنامه متلب مربوط به این نوع کنترل بهینه سیستم انتگرالگیر دوگانه به صورت زیر است. به مقادیر عددی تعریف شده در برنامه دقت کنید و برای درک بهتر از طراحی کنترل، آنها را تغییر داده و نتایج را با هم مقایسه کنید.

همانطور که میبینیم اندازه سیگنال کنترل کمتر از ۵ واحد است. هیچ کنترلکننده PID نمیتواند این عملکرد را به نمایش بگذارد و سیگنال کنترل آن به ۱۰۰ ثانیه زمان نیاز خواهد داشت.

رگولاتور خطی و پیوسته زمان درجه دوم با زمان نامحدود

تابع هزینه در حالتی که زمان به بینهایت میل میکند، به صورت زیر است:

در شرایط حالت ماندگار است. بنابراین، معادله ریکاتی به صورت زیر در میآید:

معادله بالا یک معادله جبری است. حل این معادله را میتوان با استفاده از تابع "care" در متلب به دست آورد. برنامه زیر نشان میدهد که چگونه تابع "care" مقادیر بهره بهینه را محاسبه و تابع بالا را کمینه میکند.

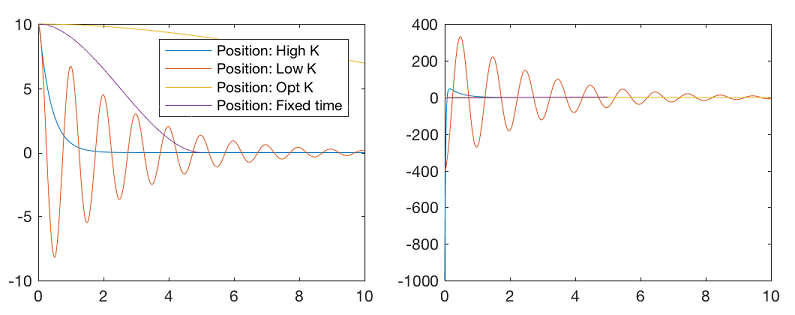

شکلهای حاصل از اجرای برنامه بالا، به صورت زیر هستند.

نمودارهای بالا نشان میدهند که کنترلکننده بهینه خطاها را سریعتر به سمت صفر میبرد و به مقدار سیگنال کنترل کمتری نیاز دارد. کنترلکننده بهینه را میتوان برای سیستمهای گسسته نیز طراحی کرد. در آموزشهای بعدی درباره این موضوع بحث خواهیم کرد.

اگر این مطلب برای شما مفید بوده است، آموزشهای زیر نیز به شما پیشنهاد میشوند:

- سیستم کنترل حلقه باز — به زبان ساده

- تقلب نامه (Cheat Sheet) کنترل خطی

- پاسخ سیستم مرتبه دوم — از صفر تا صد

^^

سلام فوق العاده عالی بود و کمک زیادی به من شد

سلام.

خوشحالیم که آموزشهای مجله فرادرس برایتان مفید بودهاند.

شاد و پیروز باشید.

سلام عالی بود فقط با ورد باشه لطفا