تفاوت خطا و مقدار باقیمانده در محاسبات آماری – به زبان ساده

در بسیاری از «تحلیلهای آماری» (Statistical Analysis) بخصوص در زمینه «مدلسازی» (Modeling) در «یادگیری ماشین» (Machine Learning) با اصطلاح «خطا» (Error) و «مقدار باقیمانده» (Residual) مواجه میشویم. درک درست از مفهوم این اصطلاحات میتواند در توصیف مدل ایجاد شده، برای کسانی که به عنوان «تحلیلگر دادهها» (Data Scientist) مشغول به کار هستند، بسیار مفید باشد. اغلب افرادی که با تجزیه و تحلیل دادهها سروکار دارند، ممکن است باقیمانده را با خطا اشتباه بگیرند. هر چند هر دوی این مقدارها تقریبا به یک شیوه تعریف میشوند ولی روش استفاده از آنها در حوزههای گوناگون، متفاوت است. در این مطلب قصد داریم برای روشن شدن تفاوت بین خطا و مقدار باقیمانده از مثالهایی استفاده کنیم تا درک این دو مفهوم برای خوانندگان بیشتر و بهتر حاصل شود.

هنگام مدلسازی در تحلیلهای رگرسیونی بسیار از خطا و باقیمانده صحبت به میان میآید. بنابراین در این مطلب هم از تکنیکهای رگرسیونی برای بیان تفاوت بین خطا و باقیمانده استفاده خواهیم کرد. از آنجایی که برای این منظور باید از روش و تکنیکهای رگرسیونی آگاه باشید، بهتر است قبلا مطلب رگرسیون خطی — مفهوم و محاسبات به زبان ساده را مطالعه کرده و یا از قبل اطلاعاتی در این زمینه کسب کنید. از طرفی خواندن تحلیل واریانس (Anova) — مفاهیم و کاربردها نیز خالی از لطف نیست زیرا در این تکنیک آماری نیز از مفاهیم خطا و باقیمانده بسیار استفاده میشود.

خطا و مقدار باقیمانده

فرض کنید یک سری مشاهدات از متغیرهای تصادفی یک بُعدی از توزیع یکسانی در اختیارتان هست و قرار است میانگین توزیع را به عنوان یک پارامتر جامعه آماری یا توزیع مورد نظر، برآورد کنید. در اصطلاح مدلسازی میانگین را گاهی «پارامتر مکان» (Location Parameter) نیز مینامند. در چنین وضعیتی «خطا» (Error) فاصله یا انحرافی است که مقدار برآورد شده برای پارامتر مکان از مقدار واقعی آن دارد.

البته براساس توابع فاصله یا شیوههای محاسبه انحراف، ممکن است این مقدار به صورتهای متفاوتی بدست آید. ولی نکته مهم در این است که اگر مقدار واقعی پارامتر توزیع مشخص نباشد، نمیتوان خطای برآورد را محاسبه کرد. در ادامه علت این امر مشخص خواهد شد.

به این ترتیب با توجه به توضیحات بالا میتوان این وضعیت را برای توزیع نرمال یک متغیره در نظر گرفت. فرض کنید نمونه تصادفی تایی iid از جامعه نرمال باشند. واضح است که پارامترهای این توزیع به ترتیب میانگین () و واریانس () هستند. به این ترتیب خطا آماری به صورت زیر محاسبه میشود.

واضح است که در این حالت با فرض اینکه هنوز مشاهدهای برای وجود ندارد، خطای نیز یک متغیر تصادفی است که توزیعی مشابه با توزیع دارد. در صورتی که مقادیر متغیر تصادفی مشاهده شود و پارامتر توزیع نیز معلوم باشد، میتوان خطاها را به ازاء هر مشاهده، به شکل زیر محاسبه کرد.

در نتیجه میانگین خطا به صورت زیر در خواهد آمد.

برای مثال فرض کنید متوسط سن دانشجویان در یک دانشگاه (جامعه آماری) برابر با ۲۱ سال است. یک دانشجو به تصادف انتخاب شده و سنش مورد پرسش قرار گرفته است. به این ترتیب مشخص شده که سن او برابر با ۲۷ سال است. در این حالت مقدار خطا سن این فرد از میانگین سن دانشجویان (میانگین جامعه آماری) برابر با است.

اگر هدف از انجام بررسی آماری محاسبه مجموع مربعات خطا باشد (مانند روش تحلیل واریانس) میدانیم که توزیع آماری این شاخص مرتبط با توزیع کای ۲ با درجه آزادی است. به این ترتیب خواهیم داشت:

نکته: همانطور که مشاهده شده، خطای آماری () یک متغیر تصادفی است در حالیکه مقدار خطای آماری () براساس مقادیر مشاهده شده از متغیرهای تصادفی حاصل میشود.

در مقابل باقیمانده یا مقدار «اختلاف برازش» (Fitting Deviation)، مقداری است که براساس برآورد میزان خطای آماری حاصل میشود. فرض کنید به کمک روشهای برآوردیابی مثلا روش حداکثر درستنمایی (با فرض معلوم بودن واریانس) میدانیم که برآوردگر مناسب برای میانگین جامعه نرمال، میانگین نمونه () است.

در این حالت باقیمانده با نشان داده شده و به صورت زیر محاسبه میشود.

از آنجایی که میدانیم ها متغیر تصادفی هستند، باقیمانده نیز متغیر تصادفی است. به مانند قبل اگر هدف، محاسبه مربعات مقادیر باقیمانده باشد، توزیع آماری آن، کای ۲ با درجه آزادی خواهد بود. در این صورت رابطه زیر برقرار است.

توجه داشته باشید که هم در مجموع مربعات خطا و هم در باقیماندهها، فرض بر معلوم بودن واریانس در جامعه آماری است و خطا یا باقیمانده برای میانگین جامعه آماری نسبت به مشاهدات محاسبه شده است. از طرفی تفاوت در توزیع آماری مجموع مربعات خطا و باقیمانده نیز دیده میشود بطوری که در اولی درجه آزادی توزیع کای ۲ برابر با و در دومی برابر با است.

نکته: با توجه به قضیه باسو مشخص است که میانگین نمونه آماری از مجموع مربعات باقیماندهها مستقل است. در نتیجه نسبتی که در رابطه زیر نوشته شده دارای توزیع با درجه آزادی خواهد بود. البته باید توجه داشت که منظور از نیز انحراف استاندارد نمونهای برای نمونه تصادفی است.

خطا و مقدار باقیمانده در رگرسیون

تشخیص تفاوت بین خطا و مقدار باقیمانده در تجزیه و تحلیل رگرسیون مقداری گنگ بوده ولی بسیار مهم است. بر این اساس مفاهیم دیگری مانند باقیماندههای Studentized در مقابل باقیماندههای Standardized ظاهر میشود. اگر در رگرسیون خطی یک تابع به شکل خط با پارامتری نامعلوم بیانگر رابطه بین متغیر مستقل و متغیر وابسته باشد، فاصله یا اختلاف بین مقدارهای واقعی متغیر وابسته و مقدارهای پیشبینی شده توسط تابع خطی، خطای غیرقابل مشاهده را مشخص میکند، زیرا هنوز پارامترهای مدل خطی برآورد نشدهاند.\

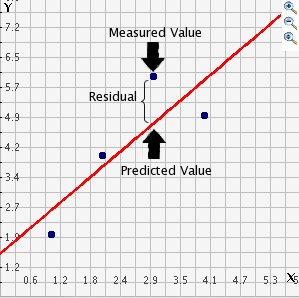

ولی اگر پارامترهای مدل توسط زوج مشاهدههای مربوط به و به عنوان متغیرهای مستقل و وابسته برآورد شده باشد، اختلاف بین مقدار واقعی (Measured Value) و مقدار «برازش شده» (Fitted Value) یا «مقدار پیشبینی شده» (Predicted Value) توسط مدل (که پارامترهای آن مشخص است)، باقیمانده را تعیین میکند.

شاید مفهوم خطا و باقیمانده در تعریف «میانگین مربعات خطا» (Mean Squared Error - MSE) بهتر قابل درک باشد. MSE برای یک مدل رگرسیونی، مقداری است که براساس مجموع مربعات باقیماندهها حاصل میشود و ارتباطی با خطاهای غیرقابل مشاهده ندارد. اگر مجموع مربعات باقیماندهها را بر تعدادشان یعنی تقسیم کنیم میانگین مربعات باقیمانده حاصل خواهد شد. در ادامه این رابطه برای متغیر وابسته محاسبه شده است.

از آنجایی که میانگین مربعات باقیمانده ارائه شده در رابطه بالا، برآوردگر «اریب» (Biased) برای واریانس خطا محسوب میشود آن را به صورت نشان دادهایم. با تقسیم مجموع مربعات باقیماندهها بر برآوردگر نااریب واریانس خطا بدست خواهد آمد. واضح است که در اینجا تعداد پارامترهای برآورد شده و درجه آزادی برای مجموع مربعات باقیماندهها در نظر گرفته شده است. این «آماره» (Statistic) که به عنوان برآوردگر نااریب واریانس خطاهای غیرقابل مشاهده در نظر گرفته میشود مطابق با رابطه زیر محاسبه میشود.

یکی دیگر از روشهای آماری که وابسته به خطا و باقیمانده است، تکنیک «تحلیل واریانس» یا (ANOVA (Analysis of Variance در تحلیل رگرسیونی است. به این ترتیب براساس تجزیه «مجموع مربعات کل خطا» مشاهدات (Total Sum of Squared) مربوط به متغیر وابسته به مجموع «مربعات خطای رگرسیون» (Sum of Squared- Regression) و «مجموع مربعات خطا» (Sum of Squared Error)، میتوان نسبت به وجود اختلاف در میانگینهای چند جامعه آماری رای داد. به این ترتیب با استفاده از آمارهای با توزیع ، آزمون فرض آماری نسبت به یکسان یا وجود اختلاف در میانگین جوامع، صورت میگیرد. با مشاهده مقادیر و محاسبه مقدارهای برازش شده، خطاها تبدیل به باقیمانده شده و مقدار آماره آزمون با مقدار توزیع مقایسه میشود. به این ترتیب ملاکی برای رد یا عدم رد فرض صفر بوجود میآید.

از طرف دیگر، در مدل رگرسیونی فرض بر این است که باقیماندهها دارای توزیع یکسان بوده و نسبت به هم مستقل هستند. البته در رگرسیون خطی OLS، فرض نرمال بودن برای خطاها نیز وجود دارد. هر چند در روند انجام تحلیل رگرسیونی، توزیع باقیماندهها برای همه نقاط یکسان در نظر گرفته میشود ولی به علت اینکه مقدارهایی که دور از مرکز یا میانگین متغیر مستقل قرار گرفتهاند، نقش بیشتری در کمینهسازی تابع هدف (کمینهسازی مربعات خطا) دارند، بهتر توسط مدل رگرسیونی برازش میشوند، به معنی دیگر این نقاط دارای خطای کمتری هستند.

به این ترتیب برای مقایسه باقیماندهها در نقاط مختلف متغیر مستقل، باید باقیمانده به شکلی استاندارد شود. این شیوه به نام Studentizing مشهور است. این کار یعنی Studentized کردن باقیماندهها، به شناسایی «نقاط پرت» (Outlier) کمک میکند.

باقیماندههای Studentized

فرض کنید یک مدل رگرسیونی خطی ساده بین متغیر مستقل و وابسته به صورت زیر ایجاد شده است.

به این ترتیب مشخص است که برای زوج رابطه زیر برقرار است.

از طرفی مشخص است که در رابطه بالا منظور از خطای مربوط به مدل در نقطه است. فرض بر این است که این خطاها مستقل و همتوزیع با واریانس ثابت در نظر گرفته شده است. اما برآورد این خطا که همان باقیماندهها هستند براساس مقدارهای مشاهده شده برای متغیرهای مستقل و وابسته بدست میآیند و به نظر میرسد دیگر مستقل از یکدیگر نیستند زیرا در روش OLS شرطهای زیر را باید برایشان در نظر گرفته باشیم.

در رابطههای بالا منظور از باقیمانده مشاهده ام است.

متاسفانه باقیماندهها برعکس خطاها دارای واریانس ثابت و یکسانی نیستند. واریانس باقیماندهها، زمانی که مقدارهای متغیر مستقل از میانگینشان دور میشود، کاهش یافته و زمانی که به میانگین نزدیک میشود، افزایش مییابد. این تغییرات در «تابع اثر» (Influence Function) نیز به خوبی دیده میشود. به این ترتیب برای نشان دادن صحت شرایط مدل رگرسیونی بهتر است به جای مقایسه باقیماندههای استاندارد شده (Standardized) از باقیماندههای Studentized استفاده شود.

فرض کنید ماتریس طرح مدل رگرسیونی را به صورت زیر در نظر گرفتهایم.

به این ترتیب ماتریس تصویر عمودی برای ماتریس طرح (Hat Matrix) را به صورت زیر خواهیم داشت.

این ماتریس عمل برآورد را روی متغیر انجام میدهد. به این معنی که مقدار برازش شده برای بردار به شکل زیر حاصل میشود.

همچنین در نظر داشته باشید که واریانس خطای مدل رگرسیونی را به صورت زیر برآورد کردهایم:

به این ترتیب باقیمانده Studentized شده مطابق با رابطه زیر قابل محاسبه است.

که در آن مولفههای روی قطر اصلی (سطر ام و ستون ام) ماتریس هستند. به این ترتیب ها دارای توزیع مشابه توزیع هستند. یعنی داریم:

که در آن دارای توزیع student't با درجه آزادی است.

خلاصه

همانطور که دیدید، خطا در مباحث آماری به عنوان یک متغیر تصادفی در نظر گرفته شده که وابسته به پارامتر توزیع جامعه آماری است. ولی از طرف دیگر باقیمانده به میزان خطای قابل اندازهگیری گفته میشود که وابسته به برآوردهای حاصل از پارامتر جامعه است. هر چند هر دو مفهوم برای مشخص کردن میزان انحراف به کار گرفته میشوند ولی توزیعهای آماری و زمینه استفاده از آنها با یکدیگر متفاوت است.

در مطالب مربوط به مباحث آماری در اکثر اوقات فاصله یا انحراف را به صورت مربع تفاضل مقدار مشاهده شده از مقدار مورد انتظار در نظر میگیرند. در حقیقت مربع فاصله اقلیدسی ملاک محاسبه خطا یا انحراف است و به این ترتیب جهت اختلاف را از بین میبرند. ولی ممکن است برای از بین بردن جهت اختلاف از روشها یا توابع دیگری نیز استفاده شود. برای مثال از توابع فاصله مانند «فاصله ماهالانوبیس» (Mahalanobis Distance) یا «فاصله منهتن» (Manhattan Distance) نیز در بسیاری از تکنیکهای آماری استفاده شده و مبنای اندازهگیری اختلاف یا خطا را این توابع در نظر میگیرند.به عنوان نمونه، در شیوه محاسبه میانگین قدر مطلق انحرافات از میانه (Median Absolute Deviation) از فاصله منهتن استفاده شده است.

اگر مطلب بالا برای شما مفید بوده است، آموزشهای زیر نیز به شما پیشنهاد میشوند:

- مجموعه آموزشهای آمار، احتمالات و دادهکاوی

- مجموعه آموزشهای SPSS

- مجموعه آموزشهای نرمافزارهای آماری

- مجموعه آموزشهای مدل سازی، برازش و تخمین

- رگرسیون خطی چندگانه (Multiple Linear Regression) — به زبان ساده

- هم خطی در مدل رگرسیونی — به زبان ساده

^^

سلام، وقت بخیر

ببخشید منظور از باقی مانده استاندارد و استیودنت شده چیست؟ پیشاپیش از پاسخگوییتان ممنونم.

باسلام

در حال مطالعه و تحقیق روی پیش بینی روزبعد و وسط روز هستم . از انجاییکه rmse یا mae وسط روز از پیش بینی روز بعد کمتر هست میخواستم بپرسم :

ارتباط rmse یا mae با distribution function چی هست؟ هرچقدر rmse یا mae کوچکتر باشد چه تاثیری در Distribution function میگذارد؟

ایا کمتر شدن rmse منجر به کوچکتر شدن standard deviation تابع توزیع احتمالی میشود؟

سلام وقت به خیر

آیا بهتر نیست mean square error را «خطای میانگین مربعات» ترجمه کرد؟

یعنی خطایی که با محاسبهی میانگین مربعات اختلاف بین مولفههای دو بردار به دست میآید.

یا مثلا mean absolute error را به صورت «خطای میانگین قدرمطلقها» ترجمه کرد. یعنی خطایی که از میانگین گیری قدرمطلق اختلاف بین مولفههای دو بردار به دست میآید.

ممنون میشوم پاسخ دهید.

سلام دوست و همکار عزیز،

مبنای ترجمه اصطلاحات آماری و تخصصی در نوشتارهای فرادرس، واژه نامه پژوهشکده آمار ایران (+) است. در آنجا MSE به عنوان میانگین توان دوم خطاها یا میانگین مربعات خطا مطرح شده است.

از این که همراه مجله فرادرس هستید بسیار سپاسگزاریم.

جواب این سوال میشه بدید

در یک طرح کاملا تصادفی تعداد۴تیماردر ۵تکرارموردارزیابی قرارگرفته اند جمع مجذورات داخل تیمار به ترتیب برابر۲۵,۲۰,۱۰,۹محاسبه شده اند مقدار واریانس خطا در این ازمایش چقدر است؟؟

چه طوری باید حساب کنم

عرض سلام، ادب و احترام خدمت دکتر ری بد

ضمن تشکر از مطالب آموزشی خوبتون، می خواستم اگر مقدور هست، زحمت بکشید در مورد این جمله که در پاسخ به یکی از کاربران نوشتید، توضیح بدین : ” اگر آزمون های آماری نشان دهند که این اختلاف قابل تعمیم به جامعه آماری است و نه خطای نمونهگیری، می گوییم میانگین دو جامعه اختلاف معنیداری دارند یا از لحاظ آماری اختلاف دارند.” اینکه چطوری می تونیم با آزمون ها اختلاف رو به جامعه تعمیم بدیم؟پیشاپیش متشکرم.

سلام و روز بخیر

همانطور که میدانید، آزمونهای آماری امکان استنباط از نمونه به جامعه را فراهم میکنند. به این ترتیب اگر میانگین دو نمونه آماری با هم اختلاف داشته باشند، دلیلی بر وجود اختلاف در بین دو جامعه نیست. ولی اگر آزمون آماری نشان دهد که اختلاف بین مثلا میانگین دو نمونه قابل تعمیم به دو جامعه هستند، میگوییم. دو جامعه دارای اختلاف معنیداری در میانگینها هستند.

ولی اگر اختلاف در میانگین دو نمونه وجود داشته ولی نتوان آن را به جامعه تعمیم داد، خواهیم گفت، تفاوت موجود در بین میانگین دو نمونه، ناشی از خطای نمونهگیری بوده و قابل تسری به جامعه آماری نیست.

از اینکه مطالب مجله فرادرس را دنبال میکنید، بسیار سپاسگزاریم.

تندرست و پیروز باشید.

مثل سایر مقالاتتون عالی…حرف ندارید.

جواب این سوال لطف میکنید هر چه زودتر پاسخ بدین

اختلاف آماری چیست ؟مفهوم مخالف آن چیست؟

سلام و وقت بخیر

از اینکه همراه مجله فرادرس هستید بسیار خوشحالیم.

اختلاف آماری متفاوت با اختلاف ریاضیاتی است. برای مثال اختلاف ۵ و ۴ برابر است با ۱ و مشهود است. در حالیکه اختلاف میانگین دو جامعه که توسط نمونهها حاصل از هر یک از آنها حاصل شده ممکن است معنی دار نباشد. به این معنی که میانگین نمونه اول که مربوط به جامعه اول است برابر با ۵ است و میانگین نمونه دوم که برآورد میانگین جامعه دوم است، نیز برابر با ۴ شده ولی از لحاظ آماری ممکن است این اختلاف واقعا در بین میانگین دو جامعه وجود نداشته باشد و فاصله مشاهده شده ناشی از نمونه گیری باشد. اگر آزمون های آماری نشان دهند که این اختلاف قابل تعمیم به جامعه آماری است و نه خطای نمونهگیری، می گوییم میانگین دو جامعه اختلاف معنیداری دارند یا از لحاظ آماری اختلاف دارند.

موفق و تندرست باشید.