سیستم توصیه گر چیست و چگونه کار می کند؟ – به زبان ساده

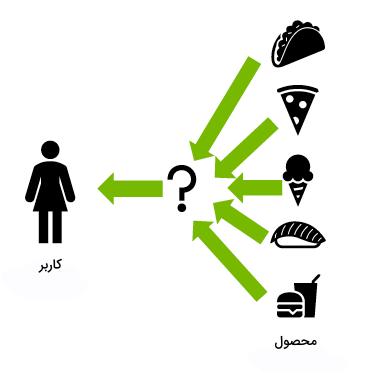

حتما برای شما نیز پیش آمده که هنگام انتخاب فیلم، آهنگ جدید یا محصول مناسب برای خرید دچار شک و تردید شوید. در چنین مواقعی «سیستمهای توصیهگر» (Recommendation Systems) بهکار آمده و بر اساس انتخابهای گذشته و همچنین علاقهمندیها، افراد را در انتخاب گزینه ایدهآل راهنمایی میکنند. در این مطلب از مجله فرادرس یاد میگیریم سیستم توصیه گر چیست و نحوه کارکرد آن چگونه است. نرمافزارهایی هوشمند که برای توصیه محصولات بر اساس رفتار و سلیقه کاربر طراحی شدهاند.

- یاد میگیرید که سیستم توصیهگر چه نقشی در فناوری امروز دارد.

- با مدلهای پالایش گروهی، مبتنی بر محتوا و ترکیبی آشنا میشوید.

- میآموزید چگونه معیارهای دقت و پوشش را برای ارزیابی بهکار ببرید.

- روش پیادهسازی نمونههای عملی با Python را تجربه میکنید.

- خواهید آموخت ابزارهای پیشرفته مانند تجزیه ماتریس و شبکههای عصبی را بهکار بگیرید.

- نقش سیستم توصیهگر در بهبود تجربه کاربری و افزایش ارزش کسبوکار را بررسی میکنید.

در این مطلب، ابتدا یاد میگیریم منظور از سیستم توصیه گر چیست و بهطور کلی چه پیشنهاد یا توصیهای مناسب و خوب در نظر گرفته میشود. سپس با انواع و همچنین کاربردهای سیستمهای توصیهگر آشنا میشویم و به بررسی مزایا و نحوه کارکرد این سیستمها میپردازیم. در انتهای این مطلب از مجله فرادرس شرح جامعی از رویکردهای مورد استفاده برای پیادهسازی یک سیستم توصیهگر ارائه میدهیم.

منظور از سیستم توصیه گر چیست؟

در حقیقت سیستم توصیهگر نوعی هوش مصنوعی یا الگوریتم هوشمند مرتبط با یادگیری ماشین است که از «کلان داده» برای پیشنهاد یا توصیه محصولات بیشتر به مصرفکننده استفاده میکند. این پیشنهادها ممکن است بر اساس شاخصهای متنوعی همچون خریدهای گذشته، تاریخچه جستجو و اطلاعات جمعیتشناختی ارائه شوند. سیستمهای توصیهگر کاربران را در یافتن محصولاتی کمک میکنند که در غیر این صورت و به تنهایی از وجود آنها مطلع نمیشدند و به همین دلیل بسیار کارآمد هستند. برای یادگیری بیشتر درباره سیستمهای توصیهگر، میتوانید فیلم آموزش عملی سیستمهای پیشنهادگر فرادرس را از طریق لینک زیر مشاهده کنید:

بهطور معمول هر سیستم یا سامانه توصیهگر بهگونهای آموزش میبیند که بتواند با استفاده از اطلاعات تعاملی جمعآوری شده از افراد و محصولات، اولویتها را شناسایی کرده و درک جامعی از تصمیمات گذشته بهدست آورد. از جمله این اطلاعات میتوان به تعداد بازدید، کلیک، لایک و پرداختها اشاره کرد. با توجه به توانایی پیشبینی علایق و خواستههای مشتری آن هم در سطح بالا و شخصیسازی شده، سیستمهای توصیهگر مورد توجه شرکتهای بسیاری قرار گرفتهاند. شرکتهایی مانند گوگل، اینستاگرام، اسپاتیفای، آمازون و نتفلیکس برای ارتقا تعامل خود با کاربران از سیستمهای توصیهگر بهره میبرند.

به عنوان مثال اسپاتیفای که پلتفرمی برای پخش آنلاین محتوای صوتی است، از سیستم توصیهگر برای شناسایی آهنگهای مشابه به آثار پرتکرار و مورد علاقه شما استفاده کرده و باعث میشود تا زمان بیشتری را در پلتفرم و برای شنیدن آهنگهای جدید سپری کنید. شرکت آمازون نیز مثال دیگری است که مطابق با اطلاعات جمعآوری شده از هر کاربر، محصولات تازهای را به او پیشنهاد میدهد.

چه پیشنهاد یا توصیه ای خوب است؟

حالا که میدانیم تعریف سیستم توصیه گر چیست، در این بخش با مفهوم و راههای شناسایی توصیه خوب آشنا میشویم. انتخاب معیار مناسب برای تشخیص و تعریف پیشنهاد یا توصیه خوب چالشی است که سازمانهای بسیاری با آن مواجه هستند. اگر مشخص کنیم منظورمان از «خوب» چیست، ارزیابی عملکرد سیستم توصیهگر به مراتب راحتتر میشود. کیفیت یک پیشنهاد را میتوان با تکنیکهای متنوعی همچون «دقت» (Accuracy) و «پوشش» (Coverage) اندازه گرفت.

نسبت پیشنهادهای درست به کل پیشنهادهای ممکن را دقت و درصدی از موارد جستجو شده که برای سیستم توصیهگر قابل شناسایی هستند را پوشش مینامند. دقت داشته باشید که روش ارزیابی و سنجش پیشنهادها وابسته به دیتاست و رویکردی است که در وهله اول برای تولید هر پیشنهاد اتخاذ کردهایم.

سیستمهای توصیهگر شباهتهای مفهومی زیادی با مسائل مدلسازی «طبقهبندی» و «رگرسیون» دارند. در شرایط ایدهآل میخواهید از بازخورد کاربران نسبت به پیشنهادی که به آنها شده باخبر شوید و پیوسته عملکرد سیستم خود را توسعه دهید. فرایندی دشوار که به تجربه زیادی نیاز دارد.

آموزش سیستم های توصیه گر با فرادرس

سیستمهای توصیهگر یکی از کاربردیترین شاخههای یادگیری ماشین هستند که در بسیاری از سرویسهای آنلاین مورد استفاده قرار میگیرند. این سیستمها با تحلیل رفتار و ترجیحات کاربر، محتوا یا محصولات مورد علاقه او را پیشنهاد میدهند. سیستمهای توصیهگر انواع مختلفی داشته که در صنایع مختلفی از جمله تجارت الکترونیک، پخش رسانه، شبکههای اجتماعی و خدمات آنلاین بهکار میروند.

با توجه به اهمیت روزافزون سیستمهای توصیهگر در جهان دیجیتال و همچنین نقش کلیدی زبان برنامهنویسی پایتون در پیادهسازی این سیستمها، یادگیری عملی این مفاهیم میتواند برای متخصصان داده و توسعهدهندگان بسیار ارزشمند باشد. اگر مایل به یادگیری عمیقتر و کاربردی سیستمهای توصیهگر هستید، مجموعه فرادرس فیلمهای آموزشی جامعی را تولید کرده است که از آشنایی با مبانی نظری تا پیادهسازی عملی این سیستمها با زبان برنامهنویسی پایتون راهنمای شما خواهند بود. برای تهیه و مشاهده این دوره آموزشی به لینک زیر مراجعه کنید:

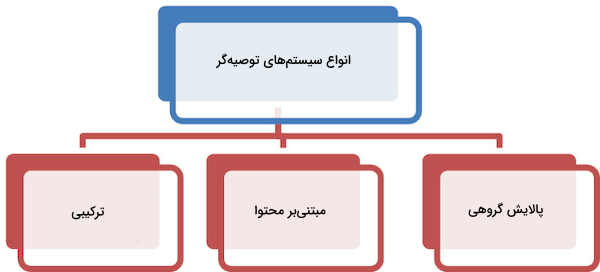

انواع سیستم توصیه گر چیست؟

در حالی که تکنیکها و الگوریتمهای متعددی در زمینه سیستمهای توصیهگر وجود دارند، اغلب در سه گروه زیر خلاصه میشوند:

- سیستمهای «پالایش گروهی» (Collaborative Filtering)

- سیستمهای «مبتنی بر محتوا» (Content Based)

- سیستمهای «ترکیبی» (Hybrid)

در ادامه این بخش، علاوهبر معرفی دقیقتر این سه روش، از مزایا و معایب آنها میگوییم و مثالی همراه با پیادهسازی به زبان برنامهنویسی پایتون برای هر کدام ارائه میدهیم.

سیستم های پالایش گروهی

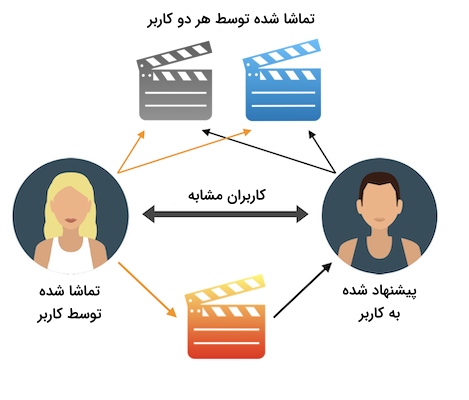

پالایش گروهی فرایندی است که از طریق شناسایی اولویتها و اطلاعات جمعآوری شده، علایق احتمالی کاربران را شناسایی میکند. در واقع پالایش گروهی فرض میگیرد که اگر دو کاربر A و B سلیقه مشابهی نسبت به یک محصول خاص دارند، احتمالا نسبت به کالاهای دیگر نیز احساس مشترکی داشته باشند. در فهرست زیر به انواع رویکردهای مورد استفاده در پالایش گروهی اشاره شده است:

- رویکردهای مبتنی بر حافظه: این رویکردها با عنوان «پالایش گروهی مجاورت» (Neighbourhood Collaborative Filtering) نیز شناخته میشوند. در حقیقت امتیاز ترکیبات به اصطلاح «کاربر-محصول» (user-item) بر اساس نمونههای مجاور بهدست میآید. همین رویکرد را هم میتوان به دو گروه کوچکتر با نامهای پالایش گروهی «مبتنی بر کاربر» و پالایش گروهی «مبتنی بر محصول» تقسیم کرد. پالایش گروهی مبتنی بر کاربر به این معنی است که کاربران همسلیقه، پیشنهادات مشابهی دریافت میکنند. اما در پالایش مبتنی بر محصول، ابتدا با بهرهگیری از امتیاز کاربران، شباهت میان کالاها محاسبه شده و سپس محصولات پیشنهاد میشوند.

- رویکردهای مبتنی بر مدل: یا همان مدلهای پیشبینی کنندهای که از یادگیری ماشین استفاده میکنند. در این رویکرد ویژگیهای دیتاست به عنوان ورودی مدل و برای حل مسائل بهینهسازی بهکار گرفته میشوند. روشهای مبتنی بر مدل از الگوریتمهایی مانند درخت تصمیم و رویکردهای قاعده محور استفاده میکنند.

مزایا

پیادهسازی سیستمهای پالایش گروهی راحت است و در زمینههای مختلفی کاربرد دارند. از طرف دیگر، بدون نیاز به درک محتوای کالا، جزئیترین ویژگیها را نیز استخراج میکنند.

معایب

از جمله مهمترین معایب این سیستمها میتوان به ضعف در پیشنهاد کالاهای جدید اشاره کرد. زیرا هیچ تعاملی میان نمونه دادههای دیتاست با محصول جدیدی که قرار است پیشنهاد شود وجود ندارد. الگوریتمهای مبتنی بر حافظه در مقابل دیتاستهای کوچک عملکرد قابل قبولی از خود به نمایش نمیگذارند.

مثال

برخی از مثالهای رویکرد پالایش گروهی عبارتاند از:

- پیشنهاد محتوای ویدئویی در پلتفرم یوتوب به کاربران: هنگام استفاده از پلتفرم یوتوب، ویدئوهایی به شما توصیه میشود که به افراد همسلیقه شما نمایش داده شده و مورد استقبال قرار گرفتهاند.

- پیشنهاد دورههای آموزشی در پلتفرم کورسرا: پیشنهاد دورههای آموزشی در پلتفرم کورسرا، بر اساس میزان علاقهمندی کاربرانی که دورههای مشابه با شما را به اتمام رساندهاند انجام میشود.

پیاده سازی

ابتدا و از طریق قطعه کد زیر، دیتاستی با موضوع کتاب و متشکل از دادههای مصنوعی تولید میکنیم:

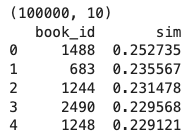

این دیتاست شامل ۱۰۰ هزار سطر با ۱۰ ستون است که هر سطر اطلاعات مربوط به یک کاربر و کتابی که مطالعه کرده و به آن امتیاز داده است را نشان میدهد. سپس برای پیادهسازی الگوریتم پالایش گروهی از متد svdsکتابخانه SciPy استفاده میکنیم و با محاسبه شباهت میان کاربران و کتابها، ۳ کتاب پیشنهادی به کاربر شماره پنجم را در خروجی نمایش میدهیم:

خروجی مانند زیر است:

همانطور که ملاحظه میکنید، بهترتیب کتابهایی با شناسه ۱۴۸۸، ۶۸۳ و ۱۲۴۴ به کاربر پنجم توصیه شدهاند.

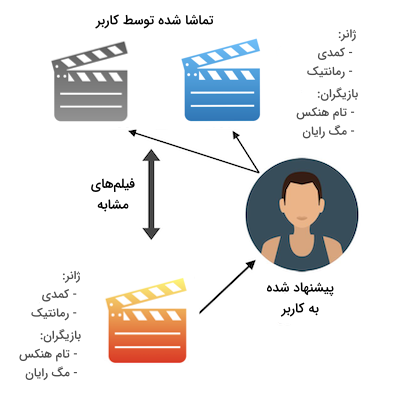

سیستم های مبتنی بر محتوا

در سیستمهای مبتنی بر محتوا هر پیشنهاد مطابق با اولویت کاربران تولید میشود و هدف، پیشنهاد محصولاتی است که مورد پسند کاربران باشند. به بیان دیگر، این کاربران هستند که سطح شباهت میان محصولات را مشخص میکنند. برخلاف مدلهای پالایش گروهی که از امتیازات ثبت شده بین کاربر هدف (کاربری که قرار است محصولی به او پیشنهاد شود) و دیگر کاربران بهره میبرند، در سیستمهای مبتنی بر محتوا تنها امتیازات کاربر هدف اهمیت دارد. سیستمهای مبتنی بر محتوا از منابع مختلفی برای توصیه یک محصول استفاده میکنند که در فهرست زیر به دو مورد از سادهترین آنها اشاره شده است:

- منابع داده در سطح محصول: دسترسی به منابع داده با ویژگیهای کامل در مورد محصولات ضروری است. به عنوان مثال در دیتاست ما، هر سطر از ویژگیهایی مانند قیمت کتاب، تعداد صفحات و سال انتشار تشکیل شده است. هر چه اطلاعات بیشتری از محصولات در اختیار داشته باشید، عملکرد نهایی سیستم قابل اعتمادتر خواهد بود.

- منابع داده در سطح کاربر: برای محصولی که قرار است توصیه شود، به نوعی بازخورد از طرف کاربران نیاز داریم. بازخوردی که میتواند بهشکل صریح یا ضمنی ثبت شده باشد. در دیتاستی که پیشتر ایجاد کردیم، بازخورد کاربران در قالب امتیاز به کتابها ذخیره شده است. هرچه بازخورد بیشتری از کاربران جمعآوری شود، سیستم مبتنی بر محتوا نتایج دقیقتری نشان میدهد.

مزایا

زمانی استفاده از مدلهای مبتنی بر محتوا پیشنهاد میشود که حجم دادههایی که از جنس امتیاز و بازخورد هستند کم باشد. چرا که ممکن است محصولات مشابه دیگر، امتیازدهی شده باشند. در نتیجه حتی اگر تعداد دادهها کم باشد، مدل این توانایی را دارد تا با بهرهگیری از امتیاز محصولات به فعالیت خود ادامه دهد.

معایب

از جمله اصلیترین معایب سیستمهای مبتنی بر محتوا میتوان به موارد زیر اشاره داشت:

- پیشبینی موارد پیشنهادی راحت است. از این موضوع به عنوان یکی از معایب سیستمهای مبتنی بر محتوا یاد میشود، زیرا تنها محتوا یا محصولاتی به کاربر توصیه میشود که از قبل با آنها تعامل داشته است. به عنوان مثال اگر هیچ کتابی از ژانر معمایی نخوانده باشید، سیستم هرگز این گروه از کتابها را به شما پیشنهاد نمیدهد. عملکرد چنین مدلهایی برای هر کاربر متفاوت بوده و از اطلاعات افراد مشابه استفاده نمیشود. از همین جهت تنوع گزینههای پیشنهادی پایین خواهد بود که نکتهای منفی برای بسیاری از کسبوکارها بهشمار میرود.

- برای پیشنهاد به کاربران جدید مناسب نیستند. هنگام طراحی و ساخت مدل، به تاریخچهای از دادهها در سطح کاربر و برای محصولات نیاز دارید. بسیار مهم است که دیتاستی بزرگ از بازخوردها و امتیازات در اختیار داشته باشید. اینگونه احتمال «بیشبرازش» کاهش یافته و خروجی موثرتری حاصل میشود.

مثال

برخی از مثالهای موفق سیستمهای مبتنی بر محتوا عبارتاند از:

- سرویس پیشنهاد کالا وبسایت آمازون

- سرویس پیشنهاد موسیقی پلتفرم اسپاتیفای

پیاده سازی

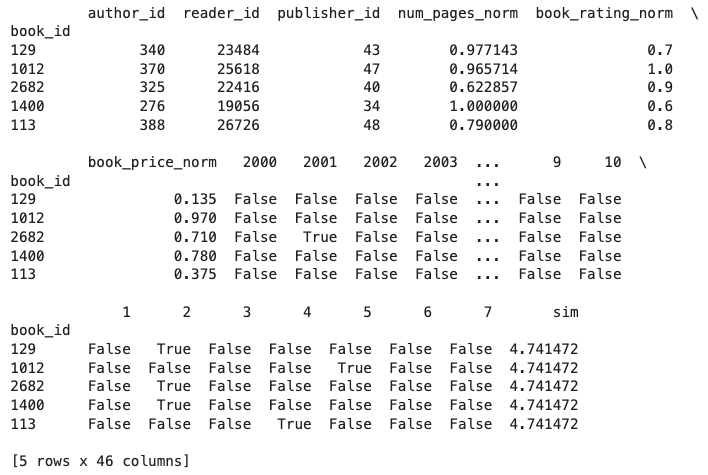

برای پیادهسازی این روش، ابتدا دادهها را از فایل دیتاست با عنوان data.csv بارگذاری میکنیم. در ادامه و پس از نرمالسازی سه ویژگی book_price، book_rating و num_pages که به ترتیب بیانگر امتیاز، قیمت و تعداد صفحات کتاب هستند، سه ویژگی دیگر را با عنوانهای publish_year، book_genre و text_lang به روش «وان هات» کدبندی میکنیم و با محاسبه معیار «شباهت کسینوسی»، پنج کتابی که بیشترین شباهت را با کتاب اول دارند در خروجی نمایش میدهیم:

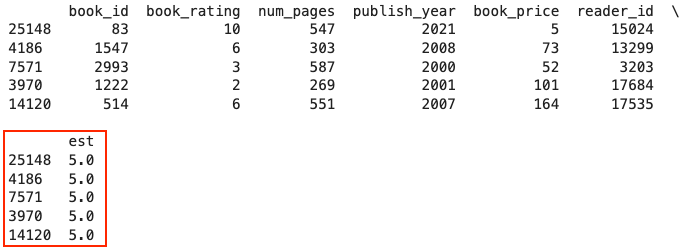

خروجی مانند جدول زیر است:

مطابق با آنچه در خروجی مشاهده میشود، پنج کتاب با شناسههای ۱۲۹، ۱۰۱۲، ۲۶۸۲، ۱۴۰۰ و ۱۱۳ بیشترین شباهت را با اولین کتاب دیتاست دارند.

سیستم های ترکیبی

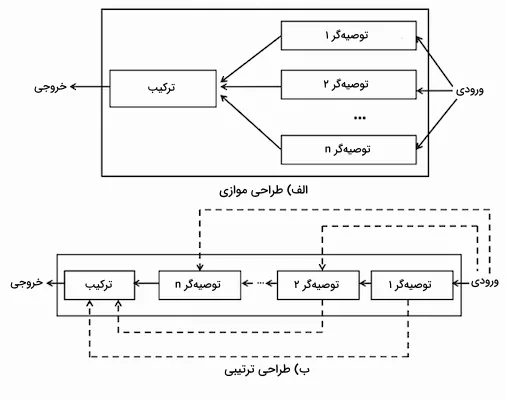

تا اینجا یاد گرفتیم منظور از سیستم توصیه گر چیست و با دو نوع پالایش گروهی و مبتنی بر محتوا نیز آشنا شدیم. هر کدام از این رویکردها مزایا و معایب منحصر به خود را دارند. محدودیت این روشها زمانی بیشتر به چشم میخورد که منابع اطلاعاتی زیادی برای مسئله موجود باشد. طراحی سیستمهای ترکیبی به نحوی است که از دیتاستهای مختلف برای نتیجهگیری کارآمد استفاده میشود. بهطور عمده طراحی سیستمهای ترکیبی به دو روش «موازی» و «ترتیبی» صورت میگیرد. در طراحی موازی، نمونههای ورودی به چند سیستم توصیهگر متفاوت ارسال شده و با ترکیب نتایج این سیستمها، یک خروجی واحد بهدست میآید. در طراحی ترتیبی اما، سیستمهای توصیهگر در امتداد یکدیگر قرار داشته و خروجی هر سیستم، نقش ورودی سیستم دیگر را دارد. در تصویر زیر نمایش دقیقتری از این دو طراحی مشاهده میکنید:

مزایا

با ترکیب چند مدل متفاوت در رویکرد ترکیبی، تلاش میشود تا معایب هر تک مدل جبران شود. در نتیجه عملکرد نهایی بهبود یافته و به پیشنهادهای مفیدتری برای کاربران منجر میشود.

معایب

پیچیدگی محاسباتی این قبیل از مدلها زیاد بوده و برای بهروز ماندن به حجم بالایی از دادهها نیاز دارند. در صورت نادیده گرفتن معیارهای بهروزرسانی مانند امتیاز و میزان تعامل کاربر، ارائه پیشنهادهای جدید و موثر دشوار خواهد بود.

مثال

پلتفرم نتفلیکس از سیستمهای ترکیبی برای پیشنهاد فیلم به کاربران خود استفاده میکند. پیشنهاد فیلم در این سیستم مطابق با سلیقه کاربران مشابه (پالایش گروهی) و فیلمهایی که مشخصات کموبیش یکسانی دارند انجام میشود.

پیاده سازی

مانند قبل، دیتاست را بارگذاری میکنیم و از یک مدل مبتنی بر محتوا یا همان شباهت کسینوسی برای بهدست آوردن ۵۰ مورد از شبیهترین کتابها کمک میگیریم. سپس و با استفاده از مدل پالایش گروهی، امتیازهای احتمالی کاربران را به ۵۰ کتاب انتخابی محاسبه میکنیم. در انتها ۵ مورد از کتابهایی که بالاترین امتیاز پیشبینی شده را دارند در خروجی برمیگردانیم:

خروجی اجرای قطعه کد فوق مانند زیر است:

همانطور که در تصویر نیز با رنگ قرمز مشخص شده است، انتظار میرود پنج کتاب با شناسههای ۲۵۱۴۸، ۴۱۸۶، ۷۵۷۱، ۳۹۷۰ و ۱۴۱۲۰ بیشترین امتیاز را از کاربران کسب کنند.

کاربرد های سیستم توصیه گر

پس از پاسخ دادن به پرسش سیستم توصیه گر چیست و پیادهسازی سه رویکرد پالایش گروهی، مبتنی بر محتوا و ترکیبی، در این بخش از مطلب مجله فرادرس و فهرست زیر به شرح برخی از کاربردهای سیستم توصیهگر میپردازیم:

- تجارت الکترونیک: کاربری را تصور کنید که یک شال خریده است. هنگام خرید از وبسایتهای فروشگاهی، بخشی با عنوان «شاید به این محصولات نیز علاقهمند باشید» وجود دارد که مثالی از سیستمهای توصیهگر است و در چنین موقعیتی، یعنی همراه با خرید شال، کلاهی نیز به خریدار پیشنهاد میشود.

- رسانه و سرگرمی: سامانههای توصیهگر این توانایی را دارند تا خریدهای انجام شده را ارزیابی کرده و با شناسایی الگوهای رفتاری، محتوای مناسبی به کاربران پیشنهاد دهند. شرکتهای گوگل، فیسبوک و نتفلیکس از همین روش برای نمایش تبلیغات و همچنین فیلمها و سریالها استفاده میکنند.

- امور مالی: توجه به امور مالی در توصیه محصولاتی که میلیونها مصرفکننده دارند بسیار حائز اهمیت است. آشنایی با شرایط مالی مشتری و اولویتهای او در ترکیب با دادههای هزاران کاربر مشابه، نتیجهای جز یک سیستم توصیهگر کارآمد ندارد.

مزایا سیستم یا سامانه توصیه گر چیست؟

سیستمهای توصیهگر بخش اساسی از هر نوع تجربه کاربری، تعامل عمیقتر با مشتری و ابزارهای تصمیمگیری موثر در حوزههایی همچون خدمات درمانی، سرگرمی و امور مالی هستند. گاهی سیستمهای توصیهگر تا ۳۰ درصد از درآمد سالانه شرکتهای بزرگ تبلیغاتی را پوشش میدهند. بنابراین حتی بهبود ۱ درصدی در کیفیت سیستمهای توصیهگر نیز با سود چند میلیاردی برابری میکند. شرکتها به دلایل مختلفی دست به پیادهسازی سیستمهای توصیهگر میزنند از جمله:

- حفظ کاربر: با پاسخگویی مداوم به خواستهها و نیاز کاربران، رفته رفته به داراییهای وفادار و ماندگار برای سازمان تبدیل میشوند. کاربران و مشتریهایی که میدانند برای شرکت ارزشمند هستند.

- افزایش فروش: تحقیقات مختلفی نشان میدهند که توصیه محصولات مشابه با علاقهمندیهای کاربر به رشد ۱۰ تا ۵۰ درصدی در سود شرکت منجر میشود. نمایش محصولات مشابه هنگام تسویه حساب و اشتراکگذاری بازخوردها و خرید دیگران، از جمله راهکارهایی است که میزان فروش را افزایش میدهد.

- جهتدهی به گرایش بازار: تداوم در ارائه پیشنهادات مرتبط و دقیق باعث شکل گرفتن عادتهای رفتاری شده و الگوی خرید کاربران را تحت تاثیر قرار میدهد.

- تجزیه و تحلیل سریعتر: با ارائه کالاهای از پیش پردازش شده به کاربران، سرعت تجزیه و تحلیل دادهها تا ۸۰ درصد افزایش مییابد.

- افزایش ارزش سبد خرید: روزانه حجم بالایی از محصولات وارد انبار شرکتهای بزرگ فروشگاهی میشود. این شرکتها با بهرهگیری از سیستمهای توصیهگر میتوانند در زمان مناسب و از طریق وبسایت یا راههای ارتباطی دیگر مانند ایمیل، محصولات جدید خود را در معرض دید کاربر قرار دهند.

سیستم توصیه گر چگونه کار می کند؟

حالا که بهخوبی میدانید سیستم توصیه گر چیست، باید توجه داشته باشید که نحوه کارکرد این سیستمها به نوع داده ورودی بستگی دارد. اگر اطلاعات جدیدی در اختیار نداشته و تنها تعاملات گذشته کاربران را ثبت کردهاید، بهتر است از رویکرد پالایش گروهی استفاده کنید. از طرف دیگر، ممکن است دادههای شما بیانگر ارتباط میان کاربر و محصول باشند که در این صورت میتوانید از رویکرد مبتنی بر محتوا برای مدلسازی تعاملات جدید بهرهمند شوید.

رویکرد های مورد استفاده در سیستم توصیه گر

تا اینجا میدانیم سیستم یا سامانه توصیه گر چیست، چگونه کار میکند و چه کاربرد و مزایایی دارد. در این بخش اما، کمی بیشتر با جزییات و رویکردهایی که برای پیادهسازی انواع سیستمهای توصیهگر مورد استفاده قرار میگیرند آشنا میشویم.

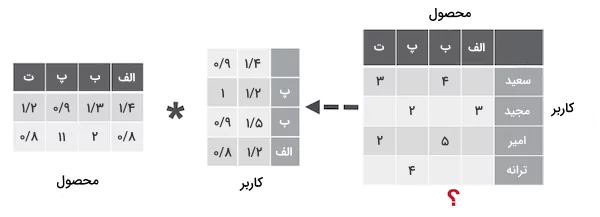

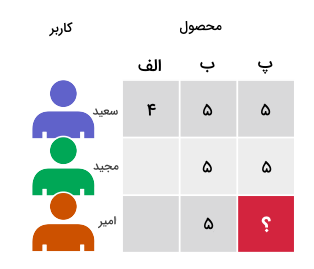

تجزیه ماتریس

تکنیکهای «تجزیه ماتریس» (Matrix Factorization) پایه و اساس الگوریتمهای محبوب بسیاری از جمله «تعبیهسازی واژگان» (Word Embedding) و «مدلسازی موضوعی» (Topic Modeling) هستند و به عنوان رویکردی موثر در سیستمهای توصیهگر پالایش گروهی از آنها یاد میشود. بهطور معمول از تجزیه ماتریس برای محاسبه شباهت در تعاملات میان کاربران و در نهایت پیشنهاد محصول کمک میگیرند. در ماتریس کاربر-محصول ساده زیر، سعید و مجید هر دو فیلمهای «ب» و «پ» را دوست دارند. همچنین امیر به فیلم «ب» علاقهمند است. با بهکارگیری روش تجزیه ماتریس به این نتیجه میرسیم که اگر فردی فیلم «ب» را دوست داشته است، به احتمال زیاد به فیلم «پ» نیز علاقهمند بوده و در نتیجه فیلم «پ» به کاربر امیر پیشنهاد میشود.

در روش تجزیه ماتریس از الگوریتم «کمترین مربعات متناوب» (Alternating Least Squares | ALS) برای تخمین ماتریس خلوت کاربر-محصول با ابعاد در استفاده میشود. این ماتریس از حاصل ضرب دو ماتریس متراکم «کاربر» و «محصول» با ابعاد در و در بهدست میآید و دو نماد و به ترتیب برابر با تعداد کاربران و تعداد محصولات هستند. دو ماتریس کاربر و محصول، ویژگیهایی را از کاربران و محصولات به نمایش میگذارند که الگوریتم در تلاش برای کشف آنها است. الگوریتم ALS برای هر کاربر و محصول، بهطور مداوم «عاملهای» (Factors) عددی را یاد میگیرد که با حرف مشخص شده است. در هر دور از اجرای الگوریتم و تا زمانی که ماتریسها همگرا شوند، یکی از ماتریسها (کاربر یا محصول) بهینهسازی میشود.

مدل های شبکه عصبی عمیق

شبکههای عصبی عمیق از انواع مختلفی تشکیل شدهاند که در فهرست زیر برخی از آنها را معرفی کردهایم:

- جریان اطلاعات و بهطور کلی فرایند آموزش در برخی از شبکههای عصبی از یک لایه به لایه دیگر جریان داشته با عنوان «شبکههای عصبی پیشخور» (Feedforward Neural Networks) شناخته میشوند. از جمله این شبکهها میتوان به شبکههای چندلایه پرسپترون اشاره کرد که از حداقل سه لایه «ورودی»، «مخفی» و «خروجی» تشکیل شدهاند. از شبکههای پرسپترون برای حل مسائل متنوعی استفاده میشود.

- «شبکههای عصبی پیچشی» (CNN) در شناسایی و تشخیص محتوای تصویری کاربرد دارند.

- «شبکههای عصبی بازگشتی» (RNN) در حقیقت موتورهای ریاضیاتی هستند که دادههای دنبالهدار و الگوهای زبانی را تجزیه میکنند.

مدلهای توصیهگر یادگیری عمیق از تکنیکهای موجود مانند تجزیه ماتریس برای مدلسازی ارتباط میان متغیرها و بردارهای «تعبیه شده» (Embeddings) بهره میبرند. یک بردار تعبیه شده، مجموعهای از اعداد است که در آن فاصله کمی میان موجودیتهای مشابه مانند کاربران یا محصولات وجود دارد. اگر میخواهید اطلاعات بیشتری در رابطه با یادگیری عمیق کسب کنید، میتوانید مطلب مجله فرادرس در رابطه با این موضوع را مطالعه کنید.

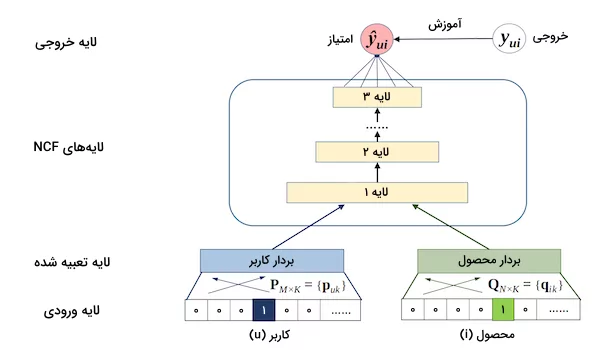

پالایش گروهی عصبی

مدل «پالایش گروهی عصبی» (Neural Collaborative Filtering | NCF) یک شبکه عصبی است که بر اساس تعاملات میان کاربر و محصول، امکان پالایش گروهی را فراهم میکند. در مدل NCF، عمل تجزیه ماتریس بر روی دنبالهای از جفت ورودیهای متشکل از اطلاعات کاربر و محصول اعمال شده و همزمان به یک شبکه پرسپترون نیز منتقل میشوند. پس از ترکیب نتیجه شبکه پرسپترون و تجزیه ماتریس و انتقال به یک لایه متراکم، خروجی یا همان احتمال تعامل کاربر با محصول بهدست میآید.

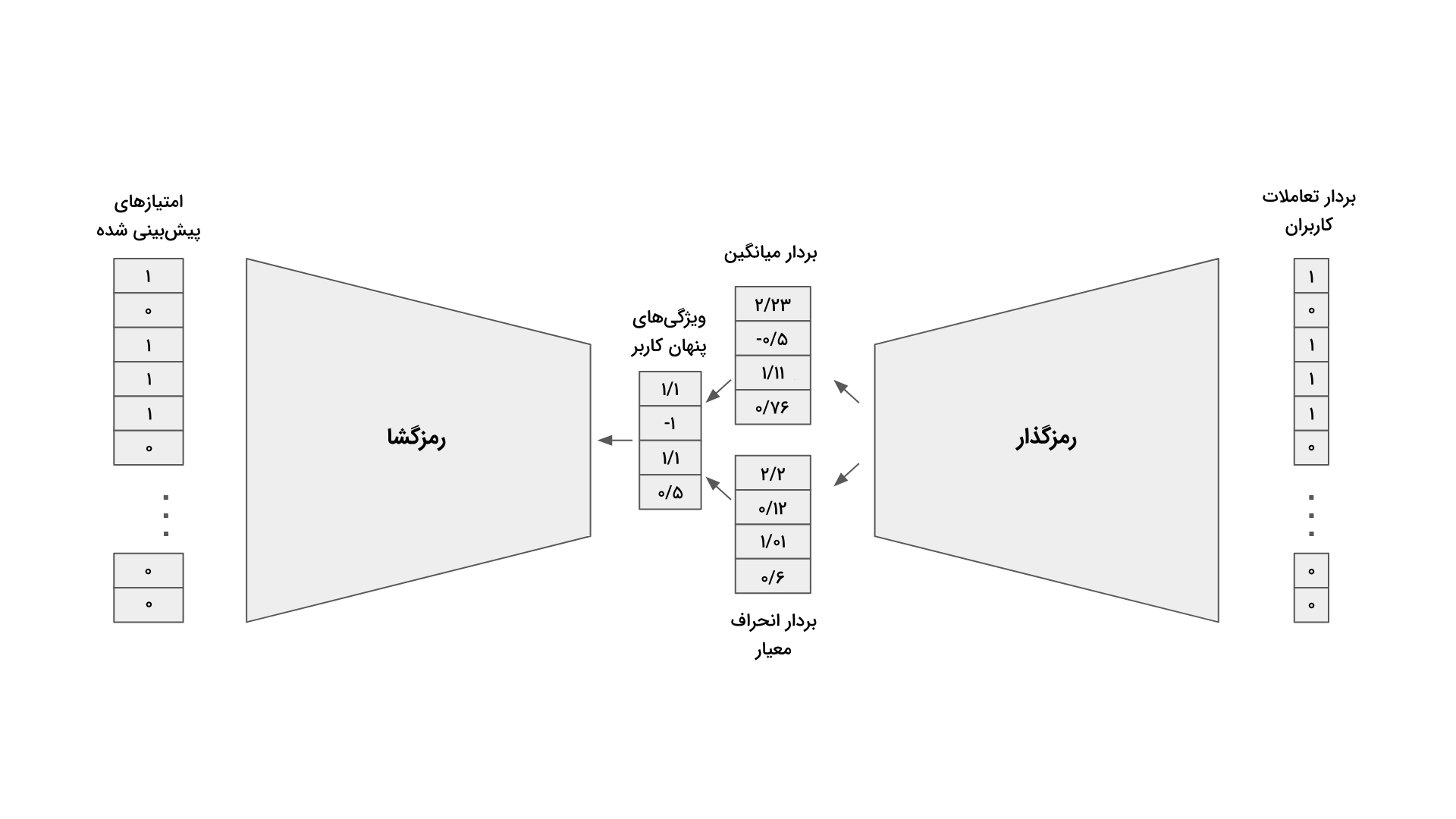

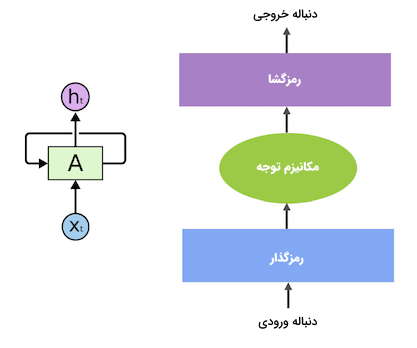

خود رمزگذار متغیر

شبکه عصبی «خود رمزگذار» (Autoencoder) با کمک درک حاصل از لایه مخفی، به نوعی لایه ورودی را در لایه خروجی بازسازی میکند. همچنین در پالایش گروهی و با یادگیری سیستم خود رمزگذار از ماتریس کاربر-محصول است که مقادیر گمشده جایگذاری میشوند. «خود رمزگذار متغیر» پیادهسازی بهینهای برای رویکرد پالایش گروهی است که در آن از جفت دادههای کاربر-محصول برای آموزش مدل استفاده میشود. هر مدل از دو بخش «رمزگذار» (Encoder) و «رمزگشا» (Decoder) تشکیل شده است. بخش رمزگذار، یک شبکه «کامل متصل» (Fully Connected) است که بردار ورودی را به یک توزیع متغیر بعدی تبدیل میکند. از این توزیع برای بهدست آوردن ویژگیهای پنهان کاربر استفاده میشود و سپس به بخش دوم یعنی رمزگشا که مانند بخش اول، نوعی شبکه پیشخور یا Feedforward است انتقال مییابند. خروجی به شکل بردار احتمالاتی از تعاملات کاربر با محصول نمایش داده میشود.

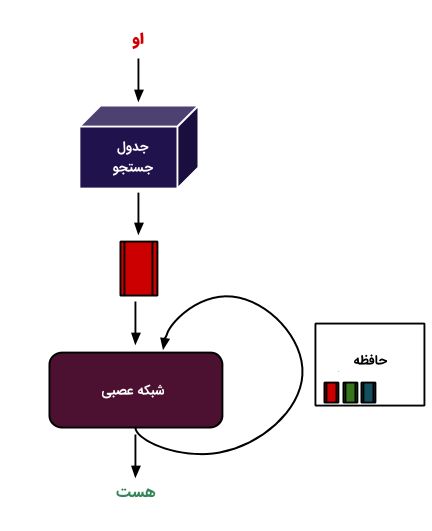

یادگیری توالی متنی

شبکه عصبی بازگشتی یا RNN زیرمجموعهای از شبکههای عصبی با حافظه یا «حلقههای بازخورد» (Feedback Loops) است که امکان بازشناسی الگوهای موجود در دادهها را تسهیل میکند. از جمله کاربردهای RNN میتوان به «پردازش زبان طبیعی» (NLP) و همچنین سیستمهای پیشنهاد «توالی متنی» (Contextual Sequence) اشاره کرد. وجه تمایز یادگیری توالی با سایر رویکردها، در نیاز به استفاده از مدلهایی با حافظه فعال مانند «حافظه طولانی کوتاه مدت» (Long Short Term Memory | LSTM) یا «واحدهای بازگشتی گِیتی» (Gated Recurrent Units | GRU) برای یادگیری وابستگیهای زمانی است. چنین اطلاعاتی برای موفقیت سیستمی که بر پایه یادگیری توالی طراحی شده است بسیار اهمیت دارند. مدلهای «ترنسفورمر» (Transformer) مانند BERT، جایگزینی برای شبکههای عصبی بازگشتی هستند که از مکانیزم «توجه» یا Attention برای تجزیه و توجه به واژگان قبل و بعد از هر جمله استفاده میکنند. مدلهای یادگیری عمیقِ مبتنی بر ترنسفورمر نیازی به داده ترتیبی ندارند و از همین جهت، زمان لازم برای آموزش بسیار کاهش مییابد.

در پردازش زبان طبیعی با استفاده از تکنیکهایی مانند تعبیهسازی واژگان، متن ورودی به چند بردار واژه تبدیل میشود. به بیان ساده، پیش از ارسال ورودی به شبکه RNN، هر واژه به مجموعهای از اعداد قابل فهم برای ترنسفورمر تبدیل میشود. سپس طی فرایند آموزش شبکه عصبی و رمزگذاری اطلاعات متنی، واژگان مشابه به یکدیگر نزدیکتر شده و در مقابل، واژگان متفاوت از هم فاصله بگیرند. عمده کاربرد این مدلها در پیشبینی واژگان و خلاصهسازی متن است. در مثال پیشنهاد فیلم، پس از بهکارگیری رویکرد مبتنی بر محتوا، مجموعه اعداد بهدست آمده برای درک محتوا به یکی از انواع RNN مانند LSTM، GRU یا ترنسفورمرها میشود.

شبکههای عصبی عمیق و یادگیری عمیق نقش مهمی در پیشرفت سیستمهای توصیهگر ایفا میکنند. تکنیکهایی که توانایی سیستمهای توصیهگر را در فهم و درک الگوهای پیچیده و همچنین ارائه پیشنهادات دقیقتر بهطور چشمگیری افزایش دادهاند. شبکههای عصبی عمیق قادر هستند روابط غیرخطی پیچیده میان دادهها را یاد بگیرند و از این طریق، عملکرد سیستمهای توصیهگر را بهبود بخشند.

یادگیری عمیق، به عنوان زیرمجموعهای از هوش مصنوعی، با الهام از مغز انسان، امکان پردازش حجم عظیمی از دادهها و استخراج ویژگیهای مهم را فراهم میکند. قابلیتی که در سیستمهای توصیهگر منجر به ارائه پیشنهادات شخصیسازی شده و دقت بالا میرود. اگر قصد دارید به شکل جامع و کاربردی به پیادهسازی انواع شبکههای عصبی با پایتون بپردازید و بهطور عملی با یادگیری عمیق آشنا شوید، پیشنهاد میکنیم به فیلمهای آموزشی تهیه شده توسط پلتفرم فرادرس که در ادامه قرار گرفته است مراجعه کنید:

- فیلم آموزش پیادهسازی گام به گام شبکههای عصبی در پایتون فرادرس

- فیلم آموزش مبانی یادگیری عمیق فرادرس

جمعبندی

با وجود تمام پیشرفتهای صورت گرفته، روزانه کسبوکارهای بسیاری برای بهبود عملکرد سامانههای توصیهگر در تلاش هستند. این سامانهها با گذشت زمان در حوزههای بیشتری بهکار گرفته میشوند. در این مطلب از مجله فرادرس یاد گرفتیم منظور از سیستم توصیه گر چیست و با انواع و نحوه پیادهسازی هر کدام نیز آشنا شدیم. سیستمهایی که هم برای کاربر و هم سازمان مزایای فراوانی دارند.