معیارهای ارزیابی در یادگیری ماشین – به زبان ساده

مدل یادگیری ماشین الگوریتمی آموزش دیده با مجموعهدادهای مشخص برای پیشبینی پاسخ یک مسئله است. برای بررسی عملکرد نهایی مدل یادگیری ماشین از معیارهای ارزیابی استفاده میشود. ارزیابی مدل مرحلهای ضروری در یادگیری ماشین است که در آن عملکرد یک مدل از پیش آموزش دیده بهوسیله معیارها و روشهایی گوناگون سنجیده میشود. بسیار مهم است که از عملکرد قابل قبول مدل یادگیری ماشین نسبت به دادههای جدید و از پیش دیده نشده اطمینان حاصل کنیم. در این مطلب از مجله فرادرس، با مفهوم و اهمیت ارزیابی مدل آشنا شده و انواع معیارهای ارزیابی در یادگیری ماشین را مورد بررسی قرار میدهیم.

- میآموزید چگونه معیار ارزیابی مناسب با نوع مسئله را انتخاب کنید.

- یاد خواهید گرفت شاخصهای اصلی دستهبندی و رگرسیون را شناسایی و تحلیل کنید.

- یاد میگیرید مفاهیم بیشبرازش، کمبرازش و خطرات نشت داده را بررسی کنید.

- خواهید آموخت تکنیکهایی مانند اعتبارسنجی متقابل را برای سنجش علمی مدل بهکار ببرید.

- میآموزید تأثیر کیفیت و سوگیری دادهها در ارزیابی مدل را بسنجید.

- خواهید توانست نتایج مدل را با تحلیل چندشاخصی بهصورت عملی تفسیر کنید.

در این مطلب، ابتدا تعریفی از ارزیابی مدل ارائه داده و سپس یاد میگیریم که چرا باید مدلهای یادگیری ماشین را ارزیابی کنیم. در ادامه با انواع معیارهای ارزیابی در یادگیری ماشین آشنا شده و روشهای رایج در ارزیابی مدل را بررسی میکنیم. در انتهای این مطلب و پس از معرفی محدودیتهای معیارهای ارزیابی، به سوالات متداول این حوزه پاسخ میدهیم.

منظور از ارزیابی مدل چیست؟

ارزیابی مدل در یادگیری ماشین فرایندی است که در آن با استفاده از معیارهایی از پیش تعیین شده، عملکرد مدل مورد ارزیابی قرار میگیرد. ارزیابی مدل را میتوان به دو صورت انجام داد:

- «برونخط» (Offline): در این روش، مدل پس از آموزش و همزمان در مرحله آزمایش ارزیابی میشود.

- «برخط» (Online): نوعی از ارزیابی که در مرحله تولید و به عنوان بخشی از عملیات «پایش مدل» (Model Monitoring) انجام میشود.

انتخاب نوع ارزیابی به دادهها و الگوریتمهای مورد استفاده شما بستگی دارد و مطابق با نوع مسئله خود، میتوانید ارزیابی مناسب را انتخاب کنید. در «یادگیری نظارت شده» (Supervised Leaning)، معیارهای ارزیابی برای دو روش «دستهبندی» (Classification) و «رگرسیون» (Regression) متفاوت هستند. معیارهای مسائل دستهبندی بر پایه «ماترسی درهم ریختگی» (Confusion Matrix) بوده و شامل روشهای همچون «صحت» (Accuracy)، «دقت» (Precision)، «بازیابی» (Recall) و «امتیاز اِفوان» (F1 Score) میشوند. از طرفی دیگر مسائل رگرسیون بر اساس معیارهایی همچون «میانگین قدر مطلق خطا» (Mean Absolute Error | MAE) و «جذر میانگین مربعات خطا» (Root Mean Squared Error | RMSE) مورد ارزیابی قرار میگیرند. تعریف معیارهای «انسجام» (Cohesion)، «جدایی» (Separation)، «اطمینان» (Confidence) و خطا در خروجی، هدف معیارهای ارزیابی در «یادگیری نظارت نشده» (Unsupervised Learning) است.

به عنوان مثال از معیار «نیمرخ» (Silhouette) برای «خوشهبندی» (Clustering) استفاده میشود تا میزان شباهت یک داده به خوشهای که در آن قرار دارد، در مقایسه با شباهتش به سایر خوشهها اندازهگیری شود. لازم به ذکر است که در هر دو روش یادگیری بهویژه یادگیری نظارت نشده، ارزیابی مدل در حین آزمایش با «مصورسازی» (Visualization) و تحلیل گروه دادهها صورت میگیرد. در آخر باید ارزیابیها توسط «متخصص دامنه» (Domain Expert) بررسی شوند.

چرا ارزیابی مدل در یادگیری ماشین اهمیت دارد؟

همانطور که پیشتر نیز گفته شد، ارزیابی مدل قدمی لازم و ضروری در یادگیری ماشین است که به ما اجازه میدهد تا عملکرد مدل را نسبت به دادههای جدید مورد سنجش قرار دهیم. «بیشبرازش» (Overfitting) یکی از مشکلاتی است که ممکن است پس از آموزش مدل با دادههای آموزشی با آن مواجه شویم. مدل وقتی بیشبرازش میشود که عملکرد خوبی نسبت به دادههای آموزشی داشته باشد و در برخورد با نمونههای جدید ضعیف عمل کند. از همینرو با ارزیابی مدل میتوانیم بهترین مدل یادگیری ماشین را انتخاب کرده و با تخمینی واقعگرایانه از دقت مدل نسبت به دادههای جدید، از بیشبرازش جلوگیری کنیم. همچنین ارزیابی مدل به ما کمک میکند تا به محدودیتهای مدل پیببریم. در نهایت میتوان نتیجه گرفت که فرایند ارزیابی برای توسعه مدلهای یادگیری ماشین پایدار امری ضروری است.

انواع معیارهای ارزیابی در یادگیری ماشین

هنگام ارزیابی عملکرد «مدلهای پیشبینی کننده» (Predictive Models)، از معیارهای ارزیابی متنوعی برای سنجش کارآمدی آنها در زمینههای مختلف استفاده میشود. درک این معیارها نقش مهمی در مقایسه و ارزیابی موثر مدلهای یادگیری ماشین دارد. در زیر چند نمونه از رایجترین معیارهای ارزیابی را فهرست کردهایم:

- «ماتریس درهم ریختگی» (Confusion Matrix)

- «صحت» (Accuracy)

- «دقت» (Precision)

- «بازیابی» (Recall)

- «ویژگی» (Specificity)

- «امتیاز اِفوان» (F1 Score)

- «منحنی دقت-بازیابی» (Precision-Recall | PR Curve)

- «منحنی نمودار مشخصه عملکرد» (Receiver Operating Characteristics | ROC Curve)

- «میانگین مربعات خطا» (Mean Squared Error | MSE)

- «جذر میانگین مربعات خطا» (Root Mean Squared Error | RMSE)

- «میانگین قدر مطلق خطا» (Mean Absolute Error | MAE)

- «ضریب تعیین» (R-squared | Coefficient of Determination)

در ادامه انواع مختلف معیارهای ارزیابی در یادگیری ماشین و همچنین «یادگیری عمیق» (Deep Learning) را بررسی میکنیم.

ماتریس درهم ریختگی

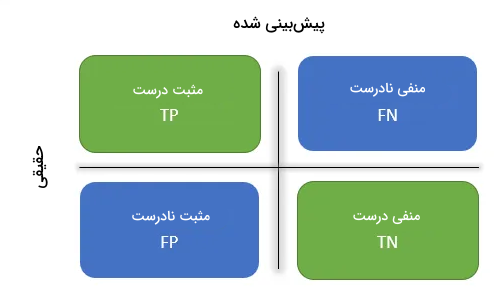

برای درک راحتتر، یک مسئله «دستهبندی دودویی» (Binary Classification) را در نظر میگیریم که در آن قرار است تصویر گربه یا سگی را پیدا کنیم. یا مسئله بیماری که مشخص شده سرطان دارد (مثبت) یا سالم بوده و تست او منفی است. از همین جهت ابتدا باید با چند اصطلاح آشنا شویم:

- «پاسخهای مثبت درست» (True Positives | TP): نمونههایی که مثبت پیشبینی شده و در حقیقت نیز مثبت هستند.

- «پاسخهای مثبت نادرست» (False Positives | FP): نمونههایی که مثبت پیشبینی شده اما در حقیقت منفی هستند.

- «پاسخهای منفی درست» (True Negatives | TN): نمونههایی که منفی پیشبینی شده و در حقیقت نیز منفی هستند.

- «پاسخهای منفی نادرست» (False Negatives | FN): نمونههایی که منفی پیشبینی شده اما در حقیقت مثبت هستند.

«ماتریس درهم ریختگی» (Confusion Matrix) در واقع شکل نمایشی پارامترهای بالا در قالب یک ماتریس است و برای مصورسازی بهتر مورد استفاده قرار میگیرد.

صحت

رایجترین معیار برای ارزیابی یک مدل یادگیری ماشین، که در حقیقت شاخص چندان واضحی برای عملکرد نیست. زمانی که تعداد نمونههای هر دسته یا کلاس اختلاف زیادی با یکدیگر داشته باشند، استفاده از این معیار پیشنهاد نمیشود.

به عنوان مثال، یک مدل تشخیص سرطان را تصور کنید. در شرایط عادی، احتمال سرطان داشتن بسیار پایین بوده و از میان هر ۱۰۰ بیمار، تنها ۱۰ نفر مبتلا هستند. ما نمیخواهیم مراجعه کنندهای که سرطان داشته را با تشخیص منفی نادرست یا FN نادیده بگیریم. قرار دادن همه بیماران در دسته افرادی که سرطان ندارند، صحتی ۹۰ درصد را نتیجه میدهد. در واقع مدل یادگیری ماشین بدون اینکه کار خاصی کرده باشد و تنها با تشخیص سرطان برای همه بیماران به این درصد رسیده است. به همین خاطر است که به معیارهای دقیقتری نیاز داریم.

دقت

نسبت نمونههای مثبت درست (TP) به تمامی نمونههای مثبت پیشبینی شده را «دقت» (Precision) گویند. در این معیار مخرج، پیشبینی مثبت مدل برای تمامی نمونههای موجود در مجموعهداده است. به بیان سادهتر، معیار دقت به این پرسش پاسخ میدهد که از میان تمامی مراجعه کنندگانی که مثبت تشخیص داده شدهاند، چند نسبتی در حقیقت نیز بیمار هستند.

بازیابی

نسبت نمونههای مثبت درست (TP) به تمامی نمونههایی که در حقیقت مثبت هستند را معیار «بازیابی» (Recall) گویند. مخرج در این معیار، جمع تمامی نمونههای مثبت در مجموعهداده است. به بیان سادهتر میتوانیم بگوییم که از میان تمامی مراجعه کنندگان بیمار، چه نسبتی را بهدرستی پیشبینی کردهایم.

ویژگی

معیار «ویژگی» (Specificity) نسبت تعداد نمونههای منفی به کل نمونههای منفی پیشبینی شده است. در این معیار، مخرج تعداد نمونههای منفی در مجموعهداده است. تغییر در نمونههای منفی، وجه تمایز معیار ویژگی با معیار بازیابی است. در واقع میخواهیم بدانیم چه تعداد از مراجعه کنندگان سرطان نداشته و ما نیز به درستی منفی بودن تست آنها را پیشبینی کردهایم. از معیار ویژگی برای اندازهگیری فاصله کلاسی استفاده میشود.

امتیاز F1

امتیاز F1 ترکیبی از دو معیار دقت و بازیابی است. از آنجایی که هر دو معیار دقت و بازیابی در محاسبه امتیاز F1 نقش دارند، امتیاز F1 بالاتر نشاندهنده عملکرد بهتر است. همانطور که در فرمول این معیار نیز مشخص است، بهدلیل وجود عملگر ضرب در صورت مخرج، اگر از میزان یکی از معیارهای دقت یا بازیابی کاسته شود، امتیاز F1 بسیار نزولی میشود. در نتیجه امتیاز F1 یک مدل یادگیری ماشین بالاست، اگر نمونههای مثبت پیشبینی شده در حقیقت نیز مثبت بوده و هیچ نمونه مثبتی به اشتباه منفی پیشبینی نشده باشد.

امتیاز F1 وزن یکسانی به دو معیار دقت و بازیابی میدهد؛ موضوعی که ممکن است مورد پسند ما نبوده و بخواهیم یکی از معیارها اهمیت بالاتری داشته باشد. به همین خاطر در چنین مواردی، معیارهایی همچون «امتیاز F1 وزندار» (Weighted-F1 Score) یا منحنیهای PR و ROC میتوانند مفید باشند.

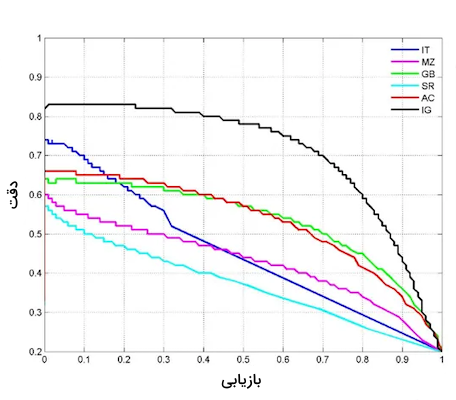

منحنی PR

به منحنی میان دو معیار دقت و بازیابی برای مقادیر «آستانه» (Threshold) مختلف، منحنی PR یا دقت-بازیابی گفته میشود. در نمودار زیر، منحنی دقت-بازیابی ۶ مدل پیشبینی کننده برای مقادیر آستانه مختلف را مشاهده میکنید. قسمت بالا سمت راست نمودار فضای ایدهآلی است که در آن دقت و بازیابی حداکثر است. در این روش میتوانیم بر اساس نیاز خود، مقدار مدل پیشبینی کننده و حد آستانه را انتخاب کنیم. سطح زیر نمودار منحنی PR را AUC مینامند. هر چقدر مقدار عددی این معیار بالاتر باشد یعنی عملکرد بهتر است.

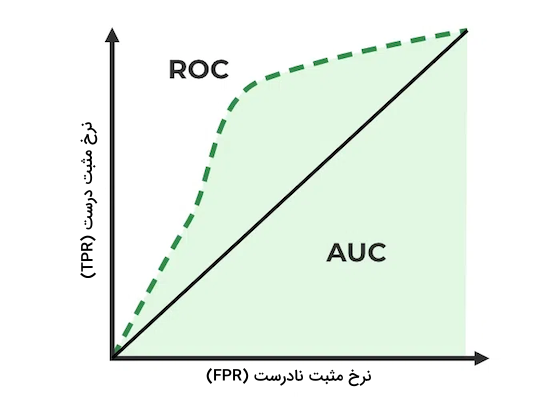

منحنی ROC

منحنی نمودار مشخصه عملکرد یا به اصطلاح ROC، نموداری است که نسبت به دو معیار «نرخ مثبت درست» (True Positive Rate | TPR) و «نرخ مثبت نادرست» (False Positive Rate | FPR) و برای مقادیر آستانه متفاوت ترسیم میشود. همزمان با رشد TPR، معیار FPR نیز افزایش پیدا میکند. همانطور که در نمودار اول مشاهده میکنید، چهار گروه یا دسته مختلف داشته و میخواهیم آستانهای را انتخاب کنیم که نتایج را به قسمت بالا سمت چپ نمودار نزدیکتر کند. با استفاده از این روش، فرایند مقایسه برای سه پیشبینی کننده متفاوت روی مجموعهدادهای مشخص آسان میشود. مقدار آستانه دلخواه بوده و بر اساس مسئله شما تغییر میکند. به سطح زیر نمودار منحنی ROC نیز AUC گفته میشود و هر چه مقدار عددی آن بالاتر باشد، عملکرد نیز بهتر است.

تفاوت منحنی PR با ROC

از هر دو معیار بسیار برای سنجش عملکرد مدلهای یادگیری ماشین استفاده میشود. اما تفاوت میان این دو منحنی در نمونههای منفی درست یا همان TN خلاصه میشود. پارامتر TN جایی در دو معادله دقت و بازیابی ندارد؛ اما در مسائلی که مشکل عدم توازن کلاسی دارند و تعداد نمونههای کلاس منفی زیاد است، پارامتر TN اهمیت پیدا میکند.

تعداد زیاد نمونههای منفی درست، نشانه مقاوم بودن مدل نسبت به عدم توازن کلاسی است. به عنوان مثال در مسئله تشخیص سرطان بهخاطر تعداد کم افراد مبتلا، عدم توازن کلاسی زیاد است. معیار بازیابی، شناسایی افراد مبتلا به سرطان را تضمین میکند و با استفاده از معیار دقت مطمئن میشویم که فرد شناسایی شده بهدرستی مبتلا باشد. از آنجایی که در معیار ROC پارامتر TN در نظر گرفته میشود، بهتر است زمانی از آن استفاده شود که هر دو کلاس برای ما مهم باشند؛ مانند مثال شناسایی گربه و سگ. ارزش دادن به نمونههای منفی نادرست یعنی هر دو کلاس بهطور مساوی مهم هستند. مانند خروجی یک «شبکه عصبی پیچشی» (Convolutional Neural Network | CNN) که سگ و یا گربه بودن تصویر را مشخص میکند.

میانگین مربعات خطا

میانگین مربعات خطا یا به اختصار MSE، معیاری پر کاربرد در مسائل رگرسیون است. این معیار ابتدا تفاضل میان نمونههای پیشبینی شده و مقادیر حقیقی را محاسبه کرده و سپس از مربع آن میانگین میگیرد. هر چه MSE کمتر باشد یعنی خطا کمتر و در نتیجه عملکرد مدل بهتر است.

جذر میانگین مربعات خطا

معیار RMSE در واقع ریشه دوم MSE است که میانگین تفاضل میان نتایج پیشبینی شده توسط مدل یادگیری ماشین و مقادیر حقیقی را بهدست میآورد.

میانگین قدر مطلق خطا

میانگین قدر مطلق خطا یا MAE، پس از بهدست آوردن تفاضل مقادیر پیشبینی شده و مقادیر حقیقی، میانگین قدر مطلق نتیجه را محاسبه میکند. این معیار اندازه میانگین خطا را نشان داده و از همینرو کمتر از MSE نسبت به نمونههای «پرت» (Outlier) حساس است.

ضریب تعیین

ضریب تعیین یا R-squared، نسبتی از واریانس در «متغیر وابسته» (Dependent Variable) که بهوسیله «متغیرهای مستقل» (Independent Variables) قابل توضیح است را اندازه میگیرد. مقدار ضریب تغیین از ۰ تا ۱ متغیر است. از ضریب تغیین اغلب در «رگرسیون خطی» (Linear Regression) استفاده میشود، اما در سایر الگوریتمها نیز کاربرد دارد.

لازم به ذکر است که انتخاب معیار ارزیابی مناسب به نوع مسئله و مشخصات دادهها بستگی دارد. همچنین پیشنهاد میشود برای درک بهتر از عملکرد مدل، همزمان چند معیار ارزیابی را تحلیل و بررسی کنید.

روش های ارزیابی مدل

ارزیابی مدل شامل گسترهای از روشهاست که هدفشان سنجش عملکرد و کیفیت مدلهای یادگیری ماشین است. در جریان فرایند ارزیابی درباره نقاط قوت، محدودیتها و کارایی مدل یادگیری ماشین اطلاعات بهدست میآوریم. تصمیمگیری درباره انتخاب مدل مناسب، بهینهسازی و بهبود نتیجه نهایی، از جمله مزایای استفاده از روشهای ارزیابی مدل بوده که تا به حال در زمینههای بسیاری موثر واقع شده است. در ادامه این مطلب از مجله فرادرس، دو نمونه پر کاربرد از روشهای ارزیابی مدل را شرح داده و بررسی میکنیم.

تقسیم داده

در یادگیری ماشین، ارزیابی عملکرد مدل نسبت به نمونه دادههای جدید و از قبل دیده نشده برای سنجش قابلیت «عمومیسازی» (Generalization) مدل ضرورت دارد. تقسیم دادهها به دو گروه «آموزش» (Train) و «آزمون» (Test) روشی رایج برای ارزیابی مدل با مجموعهدادههای مستقل است. با استفاده از روش تقسیم داده میتوانیم عملکرد مدل در مواجهه با دادههای جدید را تخمین بزنیم. نحوه کار «تقسیم داده آموزش-آزمون» (Train-Test Split) به شرح زیر است:

- تقسیم مجموعهداده: اولین قدم در تقسیم داده به دو گروه آموزش و آزمون، تقسیم مجموعهداده به دو زیر شاخه مجزا به نامهای «مجموعه آموزشی» (Training Set) و «مجموعه آزمون» (Test Set) است. همزمان که از مجموعه آموزشی برای آموزش دادن مدل استفاده میشود، مجموعه آزمون به عنوان ترکیبی از نمونههای مستقل و جدید بهکار گرفته میشود تا عملکرد مدل آموزش دیده مورد ارزیابی قرار بگیرد.

- تخصیص داده: بهطور معمول تخصیص داده به مجموعه آموزشی و آزمون بر اساس نسبتهای از پیش تعریف شدهای مانند ۷۰ به ۳۰، ۸۰ به ۲۰ یا ۹۰ به ۱۰ صورت میگیرد. به مجموعه آموزشی نسبت بیشتری تخصیص میگیرد تا مدل یادگیری ماشین بتواند الگوها و روابط میان دادهها را شناسایی کند. اما مجموعه آزمون که تعداد نمونههای کمتری را شامل میشود، جدا نگه داشته میشود تا پس از مرحله آموزش، نقش دادههای جهان حقیقی را برای مدل بازی کند.

- آموزش مدل: پس از آماده شدن مجموعه آموزشی، مدل از طریق الگوریتمها و روشهایی متناسب با مسئله، آموزش داده میشود. در طول فرایند آموزش، مدل از دادههای ورودی یاد گرفته و با تنظیم پارامترهای شبکه، خطا را کاهش داده و عملکرد را بهبود میبخشد.

- ارزیابی مدل: پس از آموزش، مدل با مجموعه آزمون ارزیابی میشود. مجموعه آزمون شامل نمونههایی است که مدل تا به حال با آنها روبهرو نشده است. با ارزیابی عملکرد مدل نسبت به این مجموعهداده مستقل، درک خوبی از توانایی آن در تشخیص و پیشبینی دقیق دادههای جدید بهدست میآوریم.

- معیارهای ارزیابی: در حین ارزیابی و با استفاده از پیشبینیهای انجام شده توسط مدل یادگیری ماشین روی مجموعه آزمون، معیارهای مختلفی همچون صحت، دقت، بازیابی و امتیاز F1 محاسبه میشوند. پس از آنکه مدل با انواع معیارها مورد ارزیابی قرار گرفت، میتوانیم به درک بهتری از نحوه استفاده و کارایی آن برای مسائل مرتبط برسیم.

تقسیم مجموعهداده به دو گروه آموزش و آزمون به ما کمک میکند تا به مشکلاتی همچون بیشبرازش پیبرده و توانایی مدل یادگیری ماشین در برابر دادههای جدید را محک بزنیم. باید اطمینان حاصل کنیم که تقسیم داده نشانگر توزیع دادههای اصلی است. روشهای «تصادفیسازی» (Randomization) اغلب پیش از مرحله تقکیک داده بهکار گرفته میشوند، تا الگوهای نامتوازن در مجموعهداده اصلی به دو مجموعه آموزش و آزمون راه پیدا نکنند. بهطور خلاصه، تقسم داده روشی بنیادی در ارزیابی مدل است که از طریق آن عملکرد مدل نسبت به دادههای مستقل تخمین زده میشود.

اعتبارسنجی متقابل

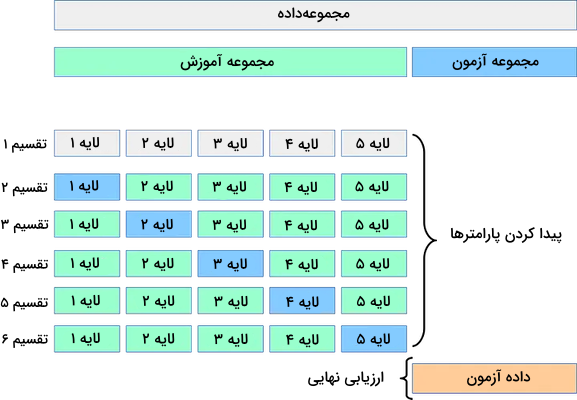

«اعتبارسنجی متقابل» (Cross Validation) تکنیکی پایهای در ارزیابی مدلهای یادگیری ماشین است که محدودیتهای روش تقسیم داده را برطرف میسازد. در اعتبارسنجی متقابل، مجموعهداده به چند زیر مجموعه یا «لایه» (Folds) تقسیم شده و سپس مدل بهطور مکرر با ترکیبهای مختلفی از دو مجموعه آموزش و «اعتبارسنجی» (Validation Set) مورد سنجش قرار میگیرد. از همین جهت نتایج بهدست آمده از این روش به مراتب قابل اتکاتر از روش تقسیم داده است. اعتبارسنجی متقابل خود به انواع مختلفی تقسیم میشود که رایجترین آن تکنیکی بهنام اعتبارسنجی متقابل K-Fold است. در روش K-Fold دادهها به K لایه با اندازه مساوی تقسیم میشوند. در ادامه مدل بر روی یکی از لایهها آموزش دیده و با K-1 لایه باقیمانده ارزیابی میشود. این فرایند K مرتبه تکرار میشود تا مطمئن شویم هر لایه هم در مجموعه آموزش و هم اعتبارسنجی کاربرد دارد. با میانگینگیری از مجموع معیارهای عملکرد حاصل از K تکرار، روش اعتبارسنجی تخمین معتبرتری از کارایی مدل یادگیری ماشین در مقابل نمونههای جدید ارائه میدهد.

اعتبارسنجی متقابل، ارزیابی جامعتری را از عملکرد مدل ممکن میسازد که این خود از مزایای کلیدی آن نسبت به سایر روشها است. از آنجایی که در این روش، مدل در مقابل ترکیبهای مختلفی از دو مجموعه آموزش و اعتبارسنجی قرار میگیرد، احتمال رخداد مشکلهایی همچون بیشبرازش و «کمبرازش» (Underfitting) کاهش یافته و به نوعی عملکرد آن در کاربردهای حقیقی تضمین میشود. به این خاطر که اعتبارسنجی متقابل حداکثر استفاده را از دادههای موجود میبرد، در مواردی که از نظر تعداد داده با محدودیت روبهرو هستیم بسیار کاربرد دارد. با این حال نباید از یاد برد که روش اعتبارسنجی متقابل به مراتب هزینهبرتر از یک تقسیم داده ساده است؛ چرا که چند مرحله تکرار از فرایندهای آموزش و ارزیابی مدل را شامل میشود. این هزینه محاسباتی ممکن است امکان استفاده از اعتبارسنجی متقابل را در مواردی خاص با مجموعهدادههای بزرگ یا منابع محدود با چالش مواجه کند.

همچنین این روش راهحلی برای رفع تمامی محدودیتهای ارزیابی مانند «سوگیری داده» (Data Bias) یا معیارهای خارجی نبوده و به همین خاطر است که باید به همراه دیگر روشهای ارزیابی برای رسیدن به درکی جامع از کارایی مدل یادگیری ماشین استفاده شود. بهطور خلاصه اعتبارسنجی متقابل معیاری کارآمد در ارزیابی مدل است که تخمین دقیقتری از سایر روشها مانند تقسیم داده نتیجه میدهد. معیاری که احتمال بیشبرازش را کاهش داده، اطلاعات بیشتری از دادهها استخراج کرده و دید خوبی از میزان پایداری عملکرد مدل ارائه میدهد. در حالی که این معیار با مشکلاتی همچون هزینه بالای محاسباتی همراه بوده و به تنهایی قادر به رفع محدودیتهای ارزیابی نیست، همچنان ابزاری مهم برای دانشمندان علم داده محسوب میشود.

معیارهای ارزیابی مدل در یادگیری ماشین چه محدودیت هایی دارند؟

در حالی که ارزیابی مدل نقش حیاتی در یادگیری ماشین و «مدلسازی پیشبینی کننده» (Predictive Modeling) بازی میکند، مهم است که با محدودیتها و ایرادات آن نیز آشنا باشیم. آشنایی با این محدودیتها در نهایت به فهم کاملتری از ارزیابی عملکرد مدل ختم میشود. در ادامه به بررسی بیشتر این محدودیت میپردازیم.

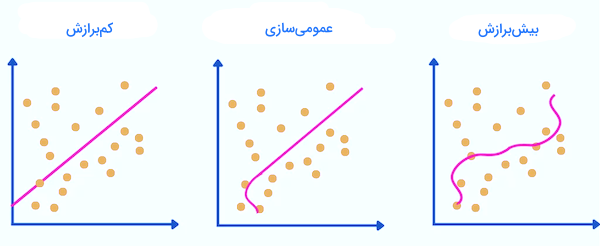

بیشبرازش و کمبرازش

هر مدل یادگیری ماشین ممکن است با مشکل بیشبرازش روبهرو شود که در آن عملکرد چشمگیری نسبت به مجموعه آموزشی از خود نشان داده اما در تعمیم این عمکلرد به دادههای جدید ناتوان است. از سوی دیگر، کمبرازش هنگامی رخ میدهد که مدل یادگیری ماشین آنقدر ساده است که نمیتواند الگوهای موجود در داده را شناسایی کند. در نتیجه نسبت به هیچ مجموعهدادهای چه آموزشی و چه آزمون، عملکرد قابل قبولی نخواهد داشت. هر دو این مشکلات ممکن است ما را در ارزیابی نهایی با اشتباه روبهرو کنند.

کیفیت داده و سوگیری

کیفیت و توازن مجموعهدادهها تاثیر بهسزایی در ارزیابی مدل دارد. خطاهای موجود در داده ممکن است بر عملکرد مدل یادگیری ماشین تاثیر گذاشته و در نتایج نهایی نیز سوگیری وجود داشته باشد. آشنایی کامل با داده، شناسایی سوگیریها، انتخاب روش جمعآوری مناسب و برچسبگذاری از جمله مواردی است که تا حد خوبی از بروز چنین مشکلاتی جلوگیری میکند.

نشت داده

«نشت داده» (Data Leakage) زمانی اتفاق میافتد که نمونههای مجموعه آزمون به نحوی در طی فرایند آموزش به مدل معرفی و باعث شده تا نتیجه ارزیابی بیش از حد خوشبینانه باشد. اطمینان حاصل کردن از تقکیک کامل مجموعه آموزش از آزمون از یکدیگر برای جلوگیری از نشت داده و کسب برآوردی قابل اعتماد از عملکرد مدل ضروری است.

عمومیسازی محدود

مدلهایی که تنها در مقابل مجموعهدادهای خاص یا محیطی آشنا خوب عمل میکنند، به احتمال زیاد در موقعیتهای آزمون و جهان حقیقی با چالش روبهرو میشوند. وقتی کارایی مدل را با دادههایی متنوع آزمایش کرده یا از معیارهایی مانند اعتبارسنجی متقابل استفاده کنیم، بهتر متوجه قابلیت عمومیسازی سیستم طراحی شده میشویم.

معیارهای ارزیابی و مسئله

انتخاب معیارهای ارزیابی مدل باید همگام با اهداف و نیازمندیهای مسئله باشد. معیارهای ارزیابی مختلف، هر کدام جنبههایی از کارایی مدل را نشان میدهند و اتکا کردن به تنها یک معیار، به ارزیابی جامع و کاملی منتهی نمیشود. برای ارزیابی هر مدل یادگیری ماشین باید چند معیار را در نظر گرفت و ترکیب نتایج را مورد بررسی قرار داد.

کلاس های نامتوازن و توزیع منحرف

توزیع نامتوازن و «منحرف» (Skewed) کلاسی در نتایج ارزیابی مسائل دستهبندی تاثیرگذار است. به عنوان مثال اگر در مجموعهداده، میان کلاسها توازن برقرار نباشد، ارزیابی معیار صحت از عملکرد مدل گمراه کننده خواهد بود. برای ارزیابی دادههای نامتوازن، استفاده از معیارهای ارزیابی یادگیری ماشین دیگری مانند دقت، بازیابی یا امتیاز F1 پیشنهاد میشود.

ملاحظات منحصر به حوزه خاص

کاربردها و حوزههای خاص، ویژگیهای منحصربهفرد و الزاماتی را شامل میشوند که باید در فرایند ارزیابی مدل در نظر گرفت. کسب دانش درباره زمینه خاص، آشنایی با محدودیتهای کسبوکار و رعایت ملاحظات اخلاقی، در تفسیر و اعتبارسنجی مدل ضرورت دارد.

معیارهای خارجی و تغییرات محیطی

این امکان وجود دارد که مدلهای یادگیری ماشین تحت تاثیر معیارهای خارجی و تغییرات محیطی پیشبینی نشده در طول فرایند ارزیابی قرار بگیرند. توسعه مدلهای یادگیری ماشین در کاربردهای جهان حقیقی، آنها را با چالشهای جدیدی مواجه میکند که ممکن است در دراز مدت موجب افت عملکرد شود. نظارت پیوسته و بهروزرسانی مدل برای همراه شدن با تغییرات، از جمله مورادی است که باید به آن توجه داشت.

تفسیر و تشریحپذیری

برخی مدلها بهویژه مدلهای یادگیری عمیق، بسیار پیچیده بوده و از همینرو تفسیر و درک آنها دشوار است. با وجود عملکرد فوقالعاده، محدودیتهایی که در فهم جعبه سیاه این مدلها وجود دارد، کارایی عملی آنها را محدود میکند. در نتیجه تنها عملکرد مهم نبوده و در برخی از حوزهها «تفسیرپذیری» (Interpretability) نیز به همان اندازه اهمیت دارد.

حفظ دیدگاهی نقادانه به ارزیابی مدل و در نظر داشتن محدودیتها تخمین مطمئنی را نتیجه میدهد. در حالی که هیچ ارزیابی بدون مشکل نیست، اما با ترکیب معیارهای مختلف و انجام آزمایشهای دقیق، میتوان تا حد قابل قبولی کارایی مدل را تضمین کرد.

سوالات متداول و مرتبط با معیارهای ارزیابی در یادگیری ماشین

همانطور که تا به اینجا یاد گرفتیم، معیارهای ارزیابی در یادگیری ماشین انواع مختلفی دارند و استفاده صحیح از آنها نیازمند بررسی دادهها و کسب آگاهی کامل از مسئله مورد نظر است. در این بخش به چند مورد از سوالات متداول این حوزه پاسخ میدهیم.

چرا باید مدل یادگیری ماشین را ارزیابی کنیم؟

نتایجی که پس از آموزش مدل حاصل میشود به تنهایی کافی نیست و لازم است تا عملکرد مدل نسبت به دادههای از پیش دیده نشده نیز مورد ارزیابی قرار بگیرد. به همین خاطر است که برای سنجش مدل از معیارهای ارزیابی استفاده میکنیم.

روش ها و معیارهای ارزیابی رایج در یادگیری ماشین چیست؟

روشهایی همچون تقسیم داده و اعتبارسنجی متقابل در زمینه ارزیابی مدل رواج دارند و همچنین برای تحلیل عملکرد از معیارهای صحت، دقت و امتیاز F1 استفاده میشود.

اعتبارسنجی متقابل چگونه کار میکند؟

اعتبارسنجی متقابل با ارائه تخمینی از عملکرد مدل یادگیری ماشین نسبت به نمونه دادههای جدید، از مشکلاتی همچون بیشبرازش و کمبرازش جلوگیری میکند.

چرا باید میان بیشبرازش و کمبرازش توازن برقرار باشد؟

برقراری توازن میان بیشبرازش و کمبرازش مهم است، زیرا باعث ایجاد توازن میان پیچیدگی مدل و دقت آن میشود.

از ارزیابی مدل در چه حوزه هایی استفاده میشود؟

گستره کاربردهای ارزیابی مدل بسیار وسیع است. به عنوان مثال در امور مالی، خدمات درمانی و بازاریابی، از معیارهای ارزیابی مدل استفاده میشود.

به چه دلیل باید ارزیابی مدل یادگیری ماشین دقیق و کامل انجام شود؟

اگر قصد داریم سیستم مبتنیبر یادگیری ماشین نهایی شما به معنای واقعی ارزشآفرین باشد، حفظ کیفیت و دقت بالا در انجام فرایند ارزیابی از اهمیت بالایی برخوردار است.

جمعبندی

ارزیابی مدل از جمله مهمترین بخشهای توسعه هر گونه سیستم مرتبط با یادگیری ماشین است. تنها با یک ارزیابی مناسب میتوانیم عملکرد مورد انتظار را تعریف کرده، قسمتهایی که نیاز به بهبود دارند را شناسایی و مدل خود را با سایر روشها مقایسه کنیم. انتخاب معیارهای ارزیابی در یادگیری ماشین وابستگی زیادی به نوع مسئله دارد. در این مطلب از مجله فرادرس از اهمیت ارزیابی مدل گفتیم و یاد گرفتیم که چگونه با استفاده از انواع مختلف معیارهای ارزیابی، میتوانیم از بروز مشکلات پیشبینی نشده در آینده جلوگیری کنیم. در سابق ارزیابی مدلهای یادگیری ماشین تنها به استفاده از معیار دقت خلاصه میشد؛ اما امروزه با گسترش روشهای موجود، دیگر نگرانی از جهت بروز رفتارهای ناگهانی توسط سیستم وجود نداشته و بسیاری از مشکلات قابلشناسایی و پیشگیری هستند.

مطلب بسیار مفید و جامعی بود و در عین حال با زبان ساده و قابل فهم نگارش شده بود خیلی ممنونم .