LSTM چیست و این شبکه عصبی چطور کار می کند؟ – به زبان ساده

«شبکه عصبی حافظه طولانی کوتاه مدت» (Long Short Term Memory | LSTM) یکی از پرکاربردترین مدلهای شبکه عصبی مصنوعی محسوب میشود که از آن میتوان در پیادهسازی مسائل مختلف روزمره از جمله ترجمه ماشینی، تشخیص گفتار، طبقه بندی متن، تحلیل توالییابی DNA و کلیه مسائلی استفاده کرد که حفظ ترتیب زمانی دادهها اهمیت دارند. LSTM نوعی از «شبکه عصبی بازگشتی» (Recurrent Neural Network | RNN) محسوب میشود و به دلیل ساختار درونی متفاوتی که دارد، از عملکرد بهتری نسبت به مدل RNN برخوردار است. در این مطلب از مجله فرادرس قصد داریم به این پرسش پاسخ دهیم که شبکه عصبی LSTM چیست و عملکرد آن به چه شکل است. در ابتدای مطلب، به دلیل پیدایش مدل LSTM میپردازیم و برتری آن را نسبت به شبکه عصبی RNN شرح میدهیم. سپس، اجزای درونی این شبکه را توضیح خواهیم داد و به کاربردها و مزایا و معایب آن اشاره خواهیم کرد.

- یاد میگیرید شبکه LSTM را از پایه توضیح دهید.

- میآموزید تفاوت اساسی LSTM و RNN در چیست.

- خواهید آموخت اجزای معماری LSTM چه نقشی دارند.

- یاد خواهید گرفت نحوه کار درگاههای ورودی، خروجی و فراموشی را تبیین کنید.

- میآموزید چرا LSTM برای توالیهای زمانی گزینهای مناسب است.

- یاد میگیرید مزایا و چالشهای کلیدی LSTM را مقایسه کنید.

دلیل پیدایش شبکه عصبی LSTM چیست ؟

پیش از آن که به این پرسش پاسخ دهیم که شبک عصبی LSTM چیست ، به دلیل پیدایش آن اشاره خواهیم کرد و به این نکته میپردازیم این نوع شبکه عصبی چه برتری خاصی نسبت به مدلهای پیش از خود داشته است. شبکههای عصبی معمولی نظیر پرسپترون در پردازش ورودی و خروجی با ابعاد متغیر مشکل داشتند و از آنها نمیتوان در حل مسائلی نظیر موارد فهرست شده در زیر استفاده کرد:

- توصیف تصویر: ورودی شبکه عصبی در این مسئله، تصاویر هستند و مدل باید در خروجی متنی را تولید کند که تصویر را شرح میدهد.

- تحلیل احساسات متن: ورودی شبکه عصبی در این نوع مسئله، متن است و مدل باید نوع آن را (مثبت، منفی، خنثی) مشخص کند.

- ترجمه ماشینی: ورودی شبکه عصبی در این نوع مسئله، متنی به زبان مبدا است و مدل باید آن را به زبان دیگر ترجمه کند.

به دلیل محدودیتهای شبکههای عصبی معمولی در حل چنین مسائلی، ایده شبکههای عصبی بازگشتی (RNN) در سال ۱۹۸۶ مطرح و به دنبال آن، معماری مشهور LSTM نیز در سال ۱۹۹۷ ارائه شد. به عبارتی، ماهیت بازگشتی بودن شبکههای عصبی RNN و LSTM این مزیت را به همراه داشت تا بتوان برای آموزش مدلها از دادههای آموزشی با ابعاد متغیر استفاده کرد.

در مطلب پیشین از مجله فرادرس با عنوان شبکه عصبی بازگشتی چیست، به طور کامل ساختار درونی شبکه RNN توضیح داده شده است. از آنجایی که شبکه عصبی LSTM نوعی شبکه RNN محسوب میشود، علاقهمندان میتوانند با مطالعه آن مطلب، با نحوه عملکرد شبکه RNN و ویژگی آن آشنا شوند. مهمترین عیبی که مدل RNN داشت، این بود که به دلیل اشتراک پارامترها در همه سلولهای RNN، اطلاعات حاصل شده از دادههای اولیه شبکه از بین میرفت به خصوص زمانی که ساختار شبکه RNN به دلیل طول زیاد دادههای ورودی، خیلی بزرگ میشد.

به عبارت دیگر، شبکه عصبی RNN نمیتوانست دادههای گذشته را با جزئیات به خاطر بسپارد. به دلیل این مشکل، تغییراتی در ساختار درونی آن اعمال و شبکه عصبی جدید با نام شبکه عصبی حافظه طولانی کوتاه مدت یا همان LSTM ارائه شد. در ادامه مطلب حاضر، به معرفی LSTM میپردازیم و عملکرد هر یک از اجزای آن را شرح خواهیم داد.

شبکه عصبی LSTM چیست ؟

بیش از ۲۰ سال است که از پیدایش شبکه عصبی LSTM میگذرد و همچنان جزو محبوبترین معماریهای شبکه عصبی بازگشتی محسوب میشود. اما دلیل محبوبیت شبکه عصبی LSTM چیست ؟ همانطور که در بخش قبل گفته شد، مدل RNN نمیتواند اطلاعات گذشته را به خوبی به خاطر بیاورد و این موضوع در شبکههای بزرگ مشکلساز است. به بیان دقیقتر، مدل RNN فقط دادههای اخیر را در حافظه کوتاه مدت خود ذخیره میکند و به محض پر شدن این حافظه، قدیمیترین اطلاعات به سادگی حذف و با دادههای جدید جایگزین میشوند.

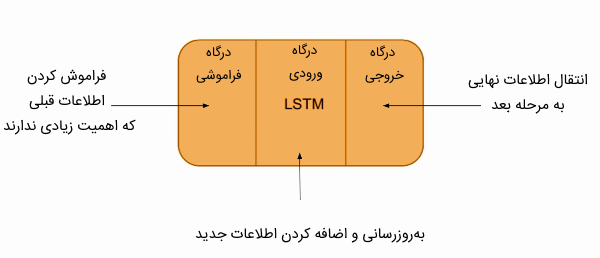

در ساختار مدل LSTM حافظه بلندمدتی تعبیه شده است که اطلاعات مورد نیاز و مهم در آن نگهداری میشود. این حافظه بلندمدت با عنوان «حالت سلول» (Cell State) شناخته میشود. علاوهبراین، LSTM دارای یک حافظه کوتاه مدت است که «حالت پنهان» (Hidden State) نام دارد و در آن اطلاعات کوتاه مدت از مراحل محاسبات قبلی ذخیره میشود. بدین ترتیب، شبکه عصبی LSTM از دو حافظه تشکیل شده است و به همین خاطر به آن «شبکه عصبی حافظه طولانی کوتاه مدت» گفته میشود. در تصویر زیر، نمایی از معماری کلی شبکه LSTM را ملاحظه میکنید:

همانطور که در تصویر بالا ملاحظه میکنید، شبکه عصبی LSTM از سه درگاه اصلی تشکیل شده است که هر یک از آنها پردازشی را بر روی داده ورودی انجام میدهند و در نهایت خروجی حاصل شده به مرحله زمانی بعدی ارسال میشود. این سه درگاه عبارتاند از:

- «درگاه ورودی» (Input Gate)

- «درگاه خروجی» (Output Gate)

- «درگاه فراموشی» (Forget Gate)

پیش از آن که به توضیح دقیقتر اجزای درونی هر یک از این درگاههای موجود در LSTM بپردازیم، در قسمت بعدی این مطلب به معرفی فیلمهای آموزشی مرتبط با یادگیری عمیق خواهیم پرداخت تا علاقهمندان به این حوزه بتوانند برای یادگیری مفاهیم تخصصی هوش مصنوعی از آنها بهرهمند شوند.

چگونه هوش مصنوعی را حرفه ای یاد بگیریم؟

فرادرس به عنوان بزرگترین پلتفرم آموزشی آنلاین، بستری را برای تمامی افراد با سطوح مهارتی مختلف فراهم کرده است و در زمینههای تخصصی مختلف، مخاطبان میتوانند از فیلمهای آموزشی آن استفاده کنند. اگر شما فردی هستید که قصد دارید نحوه پیادهسازی مدلهای یادگیری عمیق را از ابتدا یاد بگیرید و در این حوزه تازهکار هستید، میتوانید از فیلمهای آموزشی فرادرس زیر بهرهمند شوید:

- فیلم آموزش پیادهسازی گامبهگام شبکههای عصبی در پایتون فرادرس

- فیلم آموزش مقدماتی پیادهسازی شبکههای عصبی مصنوعی در پایتون Python فرادرس

چنانچه قصد دارید با کتابخانه های هوش مصنوعی آشنا شوید و نحوه استفاده از آن را برای پیادهسازی شبکههای عصبی مختلف را یاد بگیرید، فیلمهای آموزشی زیر از پلتفرم فرادرس میتوانند به شما کمک کنند:

- فیلم آموزش برنامهنویسی یادگیری عمیق با کتابخانه TensorFlow 2 فرادرس

- فیلم آموزش یادگیری عمیق در پایتون با تنسورفلو و کراس TensorFlow و Keras فرادرس

اگر قصد دارید با نحوه پیادهسازی شبکه عصبی LSTM آشنا شوید و پروژههای هوش مصنوعی مختلفی را با این مدل انجام دهید، فیلمهای آموزشی در فهرست زیر میتوانند برای شما مفید باشند:

- فیلم آموزش طراحی شبکه عصبی LSTM در متلب برای پیشبینی داده و طبقهبندی متن و فیلم فرادرس

- فیلم آموزش آموزش پیشبینی قیمت سهام در بورس با شبکه عصبی عمیق LSTM در متلب فرادرس

معماری شبکه عصبی LSTM

همانطور که اشاره کردیم، شبکه عصبی LSTM از سه درگاه اصلی با عناوین درگاه فراموشی، درگاه ورودی و درگاه خروجی تشکیل شده است که هر یک از آنها پردازشی را بر روی دادهها با اهداف مختلف اعمال میکنند. در ادامه، به توضیح دقیقتر این درگاهها میپردازیم.

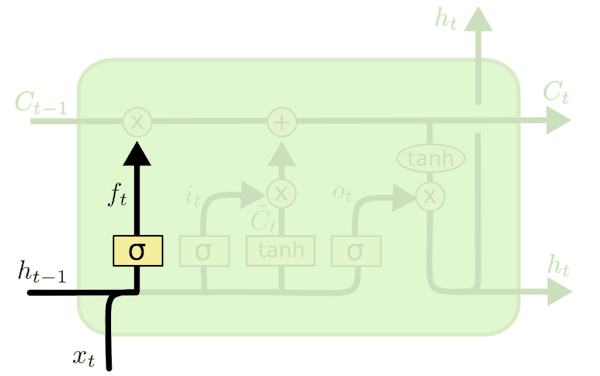

درگاه فراموشی در شبکه عصبی LSTM چیست ؟

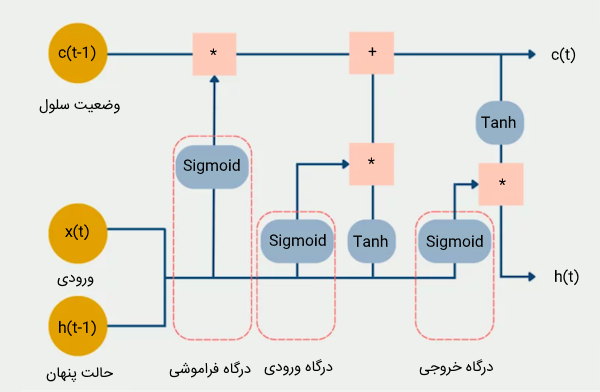

در درگاه فراموشی مدل LSTM تصمیم گرفته میشود که کدام اطلاعات جاری و گذشته حفظ و کدامیک دور ریخته شوند. ورودی این درگاه شامل وضعیت پنهان از گذر قبلی و ورودی فعلی است. این مقادیر به یک «تابع فعالسازی سیگموئید» (Sigmoid Function) وارد میشوند که فقط میتواند مقادیری بین ۰ و ۱ را در خروجی ارائه دهد. مقدار ۰ به این معنی است که اطلاعات قبلی را میتوان فراموش کرد زیرا احتمالاً اطلاعات جدید و مهمتری وجود دارد. عدد یک نیز به این معنی است که اطلاعات قبلی حفظ شوند.

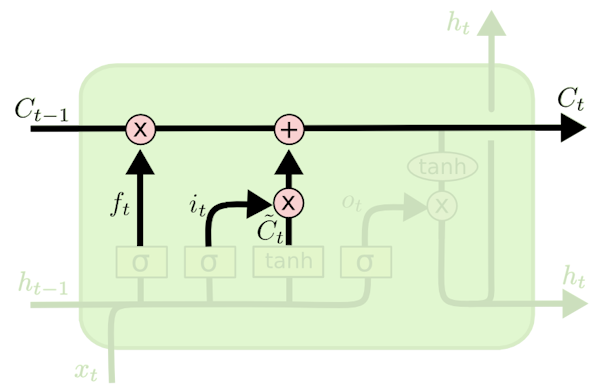

نتیجه تابع سیگموئید با مقدار وضعیت سلول (Cell State) ضرب میشود تا مشخص شود اطلاعات قبلی حذف شوند یا در مدل باقی بمانند. معادله درگاه فراموشی را در ادامه ملاحظه میکنید:

معادله بالا از مقادیر زیر شکل گرفته است:

- : این متغیر ورودی مربوط به زمان فعلی را مشخص میکند.

- : این متغیر وزنهای مربوط به مدل LSTM است که با مقدار ورودی ضرب میشود.

- : این متغیر حالت پنهان (hidden state) مربوط به زمان قبلی را مشخص میکند.

- : این متغیر وزنهای مربوط به مدل LSTM است که با مقادیر متغیر حالت پنهان ضرب میشوند.

پس از ضرب مقادیر ورودی LSTM با وزنهای درگاه فراموشی، مقدار حاصل شده به تابع سیگموئید داده شده تا عددی بین ۰ و ۱ حاصل شود. در نهایت، خروجی این درگاه با مقدار وضعیت سلول زمان قبلی یا همان ضرب میشود تا در این باره تصمیم گرفته شود آیا اطلاعات قبلی در مدل باقی بمانند و به مرحله بعد منتقل شوند؟ به عبارتی، میتوان معالههای زیر را برای این تصمیمگیری در نظر گرفت:

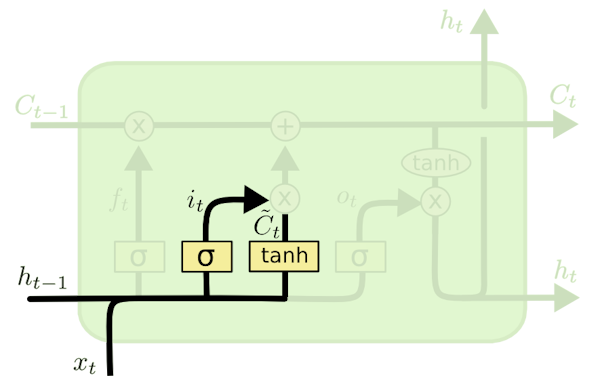

درگاه ورودی در شبکه LSTM چیست ؟

به منظور درک وظیفه درگاه ورودی در شبکه عصبی LSTM میتوان از یک مثال کمک گرفت. فرض کنید دو جمله در مورد فردی به نام علی به صورت زیر داریم:

- جمله اول: علی شنا کردن بلد است.

- جمله دوم: او از طریق تلفن به من گفت که به مدت چهار سال در نیروی دریایی خدمت کرده است.

هر دو جمله بالا اطلاعات مختلفی را در مورد علی در اختیار ما قرار میدهند. حال با توجه به متن جمله اول، کدام اطلاعات جمله دوم مهم است؟ اینکه او با تلفن صحبت کرده یا در نیروی دریایی خدمت کرده است؟ باید گفت مهم نیست که علی از طریق تلفن یا هر روش ارتباطی دیگری اطلاعات را به شنونده منتقل کرده باشد. این واقعیت که او در نیروی دریایی بوده است، اطلاعات مهمتری محسوب میشود و چیزی است که مدل LSTM باید برای محاسبات بعدی خود آن را به خاطر بسپارد. وظیفه حفظ اطلاعات مهم در شبکه عصبی LSTM بر عهده درگاه ورودی است. در ادامه، بخشی از فرمول درگاه ورودی را ملاحظه میکنید:

- : این متغیر ورودی مربوط به زمان فعلی را مشخص میکند.

- ماتریس وزنی ورودی : اهمیت یا تاثیرگذاری ورودی را بر خروجی مدل تعیین میکند.

- : اطلاعاتی است که مدل از ورودیهای قبلی دریافت کرده و در حافظه خود نگه داشته است.

- ماتریس وزنی ورودی : نشان دهنده این است که چگونه ورودی جدید با اطلاعات گذشته در مدل ترکیب میشود.

همانطور که در فرمول بالا ملاحظه میشود، برای درگاه ورودی نیز از تابع سیگموئید استفاده شده است تا اطلاعات غیرمهم ورودی، حذف شوند. به عبارتی، اگر خروجی این تابع نزدیک به عدد ۱ باشد، برای شبکه معین میکند که بخش زیادی از داده ورودی به اطلاعات وضعیت سلول فعلی () اضافه شود تا به مرحله بعدی شبکه منتقل شود. به علاوه، این درگاه شامل تابع فعالسازی دیگری با نام tanh است که مشخص میکند اطلاعات وضعیت سلول قبلی تا چه حد تحت تاثیر داده ورودی جدید قرار بگیرد.

به عبارتی، این تابع مشخص میکند تا چه حد اطلاعات قبلی، توسط داده ورودی شبکه بهروزرسانی شوند. این تابع، مقادیر را به بازه عددی ۱ و ۱- نگاشت میکند. خروجی تابع tanh هر چقدر به عدد ۱ نزدیک باشد، به این معنا است که اطلاعات ورودی شبکه بسیار مهم هستند و باید اطلاعات قبلی تا حد زیادی تحت تاثیر داده ورودی قرار گیرند و بهروزرسانی شوند. اگر خروجی این تابع به عدد ۱- نزدیک باشد، بهروزرسانی اطلاعات قبلی به صورت ناچیز اتفاق میافتد. فرمول این بخش از درگاه ورودی را در ادامه ملاحظه میکنید:

در نهایت، مقدار سلول وضعیت فعلی با استفاده از فرمول زیر محاسبه خواهد شد:

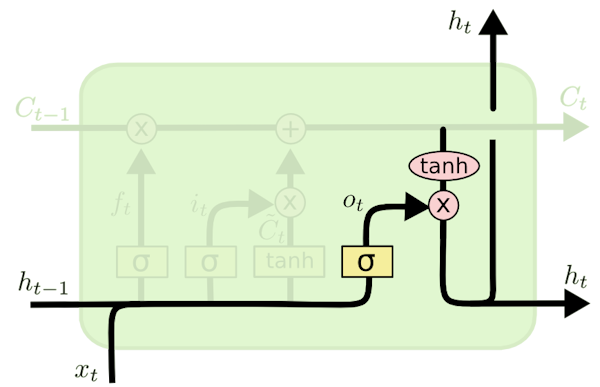

درگاه خروجی در LSTM

درگاه خروجی در شبکههای عصبی بازگشتی LSTM خروجی نهایی را بر اساس وضعیت فعلی سلول حافظه مشخص میکند. این درگاه مانند سایر درگاههای LSTM دارای یک ماتریس وزنی است که مقادیر آن طی روش «پس انتشار» (Backpropagation) بهروز میشوند. اگر با این روش آشنایی ندارید، میتوانید با مطالعه مطلب قبلی از مجله فرادرس با عنوان «روش پس انتشار — از صفر تا صد» با نحوه بهروزرسانی وزنهای شبکه عصبی آشنا شوید.

ماتریس وزن، ورودیِ جاری () و خروجیِ حالت پنهانِ قبلی () را دریافت کرده و عمل ضرب را روی آنها انجام میدهد و نتیجه حاصل شده به تابع فعالسازی سیگموئید ارسال میشود. در انتها، مقدار خروجی تابع سیگموئید با مقدار وضعیت سلول که از تابع تانژانت (tanh) عبور کرده است، ضرب میشود تا مقدار نهایی اصل شود.

به منظور درک بهتر عملکرد درگاه خروجی شبکه LSTM میتوانیم از یک مثال ملموس استفاده کنیم. فرض کنید جمله زیر را داریم:

«علی به تنهایی با دشمن جنگید و برای کشورش جان باخت. به خاطر فداکاریهایش، ________ شجاع.»

هدف این است که جمله دوم را کامل کنیم. زمانی که کلمه «شجاع» را میبینیم، میفهمیم که در مورد یک فرد صحبت میکنیم. در این جمله، فقط علی شجاع است و نمیتوانیم بگوییم دشمن یا کشور شجاع هستند. پس بر اساس انتظار فعلی، باید یک کلمه مرتبط برای پر کردن جای خالی پیدا کنیم. یافتن کلمه همان کاری است که درگاه خروجی انجام میدهد.

به عبارتی میتوان گفت درگاه خروجی در شبکههای عصبی بازگشتی LSTM جریان اطلاعات را کنترل میکند و تصمیم میگیرد کدام قسمت از خروجی سلول در زمان فعلی به خروجی نهایی مدل مرتبط است. در مثال بالا، کلمه «علی» از جمله اول، مرتبطترین اطلاعات با کلمه «شجاع» در جمله دوم است. بنابراین، گیت خروجی مدل یادگیری ماشین روی کلمه «علی» تمرکز میکند و آن را به عنوان خروجی نهایی برای پر کردن جای خالی جمله دوم در نظر میگیرد. فرمول زیر، نحوه محاسبه درگاه خروجی را نشان میدهد:

شبکه بازگشتی دو طرفه LSTM چیست ؟

شبکههای بازگشتی بلندمدت دوطرفه (Bidirectional LSTMs) نوعی معماری شبکه عصبی بازگشتی (RNN) هستند که دادههای ورودی را در دو جهت، هم به طرف جلو و هم به طرف عقب، پردازش میکنند. در شبکه عصبی LSTM معمولی، اطلاعات فقط از گذشته به آینده جریان مییابد و بر اساس دادههای قبلی، پیشبینیهایی انجام میدهد. با این حال، در شبکههای بازگشتی دوطرفه، شبکه عصبی دادههای آینده را نیز در نظر میگیرد و وابستگیها دادهها را در هر دو جهت ثبت کند.

تصویر بالا، ساختار یک شبکه عصبی BiLSTM را نشان میدهد. همانطور که ملاحظه میکنید، در لایه رو به جلو، دادهها از ابتدا به انتها پردازش میشوند و مدل LSTM در زمان پردازش داده جاری یا همان ، اطلاعات دادههای قبلی را در نظر میگیرد. در لایه دوم، مدل LSTM دادهها را از انتها به ابتدا دریافت میکند و در نهایت، برای محاسبه خروجی، اطلاعات هر دو لایه مورد استفاده قرار میگیرند.شبکههای بازگشتی دوطرفه به طور خاص برای کارهایی مفید هستند که نیازمند درک کاملی از توالی ورودی هستند. مسائلی مانند «پردازش زبان طبیعی» (Natural Language Processing | NLP) نظیر تحلیل احساسات، ترجمه ماشینی و «تشخیص موجودیت نامدار» (Named Entity Recognition | NER) را میتوان با این نوع مدل یادگیری عمیق پیادهسازی کرد.

کاربردهای شبکه عصبی LSTM چیست ؟

حال که به این پرسش پاسخ دادیم که شبکه عصبی LSTM چیست و چه ساختاری دارند، در این بخش از مطلب، به کاربردهای آن میپردازیم. شبکه عصبی حافظه طولانی کوتاه مدت نوع بسیار کارآمدی از شبکههای عصبی بازگشتی است که در کاربردهای مختلفی مورد استفاده قرار گرفته میگیرد. در ادامه به برخی از کاربردهای این مدل اشاره شده است:

- شبیهسازی زبان: شبکه عصبی LSTM در کارهای پردازش زبان طبیعی مانند ترجمه ماشینی، مدلسازی زبان و خلاصهسازی متن به کار گرفته شده است. این نوع شبکه عصبی با درک روابط بین کلمات در یک جمله میتواند برای ساختن جملات معنادار با ساختار دستوری (گرامری) صحیح به کار گرفته شود.

- تشخیص گفتار: LSTM برای کارهای تشخیص گفتار مانند تبدیل گفتار به متن و همچنین رونویسی متن به متن دیگر به کار گرفته میشود. این مدل یادگیری عمیق میتواند الگوهای گفتار را تشخیص و آنها را با متن مناسب مطابقت دهد.

- تحلیل احساسات: از شبکه عصبی LSTM میتوان برای تشخیص احساسات متن استفاده کرد. این مدل با یادگیری روابط بین کلمات و احساسات مرتبط با آنها میتواند متون را به دستههای مثبت، منفی یا خنثی تقسیمبندی کند.

- پیشبینی سریهای زمانی: LSTM میتواند با یادگیری روابط بین مقادیر گذشته و مقادیر آینده، برای پیشبینی مقادیر آتی در یک سری زمانی به کار گرفته شود.

- تحلیل ویدئو: شبکه عصبی LSTM میتواند با یادگیری روابط بین فریمهای ویدیویی و اعمال، اشیاء و صحنههای مرتبط با آنها، برای تجزیه و تحلیل ویدئو مورد استفاده قرار گیرد.

- تشخیص دستخط: مدل عمیق LSTM میتواند با یادگیری روابط بین تصاویر دست خط و متن مربوطه، برای تشخیص دست خط افراد به کار گرفته شود.

مزایا و معایب شبکه عصبی LSTM چیست ؟

تا به این قسمت از مطلب حاضر به این پرسش پاسخ دادیم که شبکه عصبی LSTM چیست و کاربردهای رایج آن در چه مسائلی است. این مدل عمیق یکی از پرکاربردترین شبکههای عصبی محسوب میشود و به دلیل مزایایی که دارد، از آن میتوان در حل مسائل مختلف استفاده کرد. در ادامه به مهمترین مزیتهای LSTM اشاره شده است:

- مدیریت وابستگی بین دادهها: LSTM در درک روابط بین دادهها با فواصل طولانی به خوبی عمل میکند. بدین ترتیب، این مدل عمیق برای وظایفی مانند ترجمه ماشینی، تشخیص گفتار و تحلیل سری زمانی ایدهآل هستند.

- رفع مشکل محو شدن گرادیان: شبکههای عصبی بازگشتی سنتی یا همان RNNها مشکل محو شدن گرادیان دارند که این مسئله ممکن است مانع یادگیری شبکه شوند. LSTM به دلیل داشتن معماری خاص به کاهش این مشکل کمک میکند و از دنبالههای طولانیتر به طور موثرتر یاد میگیرد.

- مدلسازی دادههای ترتیبی پیچیده: مدل LSTM میتواند الگوها و روابط پیچیده را در دادههای ترتیبی به طور موثر تشخیص دهد. این قابلیت LSTM باعث میشود برای وظایفی مانند شرح ویدیو، تحلیل احساسات متن و تشخیص ناهنجاری عملکرد مناسبی داشته باشد.

شبکه عصبی LSTM علیرغم مزایایی که دارد، دارای معایبی نیز هست که در ادامه به آنها میپردازیم:

- پیچیدگی محاسباتی: آموزش LSTM در مقایسه با مدلهای سادهتر، پیچیدهتر است زیرا این شبکه عصبی محاسبات سنگینتری دارد و برای آموزش موثر، نیازمند دادههای بیشتری است.

- وابستگی به داده: زمانی که LSTM بر روی مجموعه دادههای بزرگ آموزش داده میشود، بهترین عملکرد خود را دارد. به بیان دیگر، چنانچه برای آموزش آنها از دادههای محدود استفاده شود، ممکن است مسئله را به خوبی یاد نگیرد و عملکرد ضعیفی برای حل مسئله داشته باشد.

- قابلیت تفسیرپذیری: درک این که مدل LSTM چه اطلاعاتی را از دادهها یاد گرفته است، میتواند چالشبرانگیز باشد. این امر اشکالزدایی یا توضیح استدلال عملکرد مدل را دشوار میکند.

یادگیری سایر مدل های یادگیری عمیق

در این مطلب، سعی داشتیم به توضیح یکی از مدلهای یادگیری عمیق، یعنی شبکه عصبی LSTM، بپردازیم. چنانچه علاقهمند هستید با سایر شبکههای عصبی آشنا شوید، میتوانید به مطالعه مطلب «الگوریتم های یادگیری عمیق» از مجله فرادرس بپردازید. همچنین، برای یادگیری مفاهیم سایر مدلهای یادگیری عمیق و نحوه پیادهسازی آنها با کتابخانه های هوش مصنوعی، میتوانید از فیلمهای آموزشی فرادرس استفاده کنید که در ادامه به برخی از آنها اشاره شده است:

- فیلم آموزش شبکه عصبی کانولوشنی گرافی در پایتون فرادرس

- فیلم آموزش پیادهسازی شبکه عصبی کانولوشنی CNN با تنسورفلو TensorFlow فرادرس

- فیلم آموزش شبکه عصبی پرسپترون فرادرس

- فیلم آموزش شبکههای عصبی گازی در متلب MATLAB فرادرس

- فیلم آموزش شبکههای عصبی گرافی با کتابخانه DGL در پایتون فرادرس

جمعبندی

شبکههای عصبی بازگشتی یکی از پرکاربردترین مدلهای یادگیری عمیق هستند که به دلیل داشتن ویژگی بازگشتی، از آنها در مسائلی نظیر پردازش زبان طبیعی و تحلیل سریهای زمانی استفاده میشود. شبکه عصبی RNN مدل اولیهای از شبکههای عصبی بازگشتی بود که به دلیل مشکل محوشدگی گرادیان در بسیاری از مسائل هوش مصنوعی عملکرد ضعیفی داشتند. شبکه عصبی LSTM دارای معماری پیچیدهتری نسبت به RNN است و این مدل میتواند تا حد قابل توجهی، مشکلات RNN را کاهش دهد. از آنجایی که از مدل LSTM در حل بسیاری از مسائل هوش مصنوعی استفاده میشود، سعی داشتیم در این مطلب به معرفی این شبکه عصبی بپردازیم و به این پرسش پاسخ دهیم LSTM چیست و اجزای آن به چه شکل دادهها را پردازش میکنند.

باسلام و وقت بخیر

تیتر «شبکه بازگشتی دو «طرفته» LSTM چیست ؟» اشتباه تایپی دارد.

با سلام؛

از بازخورد شما سپاسگزاریم. متن مجدد بازبینی و اصلاح شد.

با تشکر از همراهی شما با مجله فرادرس