آزمون هاسمن برای داده پانلی (Hausman Test) – به زبان ساده

یکی از آزمونها پراستفاده در حوزه اقتصاد سنجی آزمون هاسمن است. براساس این آزمون میتوانیم بین دو برآوردگر مدل دست به انتخاب بزنیم. بنابراین آزمون هاسمن برای داده پانلی میتواند مبنایی برای انتخاب مدل اثرات تصادفی (Random Effect) یا اثرات ثابت (Fixed Effect) باشد. این آزمون را با نام «آزمون دوربین-وو-هاسمن» (Durbin-Wu-Hausman Test) نیز میشناسند. از این آزمون برای نشان دادن میزان سازگاری یک مدل با دادهها بخصوص در اقتصاد سنجی استفاده میکنند.

برای آشنایی با داده پانلی بهتر است نوشتار داده پانلی (Panel Data) --- از صفر تا صد را مطالعه کنید. همچنین خواندن مطلب رگرسیون خطی چندگانه (Multiple Linear Regression) — به زبان ساده نیز برای آگاهی از نحوه اجرای مدل رگرسیونی چند گانه، خالی از لطف نیست.

آزمون هاسمن برای داده پانلی

سه دانشمند در حوزه اقتصاد سنجی و آمار به اسامی «دی مین وو» (De-Min Wu)، «جیمز دوربین» (James Durbin) و «جری هاسمن» (Jerry Hausman)، آزمونی را برای سازگاری یک برآوردگر نسبت به برآوردگر دیگر ابداع کردهاند.

اولین کاربرد این رویکرد توسط «جیمز دوربین» در سال 1954 معرفی شد. او یک آزمون آماری برای "خطا در متغیرها" در یک مدل رگرسیون خطی، بر اساس مقایسه کمترین مربعات عادی (OLS) و متغیرهای ابزاری (Instrumental Variable) ارائه داد. متغیرهای ابزاری را گاهی متغیرهای مداخلهگر (Covariate) نیز مینامند. اگر بدون متغیرهای ابزاری، مدل رگرسیون خطی عادی (OLS) ساخته شود، آنگاه مدل سازگار و کارآمد است، در حالی که مدلی که با متغیرهای ابزاری ساخته میشود سازگار اما ناکارآمد محسوب خواهد شد. ولی اگر مدل تحت فرض مقابل ساخته شده باشد، مدل با روش OLS، ناسازگار بوده اما مدل متغیرهای ابزاری، همچنان سازگار باقی خواهد ماند.

نکته: منظور از سازگاری، سازگاری در میانگین و ناکارآمدی نیز مربوط به واریانس برآوردگرها است.

«دی مين وو» در سال 1973، آزمونهایی را براساس مقايسه برآوردگرهای رگرسیون کمترین مربعات (OLS) یا Ordinary Least Square و متغیرهای ابزاری (IV) یا Instrumental Variable در نظر گرفت و کاربردهای معادلات همزمان خطی (معادلات ساختاری) در تجزیه و تحلیل داده پانلی پويا را توصيف كرد. بعداها این دو روش با یکدیگر ادغام شدند و آزمون هاسمن پدید آمد.

در حقیقت آزمون هاسمن روشی برای تشخیص خطاهای یک مدل بر اساس مقایسه دو برآوردگر مختلف پارامترهای مدل است. برآوردگرهای مقایسه شده باید دارای خصوصیاتی باشند که در ادامه به آنها اشاره میکنیم.

- فرض صفر (Null Hypothesis) یکسان بودن خصوصیات هر دو مدل را بیان میکند. به این ترتیب بین دو مدل سازگاری وجود دارد و از لحاظ آماری تفاوت معنیدار بین آن دو وجود ندارد.

- تحت فرض مقابل (Alternative Hypothesis)، مدل اثرات تصادفی نسبت به مدل اثرات ثابت برتری داشته و خطای کمتری ایجاد میکند.

این خصوصیات تضمین میکند که اندازه آزمون میتواند به صورت مجانبی کنترل شود و از طرفی توان آزمون نیز توسط فرض مقابل قابل اندازهگیری است.

از نظر شهودی، ایده اصلی در آزمون هاسمن این است که وقتی مدلها به درستی مشخص شوند، برآوردگرهای مقایسه شده در هر دو مدل به یکدیگر نزدیک خواهند بود، اما وقتی مدل نادرست تشخیص داده شود، برآوردگرهای مقایسه شده از یکدیگر فاصله خواهند داشت.

آماره آزمون هاسمن

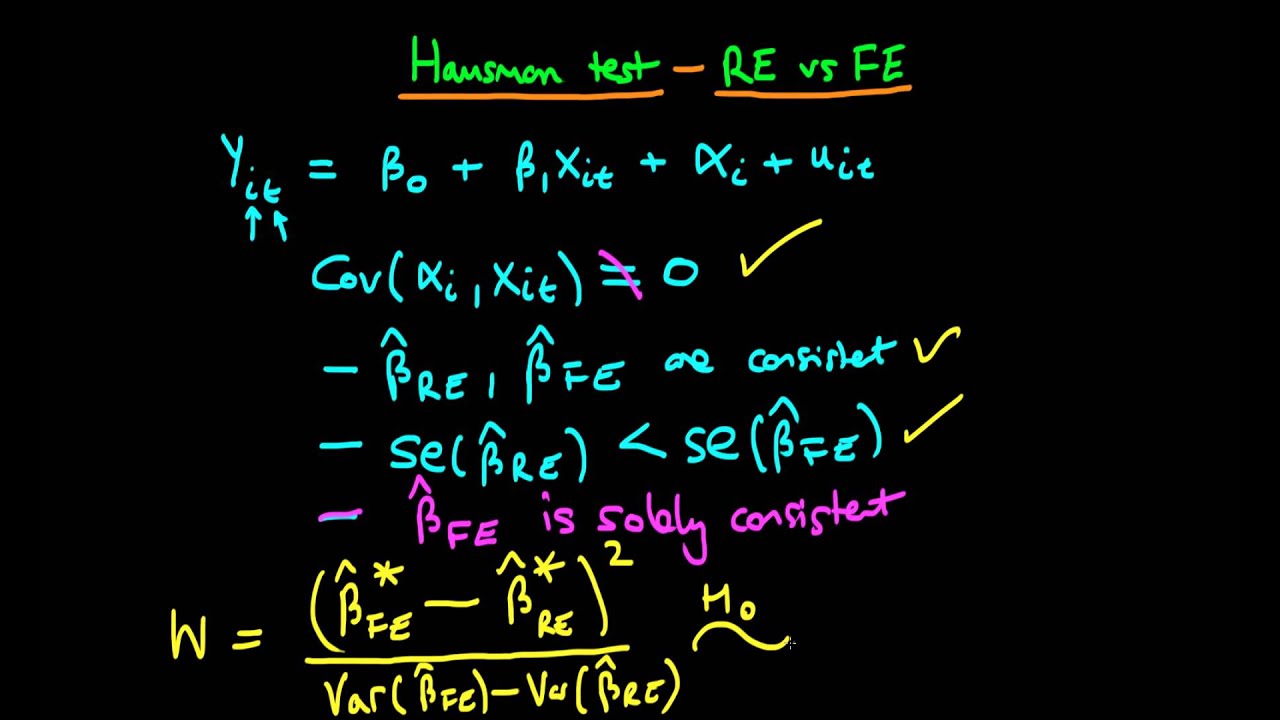

فرض کنید یک مدل خطی به صورت زیر برای تشخیص رابطه بین بردار متغیرهای مستقل و متغیر وابسته ساخته شده است. واضح است که عبارت جمله خطا را تشکیل داده است.

در اینجا برداری از ضرایب مدل رگرسیونی یا پارامترهای مدل در نظر گرفته شده است. براساس نمونه تصادفی دو برآوردگر با شیوههای متفاوت، برای بردار ضرایب مدل رگرسیونی ساخته شده است که اولی را با و دومی را با میشناسیم.

تحت فرض صفر هر دو این برآوردگرها سازگار هستند. به این معنی که با افزایش حجم نمونه، این دو برآوردگر در میانگین با یکدیگر برابر خواهند بود. از طرفی برآوردگر کارا است. به این معنی که دارای واریانس مجانبی کوچکتری نسبت به مجموعهای خاص از برآوردگرها است که نیز در این مجموعه قرار دارد.

تحت فرض مقابل، سازگار است در حالیکه این چنین نیست. به این ترتیب آماره آزمون هاسمن به شکل زیر تعریف میشود.

توجه داشته باشید که علامت نشانگر معکوس تعمیم یافته ماتریس (Generalize Inverse) است. تحت فرض صفر، آماره ، دارای توزیع کای ۲ با درجه آزادی برابر با رتبه ماتریس است. به این ترتیب اگر فرض صفر رد شود، نشانگر آن است که ناسازگار است. حال فرض کنید توزیع توام دو برآوردگر و نرمال باشد.

با در نظر گرفتن تحت فرض صفر داریم:

با استفاده از روش دلتا (Delta Method) میتوانیم توزیع را به صورت زیر مشخص کنیم.

هاسمن نشان داد که کوواریانس بین برآوردگر کارا با اختلافش از برآوردگر ناکارا، صفر است در نتیجه میتوان نوشت:

به این ترتیب آماره آزمون را به صورت زیر میتوان مشخص کرد:

که در آن رتبه ماتریس است.

آزمون هاسمن و داده پانلی

با توجه به مطالبی که در قسمتهای قبلی ارائه شد، میدانیم که آماره هاسمن به عنوان تابعی از تفاوت بین دو برآوردگر ساخته میشود. توزیع نمونه آماری هاسمن تعیین میکند که این اختلاف چقدر بزرگ است. با مقایسه آماره Hausman با یک مقدار بحرانی به دست آمده از توزیع کای ۲، یک آزمون آماری به نام هاسمن شکل میگیرد. اگر آماره هاسمن از مقدار بحرانی این آزمون بزرگتر باشد، فرض صفر رد میشود.

از آزمون «هاسمن» نیز میتوان برای تمایز و تشخیص بین مدل اثرات ثابت و مدل اثرات تصادفی در داده پانلی استفاده کرد. در این حالت، اثرات تصادفی (Random Effect) یا RE به دلیل کارآیی بالاتر برآوردگر در این مدل تحت فرض صفر ارجح است، در حالی که اگر فرض صفر رد شود، مدل تأثیرات ثابت (Fixed Effect) یا FE، ترجیح داده میشود.

کاربرد در مدل رگرسیون پانلی

به عنوان یک مثال، میتوان به مقایسه دو برآوردگر مختلف برای پارامترهای مدل رگرسیون داده پانلی اشاره کرد. به طور خاص، به خوبی مشخص است که برآوردگرهای پانل "اثرات تصادفی" و "اثرات ثابت" مطابق با این فرض که مدل به درستی مشخص شده است، سازگار هستند و متغیرهای پیشگو مستقل از اثرات ثابت هستند. این فرضیه منجر به استفاده از مدل "اثرات تصادفی" میشود.

در این حالت، برآوردگر اثرات تصادفی به صورت مجانبی کارا است. بنابراین تفاوت بین برآوردگرهای حاصل از مدل اثرات تصادفی و ثابت کوچک خواهد بود. از طرف دیگر، اگر فرض اثرات تصادفی تایید ولی مدل دارای اثرات تصادفی نباشد، برآوردگر اثرات ثابت سازگار باقی میماند، اما برآوردگر اثرات تصادفی ناسازگار میشود. بنابراین تفاوت بین برآوردگرهای اثرات تصادفی و اثرات ثابت ممکن است زیاد شود. از این رو مقایسه برآوردگرهای اثرات تصادفی و ثابت میتواند بر صحت فرض اثرات تصادفی تأثیر بگذارد.

میتوان این نتایج را در جدول زیر خلاصه کرد.

| فرض صفر صحیح است () | فرض مقابل صحیح است () | |

| برآوردگر مدل اثرات تصادفی (RE) | سازگار- کارا | ناسازگار |

| برآوردگر مدل اثرات ثابت (FE) | سازگار- ناکارا | سازگار |

خلاصه و جمعبندی

همانطور که در مطالب قبل خواندید، مشخص شد، میتوان از آزمون «هاسمن» (Hausman) برای آزمایش اینکه آیا اثرات ثابت به جای تأثیرات تصادفی مورد نیاز است، استفاده کرد. در این نوشتار با نحوه محاسبه آماره آزمون هاسمن برای داده پانلی آشنا شدیم. همچنین قواعد تصمیم و نواحی بحرانی نیز برای آزمون هاسمن ارائه و معرفی شد. همانطور که در تجزیه و تحلیل دادههای پانلی اشاره شد، یکی از روشهای بررسی نحوه به کارگیری مدل اثرات ثابت و یا اثرات تصادفی در داده پانلی، استفاده از آزمون هاسمن است که محاسبات مربوط به این آزمون در تحلیلهای داده پانلی نیز در این متن مورد بررسی قرار گرفت. البته برای مدلهای رگرسیونی و سری زمانی، شرط تصادفی بودن باقیمانده نیز باید مورد بررسی قرار گیرد. در دیگر نوشتار فرادرس به نام تصادفی بودن و آزمون گردش — به زبان ساده به این موضوع نیز پرداختهایم.

اگر این مطلب برای شما مفید بوده است، آموزشهای زیر نیز به شما پیشنهاد میشوند:

- مجموعه آموزشهای SPSS

- آموزش آمار و احتمال مهندسی

- مجموعه آموزشهای آمار و احتمالات

- مقدار احتمال (p-Value) — معیاری ساده برای انجام آزمون فرض آماری

- توزیع نرمال یک و چند متغیره — مفاهیم و کاربردها

- فرایند تصادفی (Random Process) — مفاهیم اولیه

^^

سلام.ببخشید اگر نمونه گیری بر اساس حذف سیستماتیک باشد میتوان از آزمون هاسمن صرف نظر کرد و مدل را براساس اثرات ثابت براورد نمود؟