تشخیص لبخند در چهره – راهنمای کاربردی

در این مطلب به چگونگی تشخیص لبخند در چهره و در واقع تشخیص شادی در تصاویر با استفاده از «زبان برنامهنویسی پایتون» (Python Programming Language) پرداخته شده است. کسب و کارها همواره در تلاش هستند تا مهمترین محصول ممکن را برای مخاطبان خود ارائه دهند و این محصول چیزی نیست جز «شادی». اما چرا؟ شادی چیزی بیش از یک واکنش شیمیایی است. احتمال بازگشت یک مشتری خوشحال بیشتر است و دادههای مربوط به شادی میتوانند به کسب و کارها در درک اینکه کدام محصولات در شادسازی مشتریان عملکرد بهتری داشتهاند و در واقع «نرخ بقای» (Retention Rate) بالاتری را فراهم کردهاند، کمک قابل توجهی کنند. ماشینها میتوانند یاد بگیرند که شادی را تشخیص بدهند و در این راهنما، چگونگی ساخت یک مدل تشخیص چهره که امکان تشخیص لبخند (شادی) را دارد، آموزش داده شده است.

کار با پرداختن به مقدمات موضوع آغاز میشود. انسانها چگونه شادی را توصیف میکنند؟ شادی در چهره، معمولا از طریق چشمها و لبخند بیان میشود. به طور طبیعی، افراد وقتی لبخند را در چهره دیگران میبینند چنین استنباط میکنند که آن فرد شاد است. لبخند میتواند انواع گوناگونی داشته باشد، اما به طور کلی معمولا شبیه به یک U مسطحتر است. این «(:» خندانک تبسم است که نمایی مینیمالی از تبسم را ارائه میکند. در ادامه، از «الگوریتم ویولا-جونز» برای تشخیص لبخند در چهره (تشخیص شادی) استفاده شده است.

مواردی که در ادامه و برای ساخت شناساگر شادی استفاده شدهاند، عبارتند از:

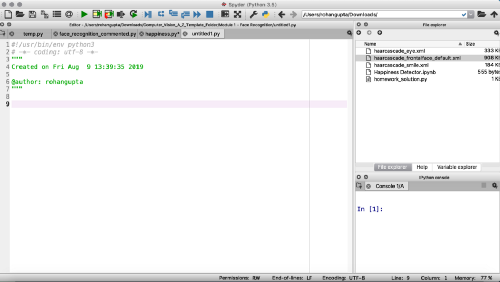

در ادامه، از «اسپایدر» (Spyder) در آناکوندا استفاده شده است. اما مخاطبان میتوانند از «نوتبوک ژوپیتر» (Jupyter Notebook) نیز استفاده کنند. افرادی که از اسپایدر استفاده میکنند، باید صفحهای مانند آنچه در تصویر زیر آمده است را مشاهده کنند. همچنین، پیش از آغاز کد زدن باید اطمینان حاصل کنند که Haar Cascades را دانلود کرده باشند.

Haar Cascades

الگوریتم ویولا-جونز (Viola-Jones Algorithm) از ویژگیهای Haar مانند برای تشخیص ویژگیهای چهره استفاده میکند. Cascade مجموعهای از فیلترها است که یکی پس از دیگری برای تشخیص چهره از طریق ویژگیهای آن، بر تصویر اعمال میشوند.

این فیلترها در فایل XML خودشان در مخزن گیتهاب Haar Cascades [+] ذخیره شدهاند. برای ساخت شناساگر شادی، نیاز به سه فایل XML زیر است.

این موارد Cascadeهایی برای چهره، چشمها و لبخند هستند. باید هر یک از این ویژگیها در صورت شاد بودن تصویر وجود داشته باشند. کد به دست آمده از هر یک از لینکها را باید در ویرایشگر متن قرار داد و فایل را مطابق با اسامی بیان شده در بالا ذخیرهسازی کرد. هر سه فایل XML را باید در پوشه مشابهی ذخیره شوند که نوتبوک پایتون از آنجا باز میشود و کار خواهد کرد. حالا که Haar Cascades موجود است، باید به سراغ محیط مجازی رفت. اکنون، زمان کد زدن فرا رسیده است.

وارد کردن OpenCV و بارگذاری Cascadeها

تنها کتابخانهای که باید «وارد» (Import) شود OpenCV است. با وجود آنکه این کتابخانه ابزار بسیار قدرتمندی برای تشخیص شی است، قدرتمندترین ابزار نیست. ابزارهای قدرتمندتر و جدیدتری نیز برای این کار ارائه شدهاند؛ اما OpenCV همچنان ارزشآفرین است و راهکار خوبی برای درک مبانی تشخیص شی محسوب میشود.

پس از وارد کردن (OpenCV (cv2، هر یک از Cascadeهای دانلود شده فراخوانی میشوند. بدین منظور، تنها نیاز به استفاده از تابع OpenCV به نام CascadeClassifier است.

تعریف تابع تشخیص روی چهره، چشمها و لبخند

پیش از تعریف تابع تشخیص، باید این موضوع را دانست که این موارد بر یک تصویر تنها اعمال میشوند و سپس، با کنار هم قرارگیری همه تصاویر، نتیجه نهایی حاصل میشود. به دلیل آنکه الگوریتم ویولا جونز با تصاویر سیاه و سفید کار میکند، اولین آرگومان در این تابع روی grayscale (سیاه و سفید) تنظیم شده است. اگرچه، برای رنگی کردن تصویر نیاز به خروجی نهایی است؛ بنابراین آرگومان img برای تصویر نهایی قرار میگیرد.

سپس، نیاز به دریافت مختصات مستطیلی است که چهره را تشخیص میدهد. برای تعریف این مختصات، ۴ تاپل در نظر گرفته میشود: w ،y ،x و h. تاپلهای x و y مختصات گوشه چپ بالا هستند، در حالیکه w و h به ترتیب عرض و ارتفاع مستطیل محسوب میشوند. این تاپلها در متغیر face ذخیره میشوند و سپس از دیگر تابع OpenCV که به آن detectMultiScale گفته میشود برای گرفتن این مختصاتها استفاده میشود. بنابراین، از شی Cascade_face استفاده میشود و متد detectMultiScale با سه آرگومانی که در زیر بیان شدهاند روی آن اعمال میشوند:

- grayscale، زیرا تصویر در حالت سیاه و سفید تحلیل میشود.

- «عامل تغییر ابعاد» (Scale Factor) برابر با ۱٫۳ (اندازه تصویر به میزان 1.3x کاهش پیدا میکند)

- حداقل عدد مناطق همسایه پذیرفته شده: ۵ همسایه

سپس، برای ترسیم مستطیلها، یک حلقه for با ۴ تاپل h_face ،y_face ،x_face و w_face ساخته میشود. در حلقه For، از تابع rectangle استفاده شده است که از جمله دیگر توابع OpenCV محسوب میشود. این کار موجب ترسیم مستطیل روی چهره میشود و در این راستا، آرگومانهای زیر به آن داده شده است.

- «img» زیرا هدف ترسیم مستطیل روی تصویر اصلی (رنگی) است.

- مختصات گوشه سمت چپ بالا: x و y

- مختصات گوشه سمت چپ پایین: w و h

- رنگ مستطیل: در اینجا از یک رنگ مایل به آبی استفاده شده است.

- ضخامت لبههای مستطیل: در اینجا ضخامت ۲ انتخاب شده است (البته این انتخاب بدین معنا نیست که ۲ بهترین گزینه و انتخاب ممکن است).

توجه: کد زیر، در کد نهایی موجود در انتهای مطلب آمده است و در اینجا صرفا برای درک بهتر موضوع و به دلیل ارائه توضیحات پیرامون آن، آورده شده است.

اکنون که کار با چهره تمام شد، وقت تشخیص چشمها رسیده است. این تنها بخشی است که نیاز به مقداری ترفند دارد و درک آن سختتر است. اساسا، خطوطی که در بالا به آنها اشاره شده، باید برای چشمها در چهره وجود داشته باشند و بنابراین، چهره، «ناحیه مورد بررسی» (Region of Interest) محسوب میشود. به دلیل آنکه الگوریتم تنها با تصاویر سیاه و سفید کار میکند، آرگومان grayscale قرار داده میشود. اگرچه، نیاز به دریافت تصویر رنگی شده است، بنابراین آرگومان دیگری برای تصویر رنگی اضافه خواهد شد.

اساسا، ۲ منطقه مورد بررسی وجود دارد که در ادامه مورد بررسی قرار گرفتهاند. یک منطقه برای تصاویر سیاه و سفید و یک منطقه برای تصویر رنگی شده اصلی است. متعاقبا، ri_grayscale روی تصویر سیاه و سفید اصلی با طیفی از مختصاتهای مستطیل y:y+h و x:x+w قرار میگیرد. سپس، در تصویر رنگی، ri_color با مختصات مشابه مستطیلها ساخته میشود.

سپس، یک حلقه for برای چشمها ساخته میشود. میتوان مورد قبلی را copy-paste کرد و رد این صورت تنها نیاز به تغییر نام تاپل و انتخاب یک رنگ متفاوت است.

سپس، مجددا برای لبخند، مراحل مشابهی با آنچه برای چهره و چشمها انجام شد، صورت میپذیرد. هنگامی که از متد detectMultiScale استفاده میشود، از عامل مقیاس ۱٫۷ و حداقل همسایگی ۲۰ استفاده میشود (همانطور که پیش از این نیز بیان شد، برای درک این موضوع نیاز به کمی تجربه است). هنگامی که همه این کارها انجام شد، نیاز به فریم اصلی است.

نمایش خروجی در وبکم

کار با ساخت یک شی که vc نامیده میشود و از کلاس VideoCapture از OpenCV استفاده میکند، آغاز شده است. این شی تنها آرگومانهای ۰ یا ۱ را میپذیرد. ۰ در صورتی که از وبکم داخلی و ۱ برای حالتی که از وبکم خارجی استفاده شود است. از آنجا که تابع تشخیص برای یک تصویر تنها کار میکند، اکنون باید حلقهای ساخته شود که این کار را در مجموعهای از تصاویر انجام دهد. بنابراین، از یک حلقه While نامتناهی استفاده میشود که با استفاده از تابع Break شکسته میشود. اکنون، خطوط بعدی ممکن است گیج کننده به نظر بیایند؛ اما اساسا، متد read از VideoCapture دو عنصر را دریافت میکند.

یکی از این عناصر آخرین فریمی است که از وبکم میآید. به دلیل آنکه کاربر تنها آن را میخواهد، باید img استفاده کرد، زیرا متد read تنها ۲ فریم را باز میگرداند و این تنها چیزی است که کاربر میخواهد. اکنون نیاز به فراخوانی این متد از کلاس VideoCapture است. از تابع cvtColor که تصاویر رنگی را به سیاه و سفید تبدیل میکند استفاده شده است؛ زیرا نیاز به یک چارچوب سیاه و سفید برای تشخیص تابع دارد. این تابع را grayscale نامیده و کلاس cvtColor دریافت میشود که میتواند ۲ آرگومان را دریافت کند.

- فریم (img)

- cv2.COLOR_BGR2GRAY (که میانگینی از Blue-green-red برای دریافت سایههای مناسبی از خاکستری است).

اکنون، متغیر جدیدی به نام final ساخته شده است؛ این متغیر، نتیجه تابع detect خواهد بود. با final، از تابع تشخیص با آرگومانهای grayscale و img استفاده میشود. تابع imshow تابع OpenCV دیگری است که این امکان را فراهم میکند که محتوای اصلی از وبکم و با یک انیمیشن مستطیل بیاید. این تابع تصاویر پردازش شده را به صورت متحرک شده نمایش میدهد. سپس، از تابع دیگری برای بستن پنجره در هنگامی که کار با آن تمام شده است، استفاده میشود.

همچنین، یک شرط if اعمال شده است که کاربر هر بار که دکمه q را روی کیبورد فشار دهد، برنامه کاربردی را متوقف میکند. این کار حلقه while را تا پایان فرایند میشکند. در نهایت، از متد release برای خاموش کردن وبکم و از تابع DestroyAllWindows برای متوقف کردن همه پنجرهها استفاده میشود. کد کامل مورد استفاده برای این کار، به منظور شفافیت هر چه بیشتر در ادامه ارسال شده است.

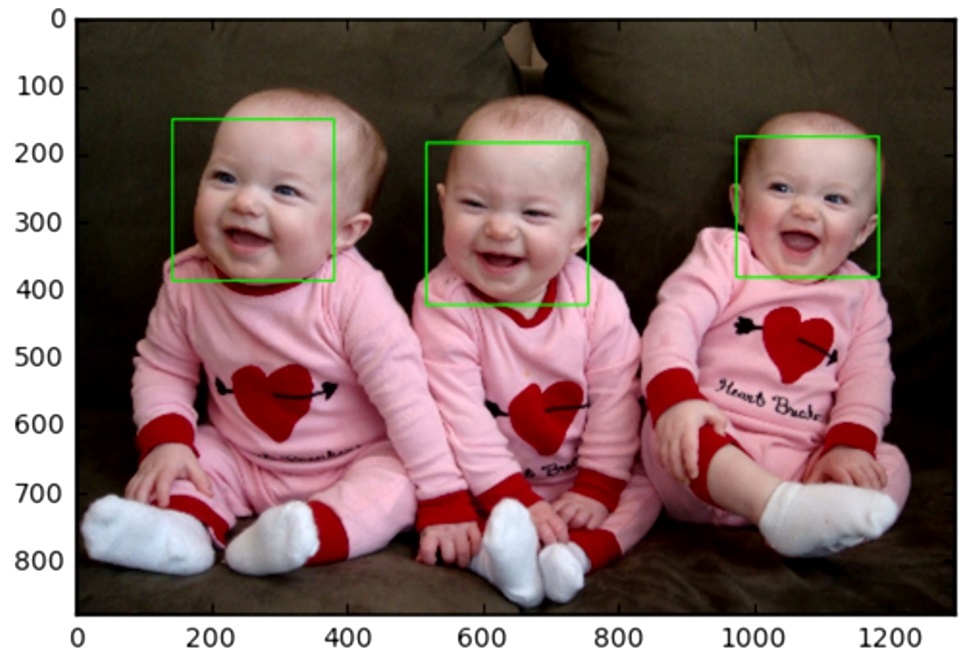

نتایج برنامه تشخیص لبخند در چهره

در ابتدا، به دلایل متعددی مدل به درستی کار نمیکرد. در واقع، مدل صورتهایی که تبسم نداشتند را نیز به عنوان چهره در حال تبسم در نظر میگرفت.

بنابراین عامل تغییر ابعاد و حداقل همسایهها مجددا بررسی شدند و تغییر کردند تا بهترین نتیجه حاصل شود.

اگر مطلب بالا برای شما مفید بوده، آموزشهای زیر نیز به شما پیشنهاد میشود:

- مجموعه آموزشهای دادهکاوی و یادگیری ماشین

- مجموعه آموزشهای دادهکاوی یا Data Mining در متلب

- مجموعه آموزشهای هوش مصنوعی

- زبان برنامهنویسی پایتون (Python) — از صفر تا صد

- یادگیری ماشین با پایتون — به زبان ساده

- آموزش یادگیری ماشین با مثالهای کاربردی — مجموعه مقالات جامع وبلاگ فرادرس

^^

سلام خوبین شما ، ممنون از اطلاعاتی ک در اختیار ما میزارین ، ببخشین یه سوال دارم ، اینکه فایل های xml که برای این کلاسیفایر استفاده میشن ، توسط sql باید نوشته بشن ؟ ممنون میشم راهنمایی کنین