محاسبه معیار ارزیابی AIC در R – به زبان ساده

در دیگر نوشتارهای فرادرس با عنوان معیار ارزیابی AIC در مدلهای احتمالی --- از صفر تا صد مفهوم ارزیابی مدل و شیوه اندازهگیری آن توسط معیار AIC آشنا شدید. در این نوشتار ابتدا با مفهوم تابع درستنمایی بیشتر آشنا شده و سپس نحوه محاسبه معیار ارزیابی AIC در زبان برنامهنویسی محاسباتی R را مرور کرده و براساس این زبان و توابع کتابخانهای R، به بررسی تابع درستنمایی و شیوه بدست آوردن AIC برای مقایسه مدلهای تصادفی میپردازیم.

به این منظور بهتر است با بعضی از دستورات این زبان برای مدلسازی در نوشتارهای روشهای رگرسیون در R — کاربرد در یادگیری ماشین (قسمت اول) و روشهای رگرسیون در R — کاربرد در یادگیری ماشین (قسمت دوم) آشنا شوید. همچنین خواندن مطلب توزیع های آماری — مجموعه مقالات جامع وبلاگ فرادرس که به معرفی چند توزیع احتمالی برای پدیدههای تصادفی میپردازد، نیز خالی از لطف نیست.

محاسبه معیار ارزیابی AIC در R

یکی از شاخصهای ارزیابی مدلهای آماری «معیار ارزیابی آیکاکی» (Akaike Information Criterion - AIC) است که برحسب «تابع درستنمایی» (Likelihood Function) محاسبه میشود. با توجه به وابستگی AIC به تابع درستنمایی ابتدا به بررسی این تابع پرداخته و سعی میکنیم با مفهوم آن براساس محاسباتی که در R انجام میدهیم، بیشتر آشنا شویم.

تابع درستنمایی (Likelihood Function)

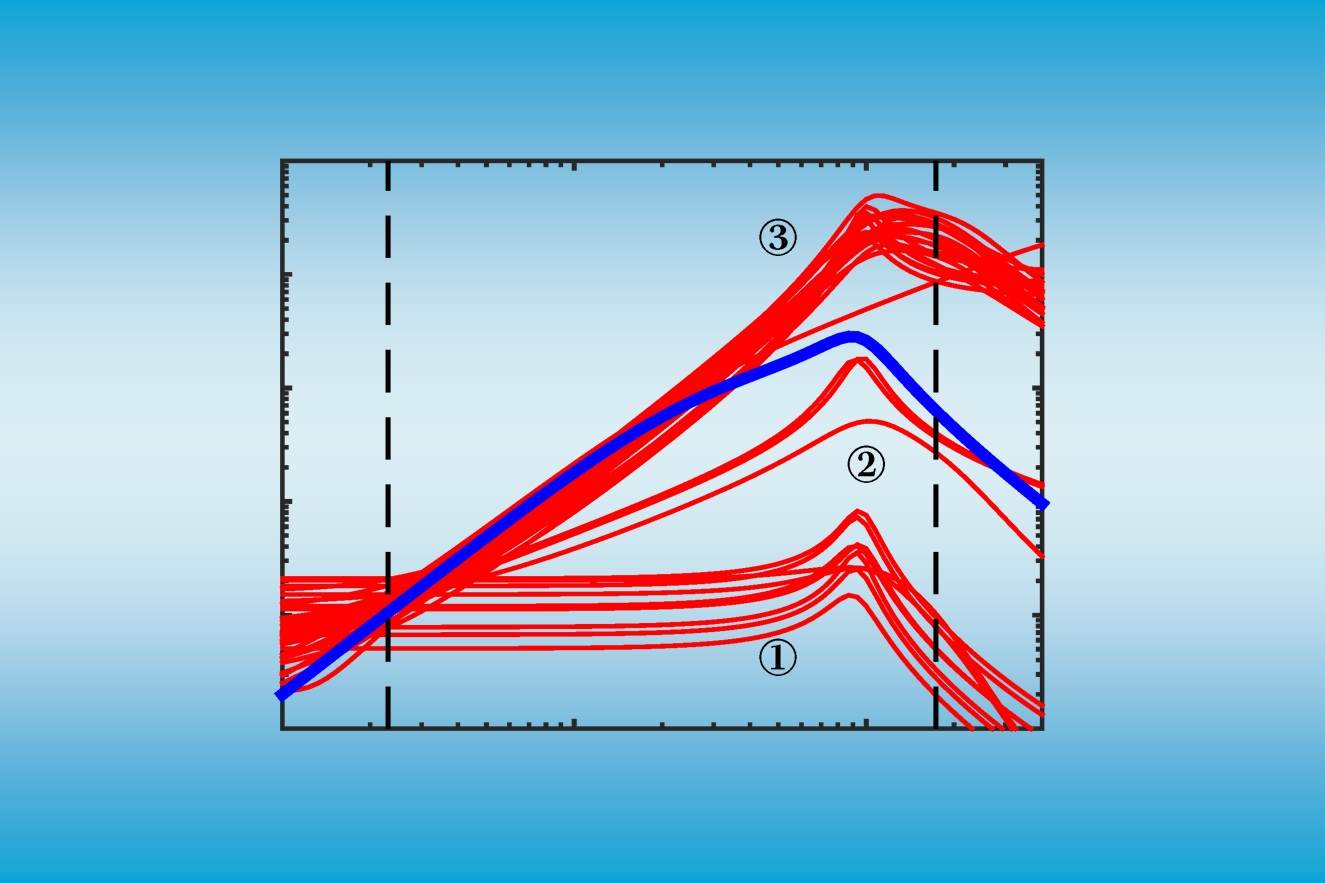

فرض کنید بوسیله کد زیر، ۵۰ نمونه تصادفی از توزیع نرمال با میانگین و انحراف معیار تولید شده است و برای نمایش فراوانی و توزیع دادهها نیز یک «هیستوگرام» (Histogram) ترسیم کردهایم.

مشخص است که در این دادهها، مقدار میانگین جامعه آماری a<-۵ و انحراف معیار آن نیز sdy<-۳ در نظر گرفته شده است.

حال قرار است که بوسیله این نمونه تصادفی، پارامتر توزیع متغیر تصادفی را مشخص کنیم. کدی که در ادامه مشاهده میکنید به منظور برآورد پارامترهای میانگین و واریانس براساس نمونه قبلی، برای یک جامعه آماری با توزیع نرمال نوشته شده است. همانطور که مشخص است پارامتر family برابر با مقدار gaussian در نظر گرفته شده تا بیانگر توزیع نرمال باشد.

خروجی این کد به صورت زیر خواهد بود. مشخص است که برآورد پارامترهای میانگین در این خروجی و واریانس است که در نتیجه جذر آن که انحراف معیار را نشان میدهد برابر با خواهد بود.

همانطور که دیده میشود، مقدار AIC نیز که موضوع این مطلب است، در انتهای جدول، محاسبه و برابر با 233.72 نشان داده شده است.

نکته: برای استخراج برآورد پارامترهای توزیع آماری این مقدارها میتوانید از دستورات زیر نیز کمک بگیرید.

باید توجه داشت که در اینجا دادهها از یک جامعه با میانگین ۵ و انحراف معیار ۳ تولید شدهاند و برآوردها نیز بسیار به مقدارهای واقعی نزدیک هستند. در گام بعدی مقدار توزیع نرمال را در نقطه به کمک برآوردهای حاصل از مرحله قبل بدست میآوریم. همانطور که دیده میشود از دستور dnorm که برای محاسبه تابع چگالی توزیع نرمال در یک نقطه خاص استفاده میشود، کمک گرفتهایم.

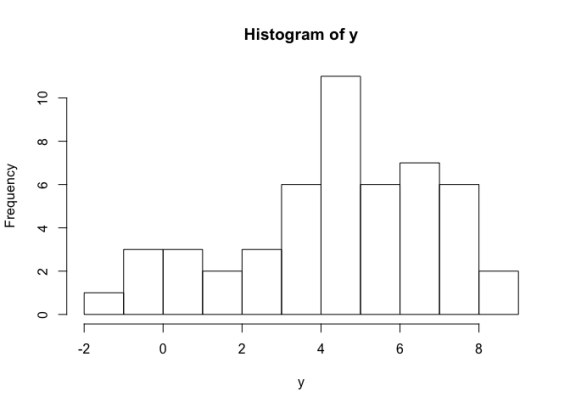

این مقدار (0.09196167) همان مقدار تابع احتمال (Likelihood) برای مقدار برحسب میانگین و انحراف معیار برآورد شده است. به این ترتیب به نظر میرسد که محاسبه تابع درستنمایی براساس مشاهدات صورت گرفته و مقدار آن از نمونه به نمونهای دیگر متفاوت است. در کدی که در زیر مشاهده میکنید تابع درستنمایی برای مشاهدات مختلف ترسیم شده است. مشخص است که این نمودار اگر برحسب متغیر بودن مشاهدات تصور شود، همان تابع چگالی توزیع نرمال خواهد بود.

محور افقی در این نمودار از مقدارهای مختلف (نمونههای تصادفی) تشکیل شده است. از طرفی محور عمودی نیز مقدار تابع چگالی احتمال را برای هر نقطه نمایش میدهد.

حال اگر بخواهیم برای چندین نمونه تصادفی، تابع احتمال توام را مشخص کنیم با فرض استقلال نمونهها و متغیرهای تصادفی، حاصلضرب تابع احتمال برای متغیرهای تصادفی (نمونههای مختلف) میتواند بیانگر توزیع توام باشد. در این حالت با توجه به یکنوا بودن تابع لگاریتم میتوانیم از لگاریتم حاصلضرب تابع توزیع توام استفاده کنیم تا نتیجه به جای حاصلضرب صورت حاصل جمع لگاریتم تابع احتمال هر یک از نمونهها در آید. این کار را به کمک کد زیر انجام دادهایم.

همانطور که دیده شد، ابتدا برای نمونههای تصادفی مختلف () تابع احتمال محاسبه شده سپس لگاریتم آن بدست آمده است. به این ترتیب برای انجام تحلیل روی تابع درستنمایی از لگاریتم تابع درستنمایی که به صورت مجموع لگاریتم توابع درستنمایی هر نمونه نوشته میشود، استفاده خواهیم کرد. مشخص است که مقدار تابع درستنمایی براساس نمونه تصادفی 50 تایی تولید شده، برابر با 114.8636- است.

نکته: از آنجایی که مقدارهای مربوط به تابع درستنمایی به مانند تابع چگالی محاسبه میشوند، معمولا در فاصله صفر تا یک قرار میگیرند در نتیجه لگاریتم آنها منفی است. به همین دلیل در اغلب موارد مقدار لگاریتم تابع درستنمایی منفی است.

مقایسه فرضیههای مختلف به کمک تابع درستنمایی

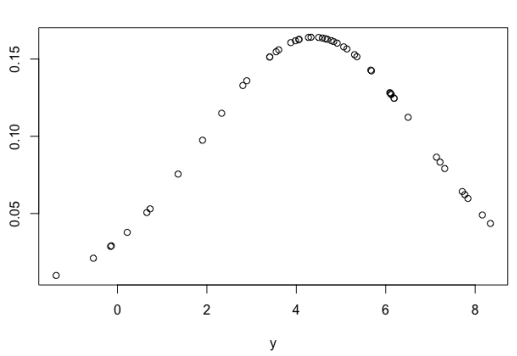

فرض کنید قرار است اثر متغیرهای و را روی مشخص کنیم. منظورمان از میزان اثر، قابلیت پیشبینی متغیر برحسب متغیرهای و است. قطعه کدی که در ادامه مشاهده میکنید به این منظور تهیه شده است.

البته فرض بر این است که بین متغیر و یک رابطه تقریبا خطی با معادله و مقداری نوفه (Noise) برقرار است. تولید متغیر توسط دستور انجام شده است.

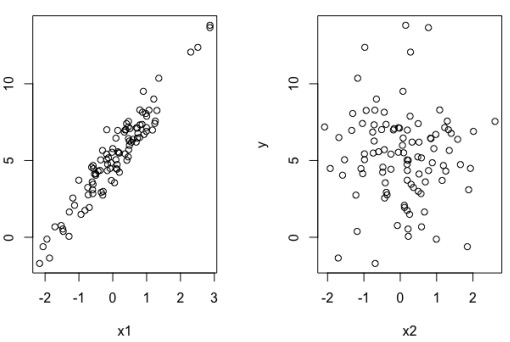

نتیجه اجرای این کد نمودارهایی است که در ادامه مشاهده میکنید. واضح است قدرت پیشبینی متغیر برای بسیار بیشتر از قدرت پیشبینی متغیر روی است.

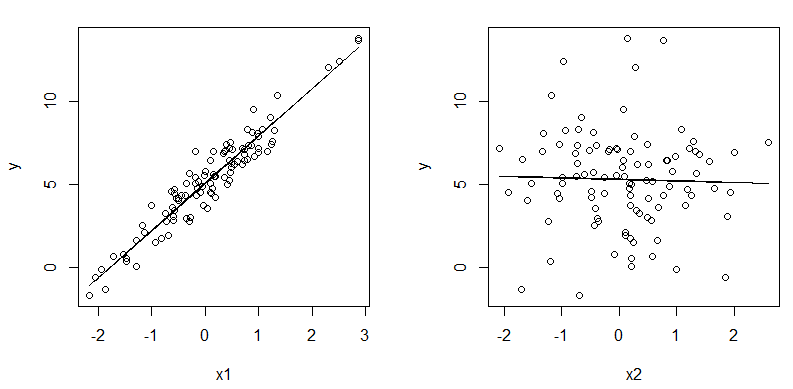

این امر را میخواهیم بوسیله مدلبندی و تابع glm در R نیز نشان دهیم. به این منظور سه مدل را در نظر میگیریم. در مدل اول () اثر متغیر روی مشخص میشود. در مدل دوم () تاثیر متغیر بر اندازه گرفته شده و در مدل سوم () اثرات متغیرهای و بر متغیر وابسته مورد تحلیل قرار میگیرد. دستوراتی که در ادامه دیده میشوند، برای ایجاد این مدلها در R نوشته شدهاند.

به این ترتیب به کمک دستورات زیر نمودار ارتباط و خط پیشبین برای دو مدل اول و دوم را ترسیم میکنیم.

مشخص است که به علت آنکه مدل سوم به صورت سه بعدی است، نمودار آن را رسم نکردهایم.

در ادامه، کدهایی را میبینید که برای نمایش پارامترهای مدلهای ایجاد شده لازم است. همچنین در انتها نیز مقدار لگاریتم تابع درستنمایی توسط جمع (sum) برای هر مدل محاسبه شده است.

نکته: توجه کنید که پارامتر انتهایی تابع dnorm به صورت log=TRUE باعث میشود که لگاریتم تابع چگالی برای هر نمونه محاسبه شود. در نتیجه مجموع این مقدارها همان لگاریتم تابع درستنمایی (لگاریتم چگالی توام متغیرهای تصادفی) است.

همانطور که میبینید، مدلی که دارای بزرگترین مقدار تابع لگاریتم درستنمایی باشد، مناسبترین مدل در بین این سه مدل خواهد بود. بنابراین مدل اول و سوم به نظر مناسب هستند و مدل دوم با مدل مناسب بسیار فاصله دارد. البته با توجه به اینکه میزان فاصله لگاریتم تابع درستنمایی برای مدل اول و سوم زیاد نیست و از طرفی مدل دارای متغیرهای کمتر در نتیجه سادهتر است، استفاده از آن بر مدل ترجیح دارد. به نظر میرسد که احتیاج به معیاری داریم که بتواند تعداد پارامترها را هم در محاسبات شرکت دهد و ما را به نتیجه دلخواه برساند. از آنجایی که در شیوه محاسبه AIC این وضعیت در نظر گرفته شده است و مقدار AIC برحسب تعداد پارامترها جریمه میشود، به نظر میرسد که برای تشخیص مدل مناسب، معیار بهتری باشد.

معیار AIC و تعیین تعداد پارامتر

برای آنکه بتوانیم معیاری بسازیم که به تعداد پارامترهای مدل حساس بوده و بتواند میزان مناسب بودن مدل را نشان دهد، از ترکیب تابع درستنمایی و که بیانگر تعداد پارامترها است، استفاده میکنیم. ابتدا تابع درستنمایی را قرینه میکنیم تا بیشینهسازی تابع درستنمایی مشابه کمینهسازی تابع قرینه آن باشد. از آنجایی که توزیع مجانبی نیز معلوم است از این عبارت برای تعیین معیار جدید استفاده میکنیم. از طرفی میزان جریمه را هم به شکل در نظر میگیریم تا شدت جریمه را متناسب با دوبرابر تعداد پارامترها تعیین کنیم. در این صورت رابطه زیر را AIC مینامیم.

منظور از نقطهای از فضای پارامتری است که تابع درستنمایی (لگاریتم تابع درستنمایی) را حداکثر میکند. این مراحل محاسباتی AIC برای مدل در کدهای زیر دیده میشود.

در انتها نیز مقدار نیز اضافه میشود تا نتیجه AIC بدست آید.

از آنجایی که پارامترهای مدل عرض از مبدا ، شیب خط و البته واریانس جمله خطا است، تعداد پارامترها برابر با در نظر گرفته شده است. در ادامه برای مدلهای و نیز مقدار AIC را محاسبه میکنیم.

مشخص است که برای مدل مقدار AIC کوچکترین مقدار است. در نتیجه برحسب معیار AIC، این مدل به نظر مناسبتر میرسد.

نکته: البته برای محاسبه AIC میتوانید از تابع کتابخانه stats به نام AIC استفاده کنید. کد زیر این کار را انجام میدهد. مشاهده میکنید که مقدارهای محاسبه شده توسط این تابع درست به مانند محاسباتی است که در کد قبلی مشاهده شد.

اصول پایه AIC

هنگام استفاده از معیار AIC باید نکات و اصول زیر را در نظر گرفت. در غیر اینصورت ممکن است در نتایج حاصل از آن دچار اشتباه شویم.

- معیار AIC، روشی نسبی برای تعیین مدل مناسب است. در این صورت محاسبه AIC برای یک مدل به تنهایی معنی ندارد و مقدار آن باید با AIC مدلهای دیگر مقایسه شود.

- در بین مدلها، کوچکترین مقدار AIC مدل مناسب را تعیین میکند.

- از معیار AIC برای انتخاب مدل مناسب از بین مدلهایی که روی مجموعه داده ثابتی ایجاد شدهاند باید استفاده کرد.

- اگر تعداد نمونهها زیاد باشد، ممکن است معیار AIC دچار مشکل شود. در این هنگام بهتر است از معیار AIC اصلاح شده که به نام AICc معروف است، استفاده کنید.

اگر مطلب بالا برای شما مفید بوده است، احتمالاً آموزشهایی که در ادامه آمدهاند نیز برایتان کاربردی خواهند بود.

- مجموعه آموزشهای آمار، احتمالات و دادهکاوی

- آموزش تخمین خطای طبقه بندی یا Classifier Error Estimation

- مجموعه آموزشهای دادهکاوی و یادگیری ماشین

- بیش برازش (Overfitting)، کم برازش (Underfitting) و برازش مناسب — مفهوم و شناسایی

- تابع درستنمایی (Likelihood Function) و کاربردهای آن — به زبان ساده

^^