مدل سازی آرایه فتوولتاییک با هوش مصنوعی | پیاده سازی در متلب

توان خروجی یک نیروگاه معمولی را که برخلاف نیروگاه خورشیدی که به ماهیت منبع انرژی (خورشید) و سایر عوامل محیطی نظیر دمای محیط وابسته است، میتوان به سادگی کنترل کرد. مشکل اصلی سیستمهای فتوولتاییک، نامعینی توان خروجی آنهاست. بنابراین، برای استفاده مؤثر از این سیستمها، باید توان خروجی آنها را پیشبینی کرد. با پیشبینی دقیق توان خروجی سیستم میتوان بر ماهیت نامعین توان تولیدی غلبه کرد و در نتیجه قابلیت اطمینان کل سیستم را بهبود داد. مدلسازی یکی از راههای انجام این کار است. در این آموزش، با مدل سازی آرایه فتوولتاییک آشنا میشویم.

مدل سازی آرایه فتوولتاییک با شبکه عصبی

مدلهای مبتنی بر شبکه عصبی مصنوعی (ANN) راهکاری برای حل مشکل شرایط آب و هوایی متغیر هستند که رابطه غیرخطی بین متغیرهای ورودی و خروجی سیستم پیچیده را توصیف میکنند. توانایی خودیادگیری شبکههای عصبی، مزیت اصلی این مدلها محسوب میشود. بنابراین، این مدلها حین عملکرد نامعین، مانند توان خروجی آرایه سیستم، دقیق هستند.

شبکه عصبی مصنوعی، مجموعهای از تکنیکهای پردازش اطلاعات با الهام از رویکرد اطلاعات پردازش سیستم عصبی بیولوژیکی است. یک ANN از واحدهای جزئی موازی به نام نرون تشکیل شده است. نرونها به وسیله شمار زیادی از پیوندهای وزنی به هم وصل میشوند که امکان انتقال سیگنال یا اطلاعات را دارند. یک نرون، ورودیها را از طریق اتصالات ورودی خود دریافت و ورودیها و خروجیها را ترکیب میکند. مفهوم اصلی شبکههای عصبی ساختار سیستم پردازش اطلاعات، مشابه تکنیک تفکر انسان است. شبکه عصبی میتواند رابطه بین متغیرهای ورودی و خروجی را با مطالعه دادههای ثبت شده قبلی یاد بگیرد. مزیت اصلی ANN این است که با استفاده از آن میتوان برای مسائل پیچیده مربوط به فناوریهای معمول که راهحل الگوریتمی ندارند یا برای حل نیازمند یک الگوریتم پیچیدهتر هستند، راهحل مناسبی ارائه کرد.

برخی از شبکههای عصبی مختلف، عبارتند از: «شبکههای عصبی تابع پایه شعاعی» (Radial Basis Fnction Networks) یا RBF، «شبکههای پیوند تابعی» (Functional Link Networks)، «شبکههای عصبی رگرسیون عمومی» (General Regression Neural Networks) یا GRNN، «شبکههای کوهونن» (Kohonen Networks)، «شبکههای رو به جلوی آبشاری» (Cascade Forward Neural Network) یا CFNN، «شبکههای عصبی پیشخور» (Feedforward Neural Network) یا FFNN، «شبکههای گرام-شارلی» (Gram–Charlier Networks)، «کوانتیزاسیون بردار یادگیری» (Learning Vector Quantization)، «شبکههای هب» (Hebb Networks)، «شبکههای آدلاین» (Adaline Networks)، «شبکههای غیرمشارکتی» (Heteroassociative Networks)، «شبکههای بازگشتی» (Recurrent Networks) و «شبکههای ترکیبی» (Hybrid networks) هستند.

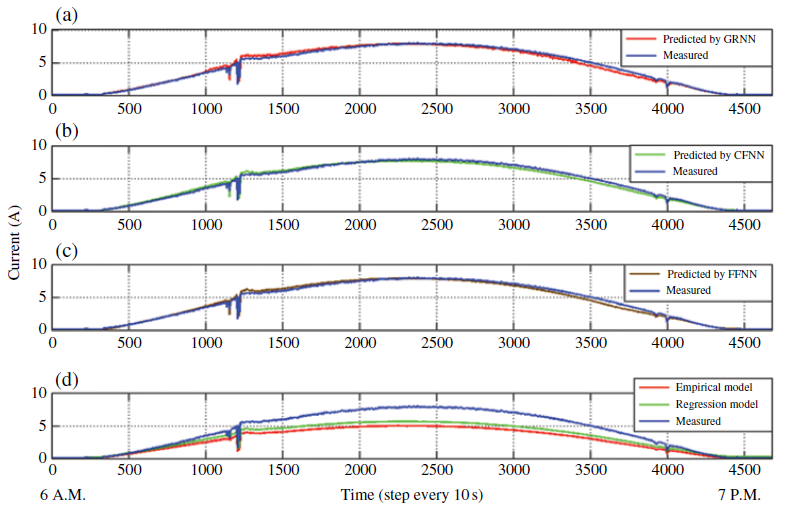

در این آموزش، شبکههای FFNN ،GRNN و CFNN را برای مدلسازی جریان خروجی آرایه فتوولتاییک انتخاب میکنیم. برای انتخاب بهترين مدل جهت این کار، شبكههای عصبی مختلف مانند CFNN و FFNN مقايسه شدهاند. این مدلها با استفاده از متلب تشکیل شده، آموزش دیده و اعتبارسنجی میشوند.

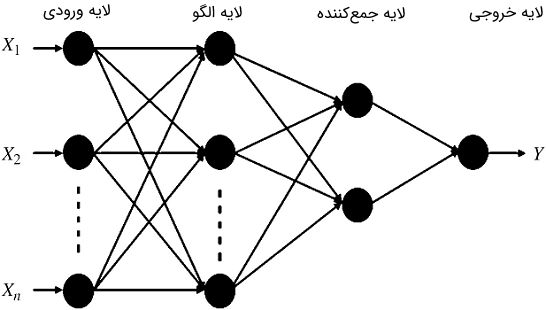

GRNN یک شبکه مبتنی بر احتمالات است. این شبکه وقتی متغیر هدف قطعی است طبقهبندی انجام میدهد، در حالی که وقتی متغیر هدف پیوسته باشد رگرسیون انجام میدهد. GRNNها شامل لایههای ورودی، الگو، جمعکننده و خروجی هستند. شکل ۱ نمودار کلی GRNN را نشان میدهد.

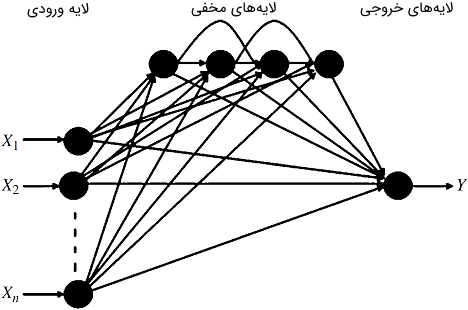

DFNN یک شبکه «خودسازمانده» و به نوعی شبیه FFNN است. هر دو شبکه مذکور از الگوریتم پسانتشار (BP) برای بهروزرسانی وزنها استفاده میکنند. شکل ۲ نمودار شماتیک کلی CFNN را نشان میدهد.

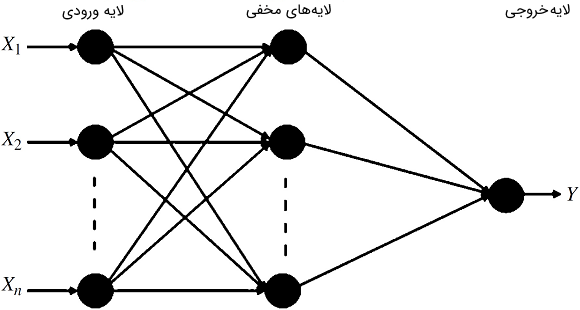

از سوی دیگر، شکل۳ نمودار شماتیک FFNN را نشان میدهد. این شبکه شامل لایههای ورودی، مخفی و خروجی است. پیشخور بدین معنی است که مقادیر فقط از لایه ورودی به لایه مخفی و سپس به لایههای خروجی حرکت میکنند.

بدون آموزش دادن و تخمین خطای تعمیم، هیچ قاعده مستقیمی برای یافتن تعداد بهینه نرونهای مخفی وجود ندارد. با این حال، اگر تعداد نرونهای مخفی کم باشد، ممکن است کمبرازش رخ دهد که سبب خطای آموزش و خطای تعمیم بالا خواهد شد. هنگامی که تعداد زیادی نرون در لایه مخفی اعمال شود، بیشبرازش و واریانس بالا رخ میدهد. معمولاً تعداد گرههای مخفی را میتوان با برخی قوانین سرانگشتی به دست آورد. برای مثال، تعداد نرونهای لایه مخفی باید عددی بین اندازه لایه ورودی و اندازه لایه خروجی باشد. برخی نیز پیشنهاد کردهاند که تعداد نرونهای مخفی نباید بیش از دو برابر تعداد ورودیها باشد. در جایی دیگر توصیه شده که تعداد گرههای مخفی دو سوم یا 70 تا 90 درصد تعداد گرههای ورودی باشد. بر اساس پیشنهادهای فوق، تعداد نرونهای لایه مخفی مدلهای FFNN و CFNN برابر با دو گره مخفی در نظر گرفته شدهاند.

برای ارزیابی مدل پیشنهادی، از سه خطای آماری استفاده شده است که عبارتاند از: «درصد میانگین قدر مطلق خطا» (Mean Absolute Percentage Error) یا MAPE، «خطای انحراف میانگین» (Mean Bias Error) یا MBE و «خطای جذر میانگین مربعات» (Root Mean Square Error) یا RMSE.

دقت کلی یک شبکه عصبی را میتوان با MAPE بررسی کرد. MAPE به صورت زیر تعریف میشود:

که در آن، دادههای اندازهگیری شده و دادههای پیشبینی شده هستند.

از سوی دیگر، شاخص انحراف میانگین مقادیر پیشبینی شده از دادههای اندازهگیری شده را میتوان با MBE بیان کرد. مقدار MBE مثبت نشان دهنده تخمین بیش از حد است. اطلاعات عملکرد طولانی مدت مدل شبکه عصبی نیز با MBE ارزیابی میشود. MBE را میتوان بهصورت زیر محاسبه کرد:

که در آن، دادههای اندازهگیریشده و دادههای پیشبینیشده هستند.

شاخص خطای آماری که در این آموزش استفاده میشود RMSE است. اطلاعات عملکرد کوتاهمدت مدل را میتوان با RMSE ارزیابی کرد. این، نشان دهنده اندازهگیری تغییرات دادههای پیشبینی شده حول دادههای اندازهگیری شده است. همچنین RMSE نشان دهنده بازدهی مدل تشکیل شده در پیشبینی مقادیر بعدی است. یک RMSE مثبت و بزرگ، انحراف بزرگ در دادههای پیشبینی شده از دادههای اندازهگیری شده را نشان میدهد. RMSE را میتوان با فرمول زیر محاسبه کرد:

مثال مدل سازی آرایه فتوولتاییک با شبکه عصبی

مدلی را در متلب تشکیل دهید که سه مدل فوق را با هم مقایسه کند. نتایج منبع دادههای «Source 2» را آزمایش و آنها را با مدلهای تجربی و آماری مقایسه کنید.

حل: برنامه زیر، پاسخ این مسئله است:

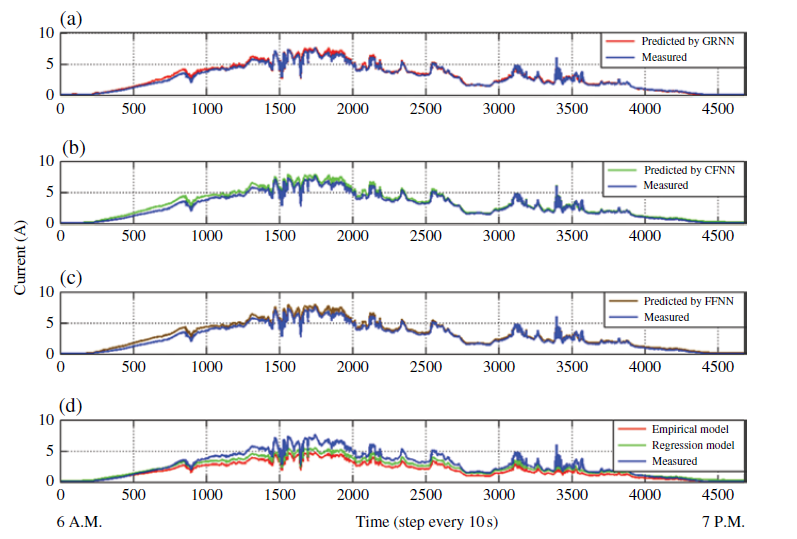

شکلهای زیر، حاصل از اجرای این برنامه هستند.

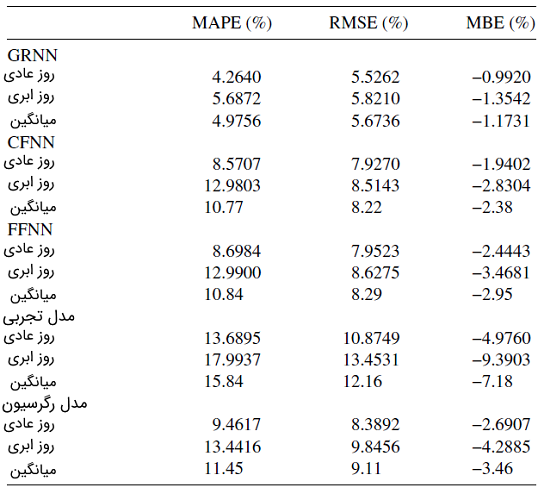

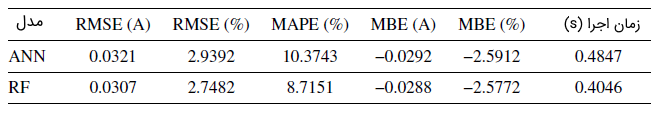

جدول زیر، ارزیابی آماری مدلها را نشان میدهد.

مدل سازی آرایه فتوولتاییک با الگوریتم جنگل تصادفی

در بخش قبل، مدلسازی توان خروجی سیستم فتوولتاییک با شبکههای عصبی انجام شد. این شبکهها میتوانند نامعینیهای خروجی سیستم را مدیریت کنند. با این حال، استفاده از شبکههای عصبی برای چنین هدفی، همراه با محدودیتها و چالشهایی مانند پیچیدگی فرایند آموزش، محاسبه نرونهای لایه مخفی و توانایی اداره دادههای بسیار نامعین است. برای حل این مشکل میتوان از برخی روشهای جدید با دقت و توانایی بالا در مدیریت دادههای بسیار نامعین مانند «مدلهای مبتنی بر جنگل تصادفی» (Random Forest-based Models) یا RF استفاده کرد.

مدل RF شامل درختهای تصمیم تصادفی و کیسهبندی است. «کیسهبندی» (Bagging) روشی برای کاهش واریانس تابع پیشبینی تخمینی است. درختهای تصمصم که از درختان ناهمبسته استفاده میکنند، تعمیمی از کیسهبندی هستند. سادهترین RFها با انتخاب گروه کوچکی از متغیرهای ورودی برای انشعاب تصادفی در هر گره تشکیل میشوند.

روش جنگل تصادفی، با ایجاد یک مجموعه جدید از مقادیر شروع میشود که با اندازه دادههای اصلی برابرند و به صورت تصادفی از مجموعه دادههای اصلی به وسیله خودراهاندازی یا بوتاسترپ انتخاب میشوند. پس از آن، دادههای جدید به صورت دنبالهای از انشعابات باینری (دوتایی) برای ایجاد درختهای تصمیم مرتب میشوند. در هر گرهای از این درختها، انشعاب با انتخاب مقدار و متغیر با خطای کمینه محاسبه میشود. در پایان، یک میانگین ساده از پیشبینهای تجمعی برای پیشبینی رگرسیون و یک رأی اکثریت ساده برای پیشبینی در طبقهبندی گرفته میشود.

تکنیکهای تجمعی خودراهانداز با دقت پیشبینی تقویت میشوند و تعیین میزان خطا و اهمیت متغیر را ممکن میسازند. میزان خطا و اهمیت متغیر با حذف مقادیر هر نمونه خودراهانداز محاسبه میشوند که دادههای «خارج از کیسه» (Out-of-bag) یا OOB نام دارند. دادههای OOB نقش اصلی را در رشد درخت ایفا میکنند، بدین معنی که این دادهها با مقادیر پیشبینی شده در هر مرحله مقایسه میشوند. در این روش، میزانهای خطا به دست آمده و از OOB نیز برای تعیین اهمیت متغیر استفاده میشود.

طبقهبندی و رگرسیون

درختهای طبقهبندی و رگرسیون پاسخهای پیشبینی شده به دادهها هستند. هنگام پیشبینی پاسخ، تصمیم، هر درخت را از گره اصلی به یک گره برگ در جنگل هدایت میکند که حاوی پاسخ است. درختهای رگرسیون پاسخ را به شکل عددی و درختهای طبقهبندی آن را به صورت اسمی (درست یا غلط) بیان میکنند.

جنگلهای تصادفی، بسته به درختهای طبقهبندی و رگرسیون ایجاد شده تغییر میکنند و طی مراحل زیر ساخته میشوند. در مرحله اول، همه دادههای ورودی برای آزمایش تمام انشعابات دوتایی ممکن در هر پیشبین استفاده شده، سپس انشعابی انتخاب میشود که بهترین مقیاس بهینهسازی را دارد. در مرحله دوم، انشعاب انتخاب شده به دو گره فرزند جدید تقسیم میشود. این فرایند برای گرههای فرزند جدید تکرار میشود.

اما دو مورد مقیاس بهینهسازی و دستور توقف برای کامل کردن فرایند قبل لازم است. مقیاس بهینهسازی مشخص میکند که انشعاب انتخابی برای کمینه «میانگین مربعات خطا» (Mean Square Error) یا MSE دادههای پیشبینی نسبت به دادههای آموزشی باید بررسی شود. در مقابل، در درختهای طبقهبندی، یکی از سه روش «شاخص تنوع جینی» (Gini’s Diversity Index) انحراف یا «قانون تقسیمبندی دوحالتی» (Towing Rule) برای انتخاب انشعاب به کار میرود.

طبقهبندی فرایندی است که در آن موضوعات شناخته، درک و متمایز میشوند. این فرایند، موضوعات را به صورت دستههای مستقل برای اهداف خاص دستهبندی میکند. طبقهبندی، فهم روابط بین موضوعات و زیرموضوعات را فراهم میکند. این فرایند در زبان، استنباط، تصمیمگیری، پیشبینی و انواع برهمکنش محیطی به کار میرود. طبقهبندی مانند رگرسیون در یادگیری ماشین نقش دارد.

رگرسیون یک فرایند آماری برای تعیین روابط بین متغیرهاست. هنگامی که روابط بین یک متغیر وابسته (یا یک «متغیر معیار») و یک یا چند متغیر مستقل بررسی میشوند، تکنیکهای بسیاری برای مدلسازی و تحلیل در رگرسیون گنجانده میشود.

از رگرسیون برای پیشبینی استفاده میشود و در طبقهبندی با یادگیری ماشین اشتراک دارد. در جنگلهای تصادفی، رگرسیون با رشد هر درخت مربوط به یک بردار تصادفی تشکیل میشود. مقادیر خروجی، عددی هستند. پیشبین درخت تصمیم با میانگینگیری از همه درختهای جنگل ساخته میشود.

الگوریتم رگرسیون

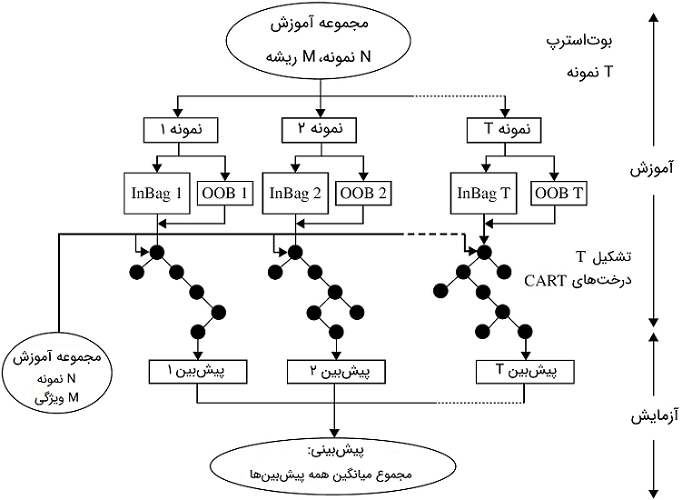

الگوریتم جنگل تصادفی، ترکیبی از مراحل آموزش و آزمایش است. در مرحلهٔ آموزش، الگوریتم، نمونه خودراهانداز را از دادههای آموزش اصلی رسم میکند و سپس تعدادی از درختهای رگرسیون یا طبقهبندی هرس نشده (Unpruned) یا CART را برای هر نمونه خودراهانداز ایجاد میکند. بهترین انشعاب صرفاً از نمونه تصادفی پیشبینها در هر گرهای از CART جدا (انتخاب) شده و انشعابی انتخاب میشود که خطا را به حداقل میرساند.

در هر تکرار خودراهانداز، دادهها با استفاده از تکنیک رشد درخت با نمونه خودراهانداز پیشبینی میشوند. میزان خطا برای هر پیشبین و پیشبینیهای OBB تجمعی محاسبه میشوند. اکنون گرههای پایانی دادههای جدیدی دارند که با تعیین میانگین تجمعی پیشبینها از میان تمام درختها پیشبینی میشوند. خطای درخت جنگل تصادفی به دو پارامتر وابسته است: همبستگی بین هر دو درخت و استحکام (مقاومت) هر درخت به صورت مجزا. هنگامی که مجموعه آموزشی یک درخت به وسیله نمونهبرداری رسم میشود، تعداد متغیرهای هر سطح در بهبود عملکرد مهم هستند. شکل ۶ مراحل اصلی الگوریتم جنگل تصادفی را نشان میدهد.

وقتی مجموعه آموزش به وسیله نمونهبرداری برای یک درخت خاص رسم میشود، از حدود یکسوم نمونههای مجموعه چشمپوشی خواهد شد. این نمونهها دادههای OBB نامیده شده و برای تخمین اهمیت متغیر و ساختار داخلی دادهها (اندازه نزدیکی) بهکار میروند. در اینجا، نمونههای داخل کیسه برای درخت خاص و نمونههای مکمل برای همان درخت را نمایش میدهد.

علاوه بر الگوریتم رگرسیون، جنگلهای تصادفی، اندازهگیری قابل توجهی از اهمیت متغیر (اثرات خاص ورودیها روی خروجی) بر اساس دادههای OOB و نیز اندازهگیری اهمیت-تغییر انجام میدهند. اهمیت هر متغیر را میتوان با تغییر تمام مقادیر متغیر در نمونههای OOB برای هر درخت به صورت تصادفی به دست آورد. اندازهگیری اهمیت متغیر به صورت اختلاف بین دقتهای پیشبینی قبل و بعد از تغییر متغیر محاسبه میشود که روی تمام پیشبینها میانگین گرفته است. وقتی اهمیت متغیر کاهش یابد، دقت پیشبینی زیاد میشود. مقدار اهمیت هر متغیر با میانگین اهمیت تمام درختها با استفاده از رابطه زیر به دست میآید:

که در آن، متناظر با نمونههای خارج از کیسه برای یک درخت خاص، تعداد درختها () و تعداد کل درختهاست. همچنین و دستههای پیشبینی شده برای هر نمونه مربوط به یک درخت قبل و بعد از تغییر متغیر هستند. پارامتر مقدار نمونه و برچسب درستی است که هردوی آنها در مرحله آموزش هستند.

پیشبینی جریان خروجی یک سیستم فتوولتاییک، با تنظیم اولیه متغیرها و نمونههای ورودی در الگوریتم کیسهپرکن شروع میشود. در اینجا، ورودیها تابش خورشید، دمای محیط، شماره روز، ساعت، عرض جغرافیایی، طول جغرافیایی و تعداد ماژولها هستند. در حقیقت، با هیچ فرمول ریاضی نمیتوان تعداد بهینه درختها را تنظیم کرد. تعداد درختها نصف تعداد نمونهها فرض میشود و تعداد برگهای هر درخت به صورت پیشفرض 5 است.

مثال مدل سازی آرایه فتوولتاییک با الگوریتم جنگل تصادفی

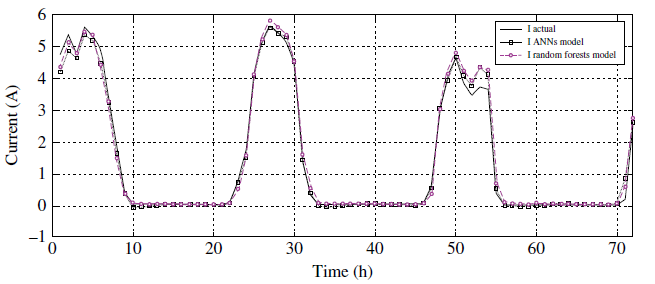

جریان خروجی سیستم فتوولتاییک مثال قبل را با استفاده از مدل جنگل تصادفی پیشبینی کرده و آن را با مدل مبتنی بر شبکه عصبی مقایسه کنید.

حل: برنامه جنگل تصادفی، با تعریف متغیرهای الگوریتم از قبیل شماره روز، تعداد ساعات در روز، دمای محیط، عرض جغرافیایی، طول جغرافیایی و تعداد ماژولها به عنوان ورودیها و جریان خروجی فتوولتاییک به عنوان خروجی شروع میشود. در مرحله نخست، برنامه مهمترین متغیرهای مؤثر بر خروجی را جستوجو میکند. در عین حال، دورافتادهها و خوشههای دادههای تشخیص داده میشوند. تعداد درختها برابر با نصف کل تعداد مشاهدات فرض میشود.

برنامه متلب این مثال به صورت زیر است.

در مرحله دوم، پس از آنکه متغیرهای مهم به دست آمدند، به عنوان ورودیها مرتب میشوند. در اینجا، یک بهینهسازی برای تعداد درختها و تعداد برگهای هر درخت با استفاده از یک روش تکراری و به ترتیب مبنی بر حداقل RMSE، زمان سپری شده، MAPE و MBE انجام میشود.

در مرحله سوم، مهمترین متغیرها و بهترین تعداد درختها و برگها در هر درخت مرتب میشوند. اکنون، برنامه برای آموزش و پیشبینی جریان خروجی فتوولتاییک آماده است.

جدول زیر مقادیر آماری و زمان صرف شده روشهای شبکه عصبی و جنگل تصادفی را نشان میدهد.

مدل سازی آرایه فتوولتاییک با تکنیکهای جستوجوی اکتشافی

معادله خروجی سلول خورشیدی را میتوان با روشهای بسیاری از قبیل روش «نیوتون-رافسون» (Newton–Raphson) یا NR، الگوریتم «لونبرگ-مارکوارت» (Levenberg–Marquard) یا LM، روشهای مبتنی بر شبکه عصبی و روشهای عددی دیگر حل کرد. اخیراً روشهای اکتشافی از قبیل «الگوریتم ژنتیک» (Genetic Algorithm) یا GA، «بهینهسازی ازدحام ذرات» (Particle Swarm Optimization) یا PSO، «بهینهسازی جفتگیری پرنده» (Simplified Bird Mating Optimizer) یا SBMO، «تکامل تفاضلی» (Differential Evolution)، «الگوریتم بهینهسازی جستوجوی ممنوعه» (Tabu Search Optimization Algorithm)، «بهینهسازی آشوب موازی جهشی» (Mutative-scale Parallel Chaos Optimization Algorithm) یا MPCOA و الگوریتمهای تبرید شبیهسازیشده (Simulated Annealing) یا SA به علت بازده و قابلیت اطمینان بالا برای حل چنین مسائلی مورد استفاده قرار گرفتهاند.

از رابطه ۱ واضح است پارامترهایی که بر عملکرد ماژول فتوولتاییک تسلط دارند، ، ، ، و هستند. این پارامترها مجهول و به تابش خورشید و دمای سلول بستگی دارند. بنابراین، میتوان از یک الگوریتم بهینهسازی برای به دست آوردن مقادیر بهینه این پارامترها استفاده کرد. در اینجا، یک تابع هدف برای یافتن پارامترهای محاسبه شده مدل ماژول به صورت بهینه فرمولبندی میکنیم. تابع هدف به صورت RMSE است که تفاوت بین جریان محاسبه شده و تجربی را نشان میدهد. این تابع بهصورت زیر است:

که در آن:

و و ، به ترتیب، مقادیر تجربی ولتاژ و جریان صفحه فتوولتاییک هستند. همچنین، برداری از پنج پارامتر (، ، ، و ) و طول مجموعه داده است.

همانطور که بسیاری از پژوهشگران توصیه کردهاند که الگوریتمهای DE بیشترین کارایی را در حل چنین مسئلهای دارند، در اینجا نیز بر الگوریتم DE تمرکز میکنیم.

در الگوریتم DE رایج، الگوریتم جستجوی مستقیم مبتنی بر جمعیت که از مجموعه جمعیت اولیه استفاده میکند، از بردارهای تکی NDبُعدی تشکیل میشود که به صورت تصادفی انتخاب شدهاند. این بردارهای منفرد توسط یک فرایند ادغام به منظور یافتن مقادیر بهینه که یک کمینهسازی سراسری را برآورده میکند، هدایت میشوند. ساز و کار اصلی فرایند جذب جایگزینی بردارهای تکی بد در جمعیت با بردارهای تکی بهتر در هر تکرار است.

الگوریتم DE شامل چهار مرحله ساده و پشت سر هم است که عبارتاند از مقداردهی اولیه، جهش، گذر و انتخاب. این الگوریتم مانند سایر الگوریتمهای جستوجوی مستقیم مبتنی بر جمعیت که از یک مجموعه جمعیت اولیه () استفاده میکند که به طور تصادفی به عنوان یک جواب انتخاب میشود. این شامل الگوریتم شامل بردار مجزا است و هر بردار شامل پارامتر است که برای بهینهسازی مورد نیاز است. سه مرحله آخر (جهش، گذر و انتخاب) در هر گام تکرار میشوند تا جواب اولیه برای رسیدن به حداکثر تعداد نسل $$ G _ \max$$

که در آن:

که بردار هدف نامیده میشود و تعداد جوابهای کاندید جمعیت ()، بعد بردار تکی () و اندیس نسل ($$ G = 1 , 2 , ... , G _\max$$

شکل ۶ الگوریتم پیشنهادی را نشان میدهد. مراحل این الگوریتم در ادامه توضیح داده شدهاند.

مقداردهی اولیه: فرایند بهینهسازی با ایجاد یک جمعیت اولیه آغاز میشود: و . مقادیر اولیه پارامتر به طور تصادفی انتخاب و به صورت یکنواخت در ناحیه جستوجو توزیع میشوند. ناحیه جستوجو به ترتیب با کرانهای پایین و بالای و محدود میشود. بردار تکی مقدار اولیه به صورت زیر انتخاب شده است:

که rand یک عدد تصادفی در بازه است.

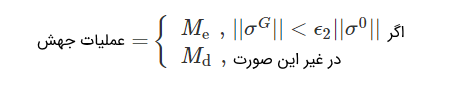

جهش: DEAM مقدار یا را در یک تکرار فراخوانی میکند. معیاری که برای جابهجایی بین هر دو نوع جهش استفاده میشود، این است:

که و نرم بردارهای انحراف معیار بردارهای سطری جمعیت برای و نسل اولیه هستند و یک پارامتر سوئیچینگ است که برای سوئیچ بین عملیات و به کار میرود و . برای هر بردار هدف ، یک بردار جهش بر اساس عملیات به صورت زیر تولید میشود:

که بردارهای ، و بردارهایی هستند که به صورت تصادفی از جمعیت انتخاب میشوند و ، و شاخصهای مجزایی هستند که به بازه تعلق دارند. بردار بردار پایه نامیده میشود و پارامتر کنترل مقیاس جهش است که معمولاً در بازه انتخاب میشود.

در همین حال، عملیات جهش نیز بر اساس سه بردار مجزا است که به طور تصادفی از بین جمعیت انتخاب میشوند، اما بر خلاف ، شاخص یکی از این بردارها ممکن است همان شاخص بردار فعلی باشد. عملیات از کل نیروی وارده بر یک بردار منفرد توسط دو بردار دیگر و استفاده میکند. مانند الگوریتم EM، نیروی اعمال شده بر توسط و بر اساس بارهای بین بردارهای زیر محاسبه میشود:

که مقدار تابع هدف برای بردار تکی است و و ، به ترتیب، بهترین و بدترین بردارهای تکی هستند که مقادیر بهترین و بدترین تابع هدف را برای نسل اُم رقم میزنند. نیز شاخصی است که به تعداد نسل بر میگردد ($$G = 1 , 2 , ... , G _ \max $$

در نتیجه، نیروی اعمالی بر توسط و به شکل زیر محاسبه میشود:

سپس، بردار جهش عملیات به صورت زیر محاسبه میشود:

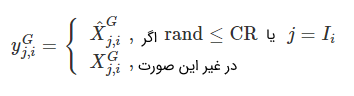

گذر: مرحله گذر DEAM مشابه همانی است که در الگوریتم DE وجود دارد. در این مرحله، هر دو بردار هدف و بردار جهش برای تولید بردار آزمایش به کار میروند که به صورت زیر بیان میشود:

که یک عدد تصادفی در بازه است. همچنین، یک شاخص تصادفی در بازه و پارامتر کنترل گذر است. بردار آزمایش برابر با بردار جهش است.

پارامترهای بردار آزمایشی را در صورتی که خارج از فضای مجاز جستوجو باشد، بررسی کرد تا اطمینان حاصل شود که مقادیر پارامتر مقادیر فیزیکی هستند. اگر هر پارامتر خارج از حد مجاز فضای جستوجو باشد، با مقدار جدید به شرح زیر جایگزین میشود:

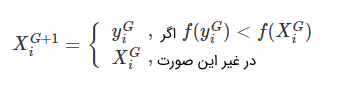

انتخاب: مرحله انتخاب پس از تولید بردارهای آزمایشی N اعمال میشود. روند انتخاب بین بردارهای هدف فعلی و آزمایشی براساس مقادیر تابع هدف برای هر دو بردار است. برداری كه تابع هدف كوچكی دارد، به عنوان عضوی از جمعیت برای نسل بعدی انتخاب میشود. روند انتخاب را میتوان به این صورت توصیف کرد:

سرانجام، بازتولید بردارهای آزمایش (جهش و گذر) و مراحل انتخاب تا رسیدن به شرایط توقف از پیش تعیین شده ادامه دارد.

مثال مدل سازی آرایه فتوولتاییک با تکنیکهای جستوجوی اکتشافی

برنامهای بنویسید که با استفاده از الگوریتم DE ماژول جدول زیر را به صورت بهینه مشخص کند.

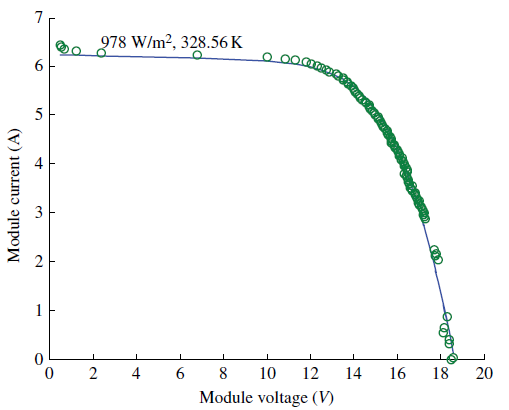

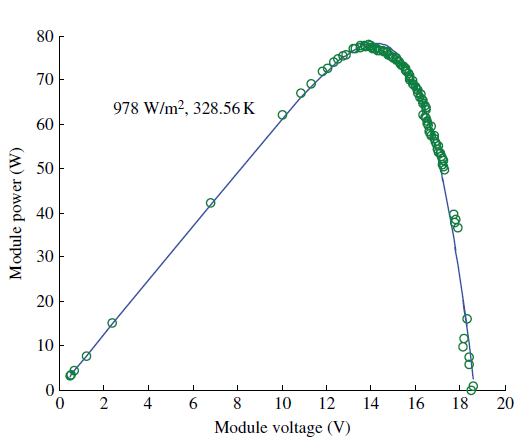

حل: برای حل این مسئله، چهار ام فایل متلب مورد نیاز است. اولین مورد برای به دست آوردن مقدار پنج پارامتر استفاده میشود. در این برنامه، مقادیر تابش خورشید و دمای سلول به دست میآید. علاوه بر این، جریان و ولتاژ آزمایشی (برای منحنی I-V) نیز به دست میآیند. پس از آن، برنامه دوم به عنوان یک تابع MATLAB برای پیادهسازی الگوریتم DE فراخوانی میشود و مقادیر بهینه پنج پارامتر را در شرایط خاص آبوهوایی برمیگرداند. سپس مشخصات I-V و P-V برای شرایط خاص آبوهوایی با استفاده از روش NR به دست میآید. پس از آن، عملکرد برازندگی الگوریتمهای DE در هر نسل اعمال میشود.

برنامههای مذکور در ادامه آورده شدهاند:

نتایج اجرای برنامه نوشته شده، شکلهای زیر خواهد بود.