Unsupervised Learning چیست؟ – توضیح به زبان ساده

یادگیری ماشین زیرشاخهای مهم از هوش مصنوعی است که کامپیوترها را قادر میسازد تا پیشبینی کرده و از محیط اطراف خود یاد بگیرند. همچنین از طریق پیشبینی و بررسی اطلاعات ورودی، به انسانها نیز در تصمیمگیری کمک میکند. به نسبت نوع و ماهیت مسئله، برخی مدلهای یادگیری ماشین به مجموعهدادههای از قبل برچسبگذاری شده نیاز داشته و برخی دیگر فرایند یادگیری مستقلی دارند. روش «یادگیری نظارت نشده» (Unsupervised Learning) زیرمجموعهای از یادگیری ماشین و متمرکز بر کشف الگوها و ساختارهای موجود در داده است که نیازی به دادههای برچسبگذاری شده ندارد. در این مطلب از مجله فرادرس، به پرسش مهم یادگیری نظارت شده چیست پاسخ میدهیم و با گستره رایجی از انواع مختلف آن آشنا میشویم. نوعی ویژه از هوش مصنوعی که علاوهبر ایجاد توانایی یادگیری در الگوریتمها، به آنها این امکان را میدهد تا بدون نیاز به دخالت انسان، خود را با دادههای جدید تطبیق دهند.

در این مطلب از مجله فرادرس، پس از آشنایی با مبانی اولیه یادگیری نظارت نشده به بررسی تفاوت آن با یادگیری نظارت شده پرداخته و به نقش دادههای برچسبدار در این دسته از الگوریتمها پی میبریم. پس از معرفی انواع و کاربردهای یادگیری نظارت نشده، شرحی از چالشها و روشهای پیشرفته ارائه میدهیم. در انتهای این مطلب، از تاثیر دو رویکرد یادگیری عمیق و یادگیری انتقالی در یادگیری نظارت نشده میگوییم و به چند مورد از پرسشهای متداول در این زمینه پاسخ میدهیم.

مبانی Unsupervised Learning چیست؟

یادگیری نظارت نشده نوع خاصی از یادگیری ماشین است که الگوریتمها را قادر میسازد تا بدون راهنمایی نمونههای برچسبگذاری شده، الگوها و همچنین ساختارهای نهفته را در دادهها کشف کرده و یاد بگیرند. هدف اصلی یادگیری نظارت شده در شناسایی روابط پنهان، گروهبندی دادهها و پیشبینی خودکار خلاصه میشود. در یادگیری نظارت نشده برخلاف «یادگیری نظارت شده» (Supervised Learning)، داده برچسبگذاری شدهای وجود ندارد. منظور از دادههای برچسبدار، جفت ورودی-خروجیهایی با خروجی مشخص است. در عوض، الگوریتمهای یادگیری نظارت نشده از دادههای بدون برچسب استفاده میکنند؛ ویژگی که یادگیری نظارت نشده را نسبت به روشهایی مانند یادگیری نظارت شده، برای کاربردهایی همچون «تجزیه داده اکتشافی» (Exploratory Data Analysis) مناسب میسازد. بیشترین مورد استفاده یادگیری نظارت نشده در شناسایی اطلاعات پنهان و الگوهای موجود در دادهها است. با این حال، از آنجایی که گاهی اوقات خروجی شناخته شده نیست، یادگیری نظارت شده باعث بروز چالشهایی در علم داده میشود؛ از جمله:

- پیچیدگی محاسباتی بالا.

- احتمال بالای وقوع خطا در خروجی.

- مدت زمان آموزش طولانی.

- نیاز به انسان برای سنجش خروجی.

- تفسیرپذیری پایین روشهای خوشهبندی.

یکی از چالشهای اصلی در یادگیری نظارت شده، تعیین تعداد مناسب «خوشهها» (Clusters) یا ابعاد لازم برای تحلیل داده است. چالشی که اغلب با عنوان «مسئله انتخاب مدل» (Model Selection Problem) از آن یاد میشود. در یادگیری نظارت شده از تکنیکهایی مانند روش Elbow و «تحلیل نیمرخ» (Silhouette Analysis) برای تخمین بهینه تعداد خوشهها یا ابعاد استفاده میشود. از آنجایی که در این روش خبری از برچسب نیست که با خروجی مقایسه شود، نیاز به معیاری مشخص برای سنجش عملکرد مدل، چالشی دیگر در یادگیری نظارت نشده است.

بهطور معمول، محققان برای حل این مشکل به معیارهای ارزیابی مبتنیبر دامنه بسنده میکنند و به دلیل قابلیت سنجش آسان، یادگیری نظارت نشده را به عنوان مرحلهای پیش از یادگیری نظارت شده در نظر میگیرند. یادگیری نظارت نشده در زمینههای بسیاری از جمله الگوریتمها و مجموعهدادههای مورد استفاده، چالشها و کاربردها با یادگیری نظارت شده متفاوت است و بازه گستردهای از کاربردها را دربر میگیرد.

تفاوت یادگیری نظارت شده و Unsupervised Learning چیست؟

در جدول زیر به برخی از تفاوتهای کلیدی میان دو روش یادگیری نظارت شده و نظارت نشده اشاره شده است:

| یادگیری نظارت شده | یادگیری نظارت نشده | |

| هدف | دستیابی به تابعی که ورودیها را بر اساس جفت ورودی-خروجیهای نمونه با یکدیگر تطبیق میدهد | ایجاد نمایشی دقیق از دادهها و تولید محتوای خلاقانه بر اساس آن |

| دقت | دقت بالا و قابل اطمینان | دقت کمتر و قابل اطمینان |

| پیچیدگی | سادهتر | محاسبات پیچیده |

| تعداد کلاس | مشخص | نامشخص |

| خروجی | مقدار خروجی مشخص که به آن «سیگنال نظارتی» (Supervisory Signal) نیز گفته میشود | فاقد مقدار خروجی متناظر با ورودی |

داده های برچسبدار و یادگیری نظارت شده

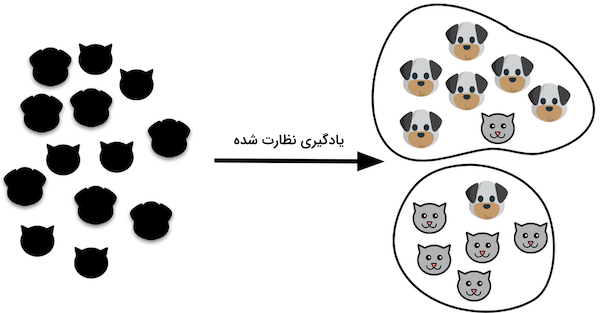

گفتیم که تفاوتی یادگیری نظارت شده و Unsupervised Learning چیست اما در ادامه باید با دادههای برچسبدار نیز آشنا شویم تا درک بهتری از این موضوع پیدا کنیم. نمونه برچسبگذاری شده در واقع نوعی داده است که همراه با خروجی صحیح یا همان «متغیر هدف» (Target Variable) ارائه میشود. چنین دادههایی برای آموزش الگوریتمهای یادگیری نظارت شده ضرورت دارند؛ تا حدی که فرایند یادگیری الگوریتمها از طریق تحلیل ارتباط میان ویژگیهای ورودی و خروجیهای مرتبط صورت میگیرد. برچسبها در حقیقت همان پاسخهای صحیحی هستند که الگوریتم سعی دارد در مواجهه با دادههای جدید پیشبینی کند. به عنوان مثال، عمل دستهبندی تصاویر حیوانات به دستههای مختلف مانند سگ یا گربه را در نظر بگیرید. در چنین مسئلهای، دادههای برچسبگذاری شده شامل تصاویر سگها و گربهها همراه با برچسب متناظر با کلاس تصویر میشوند. طی فرایند آموزش، الگوریتم از این برچسبهای نمونه برای یادگیری الگوها و ویژگیهای متمایزکننده سگها و گربهها استفاده میکند.

پس از مرحله آموزش، مدل یادگیری ماشین میتواند کلاس درست مربوط به دادههای جدید و بدون برچسب را پیشبینی کند. باید توجه داشت که فرایند برچسبگذاری نیازمند تجربه و مهارت انسانی است. بهرهگیری مناسب از روشهای ایجاد مجموعهداده به اندازه ساخت مدلهای یادگیری نظارت شده کارآمد در «یادگیری تقویتی» (Reinforcement Learning) اهمیت دارد. زیرا دادههای آموزشی تنها باید اطلاعات ضروری مورد نیاز الگوریتم را برای آموختن و همچنین کاهش پیچیدگی محاسباتی فراهم کنند. دادههای برچسبگذاری شده یکی از اساسیترین معیارهای متمایزگر میان یادگیری نظارت نشده و نظارت شده هستند.

انواع Unsupervised Learning چیست؟

همانطور که پیشتر نیز به آن اشاره شد، یادگیری نظارت نشده، تکنیکی برای گروهبندی دادههای بدون برچسب یا پاسخ است. یادگیری نظارت نشده را میتوان به دو دسته عمده تقسیم کرد:

- «خوشهبندی» (Clustering)

- «کاهش ابعاد» (Dimensionality Reduction)

هدف این روشها، شناسایی الگو و ساختارهای داده، بهمنظور درک و تفسیر بهتر اطلاعات نهفته است.

روش خوشهبندی در Unsupervised Learning چیست؟

تکنیکی که نقاط داده شبیه به هم را بر اساس ویژگیهای مشترک گروهبندی میکند. روش «خوشهبندی» (Clustering) به ماهیتِ نزدیکی نمونههای مختلف به یکدیگر پی برده و از همین جهت در موضوعات متنوعی از جمله «بخشبندی مشتریان» (Customer Segmentation)، «بخشبندی تصویر» (Image Segmentation)، «تصویربرداری پزشکی» (Medical Imaging)، «موتورهای توصیهگر» (Recommendation Engines) و «تشخیص ناهنجاری» (Anomaly Detection) کاربرد دارد. چند مثال رایج خوشهبندی به شرح زیر است:

- گروهبندی ستارهها بر اساس میزان روشنایی.

- دستهبندی مستندات بر اساس عنوان.

- طبقهبندی حیوانات و موجودات زنده.

در ادامه به بررسی دقیقتر برخی از رایجترین تکنیکهای خوشهبندی میپردازیم.

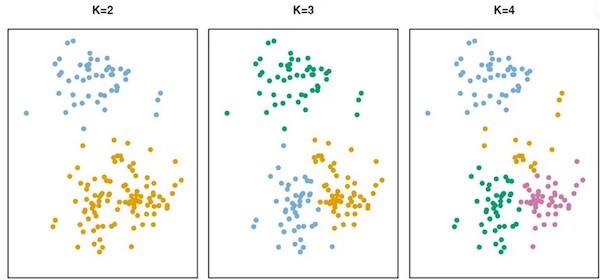

روش خوشهبندی K میانگین

الگوریتم «K میانگین» (K-means) یکی از الگوریتمهای خوشهبندی است که دادهها را به تعدادی خوشه از پیش مشخص شده بخشبندی میکند. در این روش، ابتدا تعداد K «مرکز» (Centroid) خوشه بهطور تصادفی انتخاب شده و سپس با کمینهسازی مجموع مربعِ فواصل میان هر داده و نزدیکترین مرکز، مختصات آن بهطور تصادفی عوض میشود.

این فرایند تا زمانی ادامه پیدا میکند که موقعیت هر مرکز ثابت شده یا تعداد تکرارها به حد نصاب خود رسیده باشد. الگوریتم K میانگین از نظر محاسباتی کارآمد است و با مجموعهدادههای بزرگ به خوبی کار میکند. موقعیت اولیه مراکز خوشه از اهمیت بالایی در الگوریتمهای خوشهبندی برخوردار است. اگر انتخاب موقعیت اولیه مناسب نباشد، نتیجه به سمت «کمینه محلی» (Local Minimum) همگرا شده و نتیجه قابل قبولی حاصل نمیشود. الگوریتمی بهینه است که در آن کمینهسازی درون هر خوشه صورت بگیرد. در فهرست زیر، چند مورد از روشهای مختلف اندازهگیری فاصله میان نمونههای هر خوشه را ملاحظه میکنید:

- «فاصله اقلیدسی» (Euclidean Distance): ابتدا مربع فواصل میان هر دو نمونه بهدست آمده و ریشه دوم آن محاسبه میشود.

$$ Euclidean \: Distance = \sqrt{\sum_{k=1}^m(X_{ik} - X_{jk})^2} $$

- «فاصله منهتن» (Manhattan Distance): قدر مطلق فاصله میان جفت نمونهها محاسبه میشود.

$$ Manhattan \: Distance = max_k\mid X_{ik} - X_{jk}\:\mid $$

- «فاصله چبیشف» (Chebychev Distance): ابتدا تفاضل میان نمونهها را حساب کرده و سپس اندازه مطلق را بهدست میآورد.

$$ Chebychev \: Distance = max(\mid X_A - X_B\mid, \mid Y_A - Y_B\mid) $$

- «فاصله مینکوسکی» (Minkowski Distance): معیاری که برای اندازهگیری فاصله از آن استفاده میشود.

$$ Minkowski \: Distance = (\sum_{k=1}^d\mid X_{ik} - X_{jk}\mid^{1/p})^p $$

روش خوشهبندی سلسله مراتبی

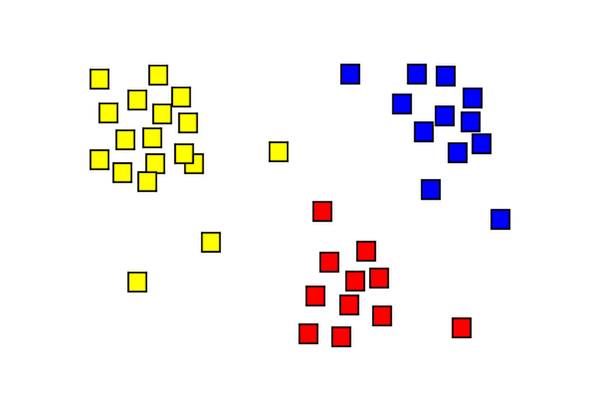

در روش «خوشهبندی سلسله مراتبی» (Hierarchical Clustering) از ساختاری درختمانند برای نمایش ارتباط میان نقاطه داده استفاده میشود. روشی که به دو شیوه «ترکیبی» (Agglomerative) یا پایین-بالا و «تقسیمی» (Divisive) یا بالا-پایین قابل انجام است:

- خوشهبندی ترکیبی: ابتدا هر نمونه یک خوشه است و الگوریتم بهطور مکرر، نزدیکترین جفت خوشهها را با یکدیگر ادغام میکند تا زمانی که تنها یک خوشه باقی بماند.

- خوشهبندی تقسیمی: در ابتدا تمامی نمونهها در یک خوشه قرار گرفته و سپس هر خوشه به شیوهای بازگشتی، تا زمانی که هر نمونه داده خوشه مجزای خود را تشکیل دهد، تقسیم میشوند.

نتیجه نهایی خوشهبندی سلسله مراتبی، «دندروگرامهای» (Dendrograms) قابل تفسیرتری نسبت به سایر روشها دارد. اما هزینه محاسباتی این روش از خوشهبندی K میانگین بیشتر بوده و ممکن است برای مجموعهدادههای بزرگ مناسب نباشد.

روش کاهش ابعاد در Unsupervised Learning چیست؟

هر مجموعهداده میتواند ویژگیها و ابعاد زیادی داشته باشد که پردازش آن را از نظر محاسباتی پیچیده و هزینهبر میکند. از تکنیک «کاهش ابعاد» (Dimensionality Reduction) برای کاهش تعداد ویژگیها یا ابعاد یک مجموعهداده، همزمان با حفظ ساختار و روابط اصلی در یادگیری نظارت نشده استفاده میشود. معضل «طلسم ابعاد» (Curse of Dimensionality) به مشکلی گفته میشود که در آن با افزایش ابعاد مجموعهداده، عملکرد الگوریتم یادگیری ماشین تضعیف میشود. تکنیک کاهش ابعاد به حل این معضل کمک کرده و از جمله مزایای آن میتوان به موارد زیر اشاره کرد:

- بهبود بهرهوری محاسباتی.

- کاهش نویز.

- بهبود نحوه نمایش داده.

کاهش ابعاد انواع مختلفی دارد؛ اما برخی نسبت به سایر روشها کاربرد بیشتری دارند که در ادامه این مطلب از مجله فردارس، به معرفی چند مورد از آنها میپردازیم.

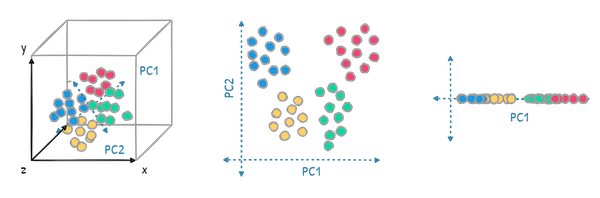

روش تحلیل مولفه اصلی

روش «تحلیل مولفه اصلی» (Principal Component Analysis | PCA) تکنیکی رایج برای کاهش ابعاد خطی است. در این روش، ابعاد بالای مجموعهداده توسط مولفههای اصلی به زیرفضایی با ابعاد پایینتر نگاشت میشوند. تحلیل مولفه اصلی یا به اختصار PCA، افزونگی دادهها را کاهش داده و از طریق نوعی تبدیل خطی، نمایشی جدید از دادهها با عنوان مولفههای اصلی ایجاد میکند؛ بردارهایی «متعامد» (Orthogonal) که جهت حداکثر واریانس دادهها را بهدست میآورند. الگوریتم PCA این توانایی را دارد تا با تعداد کمی از مولفههای اصلی، همراه با کاهش ابعاد، واریانس اصلی را نیز محفوظ نگه دارد.

محدودیت روش PCA

در PCA فرض بر این است که نقاط داده در زیرفضایی خطی واقع شدهاند. به همین خاطر و از آنجایی که بهطور تخصصی با دادههای خطی کار میکند، محدوده کاربردی چندان وسیعی ندارد.

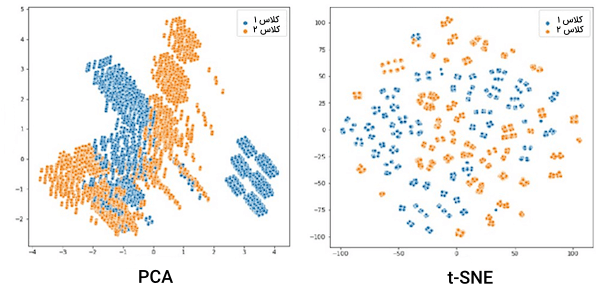

روش t-توکاری همسایگی تصادفی توزیع شده

تکنیکی محبوب برای کاهش ابعاد غیر خطی که الگوهای پیچیده و روابط غیر خطی میان دادهها را شناسایی میکند. در روش «t-توکاری همسایگی تصادفی توزیع شده» (t-Distributed Stochastic Neighbor Embedding | t-SNE)، «دیورژانس» (Divergence) میان دو توزیع احتمال کمینه میشود:

- توزیع اول بیانگر شباهتهای «زوجی» (Pairwise) در ابعاد فضایی بالا است.

- توزیع دوم نمایشی از شباهتهای زوجی در ابعاد فضایی پایین است.

هدف توزیع دوم در حفظ ساختار محلی دادهها و کاربرد روش t-SNE برای مصورسازی مجموعهدادههایی با ابعاد بالا خلاصه میشود.

محدودیت الگوریتم های t-SNE

ممکن است روش t-SNE از نظر محاسباتی برای مجموعهدادههای بزرگ گران تمام شود. از طرفی نتایج آن وابسته به انتخاب «ابَرپارامترهای» (Hyperparameters) مناسب است.

دو الگوریتم PCA و t-SNE نقاط قوت و ضعف مختص خود را دارند و انتخاب تکنیک کاهش ابعاد به نوع مسئله و مجموعهداده بستگی دارد. یک راه موثر برای کاهش ابعاد، استفاده ترکیبی از روشها است. به عنوان مثال، تکنیکهای کاهش ویژگی میتوانند در مرحل پیشپردازش دادهها قرار گرفته و فرایندهای دیگر مانند خوشهبندی و تشخیص ناهنجاری توسط یادگیری نظارت نشده انجام شوند.

کاربرد های Unsupervised Learning چیست؟

به لطف قابلیتهایی همچون شناسایی الگوهای پنهان و روابط میان دادهها، یادگیری نظارت نشده کاربردهای متنوعی در صنایع و حوزههای مختلف دارد. عدم نیاز به دادههای برچسبگذاری شده از دیگر نکاتی است که یادگیری نظارت نشده را به انتخابی مناسب برای بسیاری از صنایع تبدیل کرده است. بهطور ویژه، یادگیری نظارت نشده در سه حوزه تشخیص ناهنجاری، «سیستمها توصیهگر» (Recommender Systems) و «پردازش زبان طبیعی» (Natural Language Processing) کاربرد دارد.

تشخیص ناهنجاری در Unsupervised Learning چیست؟

در تشخیص ناهنجاری، هدف شناسایی نمونهها و الگوهایی است که از «نُرم» (Norm) فاصله داشته و نشانگر خطاهایی همچون تقلب یا دیگر رخدادهای غیر معمول هستند. ویژگی یادگیری نظارت نشده در تجزیه و تحلیل دادههای بدون برچسب، در تشخیص ناهنجاری به کار آمده و باعث صرفهجویی در هزینهها میشود. روش خوشهبندی از جمله راهکارهای رایج برای تشخیص ناهنجاری است، که در آن دادهها بر اساس شباهتشان در گروههای مشابه قرار میگیرند.

پس از خوشهبندی، نمونههایی که در هیچ خوشهای قرار نداشته یا فاصله قابل توجهی با مرکز خوشه دارند، به عنوان ناهنجاری علامتگذاری میشوند. همچنین کاهش ابعاد، یکی دیگر از روشهای مورد استفاده در تشخیص ناهنجاری است که تمرکز آن بر نمایش دادهها در فضایی با ابعاد کمتر است. الگوریتم PCA میتواند نگاشتی از نمونهها در زیرفضایی با ابعاد کمتر ارائه داده و «خطای بازسازی» (Reconstruction Error) میان نمونههای جدید و دادههای اصلی را به عنوان نمادی از ناهنجاری مورد استفاده قرار دهد. به این خاطر که نمیتوان نقاط داده با خطای بازسازی بالا را در فضایی با ابعاد پایین به نمایش گذاشت، احتمال آنکه به عنوان ناهنجاری شناخته شوند زیاد است.

از «بینایی ماشین» (Computer Vision) به عنوان یکی از کاربردهای اساسی تشخیص ناهنجاری و همچنین استخراج ویژگی و الگو از تصاویر یاد می شود. بهطور معمول، شناسایی ناهنجاریها نیازمند تنظیم دقیق پارامترهای الگوریتم و انتخاب «آستانهای» (Threshold) مناسب است.

سیستم های توصیهگر در Unsupervised Learning چیست؟

الگوریتمهایی که بر اساس اولویتها، رفتار و یا دیگر اطلاعات مفهومی، اقلام و محتوای مرتبط را به کاربران پیشنهاد میدهند. یادگیری نظارت نشده نقش مهمی در توسعه «سیستمهای توصیهگر» (Recommender Systems) داشته و به شناسایی الگوهای میان دادهای برای ارائه پیشنهادات شخصیسازی شده کمک میکند. در لیست زیر به شرح چند مورد از روشهای کاربردی در سیستمهای توصیهگر پرداختهایم:

- خوشهبندی: این روش، کاربردی رایج از یادگیری نظارت نشده در سیستمهای توصیهگر است. از خوشهبندی برای گروهبندی کاربران یا اقلام بر اساس میزان شباهت آنها به یکدیگر استفاده میشود. به عنوان مثال، پس از اجرای الگوریتم K میانگین بر روی مجموعهای از دادهها، یک سیستم توصیهگر میتواند پیشنهاداتی بر اساس خریدها و تاریخچه مرورگر مشتری به او ارائه دهد.

- کاهش ابعاد: دو روش PCA و t-SNE را میتوان به عنوان راهکارهایی برای سادهسازی دادهها در سیستمهای توصیهگر معرفی کرد. تکنیکهایی که موجب بهبود بیشتر کارآمدی این سیستمها میشوند. نحوه کار الگوریتمهای PCA و t-SNE به این شکل است که بهمنظور شناسایی معیارهای پنهانِ موثر در ردیابی اولویتها و رفتارها، تعاملات میان کاربر و محصول را به فضایی با ابعاد پایینتر نگاشت میکنند. در نهایت نیز، معیارهای شباهت محاسبه شده و پیشنهادات مختص به هر کاربر تولید میشوند.

- «پالایش گروهی» (Collaborative Filtering): فرض بر این گذاشته میشود که کاربرانی با سلیقه مشابه در انتخاب و برقراری ارتباط با محصول، در آینده نیز اولویتهای نزدیکی خواهند داشت. روش پالایش گروهی به دو نوع «کاربر-محور» (User-based) و «محصول-محور» (Item-based) تقسیم میشود. وقتی پیشنهادات بر اساس معیارهای مشابه کاربران تولید شوند به آن کاربر-محور گویند و در غیر اینصورت اگر پیشنهادات مبتنیبر شباهت میان محصولات باشند، نتیجه نهایی را محصول-محور مینامند. در هر دو حالت، امتیاز شباهت از طریق معیارهای فاصله مختلفی از جمله «شباهت کسینوسی» (Cosine Similarity) یا «ضریب همبستگی پیرسون» (Pearson Correlation Coefficient) قابل محاسبه است.

با وجود پایداری و کارآمدی بالا، تکنیکهای یادگیری نظارت نشده اغلب در ترکیب با دیگر روشها همچون «پالایش مبتنیبر محتوا» (Content-based Filtering) و «یادگیری عمیق» (Deep Learning) برای ساخت سیستمهای توصیهگر مورد استفاده قرار میگیرند. به این صورت، سیستم تصویهگر از نقاط قوت چند روش بهره برده و به پیشنهادات دقیق و گستردهتری ختم میشود.

پردازش زبان طبیعی

زیرشاخهای از هوش مصنوعی که بر تعاملات میان کامپیوتر و زبان انسان متمرکز است. حوزه «پردازش زبان طبیعی» (Natural Language Processing | NLP) شامل توسعه الگوریتمها و مدلهای یادگیری ماشین برای درک، تفسیر و تولید زبان انسان به شیوهای قابل فهم و کارآمد میشود. به کمک آخرین فناوریهای هوش مصنوعی، امروزه روشهای مربوط به حوزه NLP علاوهبر درک واژگان و عبارات زبان انسان، میتوانند الگوهای زبان شناختی را نیز یاد بگیرند. یادگیری نظارت نشده با توانایی کشف الگوهای پنهان و ساختار دادههای متنی، بدون نیاز به نمونههای برچسبگذاری شده، بسیار در توسعه سیستمهای NLP موثر واقع میشود.

کاربرد های پردازش زبان طبیعی

پردازش زبان طبیعی حوزهای وسیع است که شامل سیستمهای «تشخیص گفتار» (Speech Recognition) و متن میشود. در نتیجه کاربردهای آن نیز به مراتب متنوع و گسترده است:

- «تجزیه و تحلیل متن» (Text Analysis): برای پیدا کردن عناوین پنهان متن، استفاده از تکنیکی به نام «تخصیص پنهان دیریکله» (Latent Dirichlet Allocation | LDA) در یادگیری نظارت نشده رواج دارد. در این روش، ابتدا عناوین و موضوعات مختلف خوشهبندی شده و سپس تعداد تکرار واژگان بررسی میشود.

- «تعبیهسازی واژگان» (Word Embedding): بردارهایی پیوسته که مفاهیم معنایی را در خود ذخیره میکنند. از جمله روشهای پر استفاده برای تجزیه و تحلیل متون بزرگ میتوان به Word2Vec و GloVe اشاره کرد. با استفاده از چنین روشهایی میتوان محتوای متن را پیشبینی کرد و از نتیجه آن به عنوان ورودی سیستمهای NLP در کاربردهایی مانند «تحلیل معنایی» (Sentiment Analysis) و «ترجمه ماشینی» (Machine Translation) بهره گرفت.

یادگیری نظارت نشده در NLP اغلب نیازمند مراحل پیشپردازشی همچون «جداسازی» (Tokenization)، «ریشهیابی» (Stemming) و حذف «واژگان توقف» (Stop-Words) در جهت تبدیل متون خام به فرمتی مناسب برای تجزیه و تحلیل است. همچنین انتخاب روشهای یادگیری نظارت نشده به مسئله و مجموعهداده بستگی داشته و نتیجه بهینه تنها با شناخت کافی از هدف اصلی حاصل میشود.

چالش های Unsupervised Learning چیست؟

یادگیری نظارت شده نیز مانند سایر روشها با چالشهایی روبهرو است که برای اطمینان حاصل کردن از کارآمدی و پایداری الگوریتمها و مدلهای توسعه داده شده باید به حل آنها بپردازیم. چالشهایی از قبیل «انتخاب ویژگی» (Feature Selection)، «ارزیابی مدل» (Model Evaluation) و انتخاب تکنیکها و پارامترهای مناسب که در ادامه بیشتر با هر کدام آشنا میشویم.

انتخاب ویژگی

در مقایسه با یادگیری نظارت شده و از آنجایی که یادگیری بدون نظارت از دادههای بدون برچسب استفاده میکند، ممکن است «انتخاب ویژگی» (Feature Selection) تبدیل به چالشی بزرگ شود. در انتخاب ویژگی، مفیدترین ویژگیها یا متغیرهای موجود در مجموعهداده به عنوان ورودی الگوریتمهای یادگیری نظارت نشده انتخاب میشوند. کیفیت ویژگیها تاثیر بهسزایی در عملکرد الگوریتم دارند؛ همانطور که ویژگیهای اضافی باعث ایجاد نویز شده و شناسایی الگوهای معنایی دادهها را برای مدل یادگیری ماشین دشوار میسازند. بهطور کلی، انتخاب ویژگی در یادگیری نظارت نشده از سه طریق زیر انجام میشود:

- «روشهای جداسازی» (Filter Methods): در چنین روشهایی، ویژگیها بر اساس معیاری مشخص مانند واریانس یا «اطلاعات متقابل» (Mutual Information) ردهبندی شده و زیرمجموعهای با بالاترین امتیاز انتخاب میشود. روشهای جداسازی از نظر محاسباتی بهینه بوده و مستقل از الگوریتمهای یادگیری عمل میکنند. با این حال، روابط میان ویژگیها یا پیشنیازهای فرایند یادگیری، در نظر گرفته نمیشود.

- «روشهای پوششی» (Wrapper Methods): روشهای پوششی ابتدا عملکرد الگوریتم یادگیری نظارت نشده را نسبت به زیرمجموعههای مختلفی از ویژگیها ارزیابی کرده و در نهایت، زیرمجموعهای با بهترین نتایج را انتخاب میکنند. دقت این روشها از انوع دیگر مانند جداسازی بیشتر است؛ اما باید توجه داشت که از نظر محاسباتی برای مجموعهدادههای بزرگ و فضاهای ویژگی با ابعاد بالا گرانتر تمام میشوند.

- «روشهای تعبیه شده» (Embedded Methods): در روشهای تعبیه شده، انتخاب ویژگی به عنوان بخشی از الگوریتم یادگیری با آن ادغام میشود. به عنوان مثال، برخی از تکنیکهای یادگیری نظارت نشده مانند PCA یا «لاسو» (Lasso)، از طریق کاهش ابعاد یا اعمال محدودیت بر پارامترهای مدل، عمل انتخاب ویژگی را اجرا و توازن خوبی میان بهرهوری محاسباتی و دقت برقرار میکنند. با این حال، امکان دارد استفاده از آنها به الگوریتمهای یادگیری خاص یا فرضیاتی درباره دادهها محدود باشد.

گزینش روش انتخاب ویژگی مناسب

گزینش تکنیک انتخاب ویژگی مناسب و همچنین تعداد ویژگیهای بهینه، اغلب نیازمند تجربه و بررسی دقیق محدودیتهای مسئله است.

ارزیابی مدل در Unsupervised Learning چیست؟

از آنجایی که برچسبی برای مقایسه خروجی الگوریتم وجود ندارد، ممکن است ارزیابی مدلهای یادگیری نظارت نشده به چالش تبدیل شود. به این شکل، دیگر نمیتوان مطمئن شد که آیا ساختارهای نهفته داده با موفقیت شناسایی شده و یا تنها برازشی بر نویزها صورت گرفته است. پژوهشگران اغلب برای حل این مشکل، از معیارهای ارزیابی مختص به دامنه و یادگیری نظارت نشده به عنوان مرحله پیشپردازش در یادگیری نظارت شده استفاده میکنند. به عنوان دو نمونه مهم از روشهای ارزیابی مدل، معیارهای زیر را در نظر بگیرید:

- «معیارهای ارزیابی داخلی» (Internal Evaluation Metrics): چنین معیارهایی در سنجش کیفیت مدلهای یادگیری نظارت نشده کاربرد دارند. معیارهای ارزیابی داخلی بر اساس ویژگیهای مدل مانند «فشردگی» (Compactness) و «تفکیکپذیری خوشهها» (Separation of Clusters) در الگوریتمهای خوشهبندی یا خطای بازسازی در تکنیکهای کاهش ابعاد عمل میکنند. معیار «نیمرخ» (Silhouette) و «شاخص ارزیابی دیویس-بولدین» (Davies-Bouldin Index)، نمونههایی معمول از معیارهای ارزیابی داخلی هستند. این معیارها، ارزیابی ویژگیهایی مانند شباهت، نرخ پراکندگی و تحلیل خوشهها را بر عهده دارند. با این حال، تضمینی در همراستا بدون معیارهای داخلی با ساختار دادهها وجود ندارد.

- «معیارهای ارزیابی خارجی» (External Evaluation Metrics): معیارهایی که خروجی مدلهای یادگیری نظارت نشده را در مقایسه با مجموعهای از برچسبهای حقیقی یا نمونههای شناخته شده قرار میدهند. کاربرد اصلی معیارهای ارزیابی خارجی در سنجش مجموعهدادههای برچسبدار است. «شاخص رَند اصلاح شده» (Adjusted Rand Index) و «اطلاعات متقابل نرمالسازی شده» (Normalized Mutual Information) دو مورد از معیارهای ارزیابی خارجی هستند. اما بهخاطر وابستگی به دادههای برچسبگذاری شده، معیارهای ارزیابی خارجی تنها در کاربردهای محدودی از یادگیری نظارت نشده استفاده میشوند.

انتخاب معیار ارزیابی مناسب وابسته به نوع مسئله و مجموعهداده بهکار گرفته شده است. شاید در مواردی نیاز باشد از ترکیب معیارهای داخلی و خارجی و تکنیکهای ارزیابی دیگری همچون «بازرسی بصری» (Visual Inspection) یا «قضاوت کارشناسانه» (Expert Judgment) برای ارزیابی کارایی مدلهای یادگیری نظارت نشده استفاده کرد.

روش های پیشرفته در یادگیری نظارت نشده

یادگیری نظارت نشده حوزهای در حال تکامل است. در نتیجه محققان در جهت توسعه روشهای پیشرفتهتری برای حل مسائل پیچیده و بهبود عملکرد راهکارهای فعلی دست به کار شدهاند. روشهای پیشرفتهای که از یادگیری عمیق و «یادگیری انتقالی» (Transfer Learning) برای بهبود قابلیتهای یادگیری نظارت نشده کمک میگیرند.

کاربرد یادگیری عمیق در Unsupervised Learning چیست؟

هدف یادگیری عمیق، استفاده از شبکههای عصبی چند لایه برای مدلسازی الگوهای پیچیده موجود در داده است. یادگیری عمیق تا به امروز در زمینههای مختلفی از یادگیری نظارت شده مانند «دستهبندی تصاویر» (Image Classification) و تشخیص گفتار موفق عمل کرده است. علاوهبر آن، در یادگیری نظارت نشده نیز کاربرد داشته و از آن برای کشف ساختارهای پیچیدهتری درون مجموعهداده استفاده میشود. در ادامه، چند مورد مهم از این کاربردها را بررسی میکنیم.

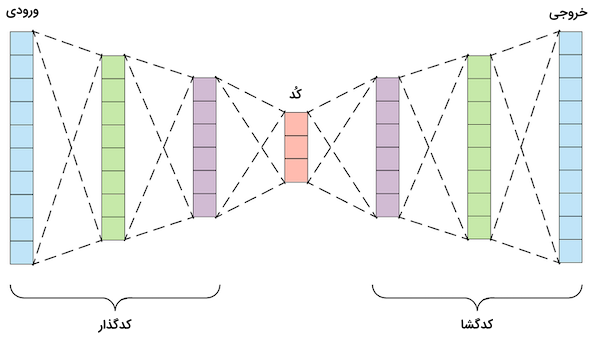

خودرمزگذارها

معماریهای عمیقی که برای وظایفی همچون کاهش ابعاد و «یادگیری ویژگی» (Feature Learning) طراحی شدهاند را «خودرمزگذار» (Autoencoder) گویند. یک خودرمزگذار از دو بخش «رمزگذار» (Encoder) و «رمزگشا» (Decoder) تشکیل شده است. قسمت رمزگذار دادههای ورودی را بر ابعادی پایینتر نگاشت کرده و رمزگشا نیز وظیفه بازسازی نتیجه بخش رمزگذار به شکل اصلی دادهها را بر عهده دارد. با آموزش دادن خودرمزگذار بهمنظور کمینه کردن خطای بازسازی، این معماری نحوه شناسایی مهمترین ویژگیها و الگوهای داده را یاد میگیرد.

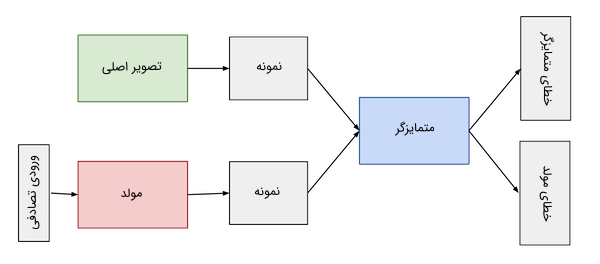

شبکه های مولد تخاصمی

از «شبکههای مولد تخاصمی» (Generative Adversarial Networks | GANs) برای تولید داده و «یادگیری ارائه» (Representation Learning) استفاده میشود. هر معماری GAN از دو قسمت «مولد» (Generator) و «متمایزگر» (Discriminator) تشکیل شده است. مدل مولد نمونههایی واقعگرایانه تولید کرده و مدل متمایزگر نیز سعی میکند نمونههای حقیقی را از نمونههای تولید شده توسط مدل مولد شناسایی و جدا کند.

یادگیری عمیق با آشکار ساختن الگوهای پیچیده مجموعهداده، به عملکردی بهتر و در نهایت مدلهای یادگیری ماشین موثرتری در یادگیری نظارت نشده ختم میشود.

محدودیت های یادگیری عمیق

تکنیکهای مبتنیبر یادگیری عمیق در یادگیری نظارت نشده، اغلب به حجم زیادی از داده و منابع محاسباتی نیاز دارند که نسبت به سایر روشها در پیادهسازی با چالش بیشتری روبهرو هستند.

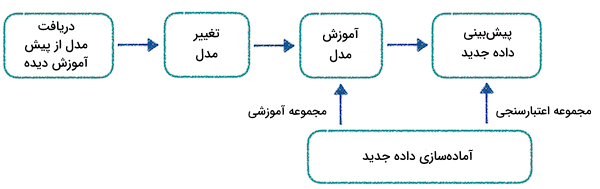

کاربرد یادگیری انتقالی در Unsupervised Learning چیست؟

رویکرد «یادگیری انتقالی» (Transfer Learning) با بهرهگیری از دانش بهدست آمده از یک مسئله، عملکرد مدل یادگیری ماشین دیگری را در کاربردی متفاوت ارتقاء میدهد. بهطور ویژه، این روش زمانی مفید واقع میشود که دادههای برچسبگذاری شده محدودی برای مسئله هدف در دسترس باشد و مدل بتواند از دانش خود در مسئلهای دیگر استفاده کند. پردازش زبان طبیعی نمونهای از یادگیری انتقالی است که فرایند یادگیری آن از طریق یک «مدل زبانی» (Language Model) آماده انجام شده و از الگوهای زبانی موجود در مجموعهدادهها بهره میبرد.

بنابراین، با «میزانسازی دقیق» (Fine-Tuning) الگوریتمهای از پیش آموزش دیده، مدلهای جدیدی حاصل میشوند که علاوهبر کارآمدی بالا، مصرف محاسباتی کمتری نیز دارند. دانش انتقالی باعث بهبود عملکرد مسائلی با تعداد دادههای برچسبدار محدود میشود. بهطور معمول، کاربرد چنین مدلهایی در مسائل NLP مانند تحلیل معنایی، ترجمه ماشینی، سیستمهای پرسش و پاسخ و «دستهبندهای متنی» (Text Classifiers) است.

محدودیت های یادگیری انتقالی

در حالی که یادگیری انتقالی نوعی مدل یادگیری کارآمد است، اما محدودیتهایی نیز دارد:

- وابستگی موضوعی: یادگیری انتقالی تنها زمانی بهترین عملکرد خود را به نمایش میگذارد که ارتباطی میان مسئله اولیه و هدف وجود نداشته باشد. در غیر اینصورت، دانش انتقالی و کاربردهای جدید تحت تاثیر قرار میگیرند.

- «مجموعهدادههای جهتدار» (Biased Datasets): هنگامی که مدلهای یادگیری ماشین بر روی مجموعهدادههای بزرگ آموزش میبینند، دچار سوگیری شده و به عملکردی کمتر از حد مطلوب ختم میشوند.

- میزانسازی دقیق: مدلهای یادگیری انتقالی نسبت به تعداد محدود دادههای هدف «بیشبرازش» (Overfit) شده و در نتیجه دیگر قادر به شناسایی نمونههای جدید نخواهند بود.

سوالات متداول پیرامون Unsupervised Learning چیست؟

اگر مطلب را تا اینجا مطالعه کرده باشید، به خوبی میدانید که Unsupervised Learning چیست و حالا زمان خوبی است تا در این بخش به چند مورد از پرسشهای متداول در این زمینه پاسخ دهیم.

تفاوت بین یادگیری نظارت شده و Unsupervised Learning چیست؟

در یادگیری نظارت شده، الگوریتمها با دادههایی آموزش میبینند که خروجی مطلوب یا به اصطلاح برچسبها شناخته شده هستند. در مقابل، الگوریتمهای یادگیری نظارت نشده بدون هیچ دانش پیشینی از خروجی، دادهها را تحلیل و دستهبندی میکنند.

یادگیری نظارت نشده از چه تکنیکهای استانداردی تشکیل شده است؟

تکنیکهای استاندارد یادگیری نظارت نشده در دو گروه خوشهبندی مانند روش K میانگین و خوشهبندی سلسله مراتبی و روش کاهش ابعاد مانند PCA و t-SNE قرار دارند.

نحوه بهکارگیری یادگیری نظارت نشده در تشخیص ناهنجاری به چه شکل است؟

از یادگیری نظارت نشده در تشخیص ناهنجاری استفاده شده و نقاط داده یا الگوهای خارج از نُرم شناسایی میشوند. خوشهبندی و کاهش ابعاد روشهای رایجی در تشخیص ناهنجاری هستند. روش خوشهبندی بر اساس فاصله میان نقاط داده و نزدیکترین مراکز خوشه، ناهنجاریهای موجود در داده را شناسایی میکند. از طرفی دیگر، معیار کشف ناهنجاری در کاهش ابعاد، خطای بازسازی نام دارد.

نقش یادگیری نظارت نشده در پردازش زبان طبیعی چیست؟

یادگیری نظارت نشده با آشکار ساختن الگوهای پنهان و ساختار دادههای متنی بدون نیاز به نمونههای برچسبدار، نقش مهمی در پردازش زبان طبیعی بازی میکنند. روشهایی از جمله خوشهبندی، کاهش ابعاد و تعبیهسازی واژگان در موضوعاتی همچون تحلیل متن، «مدلسازی عنوان» (Topic Modeling) و تحلیل معنایی کاربرد دارند.

یادگیری انتقالی چگونه به یادگیری نظارت نشده مرتبط میشود؟

رویکرد یادگیری انتقالی از دانش بهدست آمده در یک مسئله، برای بهبود عملکرد مدل یادگیری ماشین در کاربردی متفاوت بهره میبرد. یادگیری نظارت نشده با استخراج ویژگیهای ارزشمند از نمونه دادههای مرجع و انتقال آن به مسئله هدف، نقش مهمی در یادگیری انتقالی ایفا میکند.

جمعبندی

بهترین مورد استفاده از یادگیری نظارت نشده در کاربردهایی است که به دادههای برچسبگذاری شده وابستگی ندارند. کاربردهایی مانند «شناسایی الگو» (Pattern Recognition) و «پردازش تصویر» (Image Processing) که در تعیین هویت و سیستمهای تصویهگر مورد استفاده قرار میگیرند. اگر چه یادگیری نظارت نشده در انتخاب ویژگی و ارزیابی مدل با چالشهایی مواجه است، همچنان ابزاری موثر برای تشخیص ناهنجاری و پردازش زبان طبیعی محسوب میشود. در این مطلب از مجله فرادرس، خواندیم که چگونه تکنیکهای مهمی مانند خوشهبندی و کاهش ویژگی، ساختار دادهها را برملا ساخته و نگرش تازهای از ناشناختهها به ما ارائه میدهند. همزمان با تکامل یادگیری عمیق و شبکههای عصبی، یادگیری نظارت نشده نیز به رویکردی جدیتر در صنایع مختلف تبدیل شده است.