چارچوبی برای یادگیری تقویتی (Reinforcement Learning) توسط گوگل

تیم «گوگل برین» (Google Brain) از یک چارچوب یادگیری تقویتی دارای «انعطافپذیری» (Flexiblity) و «بازتولیدپذیری» (Reproducibility) با عنوان «دوپامین» (Dopamine) رونمایی کرد. این چارچوب طی خبری که در وبلاگ هوش مصنوعی گوگل منتشر شد به همگان معرفی شده است. لازم به ذکر است که گوگل برین یک پروژه تحقیقاتی در حوزه هوش مصنوعی متعلق به شرکت گوگل است که از سال ۲۰۱۱ فعالیت خود را آغاز کرده و تاکنون پیشرفتهای قابل توجهی داشته. متن خبر منتشر شده در وبلاگ هوش مصنوعی گوگل در ادامه آمده است.

پژوهشهای «یادگیری تقویتی» (Reinforcement learning) پیشرفتهای قابل توجهی را در طول سالهای گذشته به همراه داشته است. این پیشرفتها به «عاملهای هوشمند» (Intelligent Agent) امکان انجام بازی در سطح «ابَرانسانها» (super-human) را میدهند.

از جمله مثالهای قابل توجه برای این پیشرفتها میتوان به DQN ساخته شده توسط «دیپمایند» (DeepMind) که همراه با «آلفاگو» (AlphaGo) و «آلفاگو زیرو» (AlphaGo Zero) بازیهای «آتاری» (Atari) را انجام دادهاند و OpenAI Five که بازیهای کامپیوتری از جمله Dota 2 را انجام داده اشاره کرد. به ویژه، معرفی «حافظههای بازپخش» (Replay Memories) در DQN که امکان بهرهبرداری از تجربه عامل قبلی را فراهم میسازند، آموزش توزیع شده بزرگ مقیاس که توزیع فرآیند یادگیری در میان چندین کارگر را مقدور میکند، و روشهای توزیع شده که به عامل امکان مدل کردن توزیعهای کامل به جای آنکه صرفا مقادیر مورد انتظار آنها را مدل کنند را به منظور یادگیری تصویر کاملتری از جهانشان فراهم میکند اشاره کرد.

چنین پیشرفتهایی حائز اهمیت هستند و با دست یافتن الگوریتمها به چنین پیشرفتهایی، قابل اعمال بر حوزههای کاربرد گوناگون مانند رباتیک میشوند (مطالعه کارهای اخیر در زمینه دستکاری رباتیک و آموزش دادن رباتها برای خود-تطبیقی به صورت بصری توصیه میشود). اغلب اوقات، ساخت و توسعه چنین پیشرفتهایی نیازمند تکرار سریع طراحی (اغلب بدون هیچگونه جهت مشخصی) و درهمگسیختگی ساختار روشهای ایجاد شده است.

اگرچه چارچوبهای یادگیری تقویتی پیشین موجود فاقد ترکیبی از انعطافپذیری و پایداری که پژوهشگران را قادر به تکرار روشهای یادگیری تقویتی به طور موثر میکند بودند و بنابراین امکان داشت اکتشاف جهتهای پژوهشی جدید مزایای مشهود سریعی نداشته باشند. علاوه بر این، بازتولید نتایج از چارچوبهای کنونی اغلب بسیار زمانبر است و در عین حال میتواند منجر به مشکلات بازتولیدپذیری علمی شود.

در ۲۷ آگوست ۲۰۱۸، گوگل یک چارچوب مبتنی بر «تنسورفلو» (TensorFlow) برای یادگیری تقویتی ارائه کرد که هدف آن فراهم کردن انعطافپذیری، پایداری و بازتولیدپذیری هم برای پژوهشگران تازهکار و هم افراد دارای تجربه یادگیری در این حوزه است. این چارچوب از یکی از مولفههای اصلی در رفتار انگیزشی با پاداش در مغز الهام گرفته شده است و ارتباط تاریخی قدرتمندی بین پژوهشهای «علوم اعصاب» (neuroscience) و یادگیری تقویتی برقرار میکند.

هدف این پلتفرم امکانپذیر ساختن نوعی جستوجوی نظری است که میتواند اکتشافات رادیکال را انجام دهد. همچنین، این نسخه از چارچوب دربرگیرنده مجموعهای از colabها است که چگونگی استفاده از این چارچوب را شفاف میکنند.

کاربردپذیری

شفافیت و سادگی دو مورد از ملاحظات مهم چارچوب معرفی شده هستند.

کد این چارچوب به صورت فشرده (در حدود ۱۵ فایل پایتون) و به خوبی مستند شده است. این امر با تمرکز بر «Arcade Learning Environment» (یک بنچمارک بالغ و به خوبی درک شده) و چهار عامل «مبتنی بر مقدار» (value-based) شامل DQN و C51، انواع با دقت ساده شدهای از «عامل رینبو» (Rainbow agent) و عامل «Implicit Quantile Network » که طی «کنفرانس بینالمللی یادگیری ماشین» (International Conference on Machine Learning) در جولای ۲۰۱۸ معرفی شد به دست آمده است. گوگل امیدوار است سادگی این چارچوب درک کارکردهای داخلی عامل و آزمودن سریع ایدههای جدید را برای پژوهشگران تسهیل کند.

بازتولیدپذیری

گوگل در این پروژه حساسیت قابل توجهی بر بازتولیدپذیری در پژوهش یادگیری تقویتی داشته است. به همین منظور کدهای آن با پوشش تمام تست فراهم شدهاند و این تستها خود به صورت مستندات افزودهای وجود دارند. علاوه بر این، چارچوب تجربی گوگل از توصیههای ارائه شده توسط «موکادو» (Machado) و همکاران در سال ۲۰۱۸ پیرامون استانداردسازی ارزیابی تجربی با Arcade Learning Environment پیروی میکند.

معیار سنجش (بنچمارک)

برای پژوهشگران جدید داشتن توانایی بنچمارک سریع ایدههایشان برای روشهای ایجاد شده مساله مهمی است. از این رو، گوگل کل دادههای آموزش چهار عامل خود را در طول ۶۰ بازی پشتیبانی شده توسط Arcade Learning Environment (برای عاملهای آموزش دیده با چارچوب خود ) و به صورت فایل داده JSON (برای مقایسه با عاملهای آموزش دیده در دیگر چارچوبها) را ارائه کرده است.

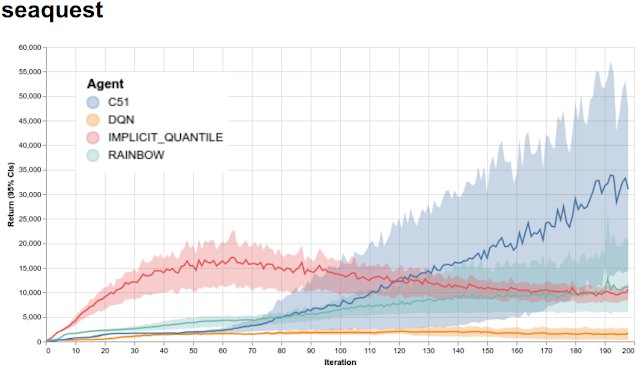

همچنین، یک وبسایت آماده کردهاند که با استفاده از آن میتوان به سرعت اجراهای آموزش را برای همه عاملهای آموزش دیده در همه ۶۰ بازی بصری کرد. در شکل زیر اجراهای آموزش برای ۴ عامل در Seaquest که یکی از بازیهای آتاری ۲۶۰۰ است و توسط Arcade Learning Environment پشتیبانی میشود ارائه شدهاند.

همچنین، شبکههای عصبی عمیق، لوگهای آماری خام و فایلهای رویداد تنسورفلو برای ترسیم نمودار با Tensorboard فراهم شدهاند. همه این موارد در قسمت دانلود سایت گوگل موجود است. گوگل امیدوار است انعطافپذیری و کاربردپذیری چارچوب ارائه شده پژوهشگران را برای آزمودن ایدههای جدید، چه به صورت افزایشی و چه به صورت رادیکال قدرت ببخشد. تیم Brain گوگل همچنین اعلام کرده که فعالانه از این چارچوب برای پژوهشهای خود استفاده میکند و دریافته که انعطافپذیری که این چارچوب در اختیار آنها قرار میدهد امکان تکرار سریع ایدههای بسیاری را فراهم میکند. این تیم همچنین در مطلبی که در وبلاگ گوگل منتشر کرده میگوید مشتاق دیدن کارهایی است که جامعه بزرگتر با استفاده از این چارچوب انجام خواهند داد. علاقمندان میتوانند مخزن گیتهاب این پروژه را چک کرده، با آن کار کنند و نظرات خود را به اطلاع تیم برسانند.

تیم پروژه

این پروژه با همکاری افراد گوناگونی در گوگل انجام شده است. تیم اصلی این پروژه متشکل از «مارک جی بلمر» (Marc G. Bellemare)، «پابلو ساموئل کسترو» (Pablo Samuel Castro)، «کرلس گلادا» (Carles Gelada)، «سابهودیپ مویترا» (Subhodeep Moitra) و «سوراب کومار» (Saurabh Kumar) است. همچنین تیم پروژه از افرادی که به آنها در تست این چارچوب یاری کردهاند قدردانی کرده است.

اگر نوشته بالا برای شما مفید بود، آموزشهای زیر نیز به شما پیشنهاد میشوند:

- آموزش یادگیری تقویتی با متلب

- مجموعه آموزشهای مهندسی کنترل

- مجموعه آموزشهای آمار، احتمالات و دادهکاوی

- مجموعه آموزشهای مهندسی برق

- مجموعه آموزشهای هوش محاسباتی

^^