رویکرد هوش ازدحامی با استفاده از کلونی زنبور عسل مصنوعی برای حل مسائل بهینهسازی

«هوش ازدحامی» (Swarm Intelligence - SI)، یک زمینه از «هوش محاسباتی» (Computational Intelligence - CI) است که برای ساخت و توسعه سیستمهای هوشمند چندعامله الهام گرفته از زیست، استفاده میشود. این رویکرد از رفتار تجمعی عاملهای طبیعی مانند دسته پرندگان و ماهیها برای ساخت الگوریتمها الگوبرداری کرده است.

اثبات شده که چنین الگوریتمهایی در حل مسائل جهان واقعی عملکرد بسیار موثری دارند. از جمله مسائلی که با استفاده از الگوریتمهای هوش ازدحامی قابل حل هستند میتوان به خوشهبندی، نگاشت سیارهای، کنترل نانو رباتها و گسترهای از مسائل دادهکاوی مانند انتخاب ویژگی و دستهبندی اشاره کرد.

به بیان ریاضی، برای حل مسائل بهینهسازی جهان واقعی با استفاده از الگوریتمهای محاسباتی هوشمند، نیاز به یک ارائه ریاضیوار از مساله وجود دارد که به آن «تابع هدف» (Objective Function) گفته میشود. تابع هدف در واقع قواعد ریاضی است که مساله و همه متغیرهای تصمیم آن را تشریح میکند.

بهطور خلاصه، یک مساله بهینهسازی در فضای جست و جو تعریف میشود. این فضا در واقع ناحیهای است که در آن بهدنبال راهکار گشته میشود و شامل یک مجموعه از متغیرهای تصمیم است که خود حاوی همه پارامترهایی هستند که مساله و بهویژه تابع هدف را تحت تاثیر قرار میدهند. تابع هدف، با ریاضیات مساله را قاعدهگذاری کرده و حجم خوبی از راهکارهای کاندید برای آن را ارائه میکند.

هدف یک مساله بهینهسازی، پیدا کردن بهترین راهکار از میان کلیه راه حلهای امکانپذیر است. این یعنی در مساله بهینهسازی هدف یافتن کمینه یا بیشینه برای تابع هدف است. به عبارت دیگر، هدف پیدا کردن یک مجموعه از متغیرهای تصمیم ورودی محسوب میشود که برابر با کمینه یا بیشینه مقدار تابع هدف است و به آن «مقدار تناسب» نیز میگویند.

الگوریتم کلونی زنبور عسل مصنوعی

الگوریتم کلونی زنبور عسل مصنوعی (ABC)، یک راهکار بهینهسازی است که رفتار یک کلونی زنبور عسل را شبیهسازی میکند و برای اولین بار در سال ۲۰۰۵ توسط «کارابوگا» (Karaboga)، برای بهینهسازی پارامتر واقعی ارائه شد.

در این مدل ریاضی، کلونی زنبور عسل مصنوعی دارای سه نوع زنبور است. زنبورهای کارگر روی گردآوری غذا و آوردن آن به کندو از یک منبع غذایی خاص کار میکنند. زنبورهای ناظر در میان کارگرها گشت میزنند تا تشخیص دهند یک منبع غذایی همچنان ارزش استفاده دارد یا خیر و در نهایت زنبورهای دیدهبان که بهدنبال کشف منابع غذایی جدید هستند.

در الگوریتم ABC، یک منبع غذایی به عنوان حالتی در فضای جستوجو تعریف میشود (یک راهکار برای مساله بهینهسازی)، و تعداد منابع غذایی در ابتدا برابر با تعداد زنبورهای موجود در کندو است. کیفیت منابع غذایی توسط مقدار تابع هدف در آن موقعیت (مقدار تناسب) تعیین میشود.

رفتار هوشمند ناپایدار زنبورهای عسل را میتوان در چند گام زیر خلاصه کرد:

- زنبورها تلاش میکنند تا به صورت تصادفی در محیط بهدنبال منابع غذایی خوب بگردند (مقدار تناسب).

- پس از یافتن یک منبع غذایی، آنها تبدیل به زنبورهای کارگر میشوند و شروع به استخراج غذا از منبع یافت شده میکنند.

- زنبور کارگر با شهد به کندو باز میگردد و بار شهد خود را خالی میکند. پس از خالی کردن آن، میتواند مستقیما به منبع کشف شده خود باز گردد یا اطلاعاتی که درباره منبع غذاییش دارد را با اجرای یک رقص گردون در ناحیه رقص به اشتراک بگذارد.

- اگر یک منبع غذایی خالی شد، زنبوران کارگر به دیدهبان مبدل شده و به جست و جوی تصادفی برای منابع غذایی میپردازند.

- زنبورهای ناظر در کندو منتظر مانده و زنبورهای کارگر را در منابع غذایی گردآوری کردهشان مورد نظارت قرار میدهند و از میان منابع غذایی موجود با بیشترین سود، یک منبع را انتخاب میکنند.

- انتخاب منابع غذایی متناسب با کیفیت آن منبع (مقدار تناسب) است.

با اینکه سه نوع از زنبورهای عسل موجود در کلونی معرفی شدند، در مرحله پیادهسازی تنها دو نوع زنبور وجود دارد که زنبورهای کارگر و ناظر هستند. در واقع زنبور دیدهبان یک رفتار اکتشافی است که میتواند توسط زنبورهای کارگر و ناظر انجام شود.

در این مقاله، از زبان پایتون برای پیادهسازی استفاده میشود زیرا در محاسبات عددی بسیار موثر عمل کرده و پیادهسازی یک مجموعه از بنچمارکهای هدف را برای استفاده مجدد در الگوریتمهای هوش ازدحامی آسانتر میسازد.

بسته deap را میتوان از این مسیر دریافت کرد.

زنبورهای مصنوعی

به منظور آغاز ساخت الگوریتم، ابتدا باید راهکاری برای ارائه عامل زنبور در کد پایتون وجود داشته باشد. سه کارکرد اصلی وجود دارد که هر زنبوری باید دارای آنها باشد. نخست اینکه اگر زنبوری به دلیل رفتار اکتشافی به خارج از ناحیه تصمیم میرود باید توانایی بازگشت به کندو را داشته باشد.

دومین کارکرد، توانایی به روز رسانی وضعیت منبع غذایی کنونی که زنبور روی آن کار میکند و ارزیابی اینکه آیا در همسایگی، ناحیهای با منبع غذایی بهتر وجود دارد یا خیر است. و در نهایت آخرین مورد تشخیص این است که یک منبع غذایی خالی شده و اکنون زنبور باید به یک دیدهبان مبدل شود و به دنبال منابع غذایی جدید بگردد.

با در نظر گرفتن این مسائل، اکنون میتوان کلاس ArtificialBee را در پایتون به صورت زیر پیاده کرد:

زنبور کارگر

رفتار اصلی زنبور کارگر استخراج غذا از یک منبع غذایی است که در آن کارگران تا مرحله خالی شدن منبع کار میکنند. در مرحله پیادهسازی، این رفتار را میتوان به عنوان ساخت موقعیتهای جدید در نزدیکی جایی که زنبورهای کارگر مشغول کار هستند دید و ارزیابی کرد که آیا این موقعیت جدید مقدار بهتری غذا فراهم میکند؟ زنبورهای کارگر همیشه موقعیت بهترین منابع غذایی که به دست آوردهاند را تا پیش از خالی شدن آن، به خاطر میسپارند.

کلاس EmployeeBee را میتوان به صورت زیر پیاده کرد:

زنبورهای ناظر

زنبورهای ناظر از عملکرد زنبورهای کارگر پاسداری میکنند. آنها بر فراز کندو پرواز کرده، پیشرفت کار زنبورهای کارگر را مورد بررسی قرار داده و ارزیابی میکنند که کدام کارگرها در گردآوری غذا موفقتر عمل کردهاند.

زنبورهای ناظر همیشه بهترین کارگران را هدف میگیرند و از یک رویکرد احتمالی، با عنوان «محل ملاقات»، استفاده میکنند که بر اساس آن دیگر زنبورها نیز با این امید که غذای بیشتری گردآوری کنند باید به این موقعیت موفقیت بیایند.

کلاس OnlookerBee را میتوان به صورت زیر پیادهسازی کرد:

الگوریتم کامل کلونی زنبور عسل مصنوعی

پس از پیادهسازی عاملهای اصلی که قرار است در الگوریتم از آنها استفاده شود، اکنون زمان آن فرا رسیده تا کلیه مراحلی که پیش از این تشریح شد با کد پایتون پیادهسازی شود.

توجه به این نکته لازم است که هر یک از گامهای الگوریتم در یک متد جدا پیادهسازی شدهاند. در ابتدا، پارامترهای داخلی الگوریتم ABC پیادهسازی شده و زنبورهای کارگر و ناظر در موقعیتهای تصادفی قرار گرفتهاند. یک استراتژی پیشفرض که در مسائل جهان واقعی موفق عمل کرده این است که نیمی از کندو به عنوان زنبورهای کارگر و نیمی دیگر به عنوان زنبور ناظر در نظر گرفته شوند.

پس از آن، زنبورهای کارگر برای گردآوری غذا به منابع غذایی اولیه مخصوص خودشان فرستاده میشوند و در عین حال همواره به دنبال مناطق دارای غذای بهتر در اطراف منبع کنونیشان هستند. هنگامی که این فاز تمام شد، زنبورهای عسل ناظر برای گشتزنی و ارزیابی اینکه فرآیند استخراج غذا از هر منبع غذایی چقدر خوب پیش رفته ارسال میشوند. در نهایت، زمان آن رسیده که بررسی شود آیا یک منبع غذایی خالی شده یا خیر، در این مرحله هم زنبورهای کارگر و هم ناظرها میتوانند به زنبور دیدهبان مبدل شوند و فرآیند اکتشافی برای جستوجوی منابع غذایی جدید را آغاز کنند.

الگوریتم ABC کامل را میتوان به صورت زیر پیادهسازی کرد:

ارزیابی روی تابع بنچمارک

مزیتی که الگوریتمهای هوش ازدحامی نسبت به الگوریتمهای کلاسیک و روشهای مبتنی بر گرادیان دارند، توانایی اجرای خیلی خوب روی توابع غیر مشتقپذیر و توابع چند مدله است.

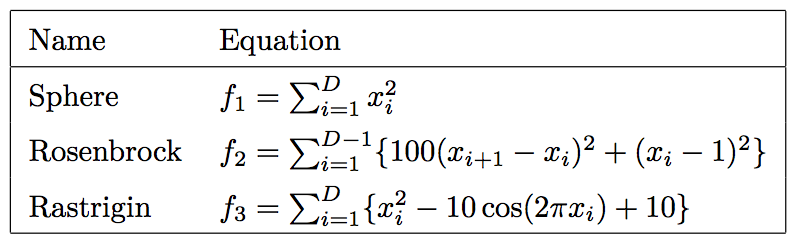

از آنجا که مسائل بهینهسازی بسیار مهم هستند، چندین تابع بنچمارک خیلی خوب برای ارزیابی کارایی الگوریتمهای بهینهسازی ارائه شده است. برخی از این توابع روی objective_function.py که پیشتر نوشته شده پیادهسازی میشوند و فرمولهای آنها در جدول یک قابل مشاهده است.

جدول ۱: لیست برخی توابع هدفی که بهعنوان بنچمارک برای سنجش کارایی الگوریتمهای بهینهسازی مورد استفاده قرار میگیرند.

برای آزمودن چارچوب ارائه شده در این مطلب و بررسی اینکه آیا الگوریتم ABC در حد انتظار عمل میکند یا خیر، میتوان کد آزمون زیر را اجرا، مقدار تناسب را روی نمودار رسم و ارزیابی کرد که فرآیند کمینهسازی برای این توابع چقدر خوب پیش رفته است.

نتایج را میتوان با تحلیل نمودار مقدار تناسب-تعداد تکرارها برای هر یک از توابع بنچمارکهای بیان شده ارزیابی کرد. همچنین میتوان خروجی optimizer.optimal_solution.pos را بررسی کرد که آیا الگوریتم ABC مقدار تخمینی خوبی نسبت به نقطه بهینه برای توابع بنچمارک داشته است یا خیر.

با توجه به نمودار یک، به نظر میرسد الگوریتم ABC برای تابع Sphere عملکرد خوبی داشته است.

نمودار ۱

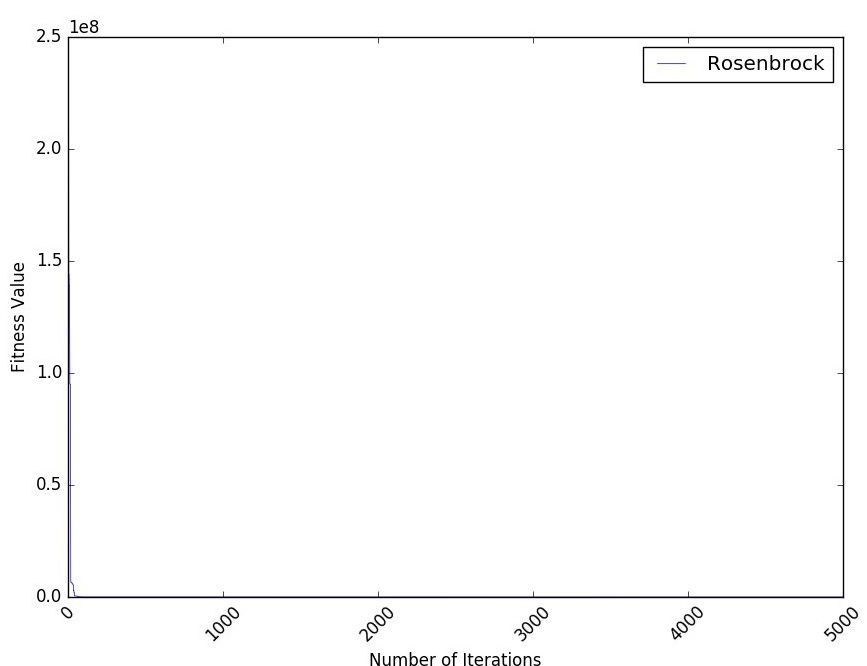

چنانکه در نمودار شماره دو نشان داده شده، عملکرد الگوریتم برای تابع Rosenbrock به میزانی سریع بوده که به سختی میتوان نمودار آن را مشاهده کرد.

نمودار ۲

چنانکه از نمودار سه مشهود است، الگوریتم ABC عملکرد خوبی برای تابع Rastrigin نیز داشته است.

نمودار ۳

گام بعدی چیست؟

اکنون که چگونگی کارکرد و روش پیادهسازی الگوریتم ABC ارائه شد، میتوان از آن برای حل مسائل جالب مانند خوشهبندی و بخشبندی تصویر (قطعهبندی تصویر | image segmentation) استفاده کرد.

برای این امر تنها کافیست تغییرات ریزی روی الگوریتم اعمال و فهمید که چگونه میتوان آن مسائل را به مساله بهینهسازی تبدیل کرد.

اگر نوشته بالا برای شما مفید بوده است، آموزشهای زیر نیز به شما پیشنهاد میشود:

- فیلم آموزشی کلونی زنبور مصنوعی یا Artificial Bee Colony در متلب

- آموزش خوشهبندی با استفاده از الگوریتم های تکاملی و فراابتکاری

- آموزش مرور مبانی تئوری الگوریتم بهینهسازی ازدحام ذرات یا PSO

- آموزش الگوریتم بهینهسازی جهش قورباغه یا SFLA

- گنجینه آموزشهای بهینهسازی هوشمند و محاسبات تکاملی

^^