دادهکاوی، الگوهای بنیادی تفکر انسان را پدیدار ساخته است

الگوهای فراوانی کلمات در نوشتههای مختلف نشان میدهد که انسان کلمات متداول و نامتداول را به طرز متفاوتی پردازش میکند و این یافته نتایج مهمی در خصوص پردازش زبان طبیعی (NLP) به دست داده است.

نخستین جرقهها

در سال 1935 میلادی زبانشناس آمریکایی جرج زیف (George Zipf) کشفی مهم انجام داد. زیف به تحقیق در خصوص کلمات متداول و نامتداول در زبان پرداخت. وی در طی این تحقیقات به بررسی میزان استفاده از کلمات در زبان معمولی پرداخته و آنها را بر اساس فراوانیشان مرتب ساخت.

در نتیجه نظم قابلتوجهی پدیدار گشت. زیف دریافت که فراوانی یک کلمه با جایگاه آن در این رتبهبندی نسبت معکوسی دارد. یعنی کلمهای که در جایگاه دوم این دستهبندی قرار داشت، به میزان نصف کلمه ردیف نخست در زبان استفاده شده بود. همچنین فراوانی کلمهای که در ردیف سوم قرار داشت، به میزان یکسوم کلمه اول بود.

در زبان انگلیسی پراستفادهترین کلمه the است که تقریباً 7 درصد از کل زبان را تشکیل میدهد. پس از آن کلمه and قرار دارد که 3.5 درصد از کلمات مورد استفاده در زبان انگلیسی را تشکیل میدهد و این لیست به همین ترتیب ادامه دارد. در واقع در حدود 135 واژه هستند که نیمی از همه فراوانیهای کلمات زبان انگلیسی را تأمین میکنند. بنابراین واژگان اندکی هستند که به طور مداوم استفاده میشوند، در حالی که اغلب واژهها به ندرت به کارمی آیند.

اما دلیل این مسئله چیست؟ یک احتمال این است که مغز انسان واژههای متداول را به طرز متفاوتی پردازش میکند و از این رو مطالعه توزیع زیف میبایست بینشهای مهمی در خصوص این فرایند مغز مشخص سازد.

خطای آماری؟

البته یک مشکل وجود دارد. همه زبانشناسها توافق ندارند که توزیع آماری فراوانی واژگان در نتیجه فرایندهای شناختی باشد. در واقع برخی از آنها میگویند که این توزیع در نتیجه خطاهای آماری در ارتباط با واژگان با فراوانی پایین است که میتوانند توزیعهای مشابهی را تولید کنند.

بدیهی است که نیاز به مطالعه بزرگتری بر روی طیف وسیعتری از زبانها وجود دارد. چنین مطالعه بزرگمقیاسی از نظر آماری آن قدر قدرتمند خواهد بود که این احتمالها از هم متمایز شوند.

امروز به لطف تحقیق شوئییوآن یو (Shuiyuan Yu) و همکاران در دانشگاه ارتباطات چین در پکن، این امر محقق شده است. این محققان دریافتهاند که قانون زیف در 50 زبان که از دستههای مختلف زبانشناختی انتخاب شدهاند و شامل زبانهای هندواروپایی، اورالی، آلتایی، قفقازی، چین-تبتی، دراویدی؛ آفریقایی-آسیایی و ... میشود صادق است.

یو و همکاران بیان کردهاند که فراوانیهای واژگان در این زبانها ساختار مشترکی دارند که از ساختار خطاهای آماری متفاوت هستند. به علاوه آنها بیان میکنند که این ساختار پیشنهاد میکند که مغز واژههای متداول را به طور متفاوتی از واژههای غیرمتداول پردازش میکند. این ایدهای است که نتایج مهمی در پردازش زبان طبیعی و تولید خودکار متن دارد.

روش یو و همکاران سرراست است. آنها کار خود را با دو مجموعه بزرگ از متن که British National Corpus و the Leipzig Corpus نام دارند آغاز کردند. این دو مجموعه شامل نمونههایی از 50 زبان مختلف هستند که هر نمونه شامل دستکم 30،000 جمله و تا 43 میلیون کلمه هستند.

توزیع سه بخشی

محقان دریافتند که فراوانی کلمات در همه زبانها از قاعده زیف (با تعدیلهایی) پیروی میکند که در آن توزیع را میتوان به سه بخش تقسیم کرد. نتایج آماری نشان میدهد که قاعده زیف در 50 زبان وجود دارد که همگی الگوی ساختاری سهبخشی مشترکی دارند و هر بخش مشخصات زبانشناختی متمایزی را به نمایش میگذارد.

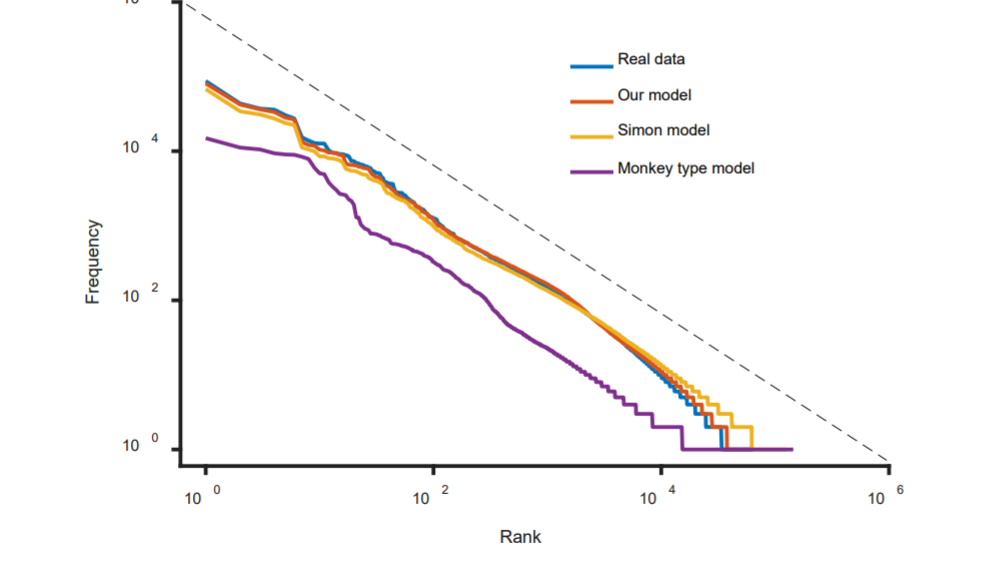

این ساختار جالب است. یو و همکاران تلاش کردند تا آن را با استفاده از چند مدل برای ایجاد کلمهها شبیهسازی کنند. یک مدل به نام مدل «میمون و ماشین تایپ» نامیده میشود که حروف تصادفی تولید میکند که هر زمان کاراکتر فاصله ایجاد شود، تبدیل به کلمه میشوند.

این فرایند یک توزیع با قاعده قوی شبیه به قاعده زیف تولید میکند. با این وجود این فرایند نمیتواند ساختاری سهبخشی که یو و همکاران کشف کردهاند را تولید کند. همچنین این ساختار نمیتواند بر حسب خطاهایی که با واژگان با فراوانی کم تولید میشوند توضیح داده شود.

با این حال یو و همکاران توانایی بازتولید این ساختار را با استفاده از مدلی که مغز مورد استفاده قرار میدهد یافتهاند. این مدل نظریه پردازش دوگانه نامیده میشود. این همان ایدهای است که نشان میدهد مغز به دو روش متفاوت عمل میکند.

روش اول تفکر شهودی سریع است که نیازمند استدلال کمی است یا اصلاً به استدلال نیاز دارد. تصور میشود این نوع از تفکر بدان دلیل در مغز انسان تکامل یافته است که به وی امکان واکنش سریع در موقعیتهای خطرناک را بدهد. این روش به طور کلی راهحلهای مناسبی برای مسائل مختلف ارائه میکند که شامل بازشناسی الگو میشوند؛ اما میتوانند به سادگی در موقعیتهای غیرشهودی اشتباه کنند.

با این وجود انسانها قادر هستند تفکر منطقیتری نیز داشته باشند. این نوع تفکر دوم کندتر بوده، نیاز به محاسبه بیشتری دارد و عامدانه است. این نوع از تفکر است که امکان حل مسائل پیچیدهای مانند معماهای ریاضیات و ... را به ما میدهد.

نظریه فرایند دوگانه

نظریه فرایند دوگانه نشان میدهد که کلمههای متداولی مانند the، and، if و غیره از طریق تفکر سریع و شهودی پردازش میشوند و بنابراین بیشتر مورد استفاده قرار میگیرند. این کلمات نوعی شاکله اصلی برای جملهها تشکیل میدهند.

با این حال کلمهها و عبارتهای کمتر متداول مانند «فرضیه»، و «قاعده زیف» نیازمند تفکر دقیقتری هستند و از این رو کمتر استفاده میشوند.

در واقع وقتی یو و همکارانش این فرایند دوگانه را شبیهسازی میکنند، تحقیق آنها منتهی به همان ساختار سهبخشی در توزیع فراوانی کلمات شد که در 50 زبان مختلف اندازهگیری کرده بودند.

بخش نخست نشاندهنده توزیع کلمههای متداول بود، آخرین بخش نشاندهنده توزیع کلمههای نامتداول بود و بخش میانی نتیجه تقابل این دو حالت بود. یو و همکاران بیان کردهاند: «این نتایج نشان میدهد که قاعده زیف در زبانها بر اساس سازوکارهای شناختی مانند پردازش دوگانه توضیح داده میشود که رفتارهای کلامی انسان را تعیین میکند.»

این تحقیق جالبی است. ایده این که مغز انسان اطلاعات را به دو روش متفاوت پردازش میکند، در سالهای اخیر مهارت زیادی کسب کرده است که بخشی از آن به دلیل کتابی با عنوان «تفکر سریع و کند» نوشته روانشناس برنده جایزه نوبل دنیل کانمَن (Daniel Kahneman) بوده است. این روانشناس ایده دوگانگی ذهن را به طور مفصل مورد بررسی قرار داده است. مسئله شناختهشدهای که جرقه ایده تفکر سریع و کند را زده، به این صورت است:

«یک چوب بیسبال و توپ آن در مجموع 1.10 دلار قیمت دارند. قیمت چوب 1.00 دلار بیشتر از توپ است. قیمت توپ جه قدر است؟»

البته مشخص است که پاسخ 5 سنت است. اما تقریباً اغلب افراد در ابتدا تمایل دارند که پاسخ را 10 سنت اعلام کنند. دلیل این مسئله آن است که 10 سنت صحیحتر به نظر میرسد. میزان بزرگی آن مقدار صحیحی است و از سوی چارچوببندی مسئله نیز پشتیبانی میشود. این پاسخ از سمت تفکر شهودی سریع ذهن ناشی میشود؛ اما پاسخی اشتباه است. پاسخ صحیح نیازمند محاسبهای کندتر است که بخش دیگری از مغز مسئول آن است.

جمع بندی

یو و همکارانش بیان کردهاند که همین دو فرایند در تولید جملات نیز نقش دارد. بخش تفکر سریع مغز ساختار اصلی جمله را تشکیل میدهد (که این کلمات به صورت پر رنگ نمایش یافتهاند). سمت دیگر مغز نیازمند محاسبات کندتر و پیچیدهتر است. این همان فرایند دوگانه است که به قاعده سهبخشی زیف منتهی میشود.

این مسئله میتواند نتایج جالبی برای دانشمندان رایانهای که بر روی پردازش زبان طبیعی فعالیت میکنند، داشته باشد. این حوزه در طی سالهای اخیر شاهد پیشرفتهای بزرگی بوده است. این پیشرفتها از الگوریتمهای یادگیری ماشین ناشی شدهاند و البته پایگاههای داده بزرگی که شرکتهایی مانند گوگل جمعآوری کردهاند نیز بیتأثیر نبوده است.

اما تولید زبان طبیعی همچنان کاری دشوار است. لازم نیست مدت زیادی با دستیارهایی مانند سیری، کورتانا یا دستیار گوگل صحبت کنید تا با محدودیتهای آنها مواجه شوید. بنابراین دستیابی به درک بهتری از شیوه تولید جملات از سوی انسان میتواند کمک شایان توجهی بکند. اگر زیف زنده بود، مطمئناً از این پیشرفتها شگفتزده میشد.

اگر این نوشته مورد توجه شما واقع شده است، موارد زیر نیز احتمالاً برای شما مفید خواهند بود:

- پایتون و مدلسازی زبان — راهنمای گامبهگام

- مجموعه آموزشهای هوش محاسباتی

- برنامهنویسی پایتون — چگونه با کمتر از ۲۰ خط کد، جملههای الهامبخش ایجاد کنیم؟

- spaCy در پایتون — پردازش زبان طبیعی به صورت آسان

- بهینهسازی کلاسیک و هوشمند

- ۳۰ پرسش و پاسخ دربارهی پردازش زبانهای طبیعی

==