یکپارچه سازی داده ها چیست؟ – توضیح Data Integration به زبان ساده

در جهان دیجیتال، کسبوکارها تنها در صورتی قادر به ادامه کار هستند که بتوانند دادههای مورد نیاز خود را از طریق گستره وسیعی از منابع شامل پایگاههای داده، نرمافزارها و سرویسهای ابری جمعاوری کنند. در بیشتر مواقع، فرمت و موقعیت ذخیرهسازی دادهها به سطح متفاوتی از کیفیت و پایداری میرسد. از همین جهت و بهمنظور غلبه بر این چالشها، به اجرای فرایندی با عنوان «یکپارچهسازی دادهها» (Data Integration) میپردازیم. فرایندی که با جمعآوری دادهها از منابع مختلف و سپس تبدیل آنها به ساختاری مطمئن، باعث تسهیل در تحلیل و تصمیمگیری نهایی میشود. در این مطلب از مجله فرادرس یاد میگیریم یکپارچه سازی داده ها چیست و آشنایی جامعی از ابعاد مختلف آن بهدست میآوریم.

در این مطلب ابتدا یاد میگیریم مفهوم یکپارچه سازی داده ها چیست و چه ارتباطی میان هوش مصنوعی و یکپارچهسازی دادهها وجود دارد. سپس از نحوه کارکرد و چگونگی انجام یکپارچهسازی دادهها میگوییم و به معرفی انواع و همچنین ابزارهای این فرایند میپردازیم. در انتهای این مطلب از مجله فرادرس پس از ارائه چند مثال، شرح مختصری از مزایا، چالشها و کاربردهای یکپارچهسازی دادهها ارائه میدهیم.

مفهوم یکپارچه سازی داده ها چیست؟

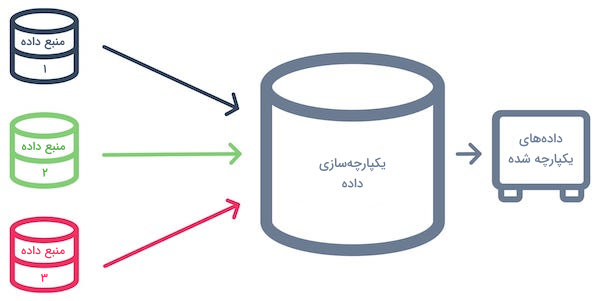

به فرایند ترکیب دادههای جمعآوری شده از چند منبع مختلف، برای ساخت مجموعهای واحد از اطلاعات، «یکپارچه سازی داده ها» (Data Integration) گفته میشود. هدف از یکپارچهسازی دادهها چیزی نیست جز ایجاد دیتاست یا «مجموعهدادهای» (Dataset) تمیز و کارآمد که نیاز بخش عمدهای از کاربران را برطرف سازد. همچنین یکپارچهسازی دادهها قدمی لازم و ضروری برای بهبود عملکرد مدلهای یادگیری ماشین است. با ترکیب دادهها از چند منبع متفاوت و تضمین کیفیت اطلاعات، فرایند یکپارچهسازی دادهها نقش جزئی سازنده را در حوزه هوش مصنوعی و آموزش مدلهای یادگیری ماشین ایفا میکند.

ارتباط میان هوش مصنوعی و یکپارچه سازی داده ها چیست؟

حالا که میدانیم منظور از یکپارچه سازی داده ها چیست، درک رابطه میان این فرایند و هوش مصنوعی در بهینهسازی عملکرد سیستمهای هوشمند ضروری است. یکپارچهسازی دادهها تاثیر مستقیمی بر کیفیت و همچنین وسعت اطلاعات مورد استفاده در آموزش و ارزیابی مدلهای یادگیری ماشین میگذارد. برخی از جنبههای کلیدی این اثرگذاری عبارتاند از:

- بهبود کیفیت دادهها: اجرای صحیح یکپارچهسازی دادهها تضمین میکند که دیگر ناهماهنگی میان نمونهها وجود نداشته و تمامی مشکلات، پیش از ارائه دادهها به الگوریتمهای یادگیری ماشین برطرف شدهاند. دادههای با کیفیت، بسیار در تولید پیشبینیهای قابل اعتماد و ارتقا اثربخشی نهایی سیستمهای هوشمند تاثیرگذار هستند.

- کاهش خطا و افزونگی: گاهی ممکن است بهدلیل تفاوت فرمت یا واحد اندازهگیری دیتاستهای مختلف، دادهها تفاوت چشمگیری با یکدیگر داشته باشند. فرایند یکپارچهسازی دادهها با ادغام نمونههایی از چند مرجع متفاوت، باعث حذف افزونگیها شده و دیتاست تمیزتری را برای آموزش مدلهای یادگیری نتیجه میدهد.

- ترکیب دیتاستهای متنوع برای تجزیه و تحلیل: با یکپارچهسازی چند دیتاست، اطمینان حاصل میشود که الگوریتمهای هوش مصنوعی دسترسی گستردهتری بر اطلاعات مورد نیاز برای تجزیه و تحلیل داشته باشند. مدلهای یادگیری ماشین با بهرهگیری از دیتاستی جامعتر، بهخوبی میتوانند از روابط پیچیده میان متغیرها آگاه شده و نتایج دقیقتری ارائه دهند.

بهطور کلی، یکپارچهسازی دادهها همزمان با حفظ انسجام میان نمونهها، باعث ادغام و تبدیل چند دیتاست متفاوت به یک ساختار جامع شده و در نهایت نیز به مدلی دقیقتر منجر میشود.

کارکرد یکپارچه سازی داده ها چیست؟

همانطور که در بخشهای قبلی نیز به پرسش یکپارچه سازی داده ها چیست پاسخ دادیم، این فرایند شامل مراحلی است که دادههایی از چند منبع مختلف را جمعاوری کرده و ترکیب آنها را به شکلی واحد و قابل استفاده تبدیل میکند. در فهرست زیر به شرح نحوه کار فرایند یکپارچهسازی دادهها پرداختهایم:

- شناسایی منبع داده: اولین قدم شناسایی دادههای مورد نیاز از منابعی مانند «پایگاههای داده» (Databases) و سرویسهای ابری است.

- استخراج داده: در مرحله بعد باید دادههای شناسایی شده را بهوسیله ابزارهایی از منابع مورد نظر استخراج کنیم.

- نگاشت داده: با توجه به احتمال متغیر بودن فرمت دیتاستها، کدها یا ساختار نمایش اطلاعات، وجود طرحوارهای که بیانگر ارتباط میان عناصر سیستمهای مختلف باشد، برای ایجاد هماهنگی در طی فرایند یکپارچهسازی ضرورت دارد.

- ارزیابی داده و تضمین کیفیت: فرایند ارزیابی شامل مراحی همچون بررسی خطاها، ناسازگاریها و انسجام میان دادهها برای اطمینان حاصل کردن از دقت و کیفیت است. همچنین منظور از تضمین کیفیت، حفظ دقت و ثبات دادهها است.

- تبدیل داده: در این مرحله، دادهها تبدیل شده و در قالب ساختاری مشترک برای حفظ تداوم، دقت و سازگاری ذخیره میشوند. «پاکسازی داده» (Data Cleaning) و «نرمالسازی داده» (Data Normalization) دو مورد از رایجترین فرایندهای این مرحله هستند.

- بارگذاری داده: به زمانی گفته میشود که دادههای تغییر یافته برای انجام عملیاتهای بعدی مانند ارزیابی و تهیه گزارش در به اصطلاح «انبار داده» (Data Warehouse) ذخیره میشوند. این بارگذاری بسته به پیشنیازهای مسئله میتواند هم به صورت «دستهای» (Batch) و هم «بلادرنگ» (Real-time) انجام شود.

- همگامسازی داده: با همگامسازی مطمئن میشویم که پس از گذشت زمان، یکپارچگی دادهها چه از طریق بهروزرسانیهای دورهای و چه بلادرنگ حفظ میشود.

- امنیت داده: اجرای تکنیکهای حفظ امنیت داده، مدیریت نمونه دادهها را به شیوهای استاندارد تضمین میکند. این تکنیکها مانع تغییر ناخواسته دادهها در طول فرایند یکپارچهسازی شده و از ذخیرهسازی نیز جلوگیری میکنند.

- مدیریت فراداده: فرداده یا همان Metadata علاوهبر ارائه اطلاعاتی اضافه در مورد دادههای یکپارچه شده، قابلیت کشف و استفاده از دادهها را به نحوی افزایش میدهد که کاربران بتوانند درک بهتری از محتوا و منبع دادهها بهدست آورند.

- دسترسی و تحلیل داده: پس از یکپارچهسازی، میتوانیم به ارزیابی و تهیه گزارش از دادهها بپردازیم و از دانش بهدست آمده برای تصمیمگیری موثرتر بهرهمند شویم.

در کل، یکپارچهسازی دادهها تشکیل شده است از ترکیب فرایندها، ابزارها و استراتژیهایی که دقت، هماهنگی و در دسترس بودن دادهها را برای انجام بررسیهای معنادار و تصمیمگیری تضمین میکنند. در ادامه این مطلب و حالا که میدانیم یکپارچه سازی داده ها چیست و چگونه کار میکند، به بررسی مراحل اجرای این فرایند میپردازیم.

چگونه یکپارچه سازی داده ها را با فرادرس یاد بگیریم؟

در جهان امروز که دادهها از منابع گوناگون و با فرمتهای متفاوت جمعآوری میشوند، یکپارچهسازی آنها چالشی بزرگ اما ضروری محسوب میشود. یکپارچهسازی دادهها به معنی ترکیب و ادغام دادههای پراکنده از منابع مختلف بهگونهای واحد و منسجم است. پیش از آنکه بتوان به فرایند یکپارچهسازی پرداخت، ابتدا باید با انواع مختلف و ساختار منابعی مانند پایگاههای داده آشنا شوید.

در مرحله بعد نیاز دارید تا با استفاده از ابزارهایی مانند زبان برنامهنویسی پایتون، مهارت پیشپردازش دادهها را کسب کنید. پس از کسب این دانش، باید آن را در پروژههای حقیقی و حوزههایی مانند یادگیری ماشین پیادهسازی کنید. در همین راستا و اگر قصد ارتقا مهارتهای خود را در این زمینه دارید، مجموعه فرادرس فیلمهای آموزشی جامع و کاربردی را فراهم کرده است که مشاهده آنها را به ترتیبی که در ادامه آورده شده است به شما پیشنهاد میکنیم:

- فیلم آموزش رایگان انواع داده و ساختارهای مدیریت و ذخیره سازی اطلاعات فرادرس

- فیلم آموزش پایگاه داده فرادرس

- فیلم آموزش رایگان روش های پیش پردازش داده ها فرادرس

- فیلم آموزش رایگان کار با پیش پردازش ها در یادگیری ماشین با پایتون فرادرس

یکپارچه سازی داده ها چگونه انجام می شود؟

سازوکار سنتی یکپارچهسازی دادهها به این صورت است که کاربر، درخواستی را برای سرور مرکزی ارسال میکند. سپس سرور مرکزی دادههای مورد نیاز را از منابع داخلی و خارجی جمعآوری کرده و نتیجه، مجموعهدادهای واحد از ترکیب دادهها خواهد بود. خروجی که برای مصرف در اختیار کاربر قرار میگیرد. حجم دادههایی که روزانه توسط شرکتها از منابع مختلف اطلاعاتی جمعآوری میشوند مدام در حال افزایش است. این وظیفه سازمانها است که شیوه کاری مناسب را جهت استخراج اطلاعات به کارکنان، کاربران و مشتریهای خود معرفی کنند. به بیان سادهتر، شرکتهای بزرگ باید این توانایی را داشته باشند تا در هر لحظهای و برای تحقق اهداف تعریف شده، به دادههای مورد نیاز خود دسترسی پیدا کنند.

دادههای مورد نیاز ما در میان منابع مختلفی مانند نرمافزارها، دیتاستها، فضای ابری و دستگاههای مرتبط با «اینترنت اشیا» (Internet of Things | IoT) پراکنده هستند. امروزه سازمانها دیگر تمامی دادههای خود را در قالب تنها یک پایگاه داده ذخیره نمیکنند و در عوض، به توزیع انواع مختلف ساختیافته و بدون ساختار نمونه دادهها میان چندین منبع متفاوت میپردازند. به عنوان مثال، ممکن است بخشی از اطلاعات شرکتی در فایل و بخش دیگر در سرویسهای ابری ذخیره شده باشد. برای آشنایی بیشتر با مفهوم اینترنت اشیا، توصیه میکنیم مطلب زیر را از مجله فرادرس مطالعه کنید:

اغلب منظور از یکپارچهسازی، نوع فیزیکی و منطقی آن است. مانند انتقال فیزیکی اطلاعات از مرجعی به مرجع دیگر که تمامی فرایندهای پاکسازی، نگاشت و تغییر داده پیش از جابهجایی انجام میشود. اما روش جایگزین «مجازیسازی داده» (Data Virtualization) نام دارد. در این روش دسترسی به زیرساختهای فیزیکی برای استخراج داده ضرورت دارد. برخلاف یکپارچهسازی فیزیکی، روش مجازیسازی نیازی به انتقال حقیقی دادهها ندارد و نمایی شبیهسازی شده از آنها ایجاد میکند.

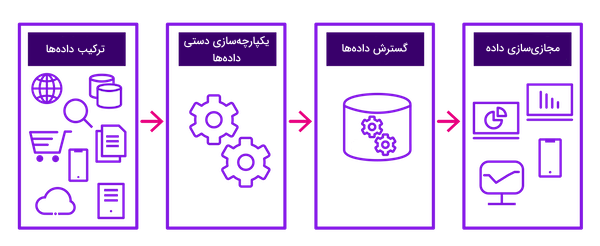

۱. ترکیب داده ها

در روش «ترکیبی» (Consolidation)، دادهها به شکل فیزیکی با یکدیگر ترکیب شده و نسخهای از این دادهها در تنها یک مخزن ذخیره میشود. بهطور معمول، هدف از جمعآوری دادهها، کاهش تعداد منابع ذخیرهسازی است. رویکرد ETL نیز از روش ترکیبی پشتیبانی میکند. در ETL، دادهها از چند منبع استخراج شده و پس از تغییر فرمت، به انبار یا پایگاه دادهای متفاوت منتقل میشوند. پیش از گسترش منبع جدید، رویکرد ETL تمامی فرایندهای آمادهسازی مانند سازماندهی و تغییر دادهها را پیادهسازی میکند.

۲. یکپارچه سازی دستی داده ها

استفاده از روش قدیمی و کدنویسی مراحل مختلف کار، از جمله پایهایترین روشهای یکپارچهسازی دادهها بهحساب میآید. این استراتژی تنها برای کمیت محدودی از دادهها کارآمد است. از جمله مزایای این روش، میتوان به داشتن کنترل کامل بر جمعآوری، تغییر و یکپارچهسازی دادهها اشاره کرد. اگرچه این روش میتواند در برخی از هزینهها صرفهجویی کند، گاهی زمانبر بوده و باعث طولانی شدن فرایند یکپارچهسازی و ادغام منابع جدید میشود.

۳. گسترش داده ها

بهرهبرداری از نرمافزارهای مرتبط برای تکثیر اطلاعات از یک موقعیت به موقعیتی دیگر را «گسترش داده» (Propagating Data) گویند. روشی که «رویداد محور» (Event-driven) است.

۴. مجازی سازی داده

علارغم تقسیم اطلاعات در سیستمهای ذخیرهسازی مختلف، «مجازیسازی داده» (Data Virtualization) به کاربران این امکان را میدهد تا نمایی واحد از دادهها دریافت کنند. مجازیسازی تنها لایهای منطقی است که دادههای چند منبع را با یکدیگر ترکیب کرده و نتیجه حاصل را در همان لحظه به کاربران انتقال میدهد. مزیت مجازیسازی در حذف نیاز به انتقال فیزیکی دادهها خلاصه میشود. دیگر نیازی به صرف هزینه اضافی برای منابع ذخیرهسازی نیست و اطلاعات، بدون تغییر در مرجع اصلی باقی میمانند.

انواع مختلف یکپارچه سازی داده ها

تا اینجا بهخوبی میداینم یکپارچه سازی داده ها چیست و از چه مراحلی تشکیل میشود. حالا و در این بخش، با انواع مختلف یکپارچهسازی دادهها آشنا میشویم و به بررسی مزایا و معایب هر کدام می پردازیم.

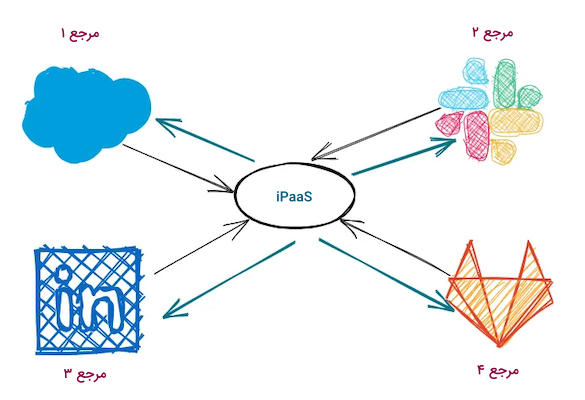

پلتفرم یکپارچه سازی به عنوان سرویس یا iPaaS

پلتفرم یکپارچه سازی به عنوان سیستم یا به اختصار iPaaS، مخفف عبارت Integration Platform as a Service است و در سال ۲۰۰۸ توسط شرکت Boomi پایهگذاری شده است. دیگر میدانیم که نوع یکپارچهسازی از یک منبع به منبع دیگر متفاوت است. اما در عمل، نحوه کارکرد تمامی روشها یکسان بوده و بر اساس یک «محرک» (Trigger) فعال میشوند. هر محرک در واقع رویدادی منتقل شده به پلتفرم یکپارچهسازی است که وظیفه انجام یک یا تعداد بیشتری عملِ از پیش تعریف شده را بر عهده دارد. به عنوان مثال، دریافت ایمیل یا پیامی در شبکههای اجتماعی نقش محرکی را دارد که محتوا و نشانهگذاری آن به عنوان پیام خوانده شده، به ترتیب دو عمل اول (Action One) و دوم (Action Two) هستند. در چنین موقعیتی، سرویس ایمیل شما به محض دریافت پیام، آن را به پلتفرم یکپارچهسازی انتقال میدهد.

راهکارهای iPaaS این قابلیت را دارند تا طبق یک جدول زمانی، به عنوان مثال هر دو ساعت یکبار بهدنبال تغییرات در سیستم مرجع بگردند و مطابق با آن عمل خاصی را انجام دهند. پلتفرم یکپارچهسازی میتواند در هر ساعت، سرویس ایمیل شما را بررسی کند تا اگر پیام تازهای دریافت کرده بودید، واکنش جدیدی نشان دهد. در اینجا نیز، محرک ما پیام جدید دریافتی است اما، این وظیفه iPaaS است که اطلاعات جدید را از سرویس ایمیل استخراج کند.

از راهکار iPaaS برای جابهجایی دادهها میان سیستمهای داخلی نیز استفاده میشود. با این حال و از آنجا که هزینه پلتفرمهای یکپارچهسازی بر اساس تعداد عملیاتها محاسبه میشود، روش iPaaS چندان در این زمینه مورد استفاده قرار نمیگیرد. از جمله مهمترین مزایای iPaaS، ارائه رابط کاربری مناسب برای یکپارچهسازی است که به کسبوکارها اجازه میدهد تا جریان کارها را تحت نظر داشته باشند. در حقیقت استفاده از iPaaS بسیار راحت بوده و نیاز به هیچ دانش فنی ندارد. در نهایت مانند هر فناوری دیگری iPaaS نیز شامل مجموعهای از محدودیتها بوده و راهحل جامعی برای انواع مختلف نیازهای یکپارچهسازی محسوب نمیشود. بهویژه زمانی که نیاز به جابهجایی دادههایی است که رویداد محور نیستند. همچنین بهخاطر انعطافپذیری و پیچیدگی راهکار iPaaS، کاربر نهایی با سطحی بالایی از پیچیدگی مواجه خواهد بود.

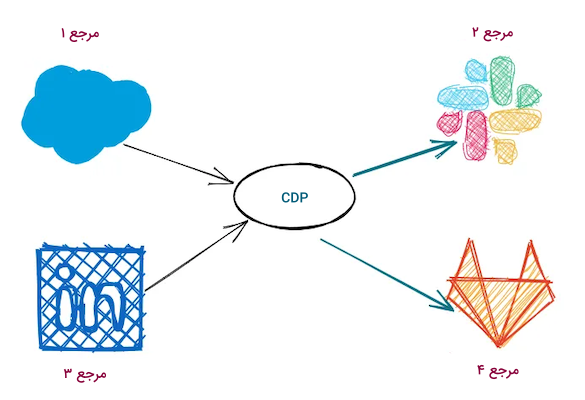

پلتفرم داده های کاربر یا CDP

در رویکرد «پلتفرم دادههای کاربر» (Customer Data Platform | CDP) همانطور که از عنوان آن مشخص است، دادههای کاربر از منابع مختلفی جمعآوری شده و به مقاصد مختلفی نیز ارسال میشود. قابل ذکر است که در کنار جابهجایی اطلاعات، در CDP امکان جمعآوری داده از طریق «کیتهای توسعه نرمافزار» (Software Development Kits | SDKs) و «رابطهای برنامهنویسی اپلیکیشن» (Application Programming Interfaces | APIs) نیز وجود دارد. مانند iPaaS، از رویکرد CDP نیز در چند سال اخیر استقبال زیادی شده و در صنایع بسیاری مورد استفاده قرار گرفته است.

پلتفرمهای داده کاربر یا همان CDP هنگام جابهجایی دادهها، مبتنیبر مدلهای داده از پیش تعریف شده عمل میکنند و همکاری محدودی با منابع خارجی دارند. از همین جهت، کمتر در یکپارچهسازی دادهها مورد استفاده قرار میگیرند. قابلیت این رویکرد بیشتر از تنها جابهجایی اطلاعات میان ابزارهای مختلف است و تیمهای بازاریابی را قادر میسازد تا با ساخت بخشهایی مطابق با رفتار کاربران، تجربه قابل قبولی به آنها ارائه دهند.

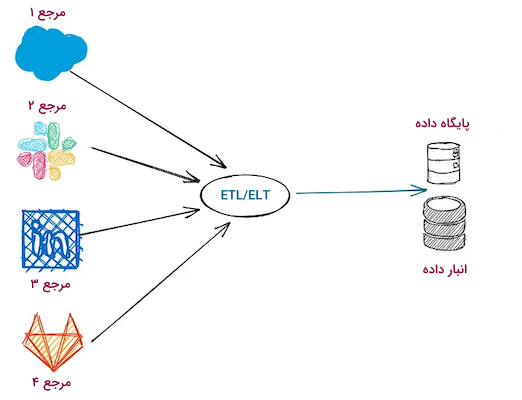

استخراج، تغییر و بارگذاری یا ETL

تاریخچه رویکرد «استخراج، تغییر و بارگذاری» (Extract, Transform and Load | ETL) به سال ۱۹۷۰ برمیگردد. با این حال تنها در اوایل دهه ۹۰ میلادی بود که ETL جایی در صنعت پیدا کرد. مطابق با الگو ETL، ابتدا دادهها از پایگاههای داده «دست اول» (First-party) و منابع «دست سوم» (Third-party) جمعآوری شده و پس از تغییر مطابق با نیاز تحلیلگران و دانشمندان علم داده، در انبار داده ذخیره می شوند. برای یادگیری بیشتر در مورد ETL میتوانید فیلم آموزشی فرایند ETL و ساخت انبار داده فرادرس که لینک آن در ادامه آورده شده است را مشاهده کنید:

بخش تغییر یا Transformation علاوهبر نیاز به منابع زیاد، بسیار زمانبر بوده که تاثیر بهسزایی بر زمان استخراج و بارگذاری میگذارد. با توجه به پیشرفتهای حوزه «انبارداری» (Warehousing)، رویکرد دیگری با عنوان ELT جایگزین ETL شده که هم سریعتر و هم انعطافپذیرتر است.

استخراج، بارگذاری و تغییر یا ELT

روش «استخراج، بارگذاری و تغییر» (Extract, Load and Transform | ELT) نسخه بهروز شده ETL است که از زمان افزایش سرعت و پایداری انبارهای داده فضای ابری، موارد استفاده بسیاری پیدا کرده است. همچنین انعطافپذیری و مزایای ساختاری که بخش محاسبات را از ذخیرهسازی جدا میکند نیز نقش مهمی در ترویج راهکار ELT داشتهاند. بر اساس الگو ELT، دادهها از سیستم مرجع استخراج و بدون تغییر در انبار داده ذخیره میشوند. علاوهبر سریع و بهصرفه بودن، ELT هیچ نیازی به کدنویسی ندارد.

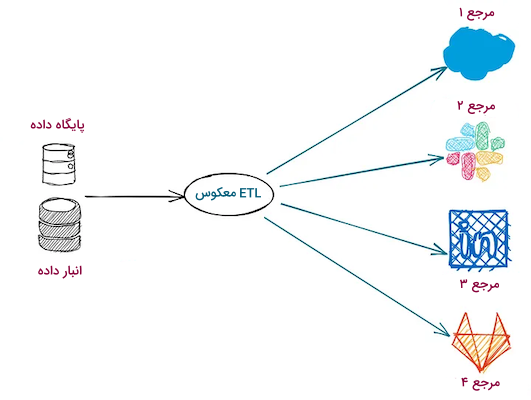

ETL معکوس

مزایای ذخیرهسازی داده از منابع مختلف با بهرهگیری از ابزارهای ELT بسیار است. با این حال، توانایی تغییر نمونهها در انبار داده است که به انواع دادهها از جمله دادههای کاربر که در بین سیستمهای داخلی و خارجی پراکنده است ارزش میدهد. در نتیجه، گروه جدیدی از ابزارهای یکپارچهسازی بهنام «ETL معکوس» (Reverse ETL) بهوجود آمدند. در فهرست زیر به تعدادی از کاربردهای ETL معکوس اشاره شده است:

- دادهها بهطور منظم از انبار یا پایگاه داده استخراج شده و در دسترس ابزارهای آماری، بازاریابی و فروش قرار میگیرند.

- با ایجاد هر تغییر در دادهها، محرکی فعال یا درخواستی به سرویسهای API ارسال میشود.

- سطرهای استخراج شده داده بهمنظور اهداف خاص به مخازن عملیاتی منتقل میشوند.

با توجه به نگهداری از انبارهای داده به عنوان منبعی از نمونههای تمیز توسط تیم تحلیل داده، انتقال دادههای ذخیره شده به سرویسهای ابری بدیهی بهنظر میرسد. به این شکل، سرانجام مهندسان داده میتوانند سیستمی واحد برای پردازش و اجرا در اختیار سایر بخشها قرار دهند. پس از پاسخ دادن به پرسش یکپارچه سازی داده ها چیست و آشنایی با انواع مختلف آن، در بخش بعدی به بررسی ابزارهای رایج و کاردبری در این زمینه میپردازیم.

ابزار های یکپارچه سازی داده ها

برای مدتها رایجترین روش برای یکپارچهسازی داده نیازمند توسعهدهندگانی بود که با زبان برنامهنویسی استاندارد مورد استفاده در «پایگاههای داده رابطهای» (Relational Databases) یعنی «زبان پرسوجوی ساختاریافته» (Structured Query Language | SQL) آشنایی داشته باشند. اما امروزه شرکتهای حوزه فناوری ابزارهای یکپارچهسازی داده متنوعی را از راهکارهای متنباز گرفته تا پلتفرمهای اختصاصی، برای کاربردهایی همچون خودکارسازی و مستندسازی فرایند یکپارچهسازی دادهها عرضه میکنند. بهطور کلی هر کدام از سیستمهای یکپارچهسازی شامل تعدادی از ابزارهای زیر میشوند:

- ابزارهای ETL: از این ابزارها برای استخراج داده از منابع مختلف، تغییر دادهها به فرمت یا ساختاری قابل قبول و سپس ذخیرهسازی در سیستمی مانند انبار و پایگاه داده استفاده میشود. ابزارهای ETL علاوهبر ذخیرهسازی در یکپارچهسازی و انتقال دادهها نیز کاربرد دارند.

- «گذرگاه سرویس سازمانی» (Enterprise Service Bus | ESB) و «میانافزار» (Middleware): ابزارهایی که از طریق ارائه زیرساختهای ارتباطی، یکپارچهسازی نرمافزارها و سرویسهای مختلف را تسهیل میکنند. از جمله ویژگیهای این ابزارها میتوان به تبادل بلادرنگ دادهها، منظمسازی جریان کار و مدیریت API اشاره کرد.

- ابزارهای «تکثیر داده» (Data Replication): کاربرد ابزارهای تکثیر داده در همانندسازی مکرر دادهها از سیستم مبدا به سیستم هدف و هماهنگ نگهداشتن آنها خلاصه میشود. یکپارچهسازی بلادرنگ، «جبران فاجعه» (Disaster Recovery) و انواع موقعیتهای اضطراری، تعدادی از مسائلی هستند که برای مدیریت آنها از ابزارهای تکثیر داده بهره میبرند.

- ابزارهای مجازیسازی داده: مورد استفاده در ساختاری مجازی که بیانگر نمایی واحد از دادهها با منبع متفاوت است. این ابزارها برای بازیابی و دسترسی به اطلاعات، نیازی به جابهجایی فیزیکی دادهها ندارند.

- پلتفرم یکپارچهسازی به عنوان سرویس یا iPaaS: رویکرد iPaaS، ارائه دهنده سرویسهای یکپارچهسازی داده متنوعی شامل تغییر و مسیریابی اطلاعات، مدیریت API و برقراری ارتباط با سرویسهای درونسازمانی است. عمده کاربرد این ابزارها در یکپارچهسازی ابری است.

- ابزارهای یکپارچهسازی «دادههای جریانی» (Streaming Data): تمرکز این ابزارها بر یکپارچهسازی بلادرنگ دادههای جریانی از منابعی مانند دستگاههای IoT، سنسورها و شبکههای اجتماعی است. ابزارهایی که سازمانها را قادر میسازند تا همزمان با تولید به پردازش و تحلیل دادهها بپردازند.

- ابزارهای نظارت و کیفیت داده: استفاده از این ابزارها، کیفیت استاندارد و سازگار با قوانین دادههای جمعآوری شده را از چند منبع متفاوت تضمین میکند. این ابزارها اغلب شامل امکاناتی مانند تمیزسازی و مدیریت فرادادهها میشوند.

- ابزارهای «شناسایی تغییرات داده» (Change Data Capture | CDC): ابزارهای به اصطلاح CDC وظیفه شناسایی و بازسازی بلادرنگ دادههای منبع را بر عهده دارند. عمده استفاده این ابزارها در بهروز نگهداشتن انبارهای داده و تجزیه و تحلیل آنی است.

- ابزارهای «مدیریت داده کلیدی» (Master Data Management | MDM): هدف اصلی ابزارهای MDM مدیریت مشتری، محصول، کارکنان و دیگر دادههای کلیدی است و از ثبات و دقت درونسازمانی اطمینان حاصل میکنند. اغلب، همگامسازی و تثبیت دادههای کلیدی از طریق این ابزارها انجام میشود.

- پلتفرمهای مدیریت API: پلتفرمهایی که از ابزارهای طراحی، انتشار و مدیریت API تشکیل شدهاند. در حالی که تمرکز اصلی چنین ابزارهایی بر یکپارچهسازی API است، همزمان نقش کلیدی در اتصال سیستمها و نرمافزارها ایفا میکنند.

مثال هایی از یکپارچه سازی داده

حالا که میدانیم منظور از یکپارچه سازی داده ها چیست، در ادامه این مطلب از مجله فرادرس چند مورد از پروژههای یکپارچهسازی داده را مرور میکنیم.

۱. یکپارچه سازی داده های مشتری در بازاریابی

همانندسازی دادههای مشتری در میان اساسیترین موارد استفاده یکپارچهسازی دادهها قرار دارد. اجرای فرایند یکپارچهسازی موجب تثبیت دادههای جمعآوری شده کاربر از تمامی منابع در دسترس مانند اطلاعات تماس، جزییات حساب کاربری، امتیاز محصولات و دیگر تعاملاتی مانند پستهای منتشر شده در شبکههای اجتماعی میشود.

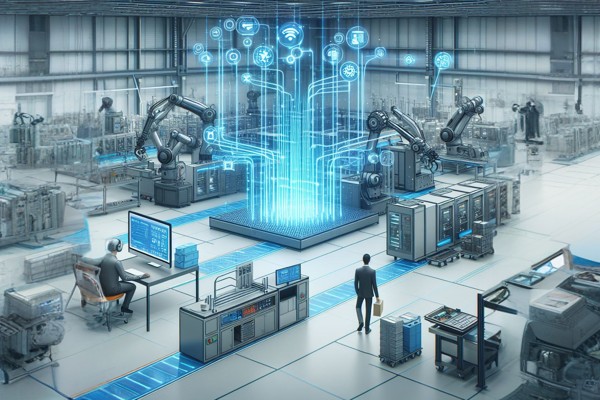

۲. یکپارچه سازی داده های حوزه IoT

سازمانها به سرعت در حال حرکت به سمت ترکیب دادههای تولید شده توسط سنسورهای متصل به اینترنت در تجهیزات صنعتی مانند ماشینهای بخش تولید، اتومبیلها و آسانسورها هستند. کسبوکارها میتوانند با بهرهگیری از دادههای جمعآوری شده از سنسورها و انجام شبیهسازیهای پیشگیرانه، در زمان سپری شده برای مشکلات ناگهانی صرفهجویی کنند.

۳. یکپارچه سازی داده در کاربرد های فروشگاهی

فروشگاههای سنتی و آنلاین، روزانه با حجم بالایی داده سروکار دارند. از همین جهت و برای بهرهگیری مناسب از این اطلاعات، صاحبان مشاغل باید دادههای جمعآوری شده را متمرکز کنند. یکپارچهسازی دادهها، فروشندگان را قادر میسازد تا راحتتر به مدیریت انبار، ساعت کار کارکنان، دادههای مربوط به درآمد و دیگر متغیرهای حیاتی در موقعیتهای مختلف بپردازند.

مزایا یکپارچه سازی داده ها چیست؟

یکپارچهسازی دادهها شامل امکانات فراوانی است که به سازمانها اجازه میدهد تصمیمات آگاهانهای اتخاذ کرده و مزیت رقابتی خود را حفظ کنند. در فهرست زیر به چند مورد از مهمترین مزایای فرایند یکپارچهسازی دادهها اشاره شده است:

- کاهش مخازن داده: نتیجه فرایند یکپارچهسازی، جمعآوری اطلاعات از چند منبع متفاوت و در نهایت ارائه نمایشی واحد و جامع است. با کاهش تعداد مخازن داده، سازمانها میتوانند افزونگی و ناپایداری ناشی از منابع داده مستقل را حذف کنند.

- بهبود کیفیت داده: همانطور که پیش از این نیز اشاره شد، یکپارچهسازی داده شامل فرایندهای دیگری مانند تغییر و پاکسازی داده است که با شناسایی و برطرف کردن خطاها باعث افزایش کیفیت دادهها میشوند.

- بهبود کارایی: دادههای یکپارچه شده نیاز به وارد کردن دستی دادهها و اجرای فرایندهای تکراری را تا حد قابل قبولی کاهش میدهند. همچنین خطاها را کاهش داده و پایداری میان دادهها را بالا میبرند.

- افزایش سرعت عمل: یکپارچهسازی دادهها باعث افزایش سرعت دسترسی به اطلاعات میشود. سرعت پاسخگویی بالا در مواجهه با فرایندهایی مانند تصمیمگیری و در کنار آن واکنش نشان دادن به نیاز مشتری ضرورت دارد.

- ارتقا هوش تجاری: یکپارچهسازی داده عنصری کلیدی در شروع هر نوع فعالیت مرتبط با هوش تجاری است. ابزارهای موجود در این زمینه برای تجزیه و تحلیل موثر به دادههای یکپارچه نیاز دارند.

- نوآوریهای «داده محور» (Data-driven): از دادههای یکپارچه برای پردهبرداری از الگوها، رویدادها و فرصتهایی که ممکن است در نگاه اول به چشم نیایند استفاده میشود. قابلیتی که با افزایش سطح نوآوری سازمانها، موجب تولید محصولات و سرویسهای جدید میشود.

چالش های یکپارچه سازی داده ها

اغلب هنگام رفع پیچیدگیهای فرایند یکپارچهسازی دادهها با چالش روبهرو میشویم. چالشهایی که کارآمدی و خروجی دلخواه ما را تحت تاثیر قرار میدهند. در فهرست زیر برخی از رایجترین چالشهای یکپارچهسازی را ملاحظه میکنید:

- سازگاری و چالش فرمت: هر مجموعهداده فرمت و ساختار منحصربهفردی دارد و «استانداردسازی» (Standardization) آنها نیازمند تلاش بسیاری است.

- امنیت و حریم خصوصی: هنگام کار با دادههای حساس، بسیار مهم است که از رعایت پروتکلهای امنیتی و تبعیت از مقررات مربوطه در برابر درخواستهای خارج از چارچوب اطمینان حاصل کنیم.

- حجم و تنوع داده: با توجه به حجم اطلاعات، تفاوت فرمت و سرعت مورد نیاز برای پردازش، یکپارچهسازی «کلان دادهها» (Big Data) فرایندی چالش انگیز است.

- یکپارچهسازی سیستمهای قدیمی: اگر سیستمی فاقد دسترسیهای API یا قابلیتهای بهروز یکپارچهسازی باشد، در هماهنگی با پلتفرمهای مدرن این حوزه دچار مشکل میشود.

غلبه بر چنین چالشهایی باعث توسعه مجموعهدادهای یکپارچه شده که در نهایت بسیار در بهبود عملکرد مدلهای یادگیری ماشین موثر خواهد بود.

کاربرد یکپارچه سازی داده ها چیست؟

از یکپارچهسازی داده در صنایع و مسائل متنوعی برای رفع نیاز کسبوکارها استفاده میشود. از جمله رایجترین کاربردهای یکپارچهسازی داده میتوان به موارد زیر اشاره کرد:

- انبارداری دادهها: از یکپارچهسازی دادهها در فرایند ساخت انبار داده برای ذخیرهسازی اطلاعات استفاده میشود.

- توسعه «دریاچه داده» (Data Lake): اغلب محیطهای کلان داده شامل ترکیبی از دادههای «ساختیافته» (Structured)، «غیر ساختیافته» (Unstructured) و «نیمه ساختیافته» (Semi-Structured) هستند. پس از جابهجایی این دادهها از پلتفرمهای فعلی به دریاچه داده و با اجرای تکنیکهای آماری مانند هوش مصنوعی و یادگیری ماشین، استخراج مقادیر داده بهمراتب راحتتر میشود.

- تشخیص نیاز مشتری: با جمعآوری و مرتبسازی دادههای مشتری از پایگاههای داده و همچنین پلتفرمهای مرتبط، سازمانها میتوانند نیازهای هر مشتری را بهطور خاص شناسایی کنند. شرکتها با کمک دادههای یکپارچه شده فرصتهای زیادی بهدست آورده و تجربه بهتری به مشتری ارائه میدهند.

- گزارشدهی: یکپارچهسازی داده نقش مهمی در تولید گزارشهایی مانند عملکرد کسبوکار، میزان فروش، بازاریابی و امور مالی دارد.

- پردازش دادههای مربوط به IoT: کسبوکارها با یکپارچهسازی خروجی وسایل IoT میتوانند به مدیریت سرویسهای متصل، تحلیل دادههای جمعآوری شده از طریق سنسورها و خودکارسازی کارها بپردازند.

جمعبندی

امروزه یکپارچهسازی دادهها نقش مهمی در صنایع مختلف دارد. با بهرهگیری از این فرایند میتوان بهجای جستجوی اطلاعات در مخازن ذخیرهسازی، انواع مختلف دادهها را در کنار یکدیگر جمعآوری کرد. در این مطلب از مجله فرادرس یاد گرفتیم منظور از یکپارچه سازی داده ها چیست و با موضوعاتی همچون انواع و ابزارهای کاربردی یکپارچهسازی نیز آشنا شدیم. با توجه به تنوع تکنیکهای یکپارچهسازی، گزینه مناسب شما وابسته به نوع مسئله و منابعی است که در اختیار دارید.